إزالة الغموض عن الطبقات المتصلة بالكامل في شبكات CNN

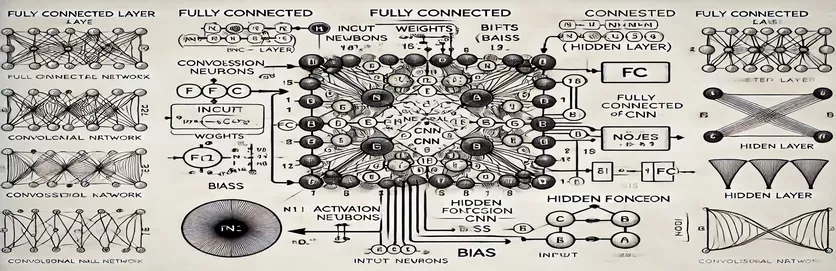

إن فهم طريقة عمل الطبقة المتصلة بالكامل (FC) في الشبكة العصبية التلافيفية (CNN) يمكن أن يبدو وكأنه كشف لغز. بالنسبة للكثيرين، يكمن التعقيد في عملية الحساب وكيفية اشتقاق عقدة واحدة في الطبقة المخفية. على عكس الشبكات العصبية الاصطناعية التقليدية (ANNs)، فإن طبقة FC في شبكات CNN تحتوي على فروق دقيقة غالبًا ما تكون غير مفسرة في البرامج التعليمية. إذا كنت في حيرة من هذا الأمر، فأنت لست وحدك!

تتجاهل العديد من الموارد هذا الموضوع، مما يترك المتعلمين دون توجيه واضح. غالبًا ما تقوم البرامج التعليمية بإعادة تدوير التفسيرات غير الكاملة، مما يزيد من إحباط أولئك الذين يبحثون عن الوضوح. إذا وجدت نفسك تبحث بشكل متكرر عن الإجابات، فأنت في المكان الصحيح. 🧩

في هذا الدليل، سنركز على حساب عقدة واحدة من الطبقة المخفية لطبقة FC. بمجرد فهمك لآلية عقدة واحدة، ستكون مجهزًا للتعامل مع الباقي. ومن خلال تقسيم هذه العملية إلى خطوات واضحة وقابلة للتنفيذ، ستكتسب الثقة للتنقل في أي حساب لطبقة FC.

باستخدام الأمثلة ذات الصلة والرسم التخطيطي المباشر، سنسلط الضوء على المسار من المدخلات إلى المخرجات في طبقة FC. قل وداعًا للارتباك ومرحبًا بالفهم - هيا بنا نتعمق! 🚀

| يأمر | مثال للاستخدام |

|---|---|

| np.dot() | ينفذ المنتج النقطي بين صفيفين. يُستخدم هنا لحساب المجموع المرجح للمدخلات والأوزان لعقدة في الطبقة المتصلة بالكامل. |

| np.maximum() | يطبق وظيفة تنشيط ReLU عن طريق تحديد القيمة القصوى بين الإخراج المحسوب والصفر. |

| torch.tensor() | إنشاء موتر في PyTorch. Tensors هي اللبنات الأساسية لتمثيل البيانات في أطر التعلم العميق. |

| torch.matmul() | ينفذ ضرب المصفوفات في PyTorch. يستخدم لحساب المنتج النقطي بين المدخلات والأوزان. |

| torch.nn.functional.relu() | يطبق وظيفة تنشيط ReLU في PyTorch، مع ضبط جميع القيم السالبة في الموتر على الصفر. |

| np.testing.assert_array_almost_equal() | يقارن صفيفين من حيث العناصر لتحقيق المساواة ضمن تسامح معين. مفيد لاختبار صحة الإخراج في العمليات العددية. |

| unittest.TestCase | فئة أساسية في وحدة Unittest لإنشاء حالات الاختبار. يستخدم لهيكلة وتنظيم اختبارات الوحدة في بايثون. |

| np.array() | إنشاء مصفوفة في NumPy. تُستخدم المصفوفات لتمثيل المدخلات والأوزان والتحيزات في حسابات الطبقة المتصلة بالكامل. |

| torch.matmul() | وظيفة PyTorch لمضاعفة المصفوفات، وهي مهمة لحساب المخرجات في الشبكات العصبية. |

| unittest.main() | يقوم بتشغيل كافة حالات الاختبار المحددة في البرنامج النصي. ضروري للتحقق من دقة وموثوقية الحلول المنفذة. |

كسر حسابات الطبقة المتصلة بالكامل

تهدف البرامج النصية المقدمة إلى إزالة الغموض عن كيفية عمل عقدة في ملف متصل بالكامل (FC) تقوم طبقة CNN بمعالجة البيانات من الطبقة السابقة. تربط هذه الطبقات كل مدخلات بكل عقدة باستخدام الروابط المرجحة والتحيزات، مما يجعلها ضرورية لمهام مثل تصنيف الصور. يقوم البرنامج النصي الأول بحساب الإخراج لعقدة واحدة باستخدام NumPy. ومن خلال ضرب قيم المدخلات بالأوزان المقابلة لها وإضافة الانحياز، يتم الحصول على مخرجات العقدة. يتم بعد ذلك تمرير هذا الإخراج من خلال وظيفة التنشيط (على سبيل المثال، ReLU) لتقديم اللاخطية. على سبيل المثال، تخيل قيم البكسل الخاصة بالصورة كمدخلات؛ قد تمثل الأوزان المرشحات المستفادة التي تستخرج ميزات ذات معنى من الصورة. 🖼️

يقوم البرنامج النصي الثاني بتعميم الحساب للعقد المتعددة. ويستخدم ضرب المصفوفات، حيث يتم تمثيل الأوزان كمصفوفة ثنائية الأبعاد والمدخلات كمتجه. يسمح هذا النهج الفعال بالحساب المتزامن لجميع العقد في الطبقة. من خلال إضافة التحيزات وتطبيق وظيفة تنشيط ReLU، يتم إنتاج المخرجات النهائية للطبقة. هذه الطريقة قابلة للتطوير بشكل كبير وهي عملية أساسية في أطر التعلم العميق الحديثة. على سبيل المثال، في نظام التعرف على الوجه، يمكن أن تساعد هذه العملية في تحديد ما إذا كان الشكل المكتشف يشبه وجه الإنسان. 😊

لأولئك الذين يعملون مع مكتبات التعلم العميق مثل باي تورش، يوضح النص الثالث كيفية استخدام الموترات والوظائف المضمنة لتحقيق نفس الحسابات. إن مرونة PyTorch وتحسيناتها المضمنة تجعلها مثالية لبناء الشبكات العصبية وتدريبها. يوضح البرنامج النصي كيفية تحديد المدخلات والأوزان والتحيزات كموترات وإجراء ضرب المصفوفة باستخدام الشعلة.matmul() وظيفة. وهذا مفيد بشكل خاص لإنشاء خطوط أنابيب شاملة لتدريب شبكات CNN على مجموعات البيانات الكبيرة، مثل تحديد الحيوانات في صور الحياة البرية.

وأخيرًا، يضمن البرنامج النصي لاختبارات الوحدة أن جميع التطبيقات تعمل بشكل صحيح في ظل ظروف مختلفة. باستخدام com.unittest المكتبة، فهي تتحقق من الدقة العددية للحسابات وتتأكد من أن المخرجات تلبي النتائج المتوقعة. تعتبر هذه الخطوة ضرورية لتصحيح الأخطاء وضمان الموثوقية، خاصة عند نشر شبكات CNN في تطبيقات العالم الحقيقي مثل تحليل الصور الطبية. باستخدام هذه البرامج النصية والشروحات، لديك الآن طريق واضح لفهم وتنفيذ طبقات FC في شبكات CNN بثقة. 🚀

فهم حساب العقدة في الطبقة المتصلة بالكامل

حل قائم على لغة بايثون يستفيد من NumPy لإجراء حسابات المصفوفة

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

تعميم حساب العقدة في الطبقات المتصلة بالكامل

حل قائم على لغة بايثون لحساب جميع العقد في الطبقة المخفية

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

استخدام PyTorch لحساب العقدة في طبقة متصلة بالكامل

التنفيذ باستخدام PyTorch لعشاق التعلم العميق

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

اختبر كل حل باستخدام اختبارات الوحدة

اختبارات الوحدة المستندة إلى بايثون لضمان صحة عمليات التنفيذ

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

الكشف عن أهمية الطبقات المتصلة بالكامل في شبكات CNN

تلعب الطبقات المتصلة بالكامل (FC) دورًا محوريًا في تحويل الميزات المستخرجة من الطبقات التلافيفية إلى تنبؤات نهائية. وهي تعمل من خلال ربط كل مدخلات بكل مخرجات، مما يوفر خريطة كثيفة للميزات التي تم تعلمها. على عكس الطبقات التلافيفية التي تركز على التسلسلات الهرمية المكانية، تقوم طبقات FC بتجميع هذه المعلومات لاتخاذ قرارات مثل تحديد الكائنات في الصورة. على سبيل المثال، في نظام التعرف على الصور في السيارة ذاتية القيادة، قد تحدد طبقة FC ما إذا كان الجسم المكتشف هو أحد المشاة أو علامة شارع. 🚗

أحد الجوانب التي تميز طبقات FC عن بعضها هو قدرتها على تعميم الأنماط التي تم تعلمها أثناء التدريب. هذه الخاصية ضرورية عند التعامل مع البيانات غير المرئية. تمثل كل عقدة في الطبقة مزيجًا فريدًا من الأوزان والتحيزات، مما يمكنها من التخصص في التعرف على أنماط أو فئات معينة. وهذا هو السبب في أن بنية طبقات FC غالبًا ما تحدد دقة النموذج بشكل عام. على سبيل المثال، في نموذج التعرف على الأرقام المكتوبة بخط اليد، تقوم طبقة FC بدمج أنماط البكسل في تنبؤات رقمية (0-9). ✍️

في حين أن طبقات FC باهظة الثمن من الناحية الحسابية بسبب اتصالاتها الكثيفة، إلا أنها تظل حيوية للمهام التي تتطلب تصنيفًا تفصيليًا. يتم استخدام التقنيات الحديثة مثل التسرب لتحسين أدائها عن طريق منع التجهيز الزائد. من خلال تقليل عدد العقد النشطة أثناء التدريب، يضمن التسرب أن طبقة FC تتعلم ميزات قوية، مما يجعلها لا غنى عنها في تطبيقات مثل التعرف على الوجه وتشخيص الصور الطبية.

أسئلة شائعة حول الطبقات المتصلة بالكامل

- ما هي الوظيفة الرئيسية للطبقة المتصلة بالكامل في شبكات CNN؟

- تربط طبقة FC جميع المدخلات بالمخرجات، وتجميع الميزات للتنبؤات النهائية. إنه مفتاح لتحويل خرائط الميزات إلى نتائج قابلة للتنفيذ.

- كيف تتم تهيئة الأوزان والتحيزات في طبقات FC؟

- غالبًا ما تتم تهيئة الأوزان بشكل عشوائي أو باستخدام تقنيات مثل تهيئة Xavier، بينما تبدأ التحيزات عادةً عند الصفر من أجل البساطة.

- كيف يعمل تنشيط ReLU على تحسين أداء طبقة FC؟

- يطبق ReLU عدم الخطية عن طريق ضبط المخرجات السلبية على الصفر. يمنع تلاشي التدرجات، مما يجعل النموذج يتقارب بشكل أسرع.

- هل يمكن تطبيق التسرب على طبقات FC؟

- نعم، يؤدي التسرب إلى تعطيل العقد بشكل عشوائي أثناء التدريب، مما يعزز تعميم النموذج ويقلل من التجهيز الزائد.

- ما الذي يجعل طبقات FC مختلفة عن الطبقات التلافيفية؟

- بينما تستخرج الطبقات التلافيفية المعالم المكانية، تقوم طبقات FC بتجميع هذه المعالم في تنسيق كثيف للتصنيف.

الوجبات السريعة الرئيسية حول الطبقات المتصلة بالكامل

تعمل الطبقة المتصلة بالكامل على دمج الميزات المستفادة في تنبؤات قابلة للتنفيذ، لتكون بمثابة الخطوة النهائية لاتخاذ القرار في الشبكات العصبية. ومن خلال فهم كيفية حساب كل عقدة، يكتسب المستخدمون الثقة في تصميم وتحسين بنيات CNN لمهام مثل اكتشاف الكائنات وتصنيفها.

توضح الأمثلة العملية، مثل التعرف على الصور في المركبات ذاتية القيادة أو التعرف على الوجه، أهمية طبقات FC. ومن خلال النهج الصحيح، يضمن دمج أساليب التحسين نماذج قوية ودقيقة تتكيف بشكل جيد مع البيانات غير المرئية. إن التمكن من هذا المفهوم يفتح المجال أمام استكشاف أعمق للذكاء الاصطناعي. 😊

المصادر والمراجع

- شرح تفصيلي للطبقات المتصلة بالكامل في شبكات CNN مصدرها إتقان التعلم الآلي .

- الدليل الشامل لوظائف التنشيط وتطبيقاتها مسترجع من تحليلات فيدهيا .

- تم العثور على رؤى حول تقنيات التسرب والتحسين للشبكات العصبية في DeepAI .

- فهم الأوزان والتحيزات في الشبكات العصبية من نحو علم البيانات .

- استخدام وظائف تنشيط ReLU في PyTorch مصدرها وثائق باي تورش .