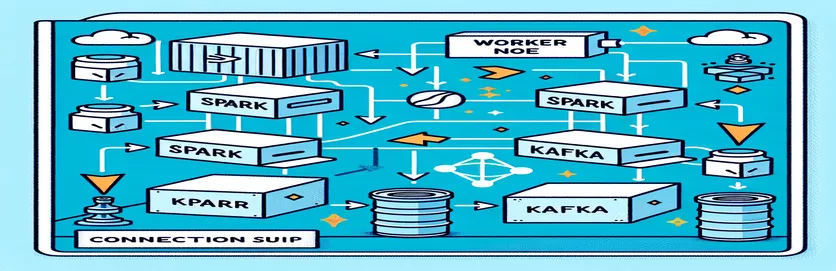

تحديات دمج Spark وKafka في بيئة Dockerized

هل سبق لك أن واجهت مشكلة في الاتصال أثناء دمج ملف وسيط كافكا في مجموعة سبارك ضمن إعداد Docker؟ أنت لست وحدك! يواجه العديد من المطورين عقبات عند إعداد الاتصال بين هاتين الأداتين القويتين. 🛠️

في الآونة الأخيرة، شرعت في تعزيز بلدي مجموعة سبارك عن طريق إضافة وسيط كافكا لتبسيط معالجة البيانات في الوقت الحقيقي. ومع ذلك، فقد واجهت عقبة بسبب انتهاء مهلات الاتصال المستمرة وأخطاء في تحليل نظام أسماء النطاقات (DNS)، مما أدى إلى تحويل العملية إلى سباق طويل لاستكشاف الأخطاء وإصلاحها. 😅

نشأت هذه المشكلات من الإعدادات التي تمت تهيئتها بشكل خاطئ في التكوينات المرتبطة بـ Docker Compose وSpark's Kafka. على الرغم من اتباع العديد من الأدلة وتعديل العديد من المعلمات، استمرت رسالة "الوسيط قد لا يكون متاحًا" بعيدة المنال، مما تركني في حيرة وإحباط.

في هذه المقالة، سأشارك تجربتي وأقدم خطوات عملية لحل تحديات الاتصال بين عمال Spark ووسطاء Kafka في بيئة Docker. على طول الطريق، ستتعلم النصائح والحيل لتجنب هذه المخاطر وضمان التكامل السلس. دعونا نتعمق! 🚀

| يأمر | مثال للاستخدام |

|---|---|

| from_json() | تقوم وظيفة Spark SQL هذه بتوزيع سلسلة JSON وإنشاء كائن بيانات منظم. في المثال، يتم استخدامه لإلغاء تسلسل رسائل كافكا وتحويلها إلى بيانات منظمة. |

| StructType() | يحدد مخططًا لمعالجة البيانات المنظمة. إنه مفيد بشكل خاص لتحديد التنسيق المتوقع لرسائل كافكا. |

| .readStream | يبدأ دفق DataFrame في Spark، مما يسمح باستيعاب البيانات بشكل مستمر من Kafka أو مصادر الدفق الأخرى. |

| writeStream | يحدد وضع الإخراج والمصرف لاستعلام Spark Structured Streaming. هنا، يحدد الكتابة إلى وحدة التحكم في وضع الإلحاق. |

| bootstrap_servers | معلمة تكوين كافكا التي تحدد عنوان وسيط كافكا. حاسم للتواصل بين سبارك وكافكا. |

| auto_offset_reset | إعداد عميل كافكا يحدد مكان بدء قراءة الرسائل في حالة عدم وجود إزاحة مسبقة. يبدأ الخيار "الأقدم" من الرسالة الأقدم. |

| KAFKA_ADVERTISED_LISTENERS | متغير بيئة تكوين Docker Kafka. وهو يحدد العناوين المعلن عنها لعملاء Kafka، مما يضمن الاتصال المناسب داخل شبكة Docker وخارجها. |

| KAFKA_LISTENERS | يقوم بتكوين واجهات الشبكة التي يستمع عليها وسيط كافكا للاتصالات الواردة. تستخدم هنا لفصل الاتصالات الداخلية والخارجية. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | يحدد بروتوكولات الأمان لمستمعي كافكا المختلفين. يقوم بتعيين أسماء المستمعين إلى البروتوكولات الخاصة بهم، مثل PLAINTEXT في هذه الحالة. |

| .awaitTermination() | طريقة Spark Structured Streaming تمنع تنفيذ البرنامج النصي حتى يتم إنهاء استعلام الدفق، مما يضمن تشغيل الدفق بشكل مستمر. |

فهم تكامل Spark وKafka في Docker

يركز النص الأول على إنشاء اتصال بين أ عامل الشرارة و أ وسيط كافكا. باستخدام Spark's Structured Streaming API، يقرأ البرنامج النصي البيانات في الوقت الفعلي من موضوع كافكا. يبدأ الأمر بتهيئة جلسة Spark وتكوينها باستخدام حزمة Kafka المطلوبة. يعد هذا أمرًا بالغ الأهمية لأنه يوفر التبعية اللازمة لـ Spark للتواصل مع كافكا بسلاسة. مثال على هذه التبعية هو الحزمة `org.apache.spark:spark-sql-kafka`، والتي تضمن التوافق بين Spark وKafka في بيئة Docker.

للتعامل مع رسائل كافكا، يحدد البرنامج النصي مخططًا باستخدام `StructType`. يضمن هذا المخطط تحليل الرسائل الواردة وتنظيمها بشكل صحيح. غالبًا ما تتضمن سيناريوهات العالم الحقيقي التعامل مع بيانات JSON من كافكا. على سبيل المثال، تخيل نظام مراقبة العملة المشفرة حيث يتم إرسال الرسائل التي تحتوي على تحديثات الأسعار إلى كافكا. يؤدي تحليل هذه الرسائل إلى تنسيق قابل للقراءة إلى تسهيل معالجة البيانات وتحليلها للتنبؤ بالاتجاه. 🪙

يلعب تكوين Docker Compose دورًا محوريًا في حل مشكلات الاتصال. يتم ضبط إعدادات `KAFKA_ADVERTISED_LISTENERS` و`KAFKA_LISTENERS` للتمييز بين الاتصالات الداخلية والخارجية داخل شبكة Docker. وهذا يضمن أن الخدمات التي تعمل على نفس شبكة Docker، مثل Spark وKafka، يمكنها التفاعل دون مشاكل في تحليل DNS. على سبيل المثال، يتيح تعيين `INSIDE://kafka:9093` للحاويات الداخلية الوصول إلى Kafka، بينما يتيح تعيين `OUTSIDE://localhost:9093` إمكانية اتصال التطبيقات الخارجية مثل أدوات المراقبة.

يوضح البرنامج النصي الثاني كيفية استخدام Python `KafkaConsumer` لاختبار اتصال Kafka. يعد هذا أسلوبًا بسيطًا ولكنه فعال لضمان عمل وسيط Kafka بشكل صحيح. من خلال استهلاك الرسائل من الموضوع المحدد، يمكنك التحقق من عدم انقطاع تدفق البيانات. فكر في تطبيق حيث يريد المستخدم تتبع بيانات سوق الأوراق المالية. يضمن اختبار الاتصال باستخدام البرنامج النصي للمستهلك عدم فقدان أي تحديثات مهمة بسبب أخطاء التكوين. باستخدام هذه الأدوات، يمكنك بثقة نشر أنظمة قوية لمعالجة البيانات في الوقت الفعلي! 🚀

التعامل مع مشكلات الاتصال بين Spark Worker وKafka Broker

الحل 1: استخدام Python لتصحيح أخطاء الاتصال وحلها في Spark وKafka باستخدام Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

تصحيح مشكلات تحليل DNS في Dockerized Kafka

الحل 2: تعديل تكوين Docker Compose للحصول على حل DNS مناسب

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

اختبار اتصال المستهلك كافكا

الحل 3: مستهلك Python Kafka لاختبار الاتصال

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

تحسين Kafka وSpark في بيئة Dockerized

جانب حاسم لضمان التواصل السلس بين وسطاء كافكا و عمال سبارك يقوم Docker بتكوين إعدادات الشبكة بشكل فعال. تعمل حاويات Docker في بيئات معزولة، مما يؤدي غالبًا إلى حدوث مشكلات في تحليل DNS عندما تحتاج الخدمات إلى التفاعل. لمعالجة هذه المشكلة، يمكنك الاستفادة من خيارات تكوين شبكة Docker Compose. على سبيل المثال، يضمن تحديد شبكة مخصصة مثل `my_network` وخدمات الربط أن تتعرف الحاويات على بعضها البعض بالاسم بدلاً من IP، مما يبسط عملية الإعداد ويتجنب الأخطاء الشائعة.

هناك اعتبار أساسي آخر وهو تحسين تكوينات مستمع كافكا. من خلال تحديد `KAFKA_ADVERTISED_LISTENERS` و`KAFKA_LISTENERS` في ملف Docker Compose، فإنك تسمح لـ Kafka بالإعلان عن العناوين المناسبة لعملائها. يؤدي هذا التمييز بين المستمعين الداخليين والخارجيين إلى حل النزاعات، خاصة عندما يحاول Spark Workers الاتصال من خارج شبكة Docker. أحد الأمثلة الواقعية على ذلك هو لوحة معلومات المراقبة التي تستعلم عن بيانات كافكا من جهاز مضيف، مما يتطلب مستمعًا خارجيًا مميزًا للوصول. 🔧

أخيرًا، يعد تنفيذ معالجة قوية للأخطاء في تطبيقات Spark أمرًا بالغ الأهمية. على سبيل المثال، يمكن أن يؤدي الاستفادة من عمليات إعادة المحاولة والاحتياطيات ضمن تكوين Kafka إلى معالجة مشكلات الاتصال المؤقتة بأمان. إن إضافة `.option("kafka.consumer.max.poll.records"، "500")` يضمن استرجاع البيانات بكفاءة، حتى في ظل الأحمال الثقيلة. تخيل تطبيقًا على مستوى الإنتاج يتتبع أسعار الأسهم في الوقت الفعلي، حيث يضمن وجود أنظمة أمان ضد الفشل تدفق البيانات دون انقطاع حتى أثناء تعطل الشبكة. تشكل هذه التقنيات معًا العمود الفقري لخط أنابيب موثوق لمعالجة البيانات. 🚀

أسئلة شائعة حول Spark وKafka في Docker

- ما هو الغرض من KAFKA_ADVERTISED_LISTENERS؟

- وهو يحدد العناوين المعلن عنها لعملاء Kafka للاتصال، مما يضمن الاتصال المناسب داخل شبكة Docker وخارجها.

- كيف يمكنك تحديد شبكة مخصصة في Docker Compose؟

- يمكنك إضافة شبكة تحت networks مفتاح وإدراجه في الخدمات، مثل `networks: my_network`.

- لماذا يفشل تحليل DNS في حاويات Docker؟

- قد لا تتعرف الحاويات على بعضها البعض بالاسم إلا إذا كانت جزءًا من نفس شبكة Docker، التي تربط DNS الخاص بها.

- ما هو دور .option("subscribe", "topic") في سبارك الجري؟

- إنه يشترك في Spark Structured Streaming DataFrame في موضوع Kafka المحدد لاستيعاب البيانات في الوقت الفعلي.

- كيف يمكن لإعادة المحاولة تحسين تكامل Kafka-Spark؟

- إعادة المحاولة في التكوينات، مثل max.poll.recordsوالمساعدة في التعامل مع الأخطاء العابرة وضمان المعالجة المتسقة للبيانات.

تبسيط تكامل سبارك وكافكا

يمكن أن يكون إعداد Spark وKafka في Docker أمرًا معقدًا، ولكن مع التكوينات الصحيحة، يصبح الأمر قابلاً للإدارة. ركز على إعدادات المستمع وتكوينات الشبكة لتجنب مشكلات الاتصال. تأكد من مزامنة جميع المكونات مثل Zookeeper وKafka جيدًا لتحقيق الأداء الأمثل.

حالات الاستخدام في العالم الحقيقي، مثل مراقبة البيانات المالية أو تدفقات إنترنت الأشياء، تسلط الضوء على أهمية التكوينات القوية. تزودك الأدوات والبرامج النصية المشتركة هنا بالمعرفة اللازمة للتغلب على العقبات الشائعة وإنشاء خطوط بيانات فعالة في الوقت الفعلي. 🛠️

المصادر والمراجع

- أبلغ هذا المقال من قبل المسؤول وثائق التكامل أباتشي سبارك كافكا ، وتوفير رؤى تفصيلية حول التكوين والاستخدام.

- تمت الإشارة إلى أفضل ممارسات شبكات Docker من وثائق شبكات دوكر لضمان إعدادات اتصالات الحاوية دقيقة وموثوقة.

- تم تعديل الأمثلة العملية وإعدادات كافكا الإضافية من مستودع Wurstmeister Kafka Docker GitHub .