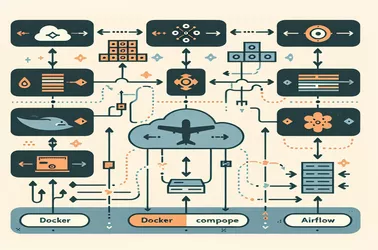

Pot ser difícil gestionar la seqüenciació de tasques dinàmiques a Apache Airflow , sobretot quan les dependències s’han de crear en temps d’execució. És possible un flux de treball més flexible mitjançant la utilització de dag_run.conf en lloc de les associacions de tasques de codificació dura. Per als canonades de processament de dades, on els paràmetres d’entrada fluctuen sovint, aquest mètode és especialment útil. Mitjançant l'ús de TaskFlow API o PythOnoperators, els fluxos de treball es poden adaptar en funció dels desencadenants externs. Els DAG dinàmics proporcionen una opció escalable per a les operacions de dades contemporànies, tant si gestionen conjunts de dades diversos, automatitzant canonades ETL o racionalitzant l'execució de tasques.

Alice Dupont

13 de febrer 2025

Generar seqüències de tasques dinàmiques al flux d'aire mitjançant la configuració de DAG Run