Daniel Marino

25 november 2024

Løsning af SparkContext-problemer med Apache Sparks brug af UDF'er til udtrækning af billedfunktioner

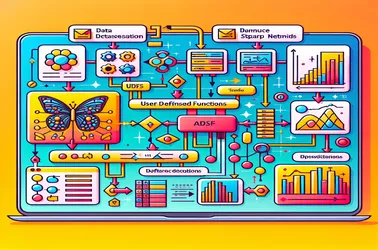

Når du bruger UDF'er inden for Apache Spark til distribuerede operationer som deep learning-modelbehandling, er det almindeligt at støde på Sparks "SparkContext kan kun bruges på driveren". Dette sker på grund af den strenge driver-bundne natur af SparkContext, som styrer jobfordelingen. Ved at forhindre serialiseringskonflikter i distribuerede billedbehandling-pipelines og garantere modeladgang uden re-initialisering på hver node, gør løsninger såsom broadcast-variabler os i stand til at dele modeller med arbejdernoder i en effektiv måde. Sparks kapacitet til at håndtere komplicerede maskinlæringsopgaver i stor skala er væsentligt forbedret af broadcast-tilgange.