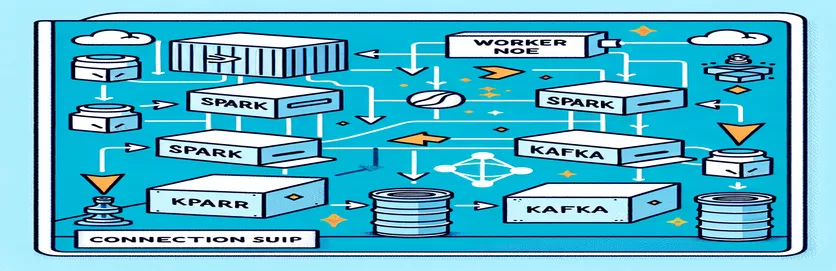

Udfordringer ved at integrere Spark og Kafka i et dockeriseret miljø

Har du nogensinde stået over for et forbindelsesproblem, mens du integrerede en Kafka mægler ind i en Gnistklynge i en Docker-opsætning? Du er ikke alene! Mange udviklere støder på forhindringer, når de opsætter kommunikationen mellem disse to kraftfulde værktøjer. 🛠️

For nylig gik jeg i gang med at forbedre min Gnistklynge ved at tilføje en Kafka-mægler for at strømline databehandling i realtid. Jeg ramte dog en vejspærring med vedvarende forbindelsestimeouts og DNS-opløsningsfejl, hvilket gjorde processen til et fejlfindingsmaraton. 😅

Disse problemer stammede fra forkert konfigurerede indstillinger i Docker Compose og Sparks Kafka-relaterede konfigurationer. På trods af at jeg fulgte adskillige guides og justerede adskillige parametre, vedblev den undvigende "mægler muligvis ikke tilgængelig"-meddelelse, hvilket efterlod mig forvirret og frustreret.

I denne artikel vil jeg dele min erfaring og tilbyde praktiske trin til at løse forbindelsesudfordringer mellem Spark-arbejdere og Kafka-mæglere i et Docker-miljø. Undervejs vil du lære tips og tricks til at undgå disse faldgruber og sikre en problemfri integration. Lad os dykke ned! 🚀

| Kommando | Eksempel på brug |

|---|---|

| from_json() | Denne Spark SQL-funktion analyserer en JSON-streng og opretter et struktureret dataobjekt. I eksemplet bruges det til at deserialisere Kafka-meddelelser til strukturerede data. |

| StructType() | Definerer et skema for struktureret databehandling. Det er især nyttigt til at definere det forventede format af Kafka-meddelelser. |

| .readStream | Starter en streaming DataFrame i Spark, hvilket giver mulighed for kontinuerlig dataindtagelse fra Kafka eller andre streamingkilder. |

| writeStream | Definerer outputtilstanden og sink for en Spark Structured Streaming-forespørgsel. Her specificerer det at skrive til konsollen i tilføjelsestilstand. |

| bootstrap_servers | En Kafka-konfigurationsparameter, der angiver adressen på Kafka-mægleren. Kritisk for Spark og Kafka kommunikation. |

| auto_offset_reset | En Kafka-forbrugerindstilling, der bestemmer, hvor man skal begynde at læse beskeder, når der ikke findes nogen tidligere forskydning. Den "tidligste" mulighed starter fra den ældste besked. |

| KAFKA_ADVERTISED_LISTENERS | En Docker Kafka-konfigurationsmiljøvariabel. Den specificerer de annoncerede adresser for Kafka-klienter, hvilket sikrer korrekt kommunikation inden for og uden for Docker-netværket. |

| KAFKA_LISTENERS | Konfigurerer netværksgrænseflader, hvorpå Kafka-mægleren lytter efter indgående forbindelser. Bruges her til at adskille intern og ekstern kommunikation. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Definerer sikkerhedsprotokollerne for forskellige Kafka-lyttere. Den knytter lytternavne til deres respektive protokoller, såsom PLAINTEXT i dette tilfælde. |

| .awaitTermination() | En Spark Structured Streaming-metode, der blokerer udførelsen af scriptet, indtil streamingforespørgslen er afsluttet, hvilket sikrer, at streamen kører kontinuerligt. |

Forståelse af Spark og Kafka-integration i Docker

Det første script fokuserer på at etablere en forbindelse mellem en Gnistarbejder og en Kafka mægler. Ved at bruge Sparks Structured Streaming API læser scriptet realtidsdata fra et Kafka-emne. Det begynder med at initialisere en Spark-session og konfigurere den med den nødvendige Kafka-pakke. Dette er afgørende, da det giver Spark den nødvendige afhængighed til at kommunikere problemfrit med Kafka. Et eksempel på denne afhængighed er `org.apache.spark:spark-sql-kafka`-pakken, som sikrer kompatibilitet mellem Spark og Kafka i et Docker-miljø.

For at håndtere Kafka-meddelelser definerer scriptet et skema ved hjælp af `StructType`. Dette skema sikrer, at de indgående meddelelser er korrekt parset og struktureret. Scenarier i den virkelige verden involverer ofte håndtering af JSON-data fra Kafka. Forestil dig for eksempel et overvågningssystem for kryptovaluta, hvor meddelelser, der indeholder prisopdateringer, sendes til Kafka. Parsing af disse meddelelser i et læsbart format gør det nemmere at behandle og analysere data til trendforudsigelse. 🪙

Docker Compose-konfigurationen spiller en central rolle i løsningen af forbindelsesproblemer. Indstillingerne for `KAFKA_ADVERTISED_LISTENERS` og `KAFKA_LISTENERS` er justeret for at adskille intern og ekstern kommunikation inden for Docker-netværket. Dette sikrer, at tjenester, der kører på det samme Docker-netværk, såsom Spark og Kafka, kan interagere uden problemer med DNS-opløsning. For eksempel giver kortlægning af `INSIDE://kafka:9093` interne containere adgang til Kafka, mens `OUTSIDE://localhost:9093` gør det muligt for eksterne applikationer som overvågningsværktøjer at forbinde.

Det andet script viser, hvordan man bruger en Python `KafkaConsumer` til at teste Kafka-forbindelsen. Dette er en enkel, men effektiv tilgang til at sikre, at Kafka-mægleren fungerer korrekt. Ved at forbruge beskeder fra det angivne emne kan du bekræfte, om datastrømmen er uafbrudt. Overvej en applikation, hvor en bruger ønsker at spore børsdata. Test af forbindelsen ved hjælp af dette forbrugerscript sikrer, at ingen kritiske opdateringer går glip af på grund af konfigurationsfejl. Med disse værktøjer kan du trygt implementere robuste systemer til databehandling i realtid! 🚀

Håndtering af forbindelsesproblemer mellem Spark Worker og Kafka Broker

Løsning 1: Brug af Python til fejlretning og løsning af forbindelsesproblemer i Spark og Kafka med Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Fejlretning af problemer med DNS-løsning i Dockerized Kafka

Løsning 2: Ændring af Docker Compose-konfiguration for korrekt DNS-opløsning

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Test af Kafka Consumer Connection

Løsning 3: Python Kafka Consumer til test af forbindelsen

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Optimering af Kafka og Spark i et dockeriseret miljø

Et kritisk aspekt for at sikre jævn kommunikation mellem Kafka Mæglere og Gnistarbejdere i Docker konfigurerer netværksindstillinger effektivt. Docker-containere fungerer i isolerede miljøer, hvilket ofte forårsager problemer med DNS-løsning, når tjenester skal interagere. For at løse dette kan du udnytte Docker Composes netværkskonfigurationsmuligheder. For eksempel, at definere et brugerdefineret netværk som "mit_netværk" og linke tjenester sikrer, at containere genkender hinanden ved navn frem for IP, hvilket forenkler opsætningen og undgår almindelige faldgruber.

En anden væsentlig overvejelse er at optimere Kafkas lytterkonfigurationer. Ved at angive `KAFKA_ADVERTISED_LISTENERS` og `KAFKA_LISTENERS` i din Docker Compose-fil, tillader du Kafka at annoncere passende adresser til sine kunder. Denne differentiering mellem interne og eksterne lyttere løser konflikter, især når Spark Workers forsøger at oprette forbindelse uden for Docker-netværket. Et virkeligt eksempel på dette er et overvågningsdashboard, der forespørger Kafka-data fra en værtsmaskine, hvilket kræver en særskilt ekstern lytter for at få adgang. 🔧

Endelig er implementering af robust fejlhåndtering i dine Spark-applikationer afgørende. For eksempel kan udnyttelse af genforsøg og fallbacks inden for Kafka-konfigurationen håndtere midlertidige forbindelsesproblemer med ynde. Tilføjelse af `.option("kafka.consumer.max.poll.records", "500")` sikrer effektiv datahentning, selv under tung belastning. Forestil dig en applikation i produktionsklasse, der sporer aktiekurser i realtid - at have sikkerhedsbokse på plads sikrer uafbrudt dataflow selv under netværkshikke. Disse teknikker udgør tilsammen rygraden i en pålidelig databehandlingspipeline. 🚀

Almindelige spørgsmål om Spark og Kafka i Docker

- Hvad er formålet med KAFKA_ADVERTISED_LISTENERS?

- Den specificerer de annoncerede adresser for Kafka-klienter at forbinde, hvilket sikrer korrekt kommunikation i og uden for Docker-netværket.

- Hvordan definerer du et brugerdefineret netværk i Docker Compose?

- Du kan tilføje et netværk under networks nøglen og inkludere den i tjenester, såsom `networks: my_network`.

- Hvorfor fejler DNS-opløsning i Docker-containere?

- Containere genkender muligvis ikke hinanden ved navn, medmindre de er en del af det samme Docker-netværk, som forbinder deres DNS.

- Hvad er rollen .option("subscribe", "topic") i Spark Streaming?

- Det abonnerer på Spark Structured Streaming DataFrame til det angivne Kafka-emne for dataindtagelse i realtid.

- Hvordan kan genforsøg forbedre Kafka-Spark-integration?

- Forsøg igen i konfigurationer, som f.eks max.poll.records, hjælpe med at håndtere forbigående fejl og sikre ensartet databehandling.

Forenkling af Spark og Kafka-integration

Opsætning af Spark og Kafka i Docker kan være kompleks, men med de rigtige konfigurationer bliver det overskueligt. Fokuser på lytterindstillinger og netværkskonfigurationer for at undgå forbindelsesproblemer. Sørg for, at alle komponenter som Zookeeper og Kafka er godt synkroniserede for optimal ydeevne.

Brugssager i den virkelige verden, såsom overvågning af finansielle data eller IoT-strømme, fremhæver vigtigheden af robuste konfigurationer. De værktøjer og scripts, der deles her, udstyrer dig med viden til at overvinde almindelige forhindringer og bygge effektive datapipelines i realtid. 🛠️

Kilder og referencer

- Denne artikel blev informeret af embedsmanden Apache Spark Kafka integrationsdokumentation , der giver detaljeret indsigt i konfiguration og brug.

- Docker-netværks bedste praksis blev refereret fra Docker-netværksdokumentation for at sikre nøjagtige og pålidelige containerkommunikationsopsætninger.

- Praktiske eksempler og yderligere Kafka-indstillinger blev tilpasset fra Wurstmeister Kafka Docker GitHub Repository .