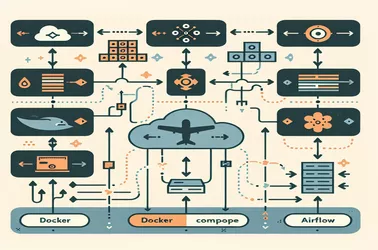

Es kann schwierig sein, die dynamische Aufgabensequenzierung in Apache Airflow zu verwalten, insbesondere wenn Abhängigkeiten zur Laufzeit erstellt werden müssen. Ein flexiblerer Workflow ist möglich, indem dag_run.conf anstelle von Hardcoding -Task -Assoziationen verwendet wird. Für Datenverarbeitungspipelines, bei denen die Eingabeparameter häufig schwanken, ist diese Methode besonders hilfreich. Durch die Verwendung der Taskflow -API oder Pythonoperatoren können sich Workflows basierend an externen Triggern anpassen. Dynamische DAGs bieten eine skalierbare Option für zeitgenössische Datenoperationen, unabhängig davon, ob sie verschiedene Datensätze bearbeiten, ETL -Pipelines automatisieren oder die Ausführung von Aufgaben optimieren.

Alice Dupont

13 Februar 2025

Generieren von dynamischen Aufgabensequenzen im Luftstrom mithilfe der DAG -Auslaufkonfiguration