Daniel Marino

25 November 2024

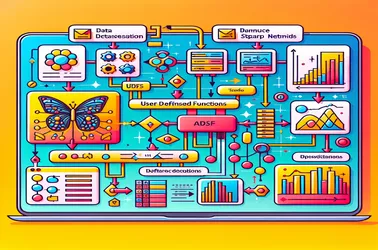

Beheben von SparkContext-Problemen bei der Verwendung von UDFs für die Bildmerkmalsextraktion durch Apache Spark

Bei der Verwendung von UDFs in Apache Spark für verteilte Vorgänge wie die Verarbeitung von Deep-Learning-Modellen tritt häufig das Spark-Problem „SparkContext kann nur für den Treiber verwendet werden“ auf. Dies liegt an der strengen Treiberbindung von SparkContext, der die Auftragsverteilung steuert. Indem sie Serialisierungskonflikte in verteilten Bildverarbeitungspipelines verhindern und den Modellzugriff ohne Neuinitialisierung auf jedem Knoten garantieren, ermöglichen uns Lösungen wie Broadcast-Variablen, Modelle mit Arbeitsknoten in einem zu teilen effiziente Art und Weise. Die Fähigkeit von Spark, komplexe maschinelle Lernaufgaben in großem Maßstab zu bewältigen, wird durch Broadcast-Ansätze erheblich verbessert.