Απομυθοποίηση πλήρως συνδεδεμένων επιπέδων σε CNN

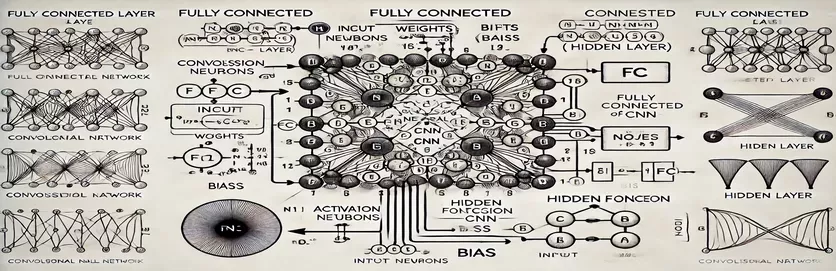

Η κατανόηση της λειτουργίας ενός στρώματος πλήρως συνδεδεμένου (FC) σε ένα Συνελικτικό Νευρωνικό Δίκτυο (CNN) μπορεί να μοιάζει σαν να ξετυλίγετε ένα μυστήριο. Για πολλούς, η πολυπλοκότητα έγκειται στη διαδικασία υπολογισμού και στον τρόπο με τον οποίο προκύπτει ένας κόμβος στο κρυφό στρώμα. Σε αντίθεση με τα παραδοσιακά τεχνητά νευρωνικά δίκτυα (ANN), το επίπεδο FC στα CNN έχει αποχρώσεις που συχνά παραμένουν ανεξήγητες στα σεμινάρια. Αν σε προβληματίζει αυτό, δεν είσαι μόνος!

Πολλοί πόροι περιορίζονται σε αυτό το θέμα, αφήνοντας τους μαθητές χωρίς σαφή καθοδήγηση. Τα σεμινάρια συχνά ανακυκλώνουν ελλιπείς εξηγήσεις, αυξάνοντας την απογοήτευση όσων αναζητούν σαφήνεια. Εάν έχετε βρει τον εαυτό σας να ψάχνει επανειλημμένα για απαντήσεις, βρίσκεστε στο σωστό μέρος. 🧩

Σε αυτόν τον οδηγό, θα επικεντρωθούμε στον υπολογισμό ενός μεμονωμένου κόμβου από το κρυφό στρώμα του επιπέδου FC. Μόλις καταλάβετε τον μηχανισμό για έναν κόμβο, θα είστε εξοπλισμένοι για να αντιμετωπίσετε τους υπόλοιπους. Διαχωρίζοντας αυτήν τη διαδικασία σε ξεκάθαρα, ενεργά βήματα, θα αποκτήσετε την αυτοπεποίθηση να πλοηγηθείτε σε οποιονδήποτε υπολογισμό του επιπέδου FC.

Χρησιμοποιώντας σχετικά παραδείγματα και ένα απλό διάγραμμα, θα φωτίσουμε τη διαδρομή από τις εισόδους στις εξόδους στο επίπεδο FC. Πείτε αντίο στη σύγχυση και γεια στην κατανόηση—ας βουτήξουμε! 🚀

| Εντολή | Παράδειγμα χρήσης |

|---|---|

| np.dot() | Εκτελεί το γινόμενο με τελείες μεταξύ δύο πινάκων. Χρησιμοποιείται εδώ για τον υπολογισμό του σταθμισμένου αθροίσματος εισόδων και βαρών για έναν κόμβο στο πλήρως συνδεδεμένο επίπεδο. |

| np.maximum() | Εφαρμόζει τη λειτουργία ενεργοποίησης ReLU επιλέγοντας τη μέγιστη τιμή μεταξύ της υπολογισμένης εξόδου και του μηδενός. |

| torch.tensor() | Δημιουργεί έναν τανυστήρα στο PyTorch. Οι τανυστές είναι τα βασικά δομικά στοιχεία για την αναπαράσταση δεδομένων σε πλαίσια βαθιάς μάθησης. |

| torch.matmul() | Εκτελεί πολλαπλασιασμό μήτρας στο PyTorch. Χρησιμοποιείται για τον υπολογισμό του γινόμενου κουκίδων μεταξύ των εισροών και των βαρών. |

| torch.nn.functional.relu() | Εφαρμόζει τη συνάρτηση ενεργοποίησης ReLU στο PyTorch, μηδενίζοντας όλες τις αρνητικές τιμές στον τανυστή. |

| np.testing.assert_array_almost_equal() | Συγκρίνει δύο πίνακες ως προς τα στοιχεία για ισότητα εντός μιας ορισμένης ανοχής. Χρήσιμο για τον έλεγχο της ορθότητας εξόδου σε αριθμητικές πράξεις. |

| unittest.TestCase | Μια βασική κλάση στη μονάδα δοκιμής μονάδας για τη δημιουργία δοκιμαστικών περιπτώσεων. Χρησιμοποιείται για τη δομή και την οργάνωση δοκιμών μονάδων στην Python. |

| np.array() | Δημιουργεί έναν πίνακα στο NumPy. Οι πίνακες χρησιμοποιούνται για να αναπαραστήσουν εισόδους, βάρη και προκαταλήψεις στους υπολογισμούς πλήρως συνδεδεμένων επιπέδων. |

| torch.matmul() | Η συνάρτηση του PyTorch για πολλαπλασιασμό πινάκων, κρίσιμη για τον υπολογισμό των εξόδων στα νευρωνικά δίκτυα. |

| unittest.main() | Εκτελεί όλες τις δοκιμαστικές περιπτώσεις που ορίζονται στο σενάριο. Απαραίτητο για την επικύρωση της ακρίβειας και της αξιοπιστίας των εφαρμοζόμενων λύσεων. |

Καταστροφή υπολογισμών πλήρως συνδεδεμένων επιπέδων

Τα σενάρια που παρέχονται στοχεύουν να απομυθοποιήσουν πώς ένας κόμβος στο α Το επίπεδο ενός CNN επεξεργάζεται δεδομένα από το προηγούμενο επίπεδο. Αυτά τα επίπεδα συνδέουν κάθε είσοδο σε κάθε κόμβο χρησιμοποιώντας σταθμισμένους συνδέσμους και προκαταλήψεις, καθιστώντας τα απαραίτητα για εργασίες όπως η ταξινόμηση εικόνων. Το πρώτο σενάριο υπολογίζει την έξοδο για έναν μόνο κόμβο χρησιμοποιώντας . Πολλαπλασιάζοντας τις τιμές εισόδου με τα αντίστοιχα βάρη τους και προσθέτοντας την προκατάληψη, προκύπτει η έξοδος κόμβου. Αυτή η έξοδος περνά στη συνέχεια μέσω μιας συνάρτησης ενεργοποίησης (π.χ., ReLU) για να εισαγάγει μη γραμμικότητα. Για παράδειγμα, φανταστείτε τις τιμές pixel μιας εικόνας ως εισόδους. τα βάρη μπορεί να αντιπροσωπεύουν μαθημένα φίλτρα που εξάγουν σημαντικά χαρακτηριστικά από την εικόνα. 🖼️

Το δεύτερο σενάριο γενικεύει τον υπολογισμό για πολλούς κόμβους. Χρησιμοποιεί πολλαπλασιασμό μήτρας, όπου τα βάρη αντιπροσωπεύονται ως δισδιάστατη μήτρα και οι είσοδοι ως διάνυσμα. Αυτή η αποτελεσματική προσέγγιση επιτρέπει ταυτόχρονο υπολογισμό για όλους τους κόμβους στο επίπεδο. Προσθέτοντας προκαταλήψεις και εφαρμόζοντας τη λειτουργία ενεργοποίησης ReLU, παράγονται οι τελικές έξοδοι του στρώματος. Αυτή η μέθοδος είναι εξαιρετικά επεκτάσιμη και αποτελεί βασική λειτουργία σε σύγχρονα πλαίσια βαθιάς μάθησης. Για παράδειγμα, σε ένα σύστημα αναγνώρισης προσώπου, αυτή η διαδικασία θα μπορούσε να βοηθήσει στον προσδιορισμό του εάν ένα ανιχνευμένο σχήμα μοιάζει με ανθρώπινο πρόσωπο. 😊

Για όσους εργάζονται με βιβλιοθήκες βαθιάς μάθησης όπως , το τρίτο σενάριο δείχνει πώς να χρησιμοποιείτε τανυστές και ενσωματωμένες συναρτήσεις για να επιτύχετε τους ίδιους υπολογισμούς. Η ευελιξία και οι ενσωματωμένες βελτιστοποιήσεις του PyTorch το καθιστούν ιδανικό για τη δημιουργία και την εκπαίδευση νευρωνικών δικτύων. Το σενάριο δείχνει πώς να ορίσετε τις εισόδους, τα βάρη και τις προκαταλήψεις ως τανυστές και να εκτελέσετε τον πολλαπλασιασμό πίνακα χρησιμοποιώντας το λειτουργία. Αυτό είναι ιδιαίτερα χρήσιμο για τη δημιουργία αγωγών από άκρο σε άκρο για την εκπαίδευση CNN σε μεγάλα σύνολα δεδομένων, όπως η αναγνώριση ζώων σε φωτογραφίες άγριας ζωής.

Τέλος, το σενάριο δοκιμών μονάδας διασφαλίζει ότι όλες οι υλοποιήσεις λειτουργούν σωστά υπό διάφορες συνθήκες. Χρησιμοποιώντας το βιβλιοθήκης, επαληθεύει την αριθμητική ακρίβεια των υπολογισμών και επιβεβαιώνει ότι οι έξοδοι πληρούν τα αναμενόμενα αποτελέσματα. Αυτό το βήμα είναι ζωτικής σημασίας για τον εντοπισμό σφαλμάτων και τη διασφάλιση της αξιοπιστίας, ειδικά κατά την ανάπτυξη CNN σε εφαρμογές πραγματικού κόσμου, όπως η ανάλυση ιατρικών εικόνων. Με αυτά τα σενάρια και τις επεξηγήσεις, έχετε πλέον μια ξεκάθαρη διαδρομή για την κατανόηση και την εφαρμογή των επιπέδων FC σε CNN με σιγουριά. 🚀

Κατανόηση του Υπολογισμού ενός Κόμβου στο Πλήρως Συνδεδεμένο Επίπεδο

Λύση βασισμένη σε Python που αξιοποιεί το NumPy για υπολογισμούς μήτρας

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

Γενικοποίηση υπολογισμού κόμβων σε πλήρως συνδεδεμένα επίπεδα

Λύση βασισμένη σε Python για τον υπολογισμό όλων των κόμβων σε ένα κρυφό επίπεδο

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

Χρήση PyTorch για υπολογισμό κόμβων σε πλήρως συνδεδεμένο επίπεδο

Υλοποίηση με PyTorch για λάτρεις της βαθιάς μάθησης

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

Δοκιμάστε κάθε λύση με δοκιμές μονάδων

Δοκιμές μονάδων που βασίζονται σε Python για να διασφαλιστεί η ορθότητα των υλοποιήσεων

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

Αποκάλυψη της σημασίας των πλήρως συνδεδεμένων επιπέδων στα CNN

Τα πλήρως συνδεδεμένα επίπεδα (FC) διαδραματίζουν κεντρικό ρόλο στη μετατροπή των εξαγόμενων χαρακτηριστικών από συνελικτικά επίπεδα σε τελικές προβλέψεις. Λειτουργούν συνδέοντας κάθε είσοδο σε κάθε έξοδο, παρέχοντας μια πυκνή χαρτογράφηση των μαθησιακών χαρακτηριστικών. Σε αντίθεση με τα συνελικτικά επίπεδα που εστιάζουν σε χωρικές ιεραρχίες, τα επίπεδα FC συγκεντρώνουν αυτές τις πληροφορίες για να λάβουν αποφάσεις όπως η αναγνώριση αντικειμένων σε μια εικόνα. Για παράδειγμα, στο σύστημα αναγνώρισης εικόνας ενός αυτοοδηγούμενου αυτοκινήτου, το επίπεδο FC μπορεί να καθορίσει εάν ένα αντικείμενο που ανιχνεύτηκε είναι πεζός ή πινακίδα του δρόμου. 🚗

Μια πτυχή που ξεχωρίζει τα επίπεδα FC είναι η ικανότητά τους να γενικεύουν τα μοτίβα που μαθαίνονται κατά τη διάρκεια της εκπαίδευσης. Αυτή η ιδιότητα είναι ζωτικής σημασίας όταν ασχολείστε με αόρατα δεδομένα. Κάθε κόμβος στο επίπεδο αντιπροσωπεύει έναν μοναδικό συνδυασμό βαρών και προκαταλήψεων, επιτρέποντάς του να ειδικεύεται στην αναγνώριση συγκεκριμένων μοτίβων ή κλάσεων. Αυτός είναι ο λόγος για τον οποίο η δομή των στρωμάτων FC συχνά καθορίζει τη συνολική ακρίβεια του μοντέλου. Για παράδειγμα, σε ένα χειρόγραφο μοντέλο αναγνώρισης ψηφίων, το επίπεδο FC ενοποιεί μοτίβα εικονοστοιχείων σε αριθμητικές προβλέψεις (0-9). ✍️

Ενώ τα επίπεδα FC είναι υπολογιστικά ακριβά λόγω των πυκνών τους συνδέσεων, παραμένουν ζωτικής σημασίας για εργασίες που απαιτούν λεπτομερή ταξινόμηση. Σύγχρονες τεχνικές όπως η εγκατάλειψη χρησιμοποιούνται για τη βελτιστοποίηση της απόδοσής τους αποτρέποντας την υπερβολική προσαρμογή. Με τη μείωση του αριθμού των ενεργών κόμβων κατά τη διάρκεια της προπόνησης, η εγκατάλειψη διασφαλίζει ότι το επίπεδο FC μαθαίνει ισχυρά χαρακτηριστικά, καθιστώντας το απαραίτητο σε εφαρμογές όπως η αναγνώριση προσώπου και η διάγνωση ιατρικών εικόνων.

- Ποια είναι η κύρια λειτουργία ενός πλήρως συνδεδεμένου στρώματος σε CNN;

- Το επίπεδο FC συνδέει όλες τις εισόδους με τις εξόδους, συγκεντρώνοντας χαρακτηριστικά για τελικές προβλέψεις. Είναι το κλειδί για τη μετατροπή των χαρτών χαρακτηριστικών σε αποτελεσματικά αποτελέσματα.

- Πώς αρχικοποιούνται τα βάρη και οι προκαταλήψεις στα επίπεδα FC;

- Τα βάρη συχνά αρχικοποιούνται τυχαία ή χρησιμοποιώντας τεχνικές όπως η προετοιμασία Xavier, ενώ οι προκαταλήψεις συνήθως ξεκινούν από το μηδέν για απλότητα.

- Πώς η ενεργοποίηση ReLU βελτιώνει την απόδοση του επιπέδου FC;

- Το ReLU εφαρμόζει μη γραμμικότητα θέτοντας τις αρνητικές εξόδους στο μηδέν. Αποτρέπει την εξαφάνιση των κλίσεων, κάνοντας το μοντέλο να συγκλίνει πιο γρήγορα.

- Μπορεί η εγκατάλειψη να εφαρμοστεί σε στρώματα FC;

- Ναι, η εγκατάλειψη απενεργοποιεί τυχαία τους κόμβους κατά τη διάρκεια της εκπαίδευσης, βελτιώνοντας τη γενίκευση του μοντέλου και μειώνοντας την υπερπροσαρμογή.

- Τι κάνει τα στρώματα FC διαφορετικά από τα συνελικτικά στρώματα;

- Ενώ τα συνελικτικά στρώματα εξάγουν χωρικά χαρακτηριστικά, τα επίπεδα FC συγκεντρώνουν αυτά τα χαρακτηριστικά σε μια πυκνή μορφή για ταξινόμηση.

Το πλήρως συνδεδεμένο επίπεδο ενοποιεί τα μαθησιακά χαρακτηριστικά σε προβλέψιμες προβλέψεις, χρησιμεύοντας ως το τελικό βήμα λήψης αποφάσεων στα νευρωνικά δίκτυα. Κατανοώντας πώς υπολογίζεται κάθε κόμβος, οι χρήστες αποκτούν εμπιστοσύνη στο σχεδιασμό και τη βελτιστοποίηση αρχιτεκτονικών CNN για εργασίες όπως η ανίχνευση και η ταξινόμηση αντικειμένων.

Πρακτικά παραδείγματα, όπως η αναγνώριση εικόνας σε αυτόνομα οχήματα ή η αναγνώριση προσώπου, δείχνουν τη σημασία των στρωμάτων FC. Με τη σωστή προσέγγιση, η ενσωμάτωση μεθόδων βελτιστοποίησης διασφαλίζει στιβαρά και ακριβή μοντέλα που προσαρμόζονται καλά σε αόρατα δεδομένα. Η κυριαρχία αυτής της ιδέας ξεκλειδώνει τη βαθύτερη εξερεύνηση στην τεχνητή νοημοσύνη. 😊

- Λεπτομερής επεξήγηση για πλήρως συνδεδεμένα επίπεδα σε CNN που προέρχονται από Μάθηση Μηχανικής .

- Ο αναλυτικός οδηγός για τις λειτουργίες ενεργοποίησης και τις εφαρμογές τους ανακτήθηκε από Analytics Vidhya .

- Πληροφορίες σχετικά με τις τεχνικές εγκατάλειψης και βελτιστοποίησης για νευρωνικά δίκτυα που βρέθηκαν στο DeepAI .

- Κατανόηση βαρών και προκαταλήψεων σε νευρωνικά δίκτυα από Προς Επιστήμη Δεδομένων .

- Χρήση συναρτήσεων ενεργοποίησης ReLU στο PyTorch που προέρχεται από Τεκμηρίωση PyTorch .