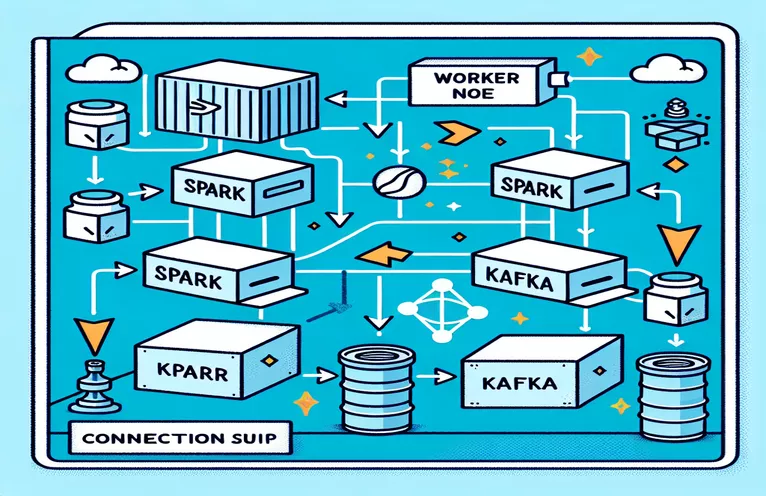

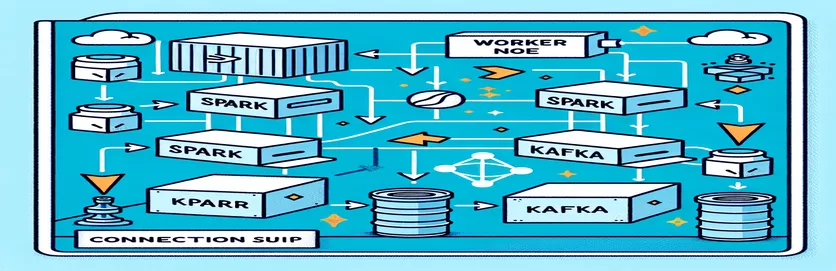

Προκλήσεις της ενσωμάτωσης του Spark και του Kafka σε ένα Dockerized περιβάλλον

Αντιμετωπίσατε ποτέ πρόβλημα συνδεσιμότητας κατά την ενσωμάτωση του a Μεσίτης Κάφκα σε α Spark Cluster σε μια εγκατάσταση Docker; Δεν είσαι μόνος! Πολλοί προγραμματιστές αντιμετωπίζουν εμπόδια κατά τη ρύθμιση της επικοινωνίας μεταξύ αυτών των δύο ισχυρών εργαλείων. 🛠️

Πρόσφατα, ξεκίνησα να βελτιώνω το δικό μου Spark Cluster με την προσθήκη ενός μεσίτη Kafka για τον εξορθολογισμό της επεξεργασίας δεδομένων σε πραγματικό χρόνο. Ωστόσο, πέτυχα ένα εμπόδιο με επίμονα χρονικά όρια σύνδεσης και σφάλματα ανάλυσης DNS, τα οποία μετέτρεψαν τη διαδικασία σε μαραθώνιο αντιμετώπισης προβλημάτων. 😅

Αυτά τα ζητήματα προέκυψαν από εσφαλμένες ρυθμίσεις στις διαμορφώσεις Docker Compose και Spark που σχετίζονται με το Kafka. Παρά την ακολούθηση πολλών οδηγών και την προσαρμογή πολλών παραμέτρων, το άπιαστο μήνυμα "ο μεσίτης μπορεί να μην είναι διαθέσιμος" παρέμεινε, αφήνοντάς με μπερδεμένο και απογοητευμένο.

Σε αυτό το άρθρο, θα μοιραστώ την εμπειρία μου και θα προσφέρω πρακτικά βήματα για την επίλυση των προκλήσεων συνδεσιμότητας μεταξύ των εργαζομένων στο Spark και των μεσιτών Kafka σε περιβάλλον Docker. Στην πορεία, θα μάθετε συμβουλές και κόλπα για να αποφύγετε αυτές τις παγίδες και να εξασφαλίσετε μια απρόσκοπτη ενσωμάτωση. Ας βουτήξουμε! 🚀

| Εντολή | Παράδειγμα χρήσης |

|---|---|

| from_json() | Αυτή η συνάρτηση Spark SQL αναλύει μια συμβολοσειρά JSON και δημιουργεί ένα αντικείμενο δομημένων δεδομένων. Στο παράδειγμα, χρησιμοποιείται για την αφαίρεση των μηνυμάτων του Κάφκα σε δομημένα δεδομένα. |

| StructType() | Ορίζει ένα σχήμα για δομημένη επεξεργασία δεδομένων. Είναι ιδιαίτερα χρήσιμο για τον καθορισμό της αναμενόμενης μορφής των μηνυμάτων του Κάφκα. |

| .readStream | Εκκινεί ένα DataFrame ροής στο Spark, επιτρέποντας τη συνεχή απορρόφηση δεδομένων από τον Kafka ή άλλες πηγές ροής. |

| writeStream | Καθορίζει τη λειτουργία εξόδου και τη βύθιση για ένα ερώτημα Spark Structured Streaming. Εδώ, καθορίζει την εγγραφή στην κονσόλα σε λειτουργία προσάρτησης. |

| bootstrap_servers | Μια παράμετρος διαμόρφωσης Kafka που καθορίζει τη διεύθυνση του μεσίτη Kafka. Κρίσιμο για την επικοινωνία Spark και Kafka. |

| auto_offset_reset | Μια ρύθμιση καταναλωτή Kafka που καθορίζει από πού να ξεκινήσει η ανάγνωση μηνυμάτων όταν δεν υπάρχει προηγούμενη μετατόπιση. Η επιλογή "πιο πρώιμη" ξεκινά από το παλαιότερο μήνυμα. |

| KAFKA_ADVERTISED_LISTENERS | Μια μεταβλητή περιβάλλοντος διαμόρφωσης Docker Kafka. Καθορίζει τις διαφημιζόμενες διευθύνσεις για πελάτες Kafka, διασφαλίζοντας τη σωστή επικοινωνία εντός και εκτός του δικτύου Docker. |

| KAFKA_LISTENERS | Ρυθμίζει τις διεπαφές δικτύου στις οποίες ο μεσίτης Kafka ακούει για εισερχόμενες συνδέσεις. Χρησιμοποιείται εδώ για το διαχωρισμό εσωτερικής και εξωτερικής επικοινωνίας. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Καθορίζει τα πρωτόκολλα ασφαλείας για διαφορετικούς ακροατές Kafka. Αντιστοιχίζει τα ονόματα των ακροατών στα αντίστοιχα πρωτόκολλά τους, όπως το PLAINTEXT σε αυτήν την περίπτωση. |

| .awaitTermination() | Μια μέθοδος Spark Structured Streaming που εμποδίζει την εκτέλεση του σεναρίου μέχρι να τερματιστεί το ερώτημα ροής, διασφαλίζοντας ότι η ροή εκτελείται συνεχώς. |

Κατανόηση της ενσωμάτωσης Spark και Kafka στο Docker

Το πρώτο σενάριο εστιάζει στη δημιουργία μιας σύνδεσης μεταξύ α Spark Worker και α Μεσίτης Κάφκα. Χρησιμοποιώντας το Structured Streaming API του Spark, το σενάριο διαβάζει δεδομένα σε πραγματικό χρόνο από ένα θέμα του Κάφκα. Ξεκινά με την προετοιμασία μιας περιόδου λειτουργίας Spark και τη διαμόρφωσή της με το απαιτούμενο πακέτο Kafka. Αυτό είναι κρίσιμο, καθώς παρέχει την απαραίτητη εξάρτηση στο Spark για να επικοινωνεί απρόσκοπτα με τον Κάφκα. Ένα παράδειγμα αυτής της εξάρτησης είναι το πακέτο «org.apache.spark:spark-sql-kafka», το οποίο διασφαλίζει τη συμβατότητα μεταξύ του Spark και του Kafka σε περιβάλλον Docker.

Για να χειριστείτε τα μηνύματα του Κάφκα, το σενάριο ορίζει ένα σχήμα χρησιμοποιώντας το "StructType". Αυτό το σχήμα διασφαλίζει ότι τα εισερχόμενα μηνύματα αναλύονται και δομούνται σωστά. Τα σενάρια του πραγματικού κόσμου συχνά περιλαμβάνουν χειρισμό δεδομένων JSON από τον Κάφκα. Για παράδειγμα, φανταστείτε ένα σύστημα παρακολούθησης κρυπτονομισμάτων όπου αποστέλλονται στον Κάφκα μηνύματα που περιέχουν ενημερώσεις τιμών. Η ανάλυση αυτών των μηνυμάτων σε μια αναγνώσιμη μορφή διευκολύνει την επεξεργασία και την ανάλυση δεδομένων για την πρόβλεψη τάσεων. 🪙

Η διαμόρφωση του Docker Compose παίζει καθοριστικό ρόλο στην επίλυση προβλημάτων συνδεσιμότητας. Οι ρυθμίσεις "KAFKA_ADVERTISED_LISTENERS" και "KAFKA_LISTENERS" προσαρμόζονται για να διαφοροποιούν την εσωτερική και την εξωτερική επικοινωνία εντός του δικτύου Docker. Αυτό διασφαλίζει ότι οι υπηρεσίες που εκτελούνται στο ίδιο δίκτυο Docker, όπως το Spark και το Kafka, μπορούν να αλληλεπιδρούν χωρίς προβλήματα επίλυσης DNS. Για παράδειγμα, η αντιστοίχιση «INSIDE://kafka:9093» επιτρέπει στα εσωτερικά κοντέινερ να έχουν πρόσβαση στο Kafka, ενώ το «OUTSIDE://localhost:9093» επιτρέπει τη σύνδεση εξωτερικών εφαρμογών όπως τα εργαλεία παρακολούθησης.

Το δεύτερο σενάριο δείχνει πώς να χρησιμοποιήσετε ένα Python «KafkaConsumer» για τον έλεγχο της σύνδεσης Kafka. Αυτή είναι μια απλή αλλά αποτελεσματική προσέγγιση για να διασφαλιστεί ότι ο μεσίτης Kafka λειτουργεί σωστά. Καταναλώνοντας μηνύματα από το καθορισμένο θέμα, μπορείτε να επαληθεύσετε εάν η ροή δεδομένων είναι αδιάκοπη. Σκεφτείτε μια εφαρμογή όπου ένας χρήστης θέλει να παρακολουθεί δεδομένα χρηματιστηρίου. Η δοκιμή της σύνδεσης χρησιμοποιώντας αυτήν τη δέσμη ενεργειών καταναλωτή διασφαλίζει ότι δεν χάνονται σημαντικές ενημερώσεις λόγω σφαλμάτων διαμόρφωσης. Με αυτά τα εργαλεία, μπορείτε να αναπτύξετε με σιγουριά ισχυρά συστήματα για επεξεργασία δεδομένων σε πραγματικό χρόνο! 🚀

Χειρισμός ζητημάτων συνδεσιμότητας μεταξύ του Spark Worker και του Kafka Broker

Λύση 1: Χρήση Python για εντοπισμό σφαλμάτων και επίλυση προβλημάτων σύνδεσης στο Spark και στο Kafka με το Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Αποσφαλμάτωση ζητημάτων επίλυσης DNS στο Dockerized Kafka

Λύση 2: Τροποποίηση της διαμόρφωσης Docker Compose για σωστή ανάλυση DNS

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Δοκιμή σύνδεσης καταναλωτών Kafka

Λύση 3: Καταναλωτής Python Kafka για τη δοκιμή της σύνδεσης

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Βελτιστοποίηση του Kafka και του Spark σε ένα Dockerized Environment

Μια κρίσιμη πτυχή για τη διασφάλιση ομαλής επικοινωνίας μεταξύ Μεσίτες Κάφκα και Spark Workers στο Docker διαμορφώνει αποτελεσματικά τις ρυθμίσεις δικτύου. Τα κοντέινερ Docker λειτουργούν σε απομονωμένα περιβάλλοντα, προκαλώντας συχνά προβλήματα επίλυσης DNS όταν χρειάζεται να αλληλεπιδράσουν οι υπηρεσίες. Για να το αντιμετωπίσετε αυτό, μπορείτε να αξιοποιήσετε τις επιλογές διαμόρφωσης δικτύου του Docker Compose. Για παράδειγμα, ο καθορισμός ενός προσαρμοσμένου δικτύου όπως το «my_network» και η σύνδεση υπηρεσιών διασφαλίζει ότι τα κοντέινερ αναγνωρίζουν το ένα το άλλο με το όνομα και όχι με IP, κάτι που απλοποιεί τη ρύθμιση και αποφεύγει κοινές παγίδες.

Ένα άλλο βασικό στοιχείο είναι η βελτιστοποίηση των διαμορφώσεων ακροατών του Κάφκα. Καθορίζοντας τα "KAFKA_ADVERTISED_LISTENERS" και "KAFKA_LISTENERS" στο αρχείο Docker Compose, επιτρέπετε στον Kafka να διαφημίζει κατάλληλες διευθύνσεις στους πελάτες του. Αυτή η διαφοροποίηση μεταξύ εσωτερικών και εξωτερικών ακροατών επιλύει τις διενέξεις, ιδιαίτερα όταν οι Spark Workers επιχειρούν να συνδεθούν εκτός του δικτύου Docker. Ένα πραγματικό παράδειγμα αυτού είναι ένας πίνακας εργαλείων παρακολούθησης που αναζητά δεδομένα Kafka από έναν κεντρικό υπολογιστή, και απαιτεί έναν ξεχωριστό εξωτερικό ακροατή για πρόσβαση. 🔧

Τέλος, η εφαρμογή ισχυρού χειρισμού σφαλμάτων στις εφαρμογές Spark σας είναι ζωτικής σημασίας. Για παράδειγμα, η αξιοποίηση των επαναλήψεων και των εναλλακτικών λύσεων στη διαμόρφωση του Kafka μπορεί να χειριστεί με χάρη προσωρινά ζητήματα συνδεσιμότητας. Η προσθήκη `.option("kafka.consumer.max.poll.records", "500")` διασφαλίζει την αποτελεσματική ανάκτηση δεδομένων, ακόμη και κάτω από μεγάλα φορτία. Φανταστείτε μια εφαρμογή κατηγορίας παραγωγής που παρακολουθεί τις τιμές των μετοχών σε πραγματικό χρόνο—η ύπαρξη ασφαλιστικών θυρών αστοχίας διασφαλίζει την αδιάλειπτη ροή δεδομένων ακόμη και κατά τη διάρκεια προβλημάτων στο δίκτυο. Αυτές οι τεχνικές μαζί αποτελούν τη ραχοκοκαλιά ενός αξιόπιστου αγωγού επεξεργασίας δεδομένων. 🚀

Συνήθεις ερωτήσεις σχετικά με το Spark και τον Kafka στο Docker

- Ποιος είναι ο σκοπός του KAFKA_ADVERTISED_LISTENERS?

- Καθορίζει τις διαφημιζόμενες διευθύνσεις για σύνδεση των πελατών Kafka, διασφαλίζοντας τη σωστή επικοινωνία εντός και εκτός του δικτύου Docker.

- Πώς ορίζετε ένα προσαρμοσμένο δίκτυο στο Docker Compose;

- Μπορείτε να προσθέσετε ένα δίκτυο κάτω από το networks κλειδί και συμπεριλάβετέ το σε υπηρεσίες, όπως `networks: my_network`.

- Γιατί η ανάλυση DNS αποτυγχάνει στα κοντέινερ Docker;

- Τα κοντέινερ ενδέχεται να μην αναγνωρίζουν το ένα το άλλο με το όνομά τους, εκτός εάν αποτελούν μέρος του ίδιου δικτύου Docker, το οποίο συνδέει το DNS τους.

- Ποιος είναι ο ρόλος του .option("subscribe", "topic") στο Spark Streaming;

- Εγγράφει το Spark Structured Streaming DataFrame στο καθορισμένο θέμα Kafka για απορρόφηση δεδομένων σε πραγματικό χρόνο.

- Πώς μπορούν οι επαναλήψεις να βελτιώσουν την ενσωμάτωση του Kafka-Spark;

- Προσπαθεί ξανά σε διαμορφώσεις, όπως π.χ max.poll.records, βοηθούν στο χειρισμό παροδικών σφαλμάτων και διασφαλίζουν συνεπή επεξεργασία δεδομένων.

Απλοποίηση της ολοκλήρωσης Spark και Kafka

Η ρύθμιση του Spark και του Kafka στο Docker μπορεί να είναι πολύπλοκη, αλλά με τις σωστές διαμορφώσεις, γίνεται διαχειρίσιμη. Εστιάστε στις ρυθμίσεις του ακροατή και στις διαμορφώσεις δικτύου για να αποφύγετε προβλήματα συνδεσιμότητας. Βεβαιωθείτε ότι όλα τα εξαρτήματα όπως το Zookeeper και το Kafka είναι καλά συγχρονισμένα για βέλτιστη απόδοση.

Οι περιπτώσεις χρήσης του πραγματικού κόσμου, όπως η παρακολούθηση οικονομικών δεδομένων ή ροών IoT, υπογραμμίζουν τη σημασία των ισχυρών διαμορφώσεων. Τα εργαλεία και τα σενάρια που μοιράζονται εδώ σάς εξοπλίζουν με τη γνώση για να ξεπεράσετε κοινά εμπόδια και να δημιουργήσετε αποτελεσματικές αγωγούς δεδομένων σε πραγματικό χρόνο. 🛠️

Πηγές και Αναφορές

- Αυτό το άρθρο ενημερώθηκε από τον αξιωματούχο Τεκμηρίωση ολοκλήρωσης του Apache Spark Kafka , παρέχοντας λεπτομερείς πληροφορίες σχετικά με τη διαμόρφωση και τη χρήση.

- Οι βέλτιστες πρακτικές δικτύωσης Docker αναφέρθηκαν από το Docker Networking Documentation για να εξασφαλίσετε ακριβείς και αξιόπιστες ρυθμίσεις επικοινωνίας κοντέινερ.

- Πρακτικά παραδείγματα και πρόσθετες ρυθμίσεις Kafka προσαρμόστηκαν από το Wurstmeister Kafka Docker GitHub Repository .