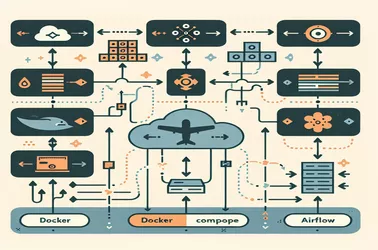

Puede ser difícil administrar la secuenciación de tareas dinámicas en Apache Airflow , particularmente cuando las dependencias deben crearse en tiempo de ejecución. Es posible un flujo de trabajo más flexible utilizando dag_run.conf en lugar de asociaciones de tareas codificantes. Para las tuberías de procesamiento de datos, donde los parámetros de entrada fluctúan a menudo, este método es especialmente útil. Mediante el uso de la API de flujo de tareas o Pythonoperators, los flujos de trabajo pueden adaptarse según los desencadenantes externos. Los DAG dinámicos proporcionan una opción escalable para las operaciones de datos contemporáneos, ya sea que manejen diversos conjuntos de datos, automatizaran tuberías ETL o racionalizar la ejecución de la tarea.

Alice Dupont

13 febrero 2025

Generación de secuencias de tareas dinámicas en el flujo de aire utilizando la configuración de ejecución de DAG