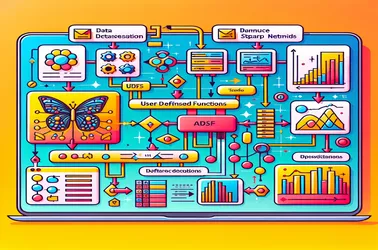

Cuando se utilizan UDF dentro de Apache Spark para operaciones distribuidas como el procesamiento de modelos de aprendizaje profundo, es común encontrarse con el problema "SparkContext solo se puede usar en el controlador" de Spark. Esto ocurre debido a la estricta naturaleza vinculada al controlador de SparkContext, que controla la distribución del trabajo. Al evitar conflictos de serialización en canalizaciones de procesamiento de imágenes distribuidas y garantizar el acceso al modelo sin reinicialización en cada nodo, soluciones como las variables de difusión nos permiten compartir modelos con nodos trabajadores en un manera eficiente. La capacidad de Spark para manejar tareas complejas de aprendizaje automático a escala mejora enormemente mediante enfoques de transmisión.

Daniel Marino

25 noviembre 2024

Solucionar problemas de SparkContext con el uso de UDF de Apache Spark para la extracción de características de imágenes