Desafíos de integrar Spark y Kafka en un entorno Dockerizado

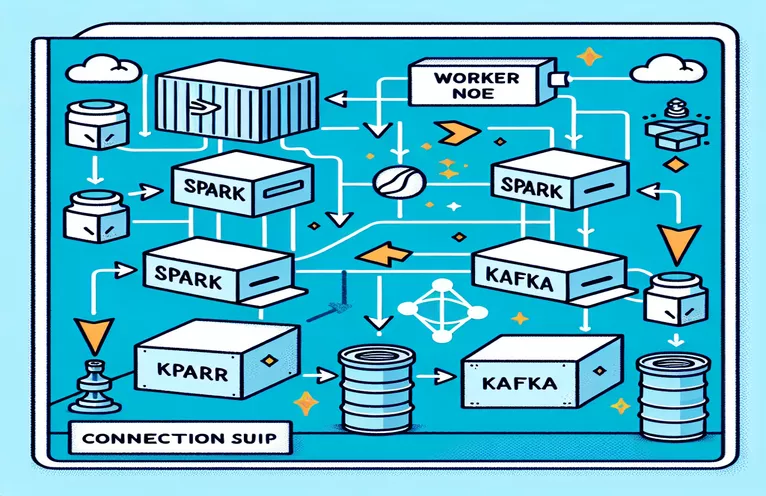

¿Alguna vez ha enfrentado un problema de conectividad al integrar un Corredor Kafka en un Clúster de chispas dentro de una configuración de Docker? ¡No estás solo! Muchos desarrolladores encuentran obstáculos al configurar la comunicación entre estas dos poderosas herramientas. 🛠️

Recientemente, me embarqué en mejorar mi Clúster de chispas agregando un corredor Kafka para agilizar el procesamiento de datos en tiempo real. Sin embargo, me encontré con un obstáculo con tiempos de espera de conexión persistentes y errores de resolución de DNS, lo que convirtió el proceso en una maratón de solución de problemas. 😅

Estos problemas surgieron de configuraciones mal configuradas en Docker Compose y las configuraciones relacionadas con Kafka de Spark. A pesar de seguir varias guías y modificar numerosos parámetros, el elusivo mensaje "es posible que el corredor no esté disponible" persistió, dejándome desconcertado y frustrado.

En este artículo, compartiré mi experiencia y ofreceré pasos prácticos para resolver los desafíos de conectividad entre los trabajadores de Spark y los brokers de Kafka en un entorno Docker. A lo largo del camino, aprenderá consejos y trucos para evitar estos errores y garantizar una integración perfecta. ¡Vamos a sumergirnos! 🚀

| Dominio | Ejemplo de uso |

|---|---|

| from_json() | Esta función de Spark SQL analiza una cadena JSON y crea un objeto de datos estructurados. En el ejemplo, se utiliza para deserializar mensajes de Kafka en datos estructurados. |

| StructType() | Define un esquema para el procesamiento de datos estructurados. Es particularmente útil para definir el formato esperado de los mensajes de Kafka. |

| .readStream | Inicia un DataFrame de transmisión en Spark, lo que permite la ingesta continua de datos desde Kafka u otras fuentes de transmisión. |

| writeStream | Define el modo de salida y el receptor para una consulta de Spark Structured Streaming. Aquí, especifica la escritura en la consola en modo agregar. |

| bootstrap_servers | Un parámetro de configuración de Kafka que especifica la dirección del intermediario de Kafka. Crítico para la comunicación Spark y Kafka. |

| auto_offset_reset | Una configuración del consumidor de Kafka que determina dónde comenzar a leer mensajes cuando no existe una compensación previa. La opción "más antigua" comienza con el mensaje más antiguo. |

| KAFKA_ADVERTISED_LISTENERS | Una variable de entorno de configuración de Docker Kafka. Especifica las direcciones anunciadas para los clientes de Kafka, garantizando una comunicación adecuada dentro y fuera de la red Docker. |

| KAFKA_LISTENERS | Configura las interfaces de red en las que el agente Kafka escucha las conexiones entrantes. Se utiliza aquí para separar la comunicación interna y externa. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Define los protocolos de seguridad para diferentes oyentes de Kafka. Asigna los nombres de los oyentes a sus respectivos protocolos, como PLAINTEXT en este caso. |

| .awaitTermination() | Un método Spark Structured Streaming que bloquea la ejecución del script hasta que finaliza la consulta de transmisión, lo que garantiza que la transmisión se ejecute continuamente. |

Comprender la integración de Spark y Kafka en Docker

El primer guión se centra en establecer una conexión entre un Trabajador de chispa y un Corredor Kafka. Al utilizar la API de transmisión estructurada de Spark, el script lee datos en tiempo real de un tema de Kafka. Comienza inicializando una sesión de Spark y configurándola con el paquete Kafka requerido. Esto es crucial ya que proporciona la dependencia necesaria para que Spark se comunique con Kafka sin problemas. Un ejemplo de esta dependencia es el paquete `org.apache.spark:spark-sql-kafka`, que garantiza la compatibilidad entre Spark y Kafka en un entorno Docker.

Para manejar mensajes de Kafka, el script define un esquema usando `StructType`. Este esquema garantiza que los mensajes entrantes se analicen y estructuren correctamente. Los escenarios del mundo real a menudo implican el manejo de datos JSON desde Kafka. Por ejemplo, imagine un sistema de monitoreo de criptomonedas donde se envían a Kafka mensajes que contienen actualizaciones de precios. Analizar estos mensajes en un formato legible facilita el procesamiento y análisis de datos para la predicción de tendencias. 🪙

La configuración de Docker Compose juega un papel fundamental en la resolución de problemas de conectividad. Las configuraciones `KAFKA_ADVERTISED_LISTENERS` y `KAFKA_LISTENERS` se ajustan para diferenciar la comunicación interna y externa dentro de la red Docker. Esto garantiza que los servicios que se ejecutan en la misma red Docker, como Spark y Kafka, puedan interactuar sin problemas de resolución de DNS. Por ejemplo, el mapeo `INSIDE://kafka:9093` permite que los contenedores internos accedan a Kafka, mientras que `OUTSIDE://localhost:9093` permite que aplicaciones externas como herramientas de monitoreo se conecten.

El segundo script demuestra cómo utilizar un `KafkaConsumer` de Python para probar la conexión Kafka. Este es un enfoque simple pero eficaz para garantizar que el corredor Kafka funcione correctamente. Al consumir mensajes del tema especificado, puede verificar si el flujo de datos es ininterrumpido. Considere una aplicación en la que un usuario desea realizar un seguimiento de los datos del mercado de valores. Probar la conexión utilizando este script de consumidor garantiza que no se pierdan actualizaciones críticas debido a errores de configuración. ¡Con estas herramientas, puede implementar con confianza sistemas robustos para el procesamiento de datos en tiempo real! 🚀

Manejo de problemas de conectividad entre Spark Worker y Kafka Broker

Solución 1: usar Python para depurar y resolver problemas de conexión en Spark y Kafka con Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Depuración de problemas de resolución de DNS en Kafka acoplado

Solución 2: Modificar la configuración de Docker Compose para una resolución DNS adecuada

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Prueba de la conexión del consumidor de Kafka

Solución 3: Consumidor Python Kafka para probar la conexión

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Optimización de Kafka y Spark en un entorno Dockerizado

Un aspecto crítico para garantizar una comunicación fluida entre Corredores Kafka y Trabajadores de chispa en Docker es configurar los ajustes de red de manera efectiva. Los contenedores Docker operan en entornos aislados, lo que a menudo causa problemas de resolución de DNS cuando los servicios necesitan interactuar. Para solucionar este problema, puede aprovechar las opciones de configuración de red de Docker Compose. Por ejemplo, definir una red personalizada como "mi_red" y vincular servicios garantiza que los contenedores se reconozcan entre sí por su nombre en lugar de por IP, lo que simplifica la configuración y evita errores comunes.

Otra consideración esencial es la optimización de las configuraciones de escucha de Kafka. Al especificar `KAFKA_ADVERTISED_LISTENERS` y `KAFKA_LISTENERS` en su archivo Docker Compose, permite que Kafka anuncie las direcciones apropiadas a sus clientes. Esta diferenciación entre oyentes internos y externos resuelve conflictos, particularmente cuando Spark Workers intenta conectarse desde fuera de la red Docker. Un ejemplo de esto en la vida real es un panel de monitoreo que consulta datos de Kafka desde una máquina host, lo que requiere un oyente externo distinto para acceder. 🔧

Finalmente, es crucial implementar un manejo sólido de errores en sus aplicaciones Spark. Por ejemplo, aprovechar los reintentos y las alternativas dentro de la configuración de Kafka puede manejar problemas de conectividad temporales sin problemas. Agregar `.option("kafka.consumer.max.poll.records", "500")` garantiza una recuperación de datos eficiente, incluso bajo cargas pesadas. Imagine una aplicación de nivel de producción que rastrea los precios de las acciones en tiempo real: contar con sistemas de seguridad garantiza un flujo de datos ininterrumpido incluso durante los problemas de la red. Estas técnicas juntas forman la columna vertebral de un proceso de procesamiento de datos confiable. 🚀

Preguntas comunes sobre Spark y Kafka en Docker

- ¿Cuál es el propósito de KAFKA_ADVERTISED_LISTENERS?

- Especifica las direcciones anunciadas para que se conecten los clientes de Kafka, lo que garantiza una comunicación adecuada dentro y fuera de la red Docker.

- ¿Cómo se define una red personalizada en Docker Compose?

- Puede agregar una red en el networks clave e incluirla en servicios, como `networks: my_network`.

- ¿Por qué falla la resolución de DNS en los contenedores Docker?

- Es posible que los contenedores no se reconozcan entre sí por su nombre a menos que formen parte de la misma red Docker, que vincula sus DNS.

- ¿Cuál es el papel de .option("subscribe", "topic") en Spark Streaming?

- Suscribe el Spark Structured Streaming DataFrame al tema de Kafka especificado para la ingesta de datos en tiempo real.

- ¿Cómo pueden los reintentos mejorar la integración de Kafka-Spark?

- Reintentos en configuraciones, como max.poll.records, ayuda a manejar errores transitorios y garantiza un procesamiento de datos consistente.

Simplificando la integración de Spark y Kafka

Configurar Spark y Kafka en Docker puede ser complejo, pero con las configuraciones adecuadas, se vuelve manejable. Concéntrese en la configuración del oyente y las configuraciones de red para evitar problemas de conectividad. Asegúrese de que todos los componentes, como Zookeeper y Kafka, estén bien sincronizados para un rendimiento óptimo.

Los casos de uso del mundo real, como el monitoreo de datos financieros o flujos de IoT, resaltan la importancia de configuraciones sólidas. Las herramientas y scripts que se comparten aquí le proporcionan el conocimiento necesario para superar obstáculos comunes y crear canales de datos eficientes en tiempo real. 🛠️

Fuentes y referencias

- Este artículo fue informado por el funcionario. Documentación de integración de Apache Spark Kafka , proporcionando información detallada sobre la configuración y el uso.

- Se hizo referencia a las mejores prácticas de redes de Docker en el Documentación de redes Docker para garantizar configuraciones de comunicación de contenedores precisas y confiables.

- Se adaptaron ejemplos prácticos y configuraciones adicionales de Kafka del Repositorio Wurstmeister Kafka Docker GitHub .