Défis de l'intégration de Spark et Kafka dans un environnement Dockerisé

Avez-vous déjà été confronté à un problème de connectivité lors de l'intégration d'un Courtier Kafka dans un Amas d'étincelles dans une configuration Docker ? Vous n'êtes pas seul ! De nombreux développeurs rencontrent des obstacles lors de la mise en place de la communication entre ces deux outils puissants. 🛠️

Récemment, j'ai commencé à améliorer mon Amas d'étincelles en ajoutant un courtier Kafka pour rationaliser le traitement des données en temps réel. Cependant, je me suis heurté à un obstacle avec des délais d'attente de connexion persistants et des erreurs de résolution DNS, ce qui a transformé le processus en un marathon de dépannage. 😅

Ces problèmes provenaient de paramètres mal configurés dans les configurations liées à Docker Compose et Spark's Kafka. Malgré le suivi de plusieurs guides et la modification de nombreux paramètres, le message insaisissable « le courtier n'est peut-être pas disponible » a persisté, me laissant perplexe et frustré.

Dans cet article, je partagerai mon expérience et proposerai des étapes pratiques pour résoudre les problèmes de connectivité entre les travailleurs Spark et les courtiers Kafka dans un environnement Docker. En cours de route, vous apprendrez des trucs et astuces pour éviter ces pièges et garantir une intégration transparente. Allons-y ! 🚀

| Commande | Exemple d'utilisation |

|---|---|

| from_json() | Cette fonction Spark SQL analyse une chaîne JSON et crée un objet de données structurées. Dans l'exemple, il est utilisé pour désérialiser les messages Kafka en données structurées. |

| StructType() | Définit un schéma pour le traitement des données structurées. Il est particulièrement utile pour définir le format attendu des messages Kafka. |

| .readStream | Initie un DataFrame de streaming dans Spark, permettant l'ingestion continue de données à partir de Kafka ou d'autres sources de streaming. |

| writeStream | Définit le mode de sortie et le récepteur pour une requête Spark Structured Streaming. Ici, il spécifie l'écriture sur la console en mode ajout. |

| bootstrap_servers | Un paramètre de configuration Kafka qui spécifie l'adresse du courtier Kafka. Critique pour la communication Spark et Kafka. |

| auto_offset_reset | Un paramètre consommateur Kafka qui détermine où commencer la lecture des messages lorsqu'aucun décalage préalable n'existe. L'option « le plus ancien » commence à partir du message le plus ancien. |

| KAFKA_ADVERTISED_LISTENERS | Une variable d'environnement de configuration Docker Kafka. Il spécifie les adresses annoncées pour les clients Kafka, garantissant ainsi une communication appropriée à l'intérieur et à l'extérieur du réseau Docker. |

| KAFKA_LISTENERS | Configure les interfaces réseau sur lesquelles le courtier Kafka écoute les connexions entrantes. Utilisé ici pour séparer la communication interne et externe. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Définit les protocoles de sécurité pour les différents auditeurs Kafka. Il mappe les noms des auditeurs sur leurs protocoles respectifs, comme PLAINTEXT dans ce cas. |

| .awaitTermination() | Une méthode Spark Structured Streaming qui bloque l'exécution du script jusqu'à ce que la requête de streaming soit terminée, garantissant ainsi que le flux s'exécute en continu. |

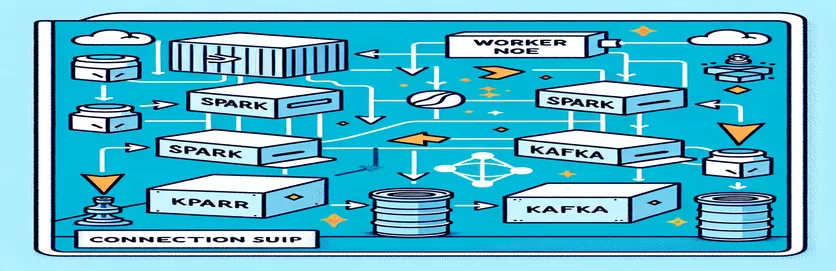

Comprendre l'intégration de Spark et Kafka dans Docker

Le premier script se concentre sur l'établissement d'une connexion entre un Travailleur d'étincelles et un Courtier Kafka. En utilisant l'API Structured Streaming de Spark, le script lit les données en temps réel à partir d'un sujet Kafka. Cela commence par l'initialisation d'une session Spark et sa configuration avec le package Kafka requis. Ceci est crucial car cela fournit la dépendance nécessaire pour que Spark communique de manière transparente avec Kafka. Un exemple de cette dépendance est le package « org.apache.spark:spark-sql-kafka », qui garantit la compatibilité entre Spark et Kafka dans un environnement Docker.

Pour gérer les messages Kafka, le script définit un schéma en utilisant `StructType`. Ce schéma garantit que les messages entrants sont correctement analysés et structurés. Les scénarios du monde réel impliquent souvent la gestion des données JSON de Kafka. Par exemple, imaginez un système de surveillance des cryptomonnaies dans lequel des messages contenant des mises à jour de prix sont envoyés à Kafka. L'analyse de ces messages dans un format lisible facilite le traitement et l'analyse des données pour la prévision des tendances. 🪙

La configuration Docker Compose joue un rôle central dans la résolution des problèmes de connectivité. Les paramètres `KAFKA_ADVERTISED_LISTENERS` et `KAFKA_LISTENERS` sont ajustés pour différencier la communication interne et externe au sein du réseau Docker. Cela garantit que les services exécutés sur le même réseau Docker, tels que Spark et Kafka, peuvent interagir sans problèmes de résolution DNS. Par exemple, le mappage « INSIDE://kafka:9093 » permet aux conteneurs internes d'accéder à Kafka, tandis que « OUTSIDE://localhost:9093 » permet aux applications externes telles que les outils de surveillance de se connecter.

Le deuxième script montre comment utiliser un `KafkaConsumer` Python pour tester la connexion Kafka. Il s'agit d'une approche simple mais efficace pour garantir le bon fonctionnement du courtier Kafka. En consommant les messages du sujet spécifié, vous pouvez vérifier si le flux de données est ininterrompu. Considérons une application dans laquelle un utilisateur souhaite suivre les données boursières. Le test de la connexion à l'aide de ce script consommateur garantit qu'aucune mise à jour critique n'est manquée en raison d'erreurs de configuration. Avec ces outils, vous pouvez déployer en toute confiance des systèmes robustes pour le traitement des données en temps réel ! 🚀

Gestion des problèmes de connectivité entre Spark Worker et Kafka Broker

Solution 1 : Utiliser Python pour déboguer et résoudre les problèmes de connexion dans Spark et Kafka avec Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Débogage des problèmes de résolution DNS dans Kafka Dockerisé

Solution 2 : modifier la configuration de Docker Compose pour une résolution DNS appropriée

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Test de la connexion consommateur Kafka

Solution 3 : Python Kafka Consumer pour tester la connexion

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Optimiser Kafka et Spark dans un environnement Dockerisé

Un aspect essentiel pour assurer une communication fluide entre Courtiers Kafka et Travailleurs d'étincelles dans Docker configure efficacement les paramètres réseau. Les conteneurs Docker fonctionnent dans des environnements isolés, provoquant souvent des problèmes de résolution DNS lorsque les services doivent interagir. Pour résoudre ce problème, vous pouvez tirer parti des options de configuration réseau de Docker Compose. Par exemple, la définition d'un réseau personnalisé tel que « my_network » et la liaison des services garantissent que les conteneurs se reconnaissent par leur nom plutôt que par leur adresse IP, ce qui simplifie la configuration et évite les pièges courants.

Une autre considération essentielle consiste à optimiser les configurations d'écoute de Kafka. En spécifiant « KAFKA_ADVERTISED_LISTENERS » et « KAFKA_LISTENERS » dans votre fichier Docker Compose, vous autorisez Kafka à annoncer les adresses appropriées à ses clients. Cette différenciation entre les auditeurs internes et externes résout les conflits, en particulier lorsque les Spark Workers tentent de se connecter depuis l'extérieur du réseau Docker. Un exemple concret de ceci est un tableau de bord de surveillance interrogeant les données Kafka à partir d'une machine hôte, nécessitant un auditeur externe distinct pour l'accès. 🔧

Enfin, la mise en œuvre d’une gestion robuste des erreurs dans vos applications Spark est cruciale. Par exemple, l'exploitation des tentatives et des replis dans la configuration Kafka peut gérer efficacement les problèmes de connectivité temporaires. L'ajout de `.option("kafka.consumer.max.poll.records", "500")` garantit une récupération efficace des données, même sous de lourdes charges. Imaginez une application de production qui suit les cours des actions en temps réel : la mise en place de sécurités garantit un flux de données ininterrompu, même en cas de problème de réseau. Ces techniques forment ensemble l’épine dorsale d’un pipeline de traitement de données fiable. 🚀

Questions courantes sur Spark et Kafka dans Docker

- Quel est le but de KAFKA_ADVERTISED_LISTENERS?

- Il spécifie les adresses annoncées auxquelles les clients Kafka doivent se connecter, garantissant ainsi une communication appropriée dans et en dehors du réseau Docker.

- Comment définir un réseau personnalisé dans Docker Compose ?

- Vous pouvez ajouter un réseau sous le networks clé et incluez-la dans les services, comme `networks: my_network`.

- Pourquoi la résolution DNS échoue-t-elle dans les conteneurs Docker ?

- Les conteneurs ne peuvent pas se reconnaître par leur nom, sauf s'ils font partie du même réseau Docker, qui relie leur DNS.

- Quel est le rôle de .option("subscribe", "topic") dans Spark Streaming ?

- Il abonne le Spark Structured Streaming DataFrame à la rubrique Kafka spécifiée pour l'ingestion de données en temps réel.

- Comment les nouvelles tentatives peuvent-elles améliorer l’intégration de Kafka-Spark ?

- Nouvelles tentatives dans des configurations, telles que max.poll.records, aident à gérer les erreurs transitoires et garantissent un traitement cohérent des données.

Simplifier l'intégration de Spark et Kafka

La configuration de Spark et Kafka dans Docker peut être complexe, mais avec les bonnes configurations, cela devient gérable. Concentrez-vous sur les paramètres de l'écouteur et les configurations réseau pour éviter les problèmes de connectivité. Assurez-vous que tous les composants tels que Zookeeper et Kafka sont bien synchronisés pour des performances optimales.

Des cas d'utilisation réels, tels que la surveillance des données financières ou des flux IoT, soulignent l'importance de configurations robustes. Les outils et scripts partagés ici vous fournissent les connaissances nécessaires pour surmonter les obstacles courants et créer des pipelines de données efficaces et en temps réel. 🛠️

Sources et références

- Cet article a été informé par le responsable Documentation d'intégration d'Apache Spark Kafka , fournissant des informations détaillées sur la configuration et l'utilisation.

- Les meilleures pratiques de mise en réseau Docker ont été référencées dans le Documentation sur la mise en réseau Docker pour garantir des configurations de communication de conteneur précises et fiables.

- Des exemples pratiques et des paramètres Kafka supplémentaires ont été adaptés du Wurstmeister Kafka Docker Dépôt GitHub .