CNN માં સંપૂર્ણપણે કનેક્ટેડ સ્તરોને ડિમિસ્ટિફાઇંગ કરવું

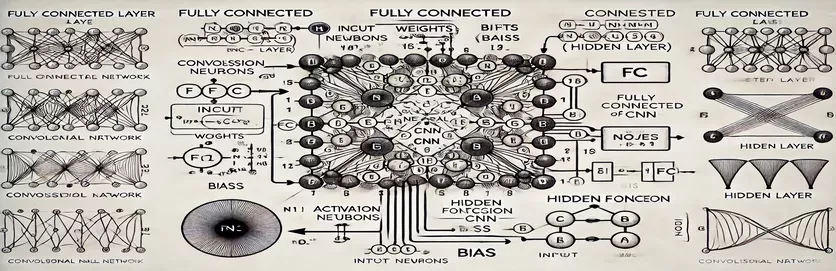

કોન્વોલ્યુશનલ ન્યુરલ નેટવર્ક (CNN) માં સંપૂર્ણ રીતે કનેક્ટેડ (FC) સ્તરની કામગીરીને સમજવું એ એક રહસ્ય ઉઘાડું પાડવા જેવું લાગે છે. ઘણા લોકો માટે, જટિલતા ગણતરીની પ્રક્રિયામાં રહે છે અને છુપાયેલા સ્તરમાં એક નોડ કેવી રીતે પ્રાપ્ત થાય છે. પરંપરાગત કૃત્રિમ ન્યુરલ નેટવર્ક્સ (ANNs) થી વિપરીત, CNN માં FC સ્તરમાં ઘોંઘાટ છે જે ઘણીવાર ટ્યુટોરિયલ્સમાં સમજાવી શકાતી નથી. જો તમે આ વિશે મૂંઝવણમાં છો, તો તમે એકલા નથી!

ઘણા સંસાધનો આ વિષય પર છવાઈ જાય છે, જે વિદ્યાર્થીઓને સ્પષ્ટ માર્ગદર્શન વિના છોડી દે છે. ટ્યુટોરિયલ્સ ઘણીવાર અપૂર્ણ સમજૂતીને રિસાયકલ કરે છે, જેઓ સ્પષ્ટતા શોધે છે તેમની નિરાશામાં વધારો કરે છે. જો તમે તમારી જાતને વારંવાર જવાબો શોધી રહ્યા છો, તો તમે યોગ્ય સ્થાને છો. 🧩

આ માર્ગદર્શિકામાં, અમે FC સ્તરના છુપાયેલા સ્તરમાંથી એક નોડની ગણતરી કરવા પર ધ્યાન કેન્દ્રિત કરીશું. એકવાર તમે એક નોડ માટે મિકેનિઝમને સમજી લો, પછી તમે બાકીનાને હલ કરવા માટે સજ્જ થઈ જશો. આ પ્રક્રિયાને સ્પષ્ટ, કાર્યક્ષમ પગલાઓમાં તોડીને, તમે કોઈપણ FC સ્તરની ગણતરીમાં નેવિગેટ કરવા માટે આત્મવિશ્વાસ મેળવશો.

સંબંધિત ઉદાહરણો અને સીધી રેખાકૃતિનો ઉપયોગ કરીને, અમે FC સ્તરમાં ઇનપુટ્સથી આઉટપુટ સુધીના માર્ગને પ્રકાશિત કરીશું. મૂંઝવણને અલવિદા કહો અને સમજણને નમસ્કાર કરો - ચાલો અંદર જઈએ! 🚀

| આદેશ | ઉપયોગનું ઉદાહરણ |

|---|---|

| np.dot() | બે એરે વચ્ચે ડોટ પ્રોડક્ટ કરે છે. સંપૂર્ણ રીતે જોડાયેલા સ્તરમાં નોડ માટે ઇનપુટ્સ અને વજનના ભારિત સરવાળાની ગણતરી કરવા માટે અહીં ઉપયોગ થાય છે. |

| np.maximum() | ગણતરી કરેલ આઉટપુટ અને શૂન્ય વચ્ચે મહત્તમ મૂલ્ય પસંદ કરીને ReLU સક્રિયકરણ કાર્ય લાગુ કરે છે. |

| torch.tensor() | PyTorch માં ટેન્સર બનાવે છે. ટેન્સર્સ એ ડીપ લર્નિંગ ફ્રેમવર્કમાં ડેટાની રજૂઆત માટે મૂળભૂત બિલ્ડીંગ બ્લોક્સ છે. |

| torch.matmul() | PyTorch માં મેટ્રિક્સ ગુણાકાર કરે છે. ઇનપુટ્સ અને વજન વચ્ચેના ડોટ પ્રોડક્ટની ગણતરી કરવા માટે વપરાય છે. |

| torch.nn.functional.relu() | ટેન્સરમાં તમામ નકારાત્મક મૂલ્યોને શૂન્ય પર સેટ કરીને, PyTorch માં ReLU સક્રિયકરણ કાર્ય લાગુ કરે છે. |

| np.testing.assert_array_almost_equal() | ચોક્કસ સહિષ્ણુતાની અંદર સમાનતા માટે તત્વ મુજબ બે એરેની તુલના કરે છે. સંખ્યાત્મક કામગીરીમાં આઉટપુટ શુદ્ધતા ચકાસવા માટે ઉપયોગી. |

| unittest.TestCase | ટેસ્ટ કેસ બનાવવા માટે યુનિટટેસ્ટ મોડ્યુલમાં બેઝ ક્લાસ. પાયથોનમાં એકમ પરીક્ષણો ગોઠવવા અને ગોઠવવા માટે વપરાય છે. |

| np.array() | NumPy માં એરે બનાવે છે. અરેનો ઉપયોગ સંપૂર્ણપણે જોડાયેલ સ્તરની ગણતરીઓમાં ઇનપુટ્સ, વજન અને પૂર્વગ્રહોને દર્શાવવા માટે થાય છે. |

| torch.matmul() | મેટ્રિક્સ ગુણાકાર માટે PyTorchનું કાર્ય, ન્યુરલ નેટવર્ક્સમાં આઉટપુટની ગણતરી કરવા માટે નિર્ણાયક. |

| unittest.main() | સ્ક્રિપ્ટમાં નિર્ધારિત તમામ ટેસ્ટ કેસ ચલાવે છે. અમલમાં મૂકાયેલા ઉકેલોની ચોકસાઈ અને વિશ્વસનીયતાને માન્ય કરવા માટે આવશ્યક. |

સંપૂર્ણપણે જોડાયેલ સ્તર ગણતરીઓ તોડીને

પૂરી પાડવામાં આવેલ સ્ક્રિપ્ટ્સનો હેતુ એ છે કે કેવી રીતે a માં નોડ છે તે અસ્પષ્ટ છે સંપૂર્ણ રીતે જોડાયેલ (FC) સીએનએનનું સ્તર પાછલા સ્તરના ડેટા પર પ્રક્રિયા કરે છે. આ સ્તરો ભારિત લિંક્સ અને પૂર્વગ્રહોનો ઉપયોગ કરીને દરેક ઇનપુટને દરેક નોડ સાથે જોડે છે, જે તેમને છબી વર્ગીકરણ જેવા કાર્યો માટે આવશ્યક બનાવે છે. પ્રથમ સ્ક્રિપ્ટ એક નોડનો ઉપયોગ કરીને આઉટપુટની ગણતરી કરે છે NumPy. ઇનપુટ મૂલ્યોને તેમના અનુરૂપ વજન સાથે ગુણાકાર કરીને અને પૂર્વગ્રહ ઉમેરીને, નોડ આઉટપુટ મેળવવામાં આવે છે. આ આઉટપુટ પછી બિન-રેખીયતા દાખલ કરવા માટે સક્રિયકરણ કાર્ય (દા.ત., ReLU) દ્વારા પસાર થાય છે. ઉદાહરણ તરીકે, ઇનપુટ તરીકે છબીના પિક્સેલ મૂલ્યોની કલ્પના કરો; વજન શીખેલા ફિલ્ટર્સનું પ્રતિનિધિત્વ કરી શકે છે જે ઇમેજમાંથી અર્થપૂર્ણ લક્ષણો કાઢે છે. 🖼️

બીજી સ્ક્રિપ્ટ બહુવિધ નોડ્સ માટે ગણતરીને સામાન્ય બનાવે છે. તે મેટ્રિક્સ ગુણાકારનો ઉપયોગ કરે છે, જ્યાં વજનને 2D મેટ્રિક્સ તરીકે અને ઇનપુટ્સને વેક્ટર તરીકે દર્શાવવામાં આવે છે. આ કાર્યક્ષમ અભિગમ સ્તરમાંના તમામ ગાંઠો માટે એક સાથે ગણતરી કરવાની મંજૂરી આપે છે. પૂર્વગ્રહો ઉમેરીને અને ReLU સક્રિયકરણ કાર્ય લાગુ કરીને, સ્તરના અંતિમ આઉટપુટ ઉત્પન્ન થાય છે. આ પદ્ધતિ ખૂબ માપી શકાય તેવી છે અને આધુનિક ડીપ લર્નિંગ ફ્રેમવર્કમાં મુખ્ય કામગીરી છે. દાખલા તરીકે, ચહેરાની ઓળખ સિસ્ટમમાં, આ પ્રક્રિયા એ નક્કી કરવામાં મદદ કરી શકે છે કે શોધાયેલ આકાર માનવ ચહેરા જેવો છે કે કેમ. 😊

જેમ કે ડીપ લર્નિંગ લાઇબ્રેરીઓ સાથે કામ કરતા લોકો માટે PyTorch, ત્રીજી સ્ક્રિપ્ટ એ જ ગણતરીઓ હાંસલ કરવા માટે ટેન્સર્સ અને બિલ્ટ-ઇન ફંક્શનનો ઉપયોગ કેવી રીતે કરવો તે દર્શાવે છે. PyTorch ની લવચીકતા અને બિલ્ટ-ઇન ઑપ્ટિમાઇઝેશન તેને ન્યુરલ નેટવર્ક બનાવવા અને તાલીમ આપવા માટે આદર્શ બનાવે છે. સ્ક્રિપ્ટ બતાવે છે કે કેવી રીતે ઇનપુટ્સ, વજન અને પૂર્વગ્રહોને ટેન્સર તરીકે વ્યાખ્યાયિત કરવા અને મેટ્રિક્સ ગુણાકારનો ઉપયોગ કરીને torch.matmul() કાર્ય આ ખાસ કરીને મોટા ડેટાસેટ્સ પર CNN ને તાલીમ આપવા માટે એન્ડ-ટુ-એન્ડ પાઇપલાઇન્સ બનાવવા માટે ઉપયોગી છે, જેમ કે વન્યજીવન ફોટોગ્રાફ્સમાં પ્રાણીઓને ઓળખવા.

છેલ્લે, યુનિટ ટેસ્ટ સ્ક્રિપ્ટ ખાતરી કરે છે કે તમામ અમલીકરણો વિવિધ પરિસ્થિતિઓમાં યોગ્ય રીતે કાર્ય કરે છે. નો ઉપયોગ કરીને એકીકૃત પુસ્તકાલય, તે ગણતરીઓની સંખ્યાત્મક ચોકસાઈને ચકાસે છે અને પુષ્ટિ કરે છે કે આઉટપુટ અપેક્ષિત પરિણામોને પૂર્ણ કરે છે. ડિબગીંગ અને વિશ્વસનીયતા સુનિશ્ચિત કરવા માટે આ પગલું નિર્ણાયક છે, ખાસ કરીને જ્યારે તબીબી છબી વિશ્લેષણ જેવી વાસ્તવિક-વિશ્વ એપ્લિકેશન્સમાં CNN ને જમાવવામાં આવે ત્યારે. આ સ્ક્રિપ્ટો અને સ્પષ્ટતાઓ સાથે, તમારી પાસે હવે CNN માં FC સ્તરોને વિશ્વાસપૂર્વક સમજવા અને અમલમાં મૂકવાનો સ્પષ્ટ માર્ગ છે. 🚀

સંપૂર્ણપણે કનેક્ટેડ લેયરમાં નોડની ગણતરી સમજવી

મેટ્રિક્સ ગણતરીઓ માટે Python-આધારિત ઉકેલ NumPyનો લાભ લે છે

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

સંપૂર્ણપણે કનેક્ટેડ સ્તરોમાં નોડની ગણતરીનું સામાન્યકરણ

છુપાયેલા સ્તરમાં તમામ ગાંઠોની ગણતરી કરવા માટે પાયથોન-આધારિત ઉકેલ

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

સંપૂર્ણપણે કનેક્ટેડ લેયરમાં નોડની ગણતરી માટે PyTorch નો ઉપયોગ

ઊંડા અભ્યાસના ઉત્સાહીઓ માટે PyTorch સાથે અમલીકરણ

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

યુનિટ ટેસ્ટ સાથે દરેક સોલ્યુશનનું પરીક્ષણ કરો

અમલીકરણની ચોકસાઈની ખાતરી કરવા માટે પાયથોન-આધારિત એકમ પરીક્ષણો

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

CNN માં સંપૂર્ણપણે કનેક્ટેડ સ્તરોના મહત્વને ઉકેલવું

સંપૂર્ણ રીતે જોડાયેલા (FC) સ્તરો અંતિમ અનુમાનોમાં કન્વોલ્યુશનલ લેયર્સમાંથી એક્સટ્રેક્ટેડ ફીચર્સને રૂપાંતરિત કરવામાં મુખ્ય ભૂમિકા ભજવે છે. તેઓ દરેક ઇનપુટને દરેક આઉટપુટ સાથે કનેક્ટ કરીને કાર્ય કરે છે, શીખેલ સુવિધાઓનું ગાઢ મેપિંગ પ્રદાન કરે છે. અવકાશી વંશવેલો પર ધ્યાન કેન્દ્રિત કરતા કન્વોલ્યુશનલ સ્તરોથી વિપરીત, એફસી સ્તરો આ માહિતીને એક ઇમેજમાં ઑબ્જેક્ટને ઓળખવા જેવા નિર્ણયો લેવા માટે એકત્રિત કરે છે. દાખલા તરીકે, સેલ્ફ-ડ્રાઇવિંગ કારની ઇમેજ રેકગ્નિશન સિસ્ટમમાં, FC લેયર એ નક્કી કરી શકે છે કે શોધાયેલ ઑબ્જેક્ટ રાહદારી છે કે શેરીનું ચિહ્ન. 🚗

એક પાસું જે FC સ્તરોને અલગ પાડે છે તે તાલીમ દરમિયાન શીખેલા દાખલાઓનું સામાન્યીકરણ કરવાની તેમની ક્ષમતા છે. અદ્રશ્ય ડેટા સાથે કામ કરતી વખતે આ ગુણધર્મ નિર્ણાયક છે. સ્તરમાં દરેક નોડ વજન અને પૂર્વગ્રહોના અનન્ય સંયોજનને રજૂ કરે છે, જે તેને ચોક્કસ પેટર્ન અથવા વર્ગોને ઓળખવામાં નિષ્ણાત બનવા માટે સક્ષમ બનાવે છે. તેથી જ FC સ્તરોનું માળખું ઘણીવાર એકંદર મોડલની ચોકસાઈ નક્કી કરે છે. ઉદાહરણ તરીકે, હસ્તલિખિત અંકોની ઓળખ મોડેલમાં, FC સ્તર પિક્સેલ પેટર્નને સંખ્યાત્મક અનુમાનો (0-9) માં એકીકૃત કરે છે. ✍️

જ્યારે FC સ્તરો તેમના ગાઢ જોડાણોને કારણે ગણતરીત્મક રીતે ખર્ચાળ હોય છે, ત્યારે તેઓ વિગતવાર વર્ગીકરણની જરૂર હોય તેવા કાર્યો માટે મહત્વપૂર્ણ રહે છે. ડ્રોપઆઉટ જેવી આધુનિક તકનીકોનો ઉપયોગ ઓવરફિટિંગ અટકાવીને તેમના પ્રદર્શનને શ્રેષ્ઠ બનાવવા માટે કરવામાં આવે છે. તાલીમ દરમિયાન સક્રિય ગાંઠોની સંખ્યા ઘટાડીને, ડ્રોપઆઉટ એ સુનિશ્ચિત કરે છે કે FC સ્તર મજબૂત લક્ષણો શીખે છે, જે તેને ચહેરાની ઓળખ અને તબીબી છબી નિદાન જેવી એપ્લિકેશનમાં અનિવાર્ય બનાવે છે.

સંપૂર્ણપણે કનેક્ટેડ સ્તરો વિશે સામાન્ય પ્રશ્નો

- CNN માં સંપૂર્ણ રીતે જોડાયેલા સ્તરનું મુખ્ય કાર્ય શું છે?

- એફસી લેયર તમામ ઇનપુટ્સને આઉટપુટ સાથે જોડે છે, અંતિમ અનુમાન માટે વિશેષતાઓને એકીકૃત કરે છે. તે કાર્યક્ષમ પરિણામોમાં લક્ષણ નકશાને રૂપાંતરિત કરવાની ચાવી છે.

- FC સ્તરોમાં વજન અને પૂર્વગ્રહો કેવી રીતે શરૂ થાય છે?

- વજન ઘણીવાર રેન્ડમ રીતે શરૂ કરવામાં આવે છે અથવા ઝેવિયર ઇનિશિયલાઇઝેશન જેવી તકનીકોનો ઉપયોગ કરીને કરવામાં આવે છે, જ્યારે પૂર્વગ્રહ સામાન્ય રીતે સરળતા માટે શૂન્યથી શરૂ થાય છે.

- ReLU એક્ટિવેશન FC લેયરની કામગીરીને કેવી રીતે સુધારે છે?

- ReLU નકારાત્મક આઉટપુટને શૂન્ય પર સેટ કરીને બિન-રેખીયતા લાગુ કરે છે. તે અદ્રશ્ય થતા ગ્રેડિએન્ટ્સને અટકાવે છે, જે મોડલને વધુ ઝડપી બનાવે છે.

- શું ડ્રોપઆઉટ FC સ્તરો પર લાગુ કરી શકાય છે?

- હા, ડ્રોપઆઉટ રેન્ડમલી ટ્રેનિંગ દરમિયાન નોડ્સને અક્ષમ કરે છે, મોડલ સામાન્યીકરણને વધારે છે અને ઓવરફિટિંગ ઘટાડે છે.

- FC સ્તરોને કંવોલ્યુશનલ સ્તરોથી અલગ શું બનાવે છે?

- જ્યારે કન્વોલ્યુશનલ સ્તરો અવકાશી વિશેષતાઓને બહાર કાઢે છે, ત્યારે FC સ્તરો આ લક્ષણોને વર્ગીકરણ માટે ગાઢ સ્વરૂપમાં એકીકૃત કરે છે.

સંપૂર્ણપણે કનેક્ટેડ સ્તરો પર મુખ્ય ટેકવેઝ

સંપૂર્ણ રીતે જોડાયેલ સ્તર શીખેલા લક્ષણોને કાર્યક્ષમ અનુમાનોમાં એકીકૃત કરે છે, જે ન્યુરલ નેટવર્ક્સમાં અંતિમ નિર્ણય લેવાના પગલા તરીકે સેવા આપે છે. દરેક નોડની ગણતરી કેવી રીતે કરવામાં આવે છે તે સમજવાથી, વપરાશકર્તાઓ ઑબ્જેક્ટ શોધ અને વર્ગીકરણ જેવા કાર્યો માટે CNN આર્કિટેક્ચરને ડિઝાઇન અને ઑપ્ટિમાઇઝ કરવામાં વિશ્વાસ મેળવે છે.

વ્યવહારુ ઉદાહરણો, જેમ કે સ્વાયત્ત વાહનોમાં ઇમેજ રેકગ્નિશન અથવા ચહેરાની ઓળખ, FC સ્તરોનું મહત્વ દર્શાવે છે. યોગ્ય અભિગમ સાથે, ઑપ્ટિમાઇઝેશન પદ્ધતિઓનો સમાવેશ કરવાથી મજબૂત અને સચોટ મૉડલ સુનિશ્ચિત થાય છે જે અદ્રશ્ય ડેટાને સારી રીતે સ્વીકારે છે. આ ખ્યાલની નિપુણતા કૃત્રિમ બુદ્ધિમાં ઊંડા સંશોધનને ખોલે છે. 😊

સ્ત્રોતો અને સંદર્ભો

- CNN માં સંપૂર્ણ કનેક્ટેડ સ્તરો પર વિગતવાર સમજૂતી મશીન લર્નિંગ માસ્ટરી .

- સક્રિયકરણ કાર્યો માટે વ્યાપક માર્ગદર્શિકા અને તેમની એપ્લિકેશનોમાંથી પુનઃપ્રાપ્ત એનાલિટિક્સ વિદ્યા .

- ન્યુરલ નેટવર્ક્સ માટે ડ્રોપઆઉટ અને ઓપ્ટિમાઇઝેશન તકનીકોની આંતરદૃષ્ટિ અહીં મળી ડીપીએઆઈ .

- થી ન્યુરલ નેટવર્ક્સમાં વજન અને પૂર્વગ્રહોને સમજવું ડેટા સાયન્સ તરફ .

- PyTorch માં ReLU એક્ટિવેશન ફંક્શનનો ઉપયોગ જેમાંથી મેળવેલ છે PyTorch દસ્તાવેજીકરણ .