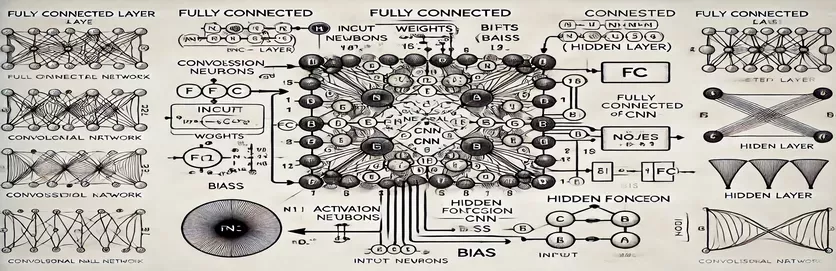

सीएनएन में पूरी तरह से जुड़ी हुई परतों का रहस्योद्घाटन

कन्वेन्शनल न्यूरल नेटवर्क (सीएनएन) में फुली कनेक्टेड (एफसी) परत की कार्यप्रणाली को समझना एक रहस्य को सुलझाने जैसा महसूस हो सकता है। कई लोगों के लिए, जटिलता गणना प्रक्रिया में निहित है और छिपी हुई परत में एक नोड कैसे प्राप्त होता है। पारंपरिक कृत्रिम तंत्रिका नेटवर्क (एएनएन) के विपरीत, सीएनएन में एफसी परत में बारीकियां होती हैं जो अक्सर ट्यूटोरियल में अस्पष्ट हो जाती हैं। यदि आप इस बारे में उलझन में हैं, तो आप अकेले नहीं हैं!

कई संसाधन इस विषय पर लापरवाही बरतते हैं, जिससे शिक्षार्थियों को स्पष्ट मार्गदर्शन नहीं मिल पाता है। ट्यूटोरियल अक्सर अधूरे स्पष्टीकरणों को दोहराते हैं, जिससे स्पष्टता चाहने वालों की निराशा बढ़ जाती है। यदि आप स्वयं को बार-बार उत्तर खोजते हुए पाते हैं, तो आप सही जगह पर हैं। 🧩

इस गाइड में, हम एफसी परत की छिपी हुई परत से एकल नोड की गणना करने पर ध्यान केंद्रित करेंगे। एक बार जब आप एक नोड के लिए तंत्र को समझ लेते हैं, तो आप बाकी से निपटने के लिए तैयार हो जाएंगे। इस प्रक्रिया को स्पष्ट, कार्रवाई योग्य चरणों में तोड़कर, आप किसी भी एफसी परत गणना को नेविगेट करने का आत्मविश्वास हासिल करेंगे।

संबंधित उदाहरणों और एक सीधे आरेख का उपयोग करके, हम एफसी परत में इनपुट से आउटपुट तक के मार्ग को उजागर करेंगे। भ्रम को अलविदा कहें और समझ को नमस्कार-आइए गहराई में उतरें! 🚀

| आज्ञा | उपयोग का उदाहरण |

|---|---|

| np.dot() | दो सरणियों के बीच डॉट उत्पाद निष्पादित करता है। पूरी तरह से कनेक्टेड परत में एक नोड के लिए इनपुट और वजन के भारित योग की गणना करने के लिए यहां उपयोग किया जाता है। |

| np.maximum() | परिकलित आउटपुट और शून्य के बीच अधिकतम मान का चयन करके ReLU सक्रियण फ़ंक्शन लागू करता है। |

| torch.tensor() | PyTorch में एक टेंसर बनाता है। गहन शिक्षण ढाँचे में डेटा प्रतिनिधित्व के लिए टेंसर बुनियादी निर्माण खंड हैं। |

| torch.matmul() | PyTorch में मैट्रिक्स गुणन करता है। इनपुट और वज़न के बीच डॉट उत्पाद की गणना करने के लिए उपयोग किया जाता है। |

| torch.nn.functional.relu() | PyTorch में ReLU सक्रियण फ़ंक्शन लागू करता है, टेंसर में सभी नकारात्मक मानों को शून्य पर सेट करता है। |

| np.testing.assert_array_almost_equal() | एक निश्चित सहनशीलता के भीतर समानता के लिए तत्व-वार दो सरणियों की तुलना करता है। संख्यात्मक परिचालनों में आउटपुट शुद्धता का परीक्षण करने के लिए उपयोगी। |

| unittest.TestCase | परीक्षण मामले बनाने के लिए यूनिटटेस्ट मॉड्यूल में एक बेस क्लास। पायथन में यूनिट परीक्षणों की संरचना और व्यवस्थित करने के लिए उपयोग किया जाता है। |

| np.array() | NumPy में एक सरणी बनाता है। पूरी तरह से कनेक्टेड परत गणना में इनपुट, वजन और पूर्वाग्रहों का प्रतिनिधित्व करने के लिए सरणियों का उपयोग किया जाता है। |

| torch.matmul() | मैट्रिक्स गुणन के लिए PyTorch का कार्य, तंत्रिका नेटवर्क में आउटपुट की गणना के लिए महत्वपूर्ण है। |

| unittest.main() | स्क्रिप्ट में परिभाषित सभी परीक्षण मामलों को चलाता है। कार्यान्वित समाधानों की सटीकता और विश्वसनीयता को मान्य करने के लिए आवश्यक। |

पूरी तरह से कनेक्टेड परत गणनाओं को तोड़ना

प्रदान की गई लिपियों का उद्देश्य यह रहस्योद्घाटन करना है कि एक नोड कैसे होता है CNN की परत पिछली परत से डेटा संसाधित करती है। ये परतें भारित लिंक और पूर्वाग्रहों का उपयोग करके प्रत्येक इनपुट को प्रत्येक नोड से जोड़ती हैं, जिससे वे छवि वर्गीकरण जैसे कार्यों के लिए आवश्यक हो जाती हैं। पहली स्क्रिप्ट का उपयोग करके एकल नोड के लिए आउटपुट की गणना की जाती है . इनपुट मानों को उनके संगत भार से गुणा करके और पूर्वाग्रह जोड़कर, नोड आउटपुट प्राप्त किया जाता है। फिर इस आउटपुट को गैर-रैखिकता पेश करने के लिए एक सक्रियण फ़ंक्शन (उदाहरण के लिए, ReLU) के माध्यम से पारित किया जाता है। उदाहरण के लिए, किसी छवि के पिक्सेल मानों को इनपुट के रूप में कल्पना करें; वज़न सीखे गए फ़िल्टर का प्रतिनिधित्व कर सकते हैं जो छवि से सार्थक विशेषताएं निकालते हैं। 🖼️

दूसरी स्क्रिप्ट एकाधिक नोड्स के लिए गणना को सामान्य बनाती है। यह मैट्रिक्स गुणन का उपयोग करता है, जहां वजन को 2डी मैट्रिक्स के रूप में और इनपुट को वेक्टर के रूप में दर्शाया जाता है। यह कुशल दृष्टिकोण परत में सभी नोड्स के लिए एक साथ गणना की अनुमति देता है। पूर्वाग्रहों को जोड़कर और ReLU सक्रियण फ़ंक्शन को लागू करके, परत के अंतिम आउटपुट उत्पन्न होते हैं। यह विधि अत्यधिक स्केलेबल है और आधुनिक गहन शिक्षण ढांचे में एक मुख्य ऑपरेशन है। उदाहरण के लिए, चेहरा पहचान प्रणाली में, यह प्रक्रिया यह निर्धारित करने में मदद कर सकती है कि पता लगाया गया आकार मानव चेहरे जैसा दिखता है या नहीं। 😊

गहन शिक्षण पुस्तकालयों के साथ काम करने वालों के लिए , तीसरी स्क्रिप्ट दर्शाती है कि समान गणना प्राप्त करने के लिए टेंसर और अंतर्निहित फ़ंक्शन का उपयोग कैसे करें। PyTorch का लचीलापन और अंतर्निहित अनुकूलन इसे तंत्रिका नेटवर्क के निर्माण और प्रशिक्षण के लिए आदर्श बनाते हैं। स्क्रिप्ट दिखाती है कि इनपुट, वज़न और पूर्वाग्रहों को टेंसर के रूप में कैसे परिभाषित किया जाए और इसका उपयोग करके मैट्रिक्स गुणन कैसे किया जाए समारोह। यह बड़े डेटासेट पर सीएनएन को प्रशिक्षित करने के लिए एंड-टू-एंड पाइपलाइन बनाने के लिए विशेष रूप से उपयोगी है, जैसे वन्यजीव तस्वीरों में जानवरों की पहचान करना।

अंत में, यूनिट परीक्षण स्क्रिप्ट यह सुनिश्चित करती है कि सभी कार्यान्वयन विभिन्न परिस्थितियों में सही ढंग से काम करते हैं। का उपयोग लाइब्रेरी, यह गणनाओं की संख्यात्मक सटीकता की पुष्टि करती है और पुष्टि करती है कि आउटपुट अपेक्षित परिणामों को पूरा करते हैं। यह कदम डिबगिंग और विश्वसनीयता सुनिश्चित करने के लिए महत्वपूर्ण है, खासकर जब मेडिकल छवि विश्लेषण जैसे वास्तविक दुनिया के अनुप्रयोगों में सीएनएन को तैनात किया जाता है। इन स्क्रिप्ट्स और स्पष्टीकरणों के साथ, अब आपके पास सीएनएन में एफसी परतों को आत्मविश्वास से समझने और लागू करने का एक स्पष्ट रास्ता है। 🚀

पूरी तरह से कनेक्टेड परत में एक नोड की गणना को समझना

मैट्रिक्स गणनाओं के लिए NumPy का लाभ उठाते हुए पायथन-आधारित समाधान

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

पूरी तरह से कनेक्टेड परतों में नोड गणना को सामान्य बनाना

एक छिपी हुई परत में सभी नोड्स की गणना के लिए पायथन-आधारित समाधान

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

पूरी तरह से कनेक्टेड परत में नोड गणना के लिए PyTorch का उपयोग करना

गहन शिक्षण के प्रति उत्साही लोगों के लिए PyTorch के साथ कार्यान्वयन

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

यूनिट टेस्ट के साथ प्रत्येक समाधान का परीक्षण करें

कार्यान्वयन की शुद्धता सुनिश्चित करने के लिए पायथन-आधारित इकाई परीक्षण

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

सीएनएन में पूरी तरह से कनेक्टेड परतों के महत्व को उजागर करना

पूरी तरह से जुड़ी हुई (एफसी) परतें कन्वेन्शनल परतों से निकाली गई विशेषताओं को अंतिम भविष्यवाणियों में बदलने में महत्वपूर्ण भूमिका निभाती हैं। वे प्रत्येक इनपुट को प्रत्येक आउटपुट से जोड़कर, सीखी गई सुविधाओं की सघन मैपिंग प्रदान करके काम करते हैं। स्थानिक पदानुक्रम पर ध्यान केंद्रित करने वाली दृढ़ परतों के विपरीत, एफसी परतें किसी छवि में वस्तुओं की पहचान करने जैसे निर्णय लेने के लिए इस जानकारी को एकत्रित करती हैं। उदाहरण के लिए, सेल्फ-ड्राइविंग कार की छवि पहचान प्रणाली में, एफसी परत यह निर्धारित कर सकती है कि पहचानी गई वस्तु पैदल यात्री है या सड़क चिन्ह। 🚗

एक पहलू जो एफसी परतों को अलग करता है वह है प्रशिक्षण के दौरान सीखे गए पैटर्न को सामान्य बनाने की उनकी क्षमता। अदृश्य डेटा से निपटने के दौरान यह संपत्ति महत्वपूर्ण है। परत में प्रत्येक नोड वजन और पूर्वाग्रहों के एक अद्वितीय संयोजन का प्रतिनिधित्व करता है, जो इसे विशिष्ट पैटर्न या वर्गों को पहचानने में विशेषज्ञता प्रदान करता है। यही कारण है कि एफसी परतों की संरचना अक्सर समग्र मॉडल की सटीकता निर्धारित करती है। उदाहरण के लिए, हस्तलिखित अंक पहचान मॉडल में, एफसी परत पिक्सेल पैटर्न को संख्यात्मक भविष्यवाणियों (0-9) में समेकित करती है। ✍️

जबकि एफसी परतें अपने घने कनेक्शन के कारण कम्प्यूटेशनल रूप से महंगी हैं, वे विस्तृत वर्गीकरण की आवश्यकता वाले कार्यों के लिए महत्वपूर्ण बनी हुई हैं। ओवरफिटिंग को रोककर उनके प्रदर्शन को अनुकूलित करने के लिए ड्रॉपआउट जैसी आधुनिक तकनीकों का उपयोग किया जाता है। प्रशिक्षण के दौरान सक्रिय नोड्स की संख्या को कम करके, ड्रॉपआउट यह सुनिश्चित करता है कि एफसी परत मजबूत विशेषताएं सीखती है, जिससे यह चेहरे की पहचान और चिकित्सा छवि निदान जैसे अनुप्रयोगों में अपरिहार्य हो जाती है।

- सीएनएन में पूरी तरह से जुड़ी परत का मुख्य कार्य क्या है?

- एफसी परत सभी इनपुट को आउटपुट से जोड़ती है, अंतिम भविष्यवाणियों के लिए सुविधाओं को एकत्रित करती है। यह फ़ीचर मानचित्रों को क्रियाशील परिणामों में बदलने की कुंजी है।

- एफसी परतों में वज़न और पूर्वाग्रहों को कैसे प्रारंभ किया जाता है?

- वज़न को अक्सर बेतरतीब ढंग से आरंभ किया जाता है या ज़ेवियर इनिशियलाइज़ेशन जैसी तकनीकों का उपयोग किया जाता है, जबकि सरलता के लिए पूर्वाग्रह आमतौर पर शून्य से शुरू होते हैं।

- ReLU सक्रियण FC परत के प्रदर्शन को कैसे सुधारता है?

- ReLU नकारात्मक आउटपुट को शून्य पर सेट करके गैर-रैखिकता लागू करता है। यह गायब होने वाले ग्रेडिएंट्स को रोकता है, जिससे मॉडल तेजी से एकत्रित होता है।

- क्या ड्रॉपआउट को एफसी परतों पर लागू किया जा सकता है?

- हां, ड्रॉपआउट प्रशिक्षण के दौरान नोड्स को बेतरतीब ढंग से अक्षम कर देता है, मॉडल सामान्यीकरण को बढ़ाता है और ओवरफिटिंग को कम करता है।

- एफसी परतें संकेंद्रित परतों से किस प्रकार भिन्न हैं?

- जबकि संकेंद्रित परतें स्थानिक विशेषताओं को निकालती हैं, एफसी परतें वर्गीकरण के लिए इन विशेषताओं को एक सघन प्रारूप में एकत्रित करती हैं।

पूरी तरह से जुड़ी हुई परत सीखी गई विशेषताओं को कार्रवाई योग्य भविष्यवाणियों में समेकित करती है, जो तंत्रिका नेटवर्क में अंतिम निर्णय लेने वाले चरण के रूप में कार्य करती है। यह समझकर कि प्रत्येक नोड की गणना कैसे की जाती है, उपयोगकर्ता ऑब्जेक्ट डिटेक्शन और वर्गीकरण जैसे कार्यों के लिए सीएनएन आर्किटेक्चर को डिजाइन और अनुकूलित करने में विश्वास हासिल करते हैं।

व्यावहारिक उदाहरण, जैसे स्वायत्त वाहनों में छवि पहचान या चेहरे की पहचान, एफसी परतों के महत्व को दर्शाते हैं। सही दृष्टिकोण के साथ, अनुकूलन विधियों को शामिल करने से मजबूत और सटीक मॉडल सुनिश्चित होते हैं जो अनदेखे डेटा के लिए अच्छी तरह अनुकूल होते हैं। इस अवधारणा की महारत कृत्रिम बुद्धिमत्ता में गहन अन्वेषण को खोलती है। 😊

- सीएनएन में पूरी तरह से जुड़ी परतों पर विस्तृत विवरण यहां से प्राप्त किया गया है मशीन लर्निंग में महारत .

- सक्रियण कार्यों और उनके अनुप्रयोगों के लिए व्यापक मार्गदर्शिका यहां से प्राप्त की गई है विश्लेषिकी विद्या .

- तंत्रिका नेटवर्क के लिए ड्रॉपआउट और अनुकूलन तकनीकों में अंतर्दृष्टि पाई गई दीपएआई .

- तंत्रिका नेटवर्क में भार और पूर्वाग्रह को समझना डेटा साइंस की ओर .

- PyTorch में ReLU सक्रियण फ़ंक्शंस का उपयोग पायटोरच दस्तावेज़ीकरण .