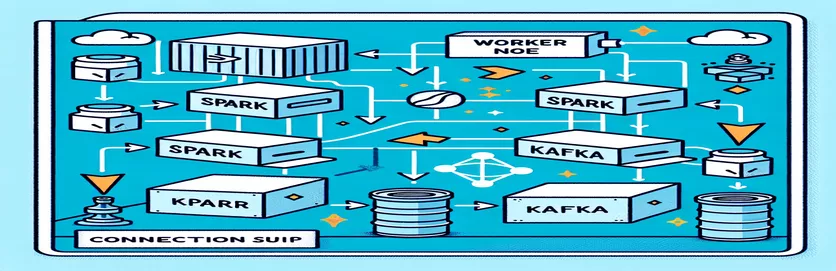

डॉकरीकृत वातावरण में स्पार्क और काफ्का को एकीकृत करने की चुनौतियाँ

क्या आपको कभी एकीकृत करते समय कनेक्टिविटी समस्या का सामना करना पड़ा है? काफ्का ब्रोकर एक में स्पार्क क्लस्टर डॉकर सेटअप के भीतर? आप अकेले नहीं हैं! इन दो शक्तिशाली उपकरणों के बीच संचार स्थापित करते समय कई डेवलपर्स को बाधाओं का सामना करना पड़ता है। 🛠️

हाल ही में, मैंने अपना सुधार करना शुरू किया स्पार्क क्लस्टर वास्तविक समय डेटा प्रोसेसिंग को सुव्यवस्थित करने के लिए काफ्का ब्रोकर को जोड़कर। हालाँकि, मुझे लगातार कनेक्शन टाइमआउट और डीएनएस रिज़ॉल्यूशन त्रुटियों के कारण एक बाधा का सामना करना पड़ा, जिसने प्रक्रिया को समस्या निवारण मैराथन में बदल दिया। 😅

ये समस्याएँ डॉकर कंपोज़ और स्पार्क के काफ्का-संबंधित कॉन्फ़िगरेशन में गलत कॉन्फ़िगर की गई सेटिंग्स के कारण उत्पन्न हुईं। कई दिशानिर्देशों का पालन करने और कई मापदंडों में बदलाव करने के बावजूद, मायावी "दलाल उपलब्ध नहीं हो सकता" संदेश कायम रहा, जिससे मैं हैरान और निराश हो गया।

इस लेख में, मैं अपना अनुभव साझा करूंगा और डॉकर वातावरण में स्पार्क श्रमिकों और काफ्का दलालों के बीच कनेक्टिविटी चुनौतियों को हल करने के लिए व्यावहारिक कदम पेश करूंगा। रास्ते में, आप इन नुकसानों से बचने और निर्बाध एकीकरण सुनिश्चित करने के लिए युक्तियाँ और तरकीबें सीखेंगे। चलो अंदर गोता लगाएँ! 🚀

| आज्ञा | उपयोग का उदाहरण |

|---|---|

| from_json() | यह स्पार्क SQL फ़ंक्शन JSON स्ट्रिंग को पार्स करता है और एक संरचित डेटा ऑब्जेक्ट बनाता है। उदाहरण में, इसका उपयोग काफ्का संदेशों को संरचित डेटा में डिसेरिएलाइज़ करने के लिए किया जाता है। |

| StructType() | संरचित डेटा प्रोसेसिंग के लिए एक स्कीमा को परिभाषित करता है। यह काफ्का संदेशों के अपेक्षित प्रारूप को परिभाषित करने के लिए विशेष रूप से उपयोगी है। |

| .readStream | स्पार्क में एक स्ट्रीमिंग डेटाफ़्रेम आरंभ करता है, जो काफ्का या अन्य स्ट्रीमिंग स्रोतों से निरंतर डेटा अंतर्ग्रहण की अनुमति देता है। |

| writeStream | स्पार्क स्ट्रक्चर्ड स्ट्रीमिंग क्वेरी के लिए आउटपुट मोड और सिंक को परिभाषित करता है। यहां, यह एपेंड मोड में कंसोल पर लिखने को निर्दिष्ट करता है। |

| bootstrap_servers | एक काफ्का कॉन्फ़िगरेशन पैरामीटर जो काफ्का ब्रोकर का पता निर्दिष्ट करता है। स्पार्क और काफ्का संचार के लिए महत्वपूर्ण। |

| auto_offset_reset | एक काफ्का उपभोक्ता सेटिंग जो यह निर्धारित करती है कि कोई पूर्व ऑफसेट मौजूद न होने पर संदेश कहां से पढ़ना शुरू करें। "सबसे पुराना" विकल्प सबसे पुराने संदेश से शुरू होता है। |

| KAFKA_ADVERTISED_LISTENERS | एक डॉकर काफ्का कॉन्फ़िगरेशन पर्यावरण चर। यह डॉकर नेटवर्क के भीतर और बाहर उचित संचार सुनिश्चित करते हुए, काफ्का ग्राहकों के लिए विज्ञापित पते निर्दिष्ट करता है। |

| KAFKA_LISTENERS | नेटवर्क इंटरफेस को कॉन्फ़िगर करता है जिस पर काफ्का ब्रोकर आने वाले कनेक्शन को सुनता है। यहां आंतरिक और बाह्य संचार को अलग करने के लिए उपयोग किया जाता है। |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | विभिन्न काफ्का श्रोताओं के लिए सुरक्षा प्रोटोकॉल को परिभाषित करता है। यह श्रोता के नाम को उनके संबंधित प्रोटोकॉल में मैप करता है, जैसे इस मामले में PLAINTEXT। |

| .awaitTermination() | एक स्पार्क संरचित स्ट्रीमिंग विधि जो स्ट्रीमिंग क्वेरी समाप्त होने तक स्क्रिप्ट के निष्पादन को अवरुद्ध करती है, यह सुनिश्चित करती है कि स्ट्रीम लगातार चलती रहे। |

डॉकर में स्पार्क और काफ्का एकीकरण को समझना

पहली स्क्रिप्ट ए के बीच संबंध स्थापित करने पर केंद्रित है चिंगारी कार्यकर्ता और ए काफ्का ब्रोकर. स्पार्क की स्ट्रक्चर्ड स्ट्रीमिंग एपीआई का उपयोग करके, स्क्रिप्ट काफ्का विषय से वास्तविक समय डेटा पढ़ती है। इसकी शुरुआत स्पार्क सत्र शुरू करने और इसे आवश्यक काफ्का पैकेज के साथ कॉन्फ़िगर करने से होती है। यह महत्वपूर्ण है क्योंकि यह स्पार्क को काफ्का के साथ निर्बाध रूप से संवाद करने के लिए आवश्यक निर्भरता प्रदान करता है। इस निर्भरता का एक उदाहरण `org.apache.spark:spark-sql-kafka` पैकेज है, जो डॉकर वातावरण में स्पार्क और काफ्का के बीच अनुकूलता सुनिश्चित करता है।

काफ्का संदेशों को संभालने के लिए, स्क्रिप्ट `स्ट्रक्चरटाइप` का उपयोग करके एक स्कीमा को परिभाषित करती है। यह स्कीमा सुनिश्चित करती है कि आने वाले संदेशों को सही ढंग से पार्स और संरचित किया गया है। वास्तविक दुनिया के परिदृश्यों में अक्सर काफ्का से JSON डेटा को संभालना शामिल होता है। उदाहरण के लिए, एक क्रिप्टोकरेंसी मॉनिटरिंग सिस्टम की कल्पना करें जहां मूल्य अपडेट वाले संदेश काफ्का को भेजे जाते हैं। इन संदेशों को पढ़ने योग्य प्रारूप में पार्स करने से प्रवृत्ति पूर्वानुमान के लिए डेटा को संसाधित करना और उसका विश्लेषण करना आसान हो जाता है। 🪙

डॉकर कंपोज़ कॉन्फ़िगरेशन कनेक्टिविटी समस्याओं को हल करने में महत्वपूर्ण भूमिका निभाता है। डॉकर नेटवर्क के भीतर आंतरिक और बाहरी संचार को अलग करने के लिए `KAFKA_ADVERTISED_LISTENERS` और `KAFKA_LISTENERS` सेटिंग्स को समायोजित किया जाता है। यह सुनिश्चित करता है कि एक ही डॉकर नेटवर्क पर चलने वाली सेवाएं, जैसे स्पार्क और काफ्का, डीएनएस रिज़ॉल्यूशन समस्याओं के बिना बातचीत कर सकती हैं। उदाहरण के लिए, मैपिंग `INSIDE://kafka:9093` आंतरिक कंटेनरों को काफ्का तक पहुंचने की अनुमति देता है, जबकि `OUTSIDE://localhost:9093` मॉनिटरिंग टूल जैसे बाहरी अनुप्रयोगों को कनेक्ट करने में सक्षम बनाता है।

दूसरी स्क्रिप्ट दर्शाती है कि काफ्का कनेक्शन के परीक्षण के लिए पायथन `काफ्काकंस्यूमर` का उपयोग कैसे करें। यह सुनिश्चित करने के लिए एक सरल लेकिन प्रभावी तरीका है कि काफ्का ब्रोकर सही ढंग से काम कर रहा है। निर्दिष्ट विषय से संदेशों का उपभोग करके, आप सत्यापित कर सकते हैं कि डेटा प्रवाह निर्बाध है या नहीं। एक ऐसे एप्लिकेशन पर विचार करें जहां उपयोगकर्ता स्टॉक मार्केट डेटा को ट्रैक करना चाहता है। इस उपभोक्ता स्क्रिप्ट का उपयोग करके कनेक्शन का परीक्षण यह सुनिश्चित करता है कि कॉन्फ़िगरेशन त्रुटियों के कारण कोई भी महत्वपूर्ण अपडेट छूट न जाए। इन उपकरणों के साथ, आप वास्तविक समय डेटा प्रोसेसिंग के लिए आत्मविश्वास से मजबूत सिस्टम तैनात कर सकते हैं! 🚀

स्पार्क वर्कर और काफ्का ब्रोकर के बीच कनेक्टिविटी मुद्दों को संभालना

समाधान 1: डॉकर के साथ स्पार्क और काफ्का में डिबगिंग और कनेक्शन समस्याओं को हल करने के लिए पायथन का उपयोग करना

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

डॉकराइज़्ड काफ्का में DNS रिज़ॉल्यूशन समस्याओं को डीबग करना

समाधान 2: उचित DNS रिज़ॉल्यूशन के लिए डॉकर कंपोज़ कॉन्फ़िगरेशन को संशोधित करना

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

काफ्का उपभोक्ता कनेक्शन का परीक्षण

समाधान 3: कनेक्शन के परीक्षण के लिए पायथन काफ्का उपभोक्ता

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

डॉकरीकृत वातावरण में काफ्का और स्पार्क का अनुकूलन

के बीच सहज संचार सुनिश्चित करने का एक महत्वपूर्ण पहलू काफ्का ब्रोकर्स और स्पार्क वर्कर्स डॉकर में नेटवर्क सेटिंग्स को प्रभावी ढंग से कॉन्फ़िगर किया जा रहा है। डॉकर कंटेनर पृथक वातावरण में काम करते हैं, जिससे सेवाओं को इंटरैक्ट करने की आवश्यकता होने पर अक्सर DNS रिज़ॉल्यूशन समस्याएं पैदा होती हैं। इसे संबोधित करने के लिए, आप डॉकर कंपोज़ के नेटवर्क कॉन्फ़िगरेशन विकल्पों का लाभ उठा सकते हैं। उदाहरण के लिए, `my_network` जैसे कस्टम नेटवर्क को परिभाषित करना और सेवाओं को लिंक करना यह सुनिश्चित करता है कि कंटेनर आईपी के बजाय नाम से एक-दूसरे को पहचानते हैं, जो सेटअप को सरल बनाता है और सामान्य नुकसान से बचाता है।

एक अन्य आवश्यक विचार काफ्का के श्रोता विन्यास को अनुकूलित करना है। अपनी डॉकर कंपोज़ फ़ाइल में `KAFKA_ADVERTISED_LISTENERS` और `KAFKA_LISTENERS` निर्दिष्ट करके, आप काफ्का को अपने ग्राहकों के लिए उचित पते का विज्ञापन करने की अनुमति देते हैं। आंतरिक और बाहरी श्रोताओं के बीच यह अंतर संघर्षों को हल करता है, खासकर जब स्पार्क वर्कर्स डॉकर नेटवर्क के बाहर से जुड़ने का प्रयास करते हैं। इसका एक वास्तविक उदाहरण एक मॉनिटरिंग डैशबोर्ड है जो एक होस्ट मशीन से काफ्का डेटा को क्वेरी करता है, जिसके उपयोग के लिए एक अलग बाहरी श्रोता की आवश्यकता होती है। 🔧

अंत में, आपके स्पार्क अनुप्रयोगों में मजबूत त्रुटि प्रबंधन लागू करना महत्वपूर्ण है। उदाहरण के लिए, काफ्का कॉन्फ़िगरेशन के भीतर पुनः प्रयास और फ़ॉलबैक का लाभ उठाकर अस्थायी कनेक्टिविटी समस्याओं को खूबसूरती से संभाला जा सकता है। `.option("kafka.consumer.max.poll.records", "500")` जोड़ने से भारी भार के तहत भी कुशल डेटा पुनर्प्राप्ति सुनिश्चित होती है। एक उत्पादन-ग्रेड एप्लिकेशन की कल्पना करें जो वास्तविक समय में स्टॉक की कीमतों पर नज़र रखता है - जगह में फेल-सेफ होने से नेटवर्क हिचकी के दौरान भी निर्बाध डेटा प्रवाह सुनिश्चित होता है। ये तकनीकें मिलकर एक विश्वसनीय डेटा प्रोसेसिंग पाइपलाइन की रीढ़ बनती हैं। 🚀

डॉकर में स्पार्क और काफ्का के बारे में सामान्य प्रश्न

- का उद्देश्य क्या है KAFKA_ADVERTISED_LISTENERS?

- यह डॉकर नेटवर्क के अंदर और बाहर उचित संचार सुनिश्चित करते हुए, काफ्का ग्राहकों से जुड़ने के लिए विज्ञापित पते निर्दिष्ट करता है।

- आप डॉकर कंपोज़ में एक कस्टम नेटवर्क को कैसे परिभाषित करते हैं?

- आप इसके अंतर्गत एक नेटवर्क जोड़ सकते हैं networks कुंजी और इसे सेवाओं में शामिल करें, जैसे `networks: my_network`.

- डॉकर कंटेनरों में DNS रिज़ॉल्यूशन विफल क्यों होता है?

- कंटेनर एक दूसरे को नाम से नहीं पहचान सकते जब तक कि वे एक ही डॉकर नेटवर्क का हिस्सा न हों, जो उनके डीएनएस को लिंक करता है।

- की क्या भूमिका है .option("subscribe", "topic") स्पार्क स्ट्रीमिंग में?

- यह वास्तविक समय डेटा अंतर्ग्रहण के लिए निर्दिष्ट काफ्का विषय पर स्पार्क स्ट्रक्चर्ड स्ट्रीमिंग डेटाफ़्रेम की सदस्यता लेता है।

- पुनर्प्रयासों से काफ्का-स्पार्क एकीकरण में सुधार कैसे हो सकता है?

- कॉन्फ़िगरेशन में पुनः प्रयास करें, जैसे max.poll.records, क्षणिक त्रुटियों को संभालने में मदद करें और लगातार डेटा प्रोसेसिंग सुनिश्चित करें।

स्पार्क और काफ्का एकीकरण को सरल बनाना

डॉकर में स्पार्क और काफ्का को स्थापित करना जटिल हो सकता है, लेकिन सही कॉन्फ़िगरेशन के साथ, यह प्रबंधनीय हो जाता है। कनेक्टिविटी समस्याओं से बचने के लिए श्रोता सेटिंग्स और नेटवर्क कॉन्फ़िगरेशन पर ध्यान दें। सुनिश्चित करें कि ज़ूकीपर और काफ्का जैसे सभी घटक इष्टतम प्रदर्शन के लिए अच्छी तरह से समन्वयित हैं।

वास्तविक दुनिया के उपयोग के मामले, जैसे वित्तीय डेटा या IoT स्ट्रीम की निगरानी, मजबूत कॉन्फ़िगरेशन के महत्व पर प्रकाश डालते हैं। यहां साझा किए गए उपकरण और स्क्रिप्ट आपको सामान्य बाधाओं को दूर करने और कुशल, वास्तविक समय डेटा पाइपलाइन बनाने के ज्ञान से लैस करते हैं। 🛠️

स्रोत और सन्दर्भ

- इस लेख की जानकारी अधिकारी ने दी अपाचे स्पार्क काफ्का एकीकरण दस्तावेज़ीकरण , कॉन्फ़िगरेशन और उपयोग में विस्तृत जानकारी प्रदान करता है।

- डॉकर नेटवर्किंग की सर्वोत्तम प्रथाओं का संदर्भ दिया गया था डॉकर नेटवर्किंग दस्तावेज़ीकरण सटीक और विश्वसनीय कंटेनर संचार सेटअप सुनिश्चित करने के लिए।

- व्यावहारिक उदाहरण और अतिरिक्त काफ्का सेटिंग्स को इससे अनुकूलित किया गया था वुर्स्टमिस्टर काफ्का डॉकर गिटहब रिपॉजिटरी .