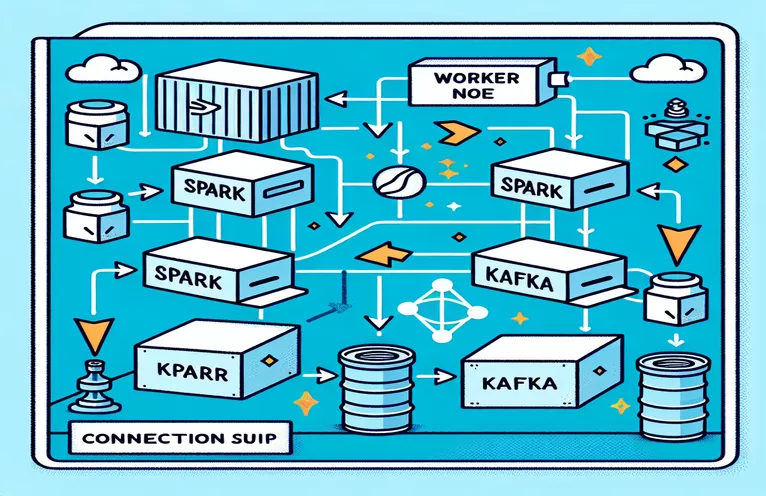

A Spark és a Kafka integrálásának kihívásai dockerizált környezetben

Találkozott-e már csatlakozási problémával, miközben integrálta a Kafka bróker a Spark Cluster egy Docker-beállításon belül? Nem vagy egyedül! Sok fejlesztő akadályokba ütközik a két hatékony eszköz közötti kommunikáció beállítása során. 🛠️

A közelmúltban elkezdtem javítani Spark Cluster egy Kafka-bróker hozzáadásával a valós idejű adatfeldolgozás egyszerűsítésére. Azonban állandó kapcsolati időtúllépésekkel és DNS-feloldási hibákkal járó akadályba ütköztem, ami a folyamatot hibaelhárítási maratonná változtatta. 😅

Ezek a problémák a Docker Compose és a Spark Kafka-val kapcsolatos konfigurációinak rosszul konfigurált beállításaiból fakadtak. Annak ellenére, hogy számos útmutatót követtem és számos paramétert módosítottam, a megfoghatatlan „lehet, hogy a bróker nem elérhető” üzenet továbbra is fennmaradt, zavarba ejtve és frusztrálva.

Ebben a cikkben megosztom tapasztalataimat, és gyakorlati lépéseket ajánlok a Spark dolgozói és a Kafka brókerek közötti kapcsolódási kihívások megoldására Docker környezetben. Útközben tippeket és trükköket tanulhat meg, amelyekkel elkerülheti ezeket a buktatókat, és biztosíthatja a zökkenőmentes integrációt. Merüljünk el! 🚀

| Parancs | Használati példa |

|---|---|

| from_json() | Ez a Spark SQL-függvény elemzi a JSON-karakterláncot, és létrehoz egy strukturált adatobjektumot. A példában a Kafka-üzenetek strukturált adatokká történő deszerializálására szolgál. |

| StructType() | Sémát határoz meg a strukturált adatfeldolgozáshoz. Különösen hasznos a Kafka-üzenetek várható formátumának meghatározásához. |

| .readStream | Adatfolyamos adatkeretet kezdeményez a Sparkban, lehetővé téve a folyamatos adatfeldolgozást a Kafkától vagy más adatfolyam-forrásokból. |

| writeStream | Meghatározza a kimeneti módot és a nyelőt a Spark Structured Streaming lekérdezéshez. Itt a konzolra való írást adja meg hozzáfűzés módban. |

| bootstrap_servers | Egy Kafka konfigurációs paraméter, amely megadja a Kafka bróker címét. Kritikus a Spark és a Kafka kommunikációhoz. |

| auto_offset_reset | Egy Kafka fogyasztói beállítás, amely meghatározza, hol kezdje el az üzenetek olvasását, ha nincs előzetes eltolás. A "legkorábbi" opció a legrégebbi üzenettől kezdődik. |

| KAFKA_ADVERTISED_LISTENERS | Egy Docker Kafka konfigurációs környezeti változó. Meghatározza a Kafka-ügyfelek hirdetett címeit, biztosítva a megfelelő kommunikációt a Docker hálózaton belül és kívül. |

| KAFKA_LISTENERS | Konfigurálja azokat a hálózati interfészeket, amelyeken a Kafka-bróker figyeli a bejövő kapcsolatokat. Itt a belső és a külső kommunikáció elkülönítésére szolgál. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Meghatározza a biztonsági protokollokat a különböző Kafka-hallgatók számára. A figyelő neveket a megfelelő protokollokhoz rendeli hozzá, például ebben az esetben a PLAINTEXT. |

| .awaitTermination() | Spark Structured Streaming metódus, amely blokkolja a szkript végrehajtását az adatfolyam-lekérdezés leállításáig, biztosítva az adatfolyam folyamatos futását. |

A Spark és a Kafka integráció megértése a Dockerben

Az első szkript arra összpontosít, hogy kapcsolatot hozzon létre a Spark Worker és a Kafka bróker. A Spark Structured Streaming API használatával a szkript valós idejű adatokat olvas be egy Kafka témakörből. A Spark-munkamenet inicializálásával és a szükséges Kafka-csomaggal történő konfigurálásával kezdődik. Ez döntő fontosságú, mivel biztosítja a szükséges függőséget a Spark számára, hogy zökkenőmentesen kommunikálhasson Kafkával. Példa erre a függőségre az "org.apache.spark:spark-sql-kafka" csomag, amely biztosítja a Spark és a Kafka kompatibilitását Docker környezetben.

A Kafka-üzenetek kezeléséhez a szkript a "StructType" használatával definiál egy sémát. Ez a séma biztosítja a bejövő üzenetek helyes elemzését és szerkezetét. A valós forgatókönyvek gyakran magukban foglalják a Kafkától származó JSON-adatok kezelését. Képzeljünk el például egy kriptovaluta-figyelő rendszert, ahol az árfrissítéseket tartalmazó üzeneteket küldik Kafkának. Az üzenetek olvasható formátumba történő elemzése megkönnyíti az adatok feldolgozását és elemzését a trend előrejelzéséhez. 🪙

A Docker Compose konfiguráció döntő szerepet játszik a csatlakozási problémák megoldásában. A "KAFKA_ADVERTISED_LISTENERS" és a "KAFKA_LISTENERS" beállítások úgy vannak beállítva, hogy megkülönböztessék a belső és a külső kommunikációt a Docker-hálózaton belül. Ez biztosítja, hogy az ugyanazon a Docker-hálózaton futó szolgáltatások, például a Spark és a Kafka, DNS-feloldási problémák nélkül működjenek együtt. Például az „INSIDE://kafka:9093” leképezés lehetővé teszi a belső tárolók számára a Kafka elérését, míg az „OUTSIDE://localhost:9093” külső alkalmazások, például megfigyelőeszközök csatlakozását teszi lehetővé.

A második szkript bemutatja, hogyan kell Python "KafkaConsumer"-t használni a Kafka-kapcsolat tesztelésére. Ez egy egyszerű, de hatékony megközelítés annak biztosítására, hogy a Kafka bróker megfelelően működjön. A megadott témakör üzeneteinek felhasználásával ellenőrizheti, hogy az adatfolyam zavartalan-e. Vegyünk egy olyan alkalmazást, ahol a felhasználó nyomon szeretné követni a tőzsdei adatokat. A kapcsolat tesztelése ezzel a fogyasztói parancsfájllal biztosítja, hogy egyetlen kritikus frissítés sem marad el konfigurációs hibák miatt. Ezekkel az eszközökkel magabiztosan telepíthet robusztus rendszereket a valós idejű adatfeldolgozáshoz! 🚀

Kapcsolódási problémák kezelése a Spark Worker és a Kafka Broker között

1. megoldás: Python használata hibakeresésre és kapcsolati problémák megoldására a Sparkban és a Kafkában a Dockerrel

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

DNS-megoldási problémák hibakeresése a Dockerized Kafkában

2. megoldás: A Docker Compose konfigurációjának módosítása a megfelelő DNS-feloldás érdekében

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

A Kafka Consumer Connection tesztelése

3. megoldás: Python Kafka Consumer a kapcsolat teszteléséhez

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

A Kafka és a Spark optimalizálása dockerizált környezetben

A közötti zökkenőmentes kommunikáció kritikus szempontja Kafka brókerek és Spark Workers a Dockerben hatékonyan konfigurálja a hálózati beállításokat. A Docker-tárolók elszigetelt környezetben működnek, gyakran DNS-feloldási problémákat okozva, amikor a szolgáltatásoknak interakcióba kell lépniük. Ennek megoldására használhatja a Docker Compose hálózati konfigurációs beállításait. Például egy egyéni hálózat, például a „saját_hálózat” meghatározása és a szolgáltatások összekapcsolása biztosítja, hogy a tárolók név szerint ismerjék fel egymást IP helyett, ami leegyszerűsíti a beállítást és elkerüli a gyakori buktatókat.

Egy másik lényeges szempont a Kafka hallgató-konfigurációinak optimalizálása. A "KAFKA_ADVERTISED_LISTENERS" és a "KAFKA_LISTENERS" megadásával a Docker Compose fájlban lehetővé teszi, hogy a Kafka megfelelő címeket hirdessen ügyfelei számára. A belső és külső figyelők közötti különbségtétel megoldja a konfliktusokat, különösen akkor, ha a Spark Workers a Docker-hálózaton kívülről próbál csatlakozni. Ennek valós példája egy megfigyelő műszerfal, amely Kafka-adatokat kérdez le egy gazdagépről, és külön külső figyelőt igényel a hozzáféréshez. 🔧

Végül a robusztus hibakezelés megvalósítása a Spark-alkalmazásokban kulcsfontosságú. Például a Kafka konfiguráción belüli újrapróbálkozások és tartalékok kihasználása kecsesen kezelheti az ideiglenes kapcsolódási problémákat. Az `.option("kafka.consumer.max.poll.records", "500")` hozzáadása hatékony adatlekérést biztosít még nagy terhelés mellett is. Képzeljen el egy éles szintű alkalmazást, amely valós időben követi a tőzsdei árakat – a hibabiztonsági rendszerek üzembe helyezése biztosítja a megszakítás nélküli adatáramlást még hálózati akadozások esetén is. Ezek a technikák együtt alkotják egy megbízható adatfeldolgozási folyamat gerincét. 🚀

Gyakori kérdések a Sparkról és a Kafkáról a Dockerben

- Mi a célja KAFKA_ADVERTISED_LISTENERS?

- Meghatározza a Kafka-ügyfelek hirdetett címeit a csatlakozáshoz, biztosítva a megfelelő kommunikációt a Docker hálózaton belül és kívül.

- Hogyan definiálhat egyéni hálózatot a Docker Compose alkalmazásban?

- alatt adhat hozzá hálózatot networks kulcsot, és foglalja bele a szolgáltatásokba, például `networks: my_network`.

- Miért nem sikerül a DNS-feloldás a Docker-tárolókban?

- Előfordulhat, hogy a tárolók nem ismerik fel egymást név szerint, hacsak nem ugyanannak a Docker-hálózatnak a részei, amely összekapcsolja a DNS-üket.

- Mi a szerepe .option("subscribe", "topic") a Spark Streamingben?

- Előfizet a Spark Structured Streaming DataFrame-re a megadott Kafka-témához a valós idejű adatfeldolgozás érdekében.

- Hogyan javíthatják az újrapróbálkozások a Kafka-Spark integrációt?

- Újrapróbálkozik olyan konfigurációkban, mint pl max.poll.records, segít az átmeneti hibák kezelésében és biztosítja a következetes adatfeldolgozást.

A Spark és a Kafka integráció egyszerűsítése

A Spark és a Kafka beállítása a Dockerben bonyolult lehet, de a megfelelő konfigurációkkal kezelhetővé válik. A kapcsolódási problémák elkerülése érdekében összpontosítson a figyelő beállításaira és a hálózati konfigurációkra. Győződjön meg arról, hogy minden összetevő, például a Zookeeper és a Kafka jól szinkronizálva van az optimális teljesítmény érdekében.

A valós használati esetek, például a pénzügyi adatok vagy az IoT-folyamok figyelése rávilágít a robusztus konfigurációk fontosságára. Az itt megosztott eszközök és szkriptek felvértezik Önt a gyakori akadályok leküzdéséhez és hatékony, valós idejű adatfolyamok létrehozásához szükséges ismeretekkel. 🛠️

Források és hivatkozások

- Ezt a cikket az illetékes tájékoztatta Apache Spark Kafka integrációs dokumentáció , amely részletes betekintést nyújt a konfigurációba és a használatba.

- A Docker hálózati bevált gyakorlataira hivatkoztak a Docker hálózati dokumentáció pontos és megbízható konténerkommunikációs beállítások biztosítása érdekében.

- Gyakorlati példákat és további Kafka-beállításokat adaptáltak a Wurstmeister Kafka Docker GitHub Repository .