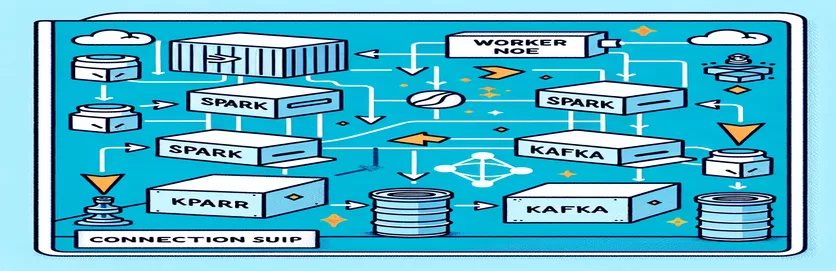

Tantangan Mengintegrasikan Spark dan Kafka dalam Lingkungan Docker

Pernahkah Anda menghadapi masalah konektivitas saat mengintegrasikan a Pialang Kafka menjadi a Kluster Percikan dalam pengaturan Docker? Anda tidak sendirian! Banyak pengembang menghadapi kendala saat menyiapkan komunikasi antara kedua alat canggih ini. 🛠️

Baru-baru ini, saya mulai meningkatkan kemampuan saya Kluster Percikan dengan menambahkan broker Kafka untuk menyederhanakan pemrosesan data waktu nyata. Namun, saya menemui hambatan dengan waktu tunggu koneksi yang terus-menerus habis dan kesalahan resolusi DNS, sehingga membuat prosesnya menjadi maraton pemecahan masalah. 😅

Masalah ini berasal dari pengaturan yang salah dikonfigurasi di Docker Compose dan konfigurasi terkait Kafka Spark. Meskipun mengikuti beberapa panduan dan mengubah banyak parameter, pesan "broker mungkin tidak tersedia" yang sulit dipahami tetap ada, membuat saya bingung dan frustrasi.

Dalam artikel ini, saya akan berbagi pengalaman dan menawarkan langkah-langkah praktis untuk mengatasi tantangan konektivitas antara pekerja Spark dan broker Kafka di lingkungan Docker. Sepanjang prosesnya, Anda akan mempelajari tips dan trik untuk menghindari kendala ini dan memastikan integrasi yang lancar. Mari selami! 🚀

| Memerintah | Contoh Penggunaan |

|---|---|

| from_json() | Fungsi Spark SQL ini mem-parsing string JSON dan membuat objek data terstruktur. Dalam contoh ini, ini digunakan untuk melakukan deserialisasi pesan Kafka menjadi data terstruktur. |

| StructType() | Mendefinisikan skema untuk pemrosesan data terstruktur. Hal ini sangat berguna untuk menentukan format pesan Kafka yang diharapkan. |

| .readStream | Memulai DataFrame streaming di Spark, memungkinkan penyerapan data berkelanjutan dari Kafka atau sumber streaming lainnya. |

| writeStream | Menentukan mode output dan sink untuk kueri Spark Structured Streaming. Di sini, ini menentukan penulisan ke konsol dalam mode penambahan. |

| bootstrap_servers | Parameter konfigurasi Kafka yang menentukan alamat broker Kafka. Penting untuk komunikasi Spark dan Kafka. |

| auto_offset_reset | Pengaturan konsumen Kafka yang menentukan di mana harus mulai membaca pesan ketika tidak ada offset sebelumnya. Opsi "paling awal" dimulai dari pesan terlama. |

| KAFKA_ADVERTISED_LISTENERS | Variabel lingkungan konfigurasi Docker Kafka. Ini menentukan alamat yang diiklankan untuk klien Kafka, memastikan komunikasi yang baik di dalam dan di luar jaringan Docker. |

| KAFKA_LISTENERS | Mengonfigurasi antarmuka jaringan tempat broker Kafka mendengarkan koneksi masuk. Digunakan di sini untuk memisahkan komunikasi internal dan eksternal. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Mendefinisikan protokol keamanan untuk pendengar Kafka yang berbeda. Ini memetakan nama pendengar ke protokolnya masing-masing, seperti PLAINTEXT dalam kasus ini. |

| .awaitTermination() | Metode Spark Structured Streaming yang memblokir eksekusi skrip hingga kueri streaming dihentikan, memastikan aliran berjalan terus-menerus. |

Memahami Integrasi Spark dan Kafka di Docker

Skrip pertama berfokus pada membangun hubungan antara a Pekerja Percikan dan sebuah Pialang Kafka. Dengan menggunakan API Streaming Terstruktur Spark, skrip membaca data real-time dari topik Kafka. Ini dimulai dengan menginisialisasi sesi Spark dan mengonfigurasinya dengan paket Kafka yang diperlukan. Hal ini penting karena memberikan ketergantungan yang diperlukan Spark untuk berkomunikasi dengan Kafka secara lancar. Contoh ketergantungan ini adalah paket `org.apache.spark:spark-sql-kafka`, yang memastikan kompatibilitas antara Spark dan Kafka di lingkungan Docker.

Untuk menangani pesan Kafka, skrip mendefinisikan skema menggunakan `StructType`. Skema ini memastikan bahwa pesan masuk diurai dan disusun dengan benar. Skenario dunia nyata sering kali melibatkan penanganan data JSON dari Kafka. Misalnya, bayangkan sistem pemantauan mata uang kripto yang mengirim pesan berisi pembaruan harga ke Kafka. Mengurai pesan-pesan ini ke dalam format yang mudah dibaca akan mempermudah pemrosesan dan analisis data untuk prediksi tren. 🪙

Konfigurasi Docker Compose memainkan peran penting dalam menyelesaikan masalah konektivitas. Pengaturan `KAFKA_ADVERTISED_LISTENERS` dan `KAFKA_LISTENERS` disesuaikan untuk membedakan komunikasi internal dan eksternal dalam jaringan Docker. Hal ini memastikan bahwa layanan yang berjalan di jaringan Docker yang sama, seperti Spark dan Kafka, dapat berinteraksi tanpa masalah resolusi DNS. Misalnya, pemetaan `INSIDE://kafka:9093` memungkinkan kontainer internal mengakses Kafka, sementara `OUTSIDE://localhost:9093` memungkinkan aplikasi eksternal seperti alat pemantauan untuk terhubung.

Skrip kedua menunjukkan cara menggunakan `KafkaConsumer` Python untuk menguji koneksi Kafka. Ini adalah pendekatan sederhana namun efektif untuk memastikan broker Kafka berfungsi dengan benar. Dengan menggunakan pesan dari topik tertentu, Anda dapat memverifikasi apakah aliran data tidak terganggu. Pertimbangkan sebuah aplikasi di mana pengguna ingin melacak data pasar saham. Menguji koneksi menggunakan skrip konsumen ini memastikan tidak ada pembaruan penting yang terlewat karena kesalahan konfigurasi. Dengan alat-alat ini, Anda dapat dengan percaya diri menerapkan sistem yang kuat untuk pemrosesan data waktu nyata! 🚀

Menangani Masalah Konektivitas Antara Spark Worker dan Kafka Broker

Solusi 1: Menggunakan Python untuk men-debug dan menyelesaikan masalah koneksi di Spark dan Kafka dengan Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Men-debug Masalah Resolusi DNS di Dockerized Kafka

Solusi 2: Memodifikasi konfigurasi Docker Compose untuk resolusi DNS yang tepat

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Menguji Koneksi Konsumen Kafka

Solusi 3: Konsumen Python Kafka untuk menguji koneksi

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Mengoptimalkan Kafka dan Spark di Lingkungan Docker

Aspek penting untuk memastikan kelancaran komunikasi antar Pialang Kafka Dan Percikan Pekerja di Docker sedang mengonfigurasi pengaturan jaringan secara efektif. Kontainer Docker beroperasi di lingkungan yang terisolasi, sering kali menyebabkan masalah resolusi DNS saat layanan perlu berinteraksi. Untuk mengatasinya, Anda dapat memanfaatkan opsi konfigurasi jaringan Docker Compose. Misalnya, mendefinisikan jaringan khusus seperti `my_network` dan menghubungkan layanan memastikan bahwa container mengenali satu sama lain berdasarkan nama, bukan IP, sehingga menyederhanakan penyiapan dan menghindari kesalahan umum.

Pertimbangan penting lainnya adalah mengoptimalkan konfigurasi pendengar Kafka. Dengan menentukan `KAFKA_ADVERTISED_LISTENERS` dan `KAFKA_LISTENERS` di file Docker Compose, Anda mengizinkan Kafka untuk mengiklankan alamat yang sesuai kepada kliennya. Perbedaan antara pendengar internal dan eksternal ini menyelesaikan konflik, terutama ketika Spark Worker mencoba terhubung dari luar jaringan Docker. Contoh nyata dari hal ini adalah dasbor pemantauan yang menanyakan data Kafka dari mesin host, yang memerlukan pendengar eksternal yang berbeda untuk mengaksesnya. 🔧

Terakhir, menerapkan penanganan kesalahan yang kuat dalam aplikasi Spark Anda sangatlah penting. Misalnya, memanfaatkan percobaan ulang dan fallback dalam konfigurasi Kafka dapat menangani masalah konektivitas sementara dengan baik. Menambahkan `.option("kafka.consumer.max.poll.records", "500")` memastikan pengambilan data yang efisien, bahkan di bawah beban berat. Bayangkan sebuah aplikasi tingkat produksi yang melacak harga saham secara real-time—memiliki brankas untuk memastikan aliran data tidak terganggu bahkan selama gangguan jaringan. Teknik-teknik ini bersama-sama membentuk tulang punggung jalur pemrosesan data yang andal. 🚀

Pertanyaan Umum Tentang Spark dan Kafka di Docker

- Apa tujuannya KAFKA_ADVERTISED_LISTENERS?

- Ini menentukan alamat yang diiklankan untuk dihubungkan oleh klien Kafka, memastikan komunikasi yang tepat di dalam dan di luar jaringan Docker.

- Bagaimana Anda mendefinisikan jaringan khusus di Docker Compose?

- Anda dapat menambahkan jaringan di bawah networks kunci dan sertakan dalam layanan, seperti `networks: my_network`.

- Mengapa resolusi DNS gagal di kontainer Docker?

- Kontainer tidak boleh mengenali nama satu sama lain kecuali mereka merupakan bagian dari jaringan Docker yang sama, yang menghubungkan DNS mereka.

- Apa perannya .option("subscribe", "topic") di Spark Streaming?

- Ini berlangganan Spark Structured Streaming DataFrame ke topik Kafka yang ditentukan untuk penyerapan data real-time.

- Bagaimana percobaan ulang dapat meningkatkan integrasi Kafka-Spark?

- Percobaan ulang dalam konfigurasi, seperti max.poll.records, membantu menangani kesalahan sementara dan memastikan pemrosesan data yang konsisten.

Menyederhanakan Integrasi Spark dan Kafka

Menyiapkan Spark dan Kafka di Docker bisa jadi rumit, tetapi dengan konfigurasi yang tepat, hal ini dapat dikelola. Fokus pada pengaturan pendengar dan konfigurasi jaringan untuk menghindari masalah konektivitas. Pastikan semua komponen seperti Zookeeper dan Kafka tersinkronisasi dengan baik untuk kinerja optimal.

Kasus penggunaan di dunia nyata, seperti pemantauan data keuangan atau aliran IoT, menyoroti pentingnya konfigurasi yang kuat. Alat dan skrip yang dibagikan di sini membekali Anda dengan pengetahuan untuk mengatasi rintangan umum dan membangun saluran data real-time yang efisien. 🛠️

Sumber dan Referensi

- Artikel ini diinformasikan oleh pejabat tersebut Dokumentasi Integrasi Apache Spark Kafka , memberikan wawasan mendetail tentang konfigurasi dan penggunaan.

- Praktik terbaik jaringan Docker direferensikan dari Dokumentasi Jaringan Docker untuk memastikan pengaturan komunikasi kontainer yang akurat dan andal.

- Contoh praktis dan pengaturan tambahan Kafka diadaptasi dari Repositori GitHub Wurstmeister Kafka Docker .