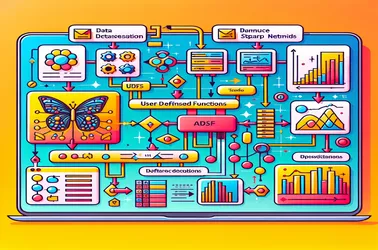

Quando si utilizzano UDF all'interno di Apache Spark per operazioni distribuite come l'elaborazione di modelli di deep learning, è comune riscontrare il problema "SparkContext può essere utilizzato solo sul driver" di Spark. Ciò si verifica a causa della natura rigorosa legata ai driver di SparkContext, che controlla la distribuzione del lavoro. Prevenendo i conflitti di serializzazione nelle pipeline di elaborazione delle immagini distribuite e garantendo l'accesso al modello senza reinizializzazione su ciascun nodo, soluzioni come le variabili broadcast ci consentono di condividere modelli con i nodi di lavoro in un modo efficiente. La capacità di Spark di gestire complesse attività di machine learning su larga scala è notevolmente migliorata dagli approcci broadcast.

Daniel Marino

25 novembre 2024

Risolvere i problemi di SparkContext con l'uso delle UDF da parte di Apache Spark per l'estrazione delle caratteristiche delle immagini