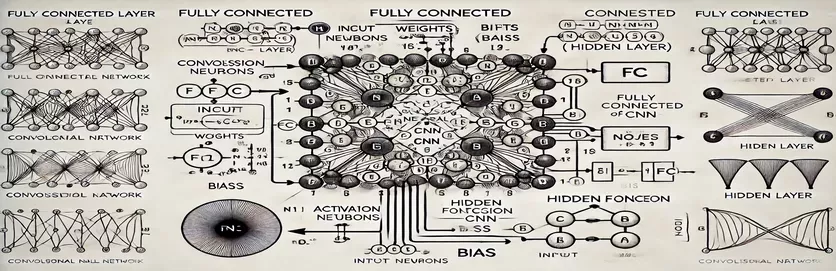

CNN の完全に接続された層を解明する

畳み込みニューラル ネットワーク (CNN) の完全接続 (FC) 層の仕組みを理解することは、謎を解くように感じるかもしれません。多くの人にとって、複雑さは計算プロセスと、隠れ層の 1 つのノードがどのように導出されるかにあります。従来の人工ニューラル ネットワーク (ANN) とは異なり、CNN の FC 層にはニュアンスがあり、チュートリアルでは説明されないことがよくあります。このことに困惑しているのは、あなただけではありません。

多くのリソースがこのトピックについてざっと説明しているため、学習者は明確なガイダンスを得ることができません。チュートリアルでは不完全な説明が再利用されることが多く、明確さを求めるユーザーのフラストレーションを増大させます。繰り返し答えを探していることに気付いた場合、あなたは正しい場所にいます。 🧩

このガイドでは、FC 層の隠れ層から単一ノードを計算することに焦点を当てます。 1 つのノードのメカニズムを理解したら、残りのノードに取り組む準備が整います。このプロセスを明確で実行可能なステップに分割することで、自信を持って FC 層の計算を進めることができるようになります。

関連性のある例とわかりやすい図を使用して、FC 層の入力から出力までの経路を明らかにします。混乱に別れを告げ、理解にこんにちは。さあ、飛び込みましょう! 🚀

| 指示 | 使用例 |

|---|---|

| np.dot() | 2 つの配列間のドット積を実行します。ここでは、完全接続層内のノードの入力と重みの加重合計を計算するために使用されます。 |

| np.maximum() | 計算された出力とゼロの間の最大値を選択することにより、ReLU 活性化関数を適用します。 |

| torch.tensor() | PyTorch でテンソルを作成します。テンソルは、深層学習フレームワークにおけるデータ表現の基本的な構成要素です。 |

| torch.matmul() | PyTorch で行列の乗算を実行します。入力と重みの間のドット積を計算するために使用されます。 |

| torch.nn.functional.relu() | PyTorch で ReLU 活性化関数を適用し、テンソルのすべての負の値をゼロに設定します。 |

| np.testing.assert_array_almost_equal() | 2 つの配列を要素ごとに比較し、一定の許容範囲内で等しいかどうかを確認します。数値演算における出力の正確性をテストするのに役立ちます。 |

| unittest.TestCase | テスト ケースを作成するための、unittest モジュールの基本クラス。 Python で単体テストを構造化および編成するために使用されます。 |

| np.array() | NumPyで配列を作成します。配列は、全結合層の計算における入力、重み、およびバイアスを表すために使用されます。 |

| torch.matmul() | PyTorch の行列乗算関数。ニューラル ネットワークの出力計算に不可欠です。 |

| unittest.main() | スクリプトで定義されたすべてのテスト ケースを実行します。実装されたソリューションの精度と信頼性を検証するために不可欠です。 |

完全に接続された層の計算の内訳

提供されているスクリプトは、ノードがどのように機能するかをわかりやすくすることを目的としています。 完全接続 (FC) CNN の層は、前の層からのデータを処理します。これらのレイヤーは、重み付けされたリンクとバイアスを使用してすべての入力をすべてのノードに接続するため、画像分類などのタスクに不可欠なものになります。最初のスクリプトは、次を使用して単一ノードの出力を計算します。 ナムピー。入力値に対応する重みを乗算し、バイアスを加算することで、ノード出力が得られます。この出力は、非線形性を導入するためにアクティベーション関数 (ReLU など) に渡されます。たとえば、画像のピクセル値が入力であると想像してください。重みは、画像から意味のある特徴を抽出する学習されたフィルターを表す場合があります。 🖼️

2 番目のスクリプトは、複数のノードの計算を一般化します。これは行列乗算を使用し、重みは 2D 行列として表され、入力はベクトルとして表されます。この効率的なアプローチにより、層内のすべてのノードの同時計算が可能になります。バイアスを追加し、ReLU 活性化関数を適用することにより、層の最終出力が生成されます。この方法は拡張性が高く、最新の深層学習フレームワークの中核となる操作です。たとえば、顔認識システムでは、このプロセスは、検出された形状が人間の顔に似ているかどうかを判断するのに役立ちます。 😊

次のような深層学習ライブラリを扱う人向け パイトーチ3 番目のスクリプトは、テンソルと組み込み関数を使用して同じ計算を実現する方法を示しています。 PyTorch の柔軟性と組み込みの最適化機能により、ニューラル ネットワークの構築とトレーニングに最適です。このスクリプトは、入力、重み、バイアスをテンソルとして定義し、 トーチ.matmul() 関数。これは、野生動物の写真から動物を識別するなど、大規模なデータセットで CNN をトレーニングするためのエンドツーエンドのパイプラインを作成する場合に特に役立ちます。

最後に、単体テスト スクリプトは、すべての実装がさまざまな条件下で正しく動作することを確認します。を使用して、 単体テスト ライブラリを使用して、計算の数値精度を検証し、出力が期待される結果を満たしていることを確認します。このステップは、特に医療画像分析などの実世界のアプリケーションに CNN を導入する場合、デバッグと信頼性の確保にとって重要です。これらのスクリプトと説明により、自信を持って CNN の FC 層を理解して実装するための明確な道筋が得られます。 🚀

完全接続層のノードの計算について

行列計算に NumPy を活用した Python ベースのソリューション

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

完全接続層でのノード計算の一般化

隠れ層内のすべてのノードを計算するための Python ベースのソリューション

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

完全接続層でのノード計算に PyTorch を使用する

深層学習愛好家のための PyTorch による実装

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

単体テストで各ソリューションをテストする

実装の正確性を確認するための Python ベースの単体テスト

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

CNN における完全に接続された層の重要性を解明する

完全接続 (FC) 層は、畳み込み層から抽出された特徴を最終的な予測に変換する際に重要な役割を果たします。これらは、すべての入力をすべての出力に接続することによって機能し、学習された特徴の密なマッピングを提供します。空間階層に焦点を当てた畳み込み層とは異なり、FC 層はこの情報を集約して、画像内のオブジェクトの識別などの意思決定を行います。たとえば、自動運転車の画像認識システムでは、FC レイヤーが、検出された物体が歩行者であるか道路標識であるかを判断する場合があります。 🚗

FC レイヤーを際立たせる 1 つの側面は、トレーニング中に学習したパターンを一般化する機能です。このプロパティは、目に見えないデータを扱う場合に非常に重要です。層内の各ノードは重みとバイアスの一意の組み合わせを表し、特定のパターンまたはクラスの認識に特化できるようにします。 FC レイヤーの構造がモデル全体の精度を決定することが多いのはこのためです。たとえば、手書き数字認識モデルでは、FC レイヤーはピクセル パターンを数値予測 (0 ~ 9) に統合します。 ✍️

FC 層は接続が密であるため計算コストが高くなりますが、詳細な分類が必要なタスクには依然として重要です。ドロップアウトなどの最新の技術を使用して、オーバーフィッティングを防止してパフォーマンスを最適化します。ドロップアウトは、トレーニング中にアクティブなノードの数を減らすことにより、FC 層が堅牢な特徴を学習することを保証し、顔認識や医療画像診断などのアプリケーションに不可欠なものとなります。

完全に接続されたレイヤーに関するよくある質問

- CNN の全結合層の主な機能は何ですか?

- FC レイヤーはすべての入力を出力に接続し、最終的な予測のために特徴を集約します。これは、機能マップを実用的な結果に変換するための鍵となります。

- FC 層で重みとバイアスはどのように初期化されるのでしょうか?

- 重みはランダムに初期化されるか、Xavier 初期化などの手法を使用して初期化されることがよくありますが、バイアスは通常、簡単にするためにゼロから始まります。

- ReLU をアクティブ化すると FC 層のパフォーマンスがどのように向上しますか?

- ReLU は、負の出力をゼロに設定することで非線形性を適用します。勾配の消失を防ぎ、モデルの収束を高速化します。

- ドロップアウトは FC 層に適用できますか?

- はい、ドロップアウトはトレーニング中にノードをランダムに無効にし、モデルの一般化を強化し、過剰適合を減らします。

- FC 層と畳み込み層の違いは何ですか?

- 畳み込み層は空間特徴を抽出しますが、FC 層はこれらの特徴を分類用の高密度フォーマットに集約します。

完全に接続されたレイヤーに関する重要なポイント

完全接続層は、学習した特徴を実用的な予測に統合し、ニューラル ネットワークの最終的な意思決定ステップとして機能します。各ノードの計算方法を理解することで、ユーザーはオブジェクトの検出や分類などのタスクのための CNN アーキテクチャの設計と最適化に自信を得ることができます。

自動運転車の画像認識や顔識別などの実践例は、FC レイヤーの重要性を示しています。適切なアプローチを使用して最適化手法を組み込むことで、目に見えないデータにうまく適応する堅牢で正確なモデルが保証されます。この概念を習得すると、人工知能をより深く探求できるようになります。 😊

出典と参考文献

- CNN の全結合層に関する詳細な説明 (出典:) 機械学習の習得 。

- から取得したアクティベーション関数とそのアプリケーションの包括的なガイド 分析ヴィディヤ 。

- ニューラル ネットワークのドロップアウトおよび最適化技術に関する洞察は、次の場所にあります。 DeepAI 。

- ニューラル ネットワークの重みとバイアスを理解する データサイエンスに向けて 。

- ソース元の PyTorch での ReLU アクティベーション関数の使用 PyTorch ドキュメント 。