CNN ಗಳಲ್ಲಿ ಸಂಪೂರ್ಣವಾಗಿ ಸಂಪರ್ಕಗೊಂಡಿರುವ ಲೇಯರ್ಗಳನ್ನು ಡಿಮಿಸ್ಟಿಫೈ ಮಾಡುವುದು

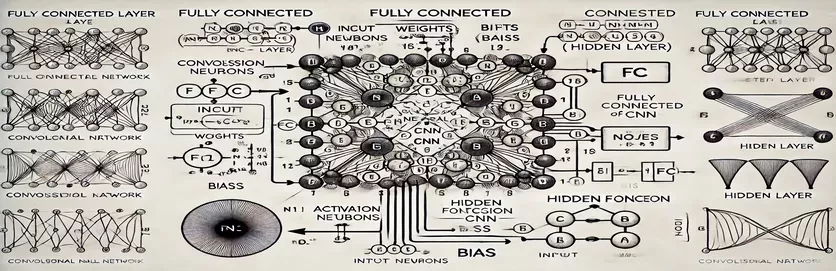

ಕಾನ್ವಲ್ಯೂಷನಲ್ ನ್ಯೂರಲ್ ನೆಟ್ವರ್ಕ್ನಲ್ಲಿ (ಸಿಎನ್ಎನ್) ಸಂಪೂರ್ಣ ಸಂಪರ್ಕಿತ (ಎಫ್ಸಿ) ಪದರದ ಕಾರ್ಯನಿರ್ವಹಣೆಯನ್ನು ಅರ್ಥಮಾಡಿಕೊಳ್ಳುವುದು ರಹಸ್ಯವನ್ನು ಬಿಚ್ಚಿದಂತೆ ಭಾಸವಾಗುತ್ತದೆ. ಅನೇಕರಿಗೆ, ಸಂಕೀರ್ಣತೆಯು ಲೆಕ್ಕಾಚಾರದ ಪ್ರಕ್ರಿಯೆಯಲ್ಲಿದೆ ಮತ್ತು ಗುಪ್ತ ಪದರದಲ್ಲಿ ಒಂದು ನೋಡ್ ಅನ್ನು ಹೇಗೆ ಪಡೆಯಲಾಗುತ್ತದೆ. ಸಾಂಪ್ರದಾಯಿಕ ಆರ್ಟಿಫಿಶಿಯಲ್ ನ್ಯೂರಲ್ ನೆಟ್ವರ್ಕ್ಗಳಿಗಿಂತ (ಎಎನ್ಎನ್ಗಳು) ಭಿನ್ನವಾಗಿ, ಸಿಎನ್ಎನ್ಗಳಲ್ಲಿನ ಎಫ್ಸಿ ಲೇಯರ್ ಸೂಕ್ಷ್ಮ ವ್ಯತ್ಯಾಸಗಳನ್ನು ಹೊಂದಿದೆ, ಅದು ಸಾಮಾನ್ಯವಾಗಿ ಟ್ಯುಟೋರಿಯಲ್ಗಳಲ್ಲಿ ವಿವರಿಸಲಾಗುವುದಿಲ್ಲ. ನೀವು ಈ ಬಗ್ಗೆ ಗೊಂದಲಕ್ಕೊಳಗಾಗಿದ್ದರೆ, ನೀವು ಒಬ್ಬಂಟಿಯಾಗಿಲ್ಲ!

ಅನೇಕ ಸಂಪನ್ಮೂಲಗಳು ಈ ವಿಷಯದ ಮೇಲೆ ಸ್ಕಿಮ್ ಆಗುತ್ತವೆ, ಕಲಿಯುವವರಿಗೆ ಸ್ಪಷ್ಟ ಮಾರ್ಗದರ್ಶನವಿಲ್ಲದೆ ಬಿಡುತ್ತವೆ. ಟ್ಯುಟೋರಿಯಲ್ಗಳು ಸಾಮಾನ್ಯವಾಗಿ ಅಪೂರ್ಣ ವಿವರಣೆಗಳನ್ನು ಮರುಬಳಕೆ ಮಾಡುತ್ತವೆ, ಇದು ಸ್ಪಷ್ಟತೆಯನ್ನು ಬಯಸುವವರ ಹತಾಶೆಯನ್ನು ಹೆಚ್ಚಿಸುತ್ತದೆ. ಉತ್ತರಗಳಿಗಾಗಿ ಪದೇ ಪದೇ ಹುಡುಕುತ್ತಿರುವುದನ್ನು ನೀವು ಕಂಡುಕೊಂಡರೆ, ನೀವು ಸರಿಯಾದ ಸ್ಥಳದಲ್ಲಿದ್ದೀರಿ. 🧩

ಈ ಮಾರ್ಗದರ್ಶಿಯಲ್ಲಿ, FC ಲೇಯರ್ನ ಗುಪ್ತ ಲೇಯರ್ನಿಂದ ಒಂದೇ ನೋಡ್ ಅನ್ನು ಲೆಕ್ಕಾಚಾರ ಮಾಡಲು ನಾವು ಗಮನಹರಿಸುತ್ತೇವೆ. ಒಮ್ಮೆ ನೀವು ಒಂದು ನೋಡ್ಗಾಗಿ ಕಾರ್ಯವಿಧಾನವನ್ನು ಗ್ರಹಿಸಿದರೆ, ಉಳಿದದ್ದನ್ನು ನಿಭಾಯಿಸಲು ನೀವು ಸಜ್ಜುಗೊಳ್ಳುತ್ತೀರಿ. ಈ ಪ್ರಕ್ರಿಯೆಯನ್ನು ಸ್ಪಷ್ಟ, ಕ್ರಿಯಾಶೀಲ ಹಂತಗಳಾಗಿ ಒಡೆಯುವ ಮೂಲಕ, ಯಾವುದೇ FC ಲೇಯರ್ ಲೆಕ್ಕಾಚಾರವನ್ನು ನ್ಯಾವಿಗೇಟ್ ಮಾಡುವ ವಿಶ್ವಾಸವನ್ನು ನೀವು ಪಡೆಯುತ್ತೀರಿ.

ಸಂಬಂಧಿಸಬಹುದಾದ ಉದಾಹರಣೆಗಳು ಮತ್ತು ನೇರವಾದ ರೇಖಾಚಿತ್ರವನ್ನು ಬಳಸಿಕೊಂಡು, ನಾವು FC ಲೇಯರ್ನಲ್ಲಿ ಇನ್ಪುಟ್ಗಳಿಂದ ಔಟ್ಪುಟ್ಗಳಿಗೆ ಮಾರ್ಗವನ್ನು ಬೆಳಗಿಸುತ್ತೇವೆ. ಗೊಂದಲಕ್ಕೆ ವಿದಾಯ ಹೇಳಿ ಮತ್ತು ತಿಳುವಳಿಕೆಗೆ ನಮಸ್ಕಾರ - ನಾವು ಧುಮುಕೋಣ! 🚀

| ಆಜ್ಞೆ | ಬಳಕೆಯ ಉದಾಹರಣೆ |

|---|---|

| np.dot() | ಎರಡು ಅರೇಗಳ ನಡುವೆ ಡಾಟ್ ಉತ್ಪನ್ನವನ್ನು ನಿರ್ವಹಿಸುತ್ತದೆ. ಸಂಪೂರ್ಣ ಸಂಪರ್ಕಿತ ಲೇಯರ್ನಲ್ಲಿ ನೋಡ್ಗಾಗಿ ಇನ್ಪುಟ್ಗಳು ಮತ್ತು ತೂಕಗಳ ತೂಕದ ಮೊತ್ತವನ್ನು ಲೆಕ್ಕಾಚಾರ ಮಾಡಲು ಇಲ್ಲಿ ಬಳಸಲಾಗುತ್ತದೆ. |

| np.maximum() | ಲೆಕ್ಕಹಾಕಿದ ಔಟ್ಪುಟ್ ಮತ್ತು ಶೂನ್ಯದ ನಡುವಿನ ಗರಿಷ್ಠ ಮೌಲ್ಯವನ್ನು ಆಯ್ಕೆ ಮಾಡುವ ಮೂಲಕ ReLU ಸಕ್ರಿಯಗೊಳಿಸುವ ಕಾರ್ಯವನ್ನು ಅನ್ವಯಿಸುತ್ತದೆ. |

| torch.tensor() | PyTorch ನಲ್ಲಿ ಟೆನ್ಸರ್ ಅನ್ನು ರಚಿಸುತ್ತದೆ. ಆಳವಾದ ಕಲಿಕೆಯ ಚೌಕಟ್ಟುಗಳಲ್ಲಿ ಡೇಟಾ ಪ್ರಾತಿನಿಧ್ಯಕ್ಕಾಗಿ ಟೆನ್ಸರ್ಗಳು ಮೂಲ ಬಿಲ್ಡಿಂಗ್ ಬ್ಲಾಕ್ಗಳಾಗಿವೆ. |

| torch.matmul() | PyTorch ನಲ್ಲಿ ಮ್ಯಾಟ್ರಿಕ್ಸ್ ಗುಣಾಕಾರವನ್ನು ನಿರ್ವಹಿಸುತ್ತದೆ. ಒಳಹರಿವು ಮತ್ತು ತೂಕಗಳ ನಡುವಿನ ಡಾಟ್ ಉತ್ಪನ್ನವನ್ನು ಲೆಕ್ಕಾಚಾರ ಮಾಡಲು ಬಳಸಲಾಗುತ್ತದೆ. |

| torch.nn.functional.relu() | PyTorch ನಲ್ಲಿ ReLU ಸಕ್ರಿಯಗೊಳಿಸುವ ಕಾರ್ಯವನ್ನು ಅನ್ವಯಿಸುತ್ತದೆ, ಟೆನ್ಸರ್ನಲ್ಲಿನ ಎಲ್ಲಾ ನಕಾರಾತ್ಮಕ ಮೌಲ್ಯಗಳನ್ನು ಶೂನ್ಯಕ್ಕೆ ಹೊಂದಿಸುತ್ತದೆ. |

| np.testing.assert_array_almost_equal() | ಒಂದು ನಿರ್ದಿಷ್ಟ ಸಹಿಷ್ಣುತೆಯೊಳಗೆ ಸಮಾನತೆಗಾಗಿ ಎರಡು ಸರಣಿಗಳನ್ನು ಅಂಶ-ವಾರು ಹೋಲಿಕೆ ಮಾಡುತ್ತದೆ. ಸಂಖ್ಯಾತ್ಮಕ ಕಾರ್ಯಾಚರಣೆಗಳಲ್ಲಿ ಔಟ್ಪುಟ್ ನಿಖರತೆಯನ್ನು ಪರೀಕ್ಷಿಸಲು ಉಪಯುಕ್ತವಾಗಿದೆ. |

| unittest.TestCase | ಪರೀಕ್ಷಾ ಪ್ರಕರಣಗಳನ್ನು ರಚಿಸಲು ಯುನಿಟೆಸ್ಟ್ ಮಾಡ್ಯೂಲ್ನಲ್ಲಿ ಮೂಲ ವರ್ಗ. ಪೈಥಾನ್ನಲ್ಲಿ ಘಟಕ ಪರೀಕ್ಷೆಗಳನ್ನು ರಚಿಸಲು ಮತ್ತು ಸಂಘಟಿಸಲು ಬಳಸಲಾಗುತ್ತದೆ. |

| np.array() | NumPy ನಲ್ಲಿ ಒಂದು ಶ್ರೇಣಿಯನ್ನು ರಚಿಸುತ್ತದೆ. ಸಂಪೂರ್ಣ ಸಂಪರ್ಕಿತ ಲೇಯರ್ ಲೆಕ್ಕಾಚಾರದಲ್ಲಿ ಒಳಹರಿವು, ತೂಕ ಮತ್ತು ಪಕ್ಷಪಾತಗಳನ್ನು ಪ್ರತಿನಿಧಿಸಲು ಅರೇಗಳನ್ನು ಬಳಸಲಾಗುತ್ತದೆ. |

| torch.matmul() | ಮ್ಯಾಟ್ರಿಕ್ಸ್ ಗುಣಾಕಾರಕ್ಕಾಗಿ PyTorch ನ ಕಾರ್ಯ, ನರಗಳ ಜಾಲಗಳಲ್ಲಿ ಔಟ್ಪುಟ್ಗಳನ್ನು ಲೆಕ್ಕಾಚಾರ ಮಾಡಲು ನಿರ್ಣಾಯಕವಾಗಿದೆ. |

| unittest.main() | ಸ್ಕ್ರಿಪ್ಟ್ನಲ್ಲಿ ವ್ಯಾಖ್ಯಾನಿಸಲಾದ ಎಲ್ಲಾ ಪರೀಕ್ಷಾ ಪ್ರಕರಣಗಳನ್ನು ರನ್ ಮಾಡುತ್ತದೆ. ಅಳವಡಿಸಲಾದ ಪರಿಹಾರಗಳ ನಿಖರತೆ ಮತ್ತು ವಿಶ್ವಾಸಾರ್ಹತೆಯನ್ನು ಮೌಲ್ಯೀಕರಿಸಲು ಅತ್ಯಗತ್ಯ. |

ಸಂಪೂರ್ಣ ಸಂಪರ್ಕಿತ ಲೇಯರ್ ಲೆಕ್ಕಾಚಾರಗಳನ್ನು ಒಡೆಯುವುದು

ಒದಗಿಸಿದ ಸ್ಕ್ರಿಪ್ಟ್ಗಳು a ನಲ್ಲಿ ನೋಡ್ ಹೇಗೆ ಎಂಬುದನ್ನು ಡಿಮಿಸ್ಟಿಫೈ ಮಾಡುವ ಗುರಿಯನ್ನು ಹೊಂದಿದೆ CNN ನ ಪದರವು ಹಿಂದಿನ ಲೇಯರ್ನಿಂದ ಡೇಟಾವನ್ನು ಪ್ರಕ್ರಿಯೆಗೊಳಿಸುತ್ತದೆ. ಈ ಲೇಯರ್ಗಳು ಪ್ರತಿ ನೋಡ್ಗೆ ತೂಕದ ಲಿಂಕ್ಗಳು ಮತ್ತು ಪಕ್ಷಪಾತಗಳನ್ನು ಬಳಸಿಕೊಂಡು ಪ್ರತಿ ಇನ್ಪುಟ್ ಅನ್ನು ಸಂಪರ್ಕಿಸುತ್ತದೆ, ಇದು ಇಮೇಜ್ ವರ್ಗೀಕರಣದಂತಹ ಕಾರ್ಯಗಳಿಗೆ ಅವಶ್ಯಕವಾಗಿದೆ. ಮೊದಲ ಸ್ಕ್ರಿಪ್ಟ್ ಬಳಸಿ ಒಂದೇ ನೋಡ್ಗಾಗಿ ಔಟ್ಪುಟ್ ಅನ್ನು ಲೆಕ್ಕಾಚಾರ ಮಾಡುತ್ತದೆ . ಇನ್ಪುಟ್ ಮೌಲ್ಯಗಳನ್ನು ಅವುಗಳ ಅನುಗುಣವಾದ ತೂಕದೊಂದಿಗೆ ಗುಣಿಸಿ ಮತ್ತು ಪಕ್ಷಪಾತವನ್ನು ಸೇರಿಸುವ ಮೂಲಕ, ನೋಡ್ ಔಟ್ಪುಟ್ ಅನ್ನು ಪಡೆಯಲಾಗುತ್ತದೆ. ರೇಖಾತ್ಮಕವಲ್ಲದತೆಯನ್ನು ಪರಿಚಯಿಸಲು ಈ ಔಟ್ಪುಟ್ ಅನ್ನು ಸಕ್ರಿಯಗೊಳಿಸುವ ಕ್ರಿಯೆಯ ಮೂಲಕ ರವಾನಿಸಲಾಗುತ್ತದೆ (ಉದಾ., ReLU). ಉದಾಹರಣೆಗೆ, ಚಿತ್ರದ ಪಿಕ್ಸೆಲ್ ಮೌಲ್ಯಗಳನ್ನು ಇನ್ಪುಟ್ಗಳಾಗಿ ಕಲ್ಪಿಸಿಕೊಳ್ಳಿ; ತೂಕವು ಚಿತ್ರದಿಂದ ಅರ್ಥಪೂರ್ಣ ವೈಶಿಷ್ಟ್ಯಗಳನ್ನು ಹೊರತೆಗೆಯುವ ಕಲಿತ ಫಿಲ್ಟರ್ಗಳನ್ನು ಪ್ರತಿನಿಧಿಸಬಹುದು. 🖼️

ಎರಡನೇ ಸ್ಕ್ರಿಪ್ಟ್ ಬಹು ನೋಡ್ಗಳಿಗೆ ಲೆಕ್ಕಾಚಾರವನ್ನು ಸಾಮಾನ್ಯಗೊಳಿಸುತ್ತದೆ. ಇದು ಮ್ಯಾಟ್ರಿಕ್ಸ್ ಗುಣಾಕಾರವನ್ನು ಬಳಸುತ್ತದೆ, ಅಲ್ಲಿ ತೂಕವನ್ನು 2D ಮ್ಯಾಟ್ರಿಕ್ಸ್ ಮತ್ತು ಇನ್ಪುಟ್ಗಳನ್ನು ವೆಕ್ಟರ್ನಂತೆ ಪ್ರತಿನಿಧಿಸಲಾಗುತ್ತದೆ. ಈ ಸಮರ್ಥ ವಿಧಾನವು ಲೇಯರ್ನಲ್ಲಿರುವ ಎಲ್ಲಾ ನೋಡ್ಗಳಿಗೆ ಏಕಕಾಲಿಕ ಲೆಕ್ಕಾಚಾರವನ್ನು ಅನುಮತಿಸುತ್ತದೆ. ಪಕ್ಷಪಾತಗಳನ್ನು ಸೇರಿಸುವ ಮೂಲಕ ಮತ್ತು ReLU ಸಕ್ರಿಯಗೊಳಿಸುವ ಕಾರ್ಯವನ್ನು ಅನ್ವಯಿಸುವ ಮೂಲಕ, ಲೇಯರ್ನ ಅಂತಿಮ ಔಟ್ಪುಟ್ಗಳನ್ನು ಉತ್ಪಾದಿಸಲಾಗುತ್ತದೆ. ಈ ವಿಧಾನವು ಹೆಚ್ಚು ಸ್ಕೇಲೆಬಲ್ ಆಗಿದೆ ಮತ್ತು ಆಧುನಿಕ ಆಳವಾದ ಕಲಿಕೆಯ ಚೌಕಟ್ಟುಗಳಲ್ಲಿ ಒಂದು ಪ್ರಮುಖ ಕಾರ್ಯಾಚರಣೆಯಾಗಿದೆ. ಉದಾಹರಣೆಗೆ, ಮುಖ ಗುರುತಿಸುವಿಕೆ ವ್ಯವಸ್ಥೆಯಲ್ಲಿ, ಪತ್ತೆಯಾದ ಆಕಾರವು ಮಾನವ ಮುಖವನ್ನು ಹೋಲುತ್ತದೆಯೇ ಎಂದು ನಿರ್ಧರಿಸಲು ಈ ಪ್ರಕ್ರಿಯೆಯು ಸಹಾಯ ಮಾಡುತ್ತದೆ. 😊

ಆಳವಾದ ಕಲಿಕೆಯ ಗ್ರಂಥಾಲಯಗಳೊಂದಿಗೆ ಕೆಲಸ ಮಾಡುವವರಿಗೆ , ಮೂರನೇ ಸ್ಕ್ರಿಪ್ಟ್ ಅದೇ ಲೆಕ್ಕಾಚಾರಗಳನ್ನು ಸಾಧಿಸಲು ಟೆನ್ಸರ್ಗಳು ಮತ್ತು ಅಂತರ್ನಿರ್ಮಿತ ಕಾರ್ಯಗಳನ್ನು ಹೇಗೆ ಬಳಸುವುದು ಎಂಬುದನ್ನು ತೋರಿಸುತ್ತದೆ. PyTorch ನ ನಮ್ಯತೆ ಮತ್ತು ಅಂತರ್ನಿರ್ಮಿತ ಆಪ್ಟಿಮೈಸೇಶನ್ಗಳು ನರ ನೆಟ್ವರ್ಕ್ಗಳನ್ನು ನಿರ್ಮಿಸಲು ಮತ್ತು ತರಬೇತಿ ನೀಡಲು ಸೂಕ್ತವಾಗಿಸುತ್ತದೆ. ಇನ್ಪುಟ್ಗಳು, ತೂಕಗಳು ಮತ್ತು ಪಕ್ಷಪಾತಗಳನ್ನು ಟೆನ್ಸರ್ಗಳಾಗಿ ಹೇಗೆ ವ್ಯಾಖ್ಯಾನಿಸುವುದು ಮತ್ತು ಮ್ಯಾಟ್ರಿಕ್ಸ್ ಗುಣಾಕಾರವನ್ನು ಹೇಗೆ ನಿರ್ವಹಿಸುವುದು ಎಂಬುದನ್ನು ಸ್ಕ್ರಿಪ್ಟ್ ತೋರಿಸುತ್ತದೆ ಕಾರ್ಯ. ವನ್ಯಜೀವಿ ಛಾಯಾಚಿತ್ರಗಳಲ್ಲಿ ಪ್ರಾಣಿಗಳನ್ನು ಗುರುತಿಸುವಂತಹ ದೊಡ್ಡ ಡೇಟಾಸೆಟ್ಗಳಲ್ಲಿ ಸಿಎನ್ಎನ್ಗಳಿಗೆ ತರಬೇತಿ ನೀಡಲು ಎಂಡ್-ಟು-ಎಂಡ್ ಪೈಪ್ಲೈನ್ಗಳನ್ನು ರಚಿಸಲು ಇದು ವಿಶೇಷವಾಗಿ ಉಪಯುಕ್ತವಾಗಿದೆ.

ಅಂತಿಮವಾಗಿ, ಯುನಿಟ್ ಟೆಸ್ಟ್ ಸ್ಕ್ರಿಪ್ಟ್ ಎಲ್ಲಾ ಅಳವಡಿಕೆಗಳು ವಿವಿಧ ಪರಿಸ್ಥಿತಿಗಳಲ್ಲಿ ಸರಿಯಾಗಿ ಕಾರ್ಯನಿರ್ವಹಿಸುತ್ತದೆ ಎಂದು ಖಚಿತಪಡಿಸುತ್ತದೆ. ಅನ್ನು ಬಳಸುವುದು ಲೈಬ್ರರಿ, ಇದು ಲೆಕ್ಕಾಚಾರಗಳ ಸಂಖ್ಯಾತ್ಮಕ ನಿಖರತೆಯನ್ನು ಪರಿಶೀಲಿಸುತ್ತದೆ ಮತ್ತು ಔಟ್ಪುಟ್ಗಳು ನಿರೀಕ್ಷಿತ ಫಲಿತಾಂಶಗಳನ್ನು ಪೂರೈಸುತ್ತದೆ ಎಂದು ಖಚಿತಪಡಿಸುತ್ತದೆ. ಡೀಬಗ್ ಮಾಡಲು ಮತ್ತು ವಿಶ್ವಾಸಾರ್ಹತೆಯನ್ನು ಖಚಿತಪಡಿಸಿಕೊಳ್ಳಲು ಈ ಹಂತವು ನಿರ್ಣಾಯಕವಾಗಿದೆ, ವಿಶೇಷವಾಗಿ ವೈದ್ಯಕೀಯ ಚಿತ್ರ ವಿಶ್ಲೇಷಣೆಯಂತಹ ನೈಜ-ಪ್ರಪಂಚದ ಅಪ್ಲಿಕೇಶನ್ಗಳಲ್ಲಿ CNN ಗಳನ್ನು ನಿಯೋಜಿಸುವಾಗ. ಈ ಸ್ಕ್ರಿಪ್ಟ್ಗಳು ಮತ್ತು ವಿವರಣೆಗಳೊಂದಿಗೆ, CNN ಗಳಲ್ಲಿ FC ಲೇಯರ್ಗಳನ್ನು ವಿಶ್ವಾಸದಿಂದ ಅರ್ಥಮಾಡಿಕೊಳ್ಳಲು ಮತ್ತು ಕಾರ್ಯಗತಗೊಳಿಸಲು ನೀವು ಈಗ ಸ್ಪಷ್ಟವಾದ ಮಾರ್ಗವನ್ನು ಹೊಂದಿದ್ದೀರಿ. 🚀

ಸಂಪೂರ್ಣ ಸಂಪರ್ಕಿತ ಲೇಯರ್ನಲ್ಲಿ ನೋಡ್ನ ಲೆಕ್ಕಾಚಾರವನ್ನು ಅರ್ಥಮಾಡಿಕೊಳ್ಳುವುದು

ಮ್ಯಾಟ್ರಿಕ್ಸ್ ಲೆಕ್ಕಾಚಾರಗಳಿಗಾಗಿ NumPy ಅನ್ನು ನಿಯಂತ್ರಿಸುವ ಪೈಥಾನ್-ಆಧಾರಿತ ಪರಿಹಾರ

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

ಸಂಪೂರ್ಣ ಸಂಪರ್ಕಿತ ಲೇಯರ್ಗಳಲ್ಲಿ ನೋಡ್ ಲೆಕ್ಕಾಚಾರವನ್ನು ಸಾಮಾನ್ಯೀಕರಿಸುವುದು

ಗುಪ್ತ ಪದರದಲ್ಲಿ ಎಲ್ಲಾ ನೋಡ್ಗಳನ್ನು ಲೆಕ್ಕಾಚಾರ ಮಾಡಲು ಪೈಥಾನ್ ಆಧಾರಿತ ಪರಿಹಾರ

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

ಸಂಪೂರ್ಣವಾಗಿ ಸಂಪರ್ಕಗೊಂಡಿರುವ ಲೇಯರ್ನಲ್ಲಿ ನೋಡ್ ಲೆಕ್ಕಾಚಾರಕ್ಕಾಗಿ PyTorch ಅನ್ನು ಬಳಸುವುದು

ಆಳವಾದ ಕಲಿಕೆಯ ಉತ್ಸಾಹಿಗಳಿಗೆ PyTorch ನೊಂದಿಗೆ ಅನುಷ್ಠಾನ

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

ಘಟಕ ಪರೀಕ್ಷೆಗಳೊಂದಿಗೆ ಪ್ರತಿ ಪರಿಹಾರವನ್ನು ಪರೀಕ್ಷಿಸಿ

ಅಳವಡಿಕೆಗಳ ನಿಖರತೆಯನ್ನು ಖಚಿತಪಡಿಸಿಕೊಳ್ಳಲು ಪೈಥಾನ್ ಆಧಾರಿತ ಘಟಕ ಪರೀಕ್ಷೆಗಳು

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

CNN ಗಳಲ್ಲಿ ಸಂಪೂರ್ಣವಾಗಿ ಸಂಪರ್ಕಗೊಂಡಿರುವ ಲೇಯರ್ಗಳ ಪ್ರಾಮುಖ್ಯತೆಯನ್ನು ಬಿಚ್ಚಿಡುವುದು

ಸಂಪೂರ್ಣ ಸಂಪರ್ಕಿತ (ಎಫ್ಸಿ) ಲೇಯರ್ಗಳು ಕನ್ವಲ್ಯೂಷನಲ್ ಲೇಯರ್ಗಳಿಂದ ಹೊರತೆಗೆಯಲಾದ ವೈಶಿಷ್ಟ್ಯಗಳನ್ನು ಅಂತಿಮ ಮುನ್ಸೂಚನೆಗಳಾಗಿ ಪರಿವರ್ತಿಸುವಲ್ಲಿ ಪ್ರಮುಖ ಪಾತ್ರವನ್ನು ವಹಿಸುತ್ತವೆ. ಅವರು ಪ್ರತಿ ಇನ್ಪುಟ್ ಅನ್ನು ಪ್ರತಿ ಔಟ್ಪುಟ್ಗೆ ಸಂಪರ್ಕಿಸುವ ಮೂಲಕ ಕೆಲಸ ಮಾಡುತ್ತಾರೆ, ಕಲಿತ ವೈಶಿಷ್ಟ್ಯಗಳ ದಟ್ಟವಾದ ಮ್ಯಾಪಿಂಗ್ ಅನ್ನು ಒದಗಿಸುತ್ತಾರೆ. ಪ್ರಾದೇಶಿಕ ಶ್ರೇಣಿಗಳ ಮೇಲೆ ಕೇಂದ್ರೀಕರಿಸುವ ಕನ್ವಲ್ಯೂಷನಲ್ ಲೇಯರ್ಗಳಿಗಿಂತ ಭಿನ್ನವಾಗಿ, FC ಲೇಯರ್ಗಳು ಚಿತ್ರದಲ್ಲಿನ ವಸ್ತುಗಳನ್ನು ಗುರುತಿಸುವಂತಹ ನಿರ್ಧಾರಗಳನ್ನು ಮಾಡಲು ಈ ಮಾಹಿತಿಯನ್ನು ಒಟ್ಟುಗೂಡಿಸುತ್ತದೆ. ಉದಾಹರಣೆಗೆ, ಸ್ವಯಂ-ಚಾಲನಾ ಕಾರಿನ ಇಮೇಜ್ ಗುರುತಿಸುವಿಕೆ ವ್ಯವಸ್ಥೆಯಲ್ಲಿ, ಪತ್ತೆಯಾದ ವಸ್ತುವು ಪಾದಚಾರಿ ಅಥವಾ ರಸ್ತೆ ಚಿಹ್ನೆಯೇ ಎಂಬುದನ್ನು FC ಲೇಯರ್ ನಿರ್ಧರಿಸಬಹುದು. 🚗

ಎಫ್ಸಿ ಲೇಯರ್ಗಳನ್ನು ಪ್ರತ್ಯೇಕಿಸುವ ಒಂದು ಅಂಶವೆಂದರೆ ತರಬೇತಿಯ ಸಮಯದಲ್ಲಿ ಕಲಿತ ಮಾದರಿಗಳನ್ನು ಸಾಮಾನ್ಯೀಕರಿಸುವ ಸಾಮರ್ಥ್ಯ. ಕಾಣದ ಡೇಟಾದೊಂದಿಗೆ ವ್ಯವಹರಿಸುವಾಗ ಈ ಆಸ್ತಿಯು ನಿರ್ಣಾಯಕವಾಗಿದೆ. ಪದರದಲ್ಲಿನ ಪ್ರತಿಯೊಂದು ನೋಡ್ ತೂಕ ಮತ್ತು ಪಕ್ಷಪಾತಗಳ ವಿಶಿಷ್ಟ ಸಂಯೋಜನೆಯನ್ನು ಪ್ರತಿನಿಧಿಸುತ್ತದೆ, ಇದು ನಿರ್ದಿಷ್ಟ ಮಾದರಿಗಳು ಅಥವಾ ವರ್ಗಗಳನ್ನು ಗುರುತಿಸುವಲ್ಲಿ ಪರಿಣತಿಯನ್ನು ಪಡೆಯಲು ಅನುವು ಮಾಡಿಕೊಡುತ್ತದೆ. ಇದಕ್ಕಾಗಿಯೇ FC ಪದರಗಳ ರಚನೆಯು ಸಾಮಾನ್ಯವಾಗಿ ಒಟ್ಟಾರೆ ಮಾದರಿಯ ನಿಖರತೆಯನ್ನು ನಿರ್ಧರಿಸುತ್ತದೆ. ಉದಾಹರಣೆಗೆ, ಕೈಬರಹದ ಅಂಕಿ ಗುರುತಿಸುವಿಕೆ ಮಾದರಿಯಲ್ಲಿ, FC ಪದರವು ಪಿಕ್ಸೆಲ್ ಮಾದರಿಗಳನ್ನು ಸಂಖ್ಯಾತ್ಮಕ ಮುನ್ನೋಟಗಳಾಗಿ (0-9) ಏಕೀಕರಿಸುತ್ತದೆ. ✍️

ಎಫ್ಸಿ ಲೇಯರ್ಗಳು ಅವುಗಳ ದಟ್ಟವಾದ ಸಂಪರ್ಕಗಳಿಂದಾಗಿ ಕಂಪ್ಯೂಟೇಶನಲ್ ಆಗಿ ದುಬಾರಿಯಾಗಿದ್ದರೂ, ವಿವರವಾದ ವರ್ಗೀಕರಣದ ಅಗತ್ಯವಿರುವ ಕಾರ್ಯಗಳಿಗೆ ಅವು ಪ್ರಮುಖವಾಗಿರುತ್ತವೆ. ಡ್ರಾಪ್ಔಟ್ನಂತಹ ಆಧುನಿಕ ತಂತ್ರಗಳನ್ನು ಓವರ್ಫಿಟ್ ಮಾಡುವುದನ್ನು ತಡೆಯುವ ಮೂಲಕ ಅವರ ಕಾರ್ಯಕ್ಷಮತೆಯನ್ನು ಅತ್ಯುತ್ತಮವಾಗಿಸಲು ಬಳಸಲಾಗುತ್ತದೆ. ತರಬೇತಿಯ ಸಮಯದಲ್ಲಿ ಸಕ್ರಿಯ ನೋಡ್ಗಳ ಸಂಖ್ಯೆಯನ್ನು ಕಡಿಮೆ ಮಾಡುವ ಮೂಲಕ, ಡ್ರಾಪ್ಔಟ್ ಎಫ್ಸಿ ಲೇಯರ್ ದೃಢವಾದ ವೈಶಿಷ್ಟ್ಯಗಳನ್ನು ಕಲಿಯುತ್ತದೆ ಎಂದು ಖಚಿತಪಡಿಸುತ್ತದೆ, ಮುಖ ಗುರುತಿಸುವಿಕೆ ಮತ್ತು ವೈದ್ಯಕೀಯ ಚಿತ್ರಣ ರೋಗನಿರ್ಣಯದಂತಹ ಅಪ್ಲಿಕೇಶನ್ಗಳಲ್ಲಿ ಇದು ಅನಿವಾರ್ಯವಾಗುತ್ತದೆ.

- CNN ಗಳಲ್ಲಿ ಸಂಪೂರ್ಣವಾಗಿ ಸಂಪರ್ಕಗೊಂಡಿರುವ ಲೇಯರ್ನ ಮುಖ್ಯ ಕಾರ್ಯವೇನು?

- FC ಲೇಯರ್ ಎಲ್ಲಾ ಇನ್ಪುಟ್ಗಳನ್ನು ಔಟ್ಪುಟ್ಗಳಿಗೆ ಸಂಪರ್ಕಿಸುತ್ತದೆ, ಅಂತಿಮ ಮುನ್ಸೂಚನೆಗಳಿಗಾಗಿ ವೈಶಿಷ್ಟ್ಯಗಳನ್ನು ಒಟ್ಟುಗೂಡಿಸುತ್ತದೆ. ವೈಶಿಷ್ಟ್ಯದ ನಕ್ಷೆಗಳನ್ನು ಕ್ರಿಯಾಶೀಲ ಫಲಿತಾಂಶಗಳಾಗಿ ಪರಿವರ್ತಿಸಲು ಇದು ಪ್ರಮುಖವಾಗಿದೆ.

- ಎಫ್ಸಿ ಲೇಯರ್ಗಳಲ್ಲಿ ತೂಕ ಮತ್ತು ಪಕ್ಷಪಾತಗಳನ್ನು ಹೇಗೆ ಪ್ರಾರಂಭಿಸಲಾಗುತ್ತದೆ?

- ತೂಕವನ್ನು ಸಾಮಾನ್ಯವಾಗಿ ಯಾದೃಚ್ಛಿಕವಾಗಿ ಪ್ರಾರಂಭಿಸಲಾಗುತ್ತದೆ ಅಥವಾ ಕ್ಸೇವಿಯರ್ ಇನಿಶಿಯಲೈಸೇಶನ್ನಂತಹ ತಂತ್ರಗಳನ್ನು ಬಳಸುತ್ತಾರೆ, ಆದರೆ ಪಕ್ಷಪಾತಗಳು ಸಾಮಾನ್ಯವಾಗಿ ಸರಳತೆಗಾಗಿ ಶೂನ್ಯದಿಂದ ಪ್ರಾರಂಭವಾಗುತ್ತವೆ.

- ReLU ಸಕ್ರಿಯಗೊಳಿಸುವಿಕೆಯು FC ಲೇಯರ್ ಕಾರ್ಯಕ್ಷಮತೆಯನ್ನು ಹೇಗೆ ಸುಧಾರಿಸುತ್ತದೆ?

- ಋಣಾತ್ಮಕ ಔಟ್ಪುಟ್ಗಳನ್ನು ಶೂನ್ಯಕ್ಕೆ ಹೊಂದಿಸುವ ಮೂಲಕ ReLU ರೇಖಾತ್ಮಕವಲ್ಲದತೆಯನ್ನು ಅನ್ವಯಿಸುತ್ತದೆ. ಇದು ಕಣ್ಮರೆಯಾಗುತ್ತಿರುವ ಗ್ರೇಡಿಯಂಟ್ಗಳನ್ನು ತಡೆಯುತ್ತದೆ, ಮಾದರಿಯು ವೇಗವಾಗಿ ಒಮ್ಮುಖವಾಗುವಂತೆ ಮಾಡುತ್ತದೆ.

- FC ಲೇಯರ್ಗಳಿಗೆ ಡ್ರಾಪ್ಔಟ್ ಅನ್ನು ಅನ್ವಯಿಸಬಹುದೇ?

- ಹೌದು, ಡ್ರಾಪ್ಔಟ್ ತರಬೇತಿಯ ಸಮಯದಲ್ಲಿ ನೋಡ್ಗಳನ್ನು ಯಾದೃಚ್ಛಿಕವಾಗಿ ನಿಷ್ಕ್ರಿಯಗೊಳಿಸುತ್ತದೆ, ಮಾದರಿ ಸಾಮಾನ್ಯೀಕರಣವನ್ನು ಹೆಚ್ಚಿಸುತ್ತದೆ ಮತ್ತು ಓವರ್ಫಿಟ್ಟಿಂಗ್ ಅನ್ನು ಕಡಿಮೆ ಮಾಡುತ್ತದೆ.

- ಎಫ್ಸಿ ಲೇಯರ್ಗಳು ಕನ್ವಲ್ಯೂಷನಲ್ ಲೇಯರ್ಗಳಿಗಿಂತ ಭಿನ್ನವಾಗಿರುವುದು ಯಾವುದು?

- ಕನ್ವಲ್ಯೂಷನಲ್ ಲೇಯರ್ಗಳು ಪ್ರಾದೇಶಿಕ ವೈಶಿಷ್ಟ್ಯಗಳನ್ನು ಹೊರತೆಗೆಯುವಾಗ, ಎಫ್ಸಿ ಲೇಯರ್ಗಳು ಈ ವೈಶಿಷ್ಟ್ಯಗಳನ್ನು ವರ್ಗೀಕರಣಕ್ಕಾಗಿ ದಟ್ಟವಾದ ಸ್ವರೂಪಕ್ಕೆ ಒಟ್ಟುಗೂಡಿಸುತ್ತದೆ.

ಸಂಪೂರ್ಣವಾಗಿ ಸಂಪರ್ಕಗೊಂಡಿರುವ ಪದರವು ಕಲಿತ ವೈಶಿಷ್ಟ್ಯಗಳನ್ನು ಕ್ರಿಯಾಶೀಲ ಮುನ್ನೋಟಗಳಾಗಿ ಏಕೀಕರಿಸುತ್ತದೆ, ಇದು ನರಗಳ ಜಾಲಗಳಲ್ಲಿ ಅಂತಿಮ ನಿರ್ಧಾರ ತೆಗೆದುಕೊಳ್ಳುವ ಹಂತವಾಗಿ ಕಾರ್ಯನಿರ್ವಹಿಸುತ್ತದೆ. ಪ್ರತಿ ನೋಡ್ ಅನ್ನು ಹೇಗೆ ಲೆಕ್ಕ ಹಾಕಲಾಗುತ್ತದೆ ಎಂಬುದನ್ನು ಅರ್ಥಮಾಡಿಕೊಳ್ಳುವ ಮೂಲಕ, ಆಬ್ಜೆಕ್ಟ್ ಡಿಟೆಕ್ಷನ್ ಮತ್ತು ವರ್ಗೀಕರಣದಂತಹ ಕಾರ್ಯಗಳಿಗಾಗಿ CNN ಆರ್ಕಿಟೆಕ್ಚರ್ಗಳನ್ನು ವಿನ್ಯಾಸಗೊಳಿಸಲು ಮತ್ತು ಅತ್ಯುತ್ತಮವಾಗಿಸಲು ಬಳಕೆದಾರರು ವಿಶ್ವಾಸವನ್ನು ಗಳಿಸುತ್ತಾರೆ.

ಸ್ವಾಯತ್ತ ವಾಹನಗಳಲ್ಲಿ ಇಮೇಜ್ ಗುರುತಿಸುವಿಕೆ ಅಥವಾ ಮುಖದ ಗುರುತಿಸುವಿಕೆಯಂತಹ ಪ್ರಾಯೋಗಿಕ ಉದಾಹರಣೆಗಳು FC ಲೇಯರ್ಗಳ ಮಹತ್ವವನ್ನು ಪ್ರದರ್ಶಿಸುತ್ತವೆ. ಸರಿಯಾದ ವಿಧಾನದೊಂದಿಗೆ, ಆಪ್ಟಿಮೈಸೇಶನ್ ವಿಧಾನಗಳನ್ನು ಅಳವಡಿಸಿಕೊಳ್ಳುವುದು ದೃಢವಾದ ಮತ್ತು ನಿಖರವಾದ ಮಾದರಿಗಳನ್ನು ಖಾತ್ರಿಗೊಳಿಸುತ್ತದೆ ಅದು ಕಾಣದ ಡೇಟಾಗೆ ಉತ್ತಮವಾಗಿ ಹೊಂದಿಕೊಳ್ಳುತ್ತದೆ. ಈ ಪರಿಕಲ್ಪನೆಯ ಪಾಂಡಿತ್ಯವು ಕೃತಕ ಬುದ್ಧಿಮತ್ತೆಗೆ ಆಳವಾದ ಪರಿಶೋಧನೆಯನ್ನು ಅನ್ಲಾಕ್ ಮಾಡುತ್ತದೆ. 😊

- CNN ಗಳಲ್ಲಿ ಸಂಪೂರ್ಣವಾಗಿ ಸಂಪರ್ಕಗೊಂಡಿರುವ ಲೇಯರ್ಗಳ ಕುರಿತು ವಿವರವಾದ ವಿವರಣೆಯನ್ನು ಮೂಲದಿಂದ ಪಡೆಯಲಾಗಿದೆ ಯಂತ್ರ ಕಲಿಕೆಯ ಪಾಂಡಿತ್ಯ .

- ಸಕ್ರಿಯಗೊಳಿಸುವ ಕಾರ್ಯಗಳು ಮತ್ತು ಅವುಗಳ ಅಪ್ಲಿಕೇಶನ್ಗಳಿಗೆ ಸಮಗ್ರ ಮಾರ್ಗದರ್ಶಿಯನ್ನು ಹಿಂಪಡೆಯಲಾಗಿದೆ ಅನಾಲಿಟಿಕ್ಸ್ ವಿಧ್ಯಾ .

- ನಲ್ಲಿ ಕಂಡುಬರುವ ನರಗಳ ನೆಟ್ವರ್ಕ್ಗಳಿಗಾಗಿ ಡ್ರಾಪ್ಔಟ್ ಮತ್ತು ಆಪ್ಟಿಮೈಸೇಶನ್ ತಂತ್ರಗಳ ಒಳನೋಟಗಳು ದೀಪಎಐ .

- ನರ ನೆಟ್ವರ್ಕ್ಗಳಲ್ಲಿ ತೂಕ ಮತ್ತು ಪಕ್ಷಪಾತಗಳನ್ನು ಅರ್ಥಮಾಡಿಕೊಳ್ಳುವುದು ಡೇಟಾ ಸೈನ್ಸ್ ಕಡೆಗೆ .

- PyTorch ನಲ್ಲಿ ReLU ಸಕ್ರಿಯಗೊಳಿಸುವ ಕಾರ್ಯಗಳ ಬಳಕೆಯನ್ನು ಮೂಲದಿಂದ ಪಡೆಯಲಾಗಿದೆ PyTorch ಡಾಕ್ಯುಮೆಂಟೇಶನ್ .