CNN의 완전 연결 레이어 이해하기

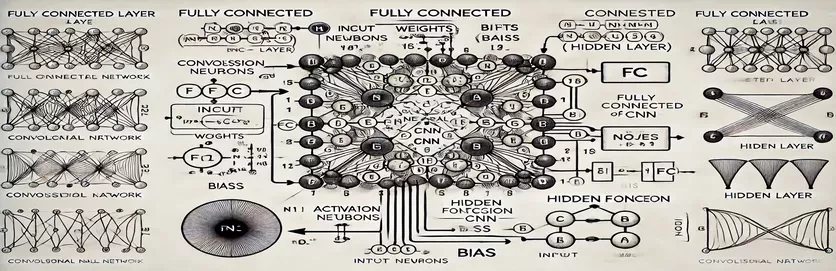

CNN(Convolutional Neural Network)에서 FC(Fully Connected) 계층의 작동을 이해하는 것은 미스터리를 푸는 것처럼 느껴질 수 있습니다. 많은 경우 계산 프로세스와 숨겨진 레이어의 노드 하나가 파생되는 방식에 복잡성이 있습니다. 기존 인공 신경망(ANN)과 달리 CNN의 FC 계층에는 튜토리얼에서 설명할 수 없는 미묘한 차이가 있습니다. 이것에 대해 의아해하신다면, 당신은 혼자가 아닙니다!

많은 리소스에서 이 주제를 훑어보므로 학습자에게 명확한 지침이 제공되지 않습니다. 튜토리얼에서는 종종 불완전한 설명을 재활용하여 명확성을 추구하는 사람들의 좌절감을 가중시킵니다. 반복적으로 답을 찾고 계시다면, 잘 찾아오셨습니다. 🧩

이 가이드에서는 FC 레이어의 숨겨진 레이어에서 단일 노드를 계산하는 데 중점을 둘 것입니다. 한 노드의 메커니즘을 파악하고 나면 나머지 노드를 처리할 수 있는 준비를 갖추게 됩니다. 이 프로세스를 명확하고 실행 가능한 단계로 나누면 FC 레이어 계산을 탐색하는 데 자신감을 얻을 수 있습니다.

관련 예제와 간단한 다이어그램을 사용하여 FC 계층의 입력에서 출력까지의 경로를 조명합니다. 혼란에 작별을 고하고 이해에 인사를 전하세요. 지금 바로 시작해 보세요! 🚀

| 명령 | 사용예 |

|---|---|

| np.dot() | 두 배열 사이의 내적을 수행합니다. 여기서는 완전 연결 계층의 노드에 대한 입력 및 가중치의 가중치 합을 계산하는 데 사용됩니다. |

| np.maximum() | 계산된 출력과 0 사이의 최대값을 선택하여 ReLU 활성화 함수를 적용합니다. |

| torch.tensor() | PyTorch에서 텐서를 생성합니다. Tensor는 딥러닝 프레임워크에서 데이터 표현을 위한 기본 구성 요소입니다. |

| torch.matmul() | PyTorch에서 행렬 곱셈을 수행합니다. 입력과 가중치 사이의 내적을 계산하는 데 사용됩니다. |

| torch.nn.functional.relu() | PyTorch에서 ReLU 활성화 함수를 적용하여 텐서의 모든 음수 값을 0으로 설정합니다. |

| np.testing.assert_array_almost_equal() | 특정 허용오차 내에서 두 배열이 요소별로 동일한지 비교합니다. 수치 연산에서 출력 정확성을 테스트하는 데 유용합니다. |

| unittest.TestCase | 테스트 사례 생성을 위한 단위 테스트 모듈의 기본 클래스입니다. Python에서 단위 테스트를 구성하고 구성하는 데 사용됩니다. |

| np.array() | NumPy에서 배열을 만듭니다. 배열은 완전 연결 계층 계산에서 입력, 가중치 및 편향을 나타내는 데 사용됩니다. |

| torch.matmul() | 신경망에서 출력을 계산하는 데 중요한 행렬 곱셈을 위한 PyTorch의 기능입니다. |

| unittest.main() | 스크립트에 정의된 모든 테스트 케이스를 실행합니다. 구현된 솔루션의 정확성과 신뢰성을 검증하는 데 필수적입니다. |

완전 연결 계층 계산 분석

제공된 스크립트는 노드가 어떻게 작동하는지 이해하는 것을 목표로 합니다. 완전히 연결됨(FC) CNN의 계층은 이전 계층의 데이터를 처리합니다. 이러한 레이어는 가중치 링크와 편향을 사용하여 모든 입력을 모든 노드에 연결하므로 이미지 분류와 같은 작업에 필수적입니다. 첫 번째 스크립트는 다음을 사용하여 단일 노드에 대한 출력을 계산합니다. 넘파이. 입력 값에 해당 가중치를 곱하고 편향을 추가하여 노드 출력을 얻습니다. 그런 다음 이 출력은 활성화 함수(예: ReLU)를 통해 전달되어 비선형성을 도입합니다. 예를 들어, 이미지의 픽셀 값을 입력으로 상상해 보세요. 가중치는 이미지에서 의미 있는 특징을 추출하는 학습된 필터를 나타낼 수 있습니다. 🖼️

두 번째 스크립트는 여러 노드에 대한 계산을 일반화합니다. 가중치는 2D 행렬로 표시되고 입력은 벡터로 표시되는 행렬 곱셈을 사용합니다. 이 효율적인 접근 방식을 사용하면 레이어의 모든 노드에 대한 동시 계산이 가능합니다. 편향을 추가하고 ReLU 활성화 함수를 적용하면 레이어의 최종 출력이 생성됩니다. 이 방법은 확장성이 뛰어나며 현대 딥러닝 프레임워크의 핵심 작업입니다. 예를 들어 얼굴 인식 시스템에서 이 프로세스는 감지된 모양이 사람의 얼굴과 유사한지 여부를 결정하는 데 도움이 될 수 있습니다. 😊

다음과 같은 딥러닝 라이브러리를 사용하는 사람들을 위해 파이토치, 세 번째 스크립트는 텐서 및 내장 함수를 사용하여 동일한 계산을 수행하는 방법을 보여줍니다. PyTorch의 유연성과 내장된 최적화 기능은 신경망 구축 및 훈련에 이상적입니다. 이 스크립트는 입력, 가중치 및 편향을 텐서로 정의하고 다음을 사용하여 행렬 곱셈을 수행하는 방법을 보여줍니다. torch.matmul() 기능. 이는 야생 동물 사진에서 동물을 식별하는 등 대규모 데이터세트에서 CNN을 훈련하기 위한 엔드투엔드 파이프라인을 만드는 데 특히 유용합니다.

마지막으로 단위 테스트 스크립트는 모든 구현이 다양한 조건에서 올바르게 작동하는지 확인합니다. 사용하여 단위 테스트 라이브러리를 사용하여 계산의 수치적 정확성을 확인하고 출력이 예상 결과를 충족하는지 확인합니다. 이 단계는 특히 의료 이미지 분석과 같은 실제 애플리케이션에 CNN을 배포할 때 디버깅하고 안정성을 보장하는 데 중요합니다. 이러한 스크립트와 설명을 통해 이제 CNN의 FC 레이어를 자신 있게 이해하고 구현할 수 있는 명확한 경로를 갖게 되었습니다. 🚀

완전 연결 계층의 노드 계산 이해

행렬 계산에 NumPy를 활용하는 Python 기반 솔루션

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

완전 연결 계층에서 노드 계산 일반화

히든 레이어의 모든 노드를 계산하기 위한 Python 기반 솔루션

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

완전 연결 계층에서 노드 계산을 위해 PyTorch 사용

딥 러닝 매니아를 위한 PyTorch를 사용한 구현

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

단위 테스트로 각 솔루션 테스트

구현의 정확성을 보장하기 위한 Python 기반 단위 테스트

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

CNN에서 완전 연결 레이어의 중요성 파악

완전 연결(FC) 레이어는 컨벌루션 레이어에서 추출된 특징을 최종 예측으로 변환하는 데 중추적인 역할을 합니다. 모든 입력을 모든 출력에 연결하여 학습된 기능의 조밀한 매핑을 제공하는 방식으로 작동합니다. 공간 계층에 초점을 맞춘 컨벌루션 레이어와 달리 FC 레이어는 이 정보를 집계하여 이미지에서 개체를 식별하는 것과 같은 결정을 내립니다. 예를 들어, 자율주행차의 이미지 인식 시스템에서 FC 레이어는 감지된 객체가 보행자인지 거리 표지판인지 판단할 수 있습니다. 🚗

FC 레이어를 차별화하는 한 가지 측면은 훈련 중에 학습된 패턴을 일반화하는 능력입니다. 이 속성은 보이지 않는 데이터를 처리할 때 매우 중요합니다. 레이어의 각 노드는 가중치와 편향의 고유한 조합을 나타내므로 특정 패턴이나 클래스를 전문적으로 인식할 수 있습니다. 이것이 FC 레이어의 구조가 전체 모델의 정확도를 결정하는 경우가 많은 이유입니다. 예를 들어, 필기 숫자 인식 모델에서 FC 레이어는 픽셀 패턴을 숫자 예측(0-9)으로 통합합니다. ✍️

FC 레이어는 조밀한 연결로 인해 계산 비용이 많이 들지만, 세부적인 분류가 필요한 작업에는 여전히 중요합니다. 드롭아웃과 같은 최신 기술은 과적합을 방지하여 성능을 최적화하는 데 사용됩니다. 훈련 중에 활성 노드 수를 줄임으로써 드롭아웃은 FC 계층이 강력한 기능을 학습하도록 보장하므로 안면 인식 및 의료 영상 진단과 같은 응용 분야에 없어서는 안 됩니다.

완전 연결 레이어에 대한 일반적인 질문

- CNN에서 완전 연결 계층의 주요 기능은 무엇입니까?

- FC 레이어는 모든 입력을 출력에 연결하여 최종 예측을 위한 기능을 집계합니다. 기능 맵을 실행 가능한 결과로 변환하는 것이 핵심입니다.

- FC 레이어에서 가중치와 편향은 어떻게 초기화되나요?

- 가중치는 종종 무작위로 초기화되거나 Xavier 초기화와 같은 기술을 사용하여 초기화되는 반면 편향은 일반적으로 단순화를 위해 0에서 시작됩니다.

- ReLU 활성화는 FC 계층 성능을 어떻게 향상시킵니까?

- ReLU는 음수 출력을 0으로 설정하여 비선형성을 적용합니다. 그라데이션이 사라지는 것을 방지하여 모델이 더 빠르게 수렴되도록 합니다.

- FC 레이어에 드롭아웃을 적용할 수 있나요?

- 예, 드롭아웃은 훈련 중에 노드를 무작위로 비활성화하여 모델 일반화를 강화하고 과적합을 줄입니다.

- FC 레이어가 컨벌루션 레이어와 다른 점은 무엇인가요?

- 컨벌루션 레이어는 공간 특징을 추출하는 반면 FC 레이어는 분류를 위해 이러한 특징을 밀집된 형식으로 집계합니다.

완전 연결 레이어에 대한 주요 내용

완전 연결 계층은 학습된 기능을 실행 가능한 예측으로 통합하여 신경망의 최종 의사 결정 단계 역할을 합니다. 각 노드가 계산되는 방식을 이해함으로써 사용자는 객체 감지 및 분류와 같은 작업을 위한 CNN 아키텍처를 설계하고 최적화하는 데 자신감을 얻을 수 있습니다.

자율주행차의 이미지 인식이나 얼굴 식별과 같은 실제 사례는 FC 레이어의 중요성을 보여줍니다. 올바른 접근 방식을 통해 최적화 방법을 통합하면 보이지 않는 데이터에 잘 적응하는 강력하고 정확한 모델이 보장됩니다. 이 개념을 숙지하면 인공 지능에 대한 더 깊은 탐구가 가능해집니다. 😊

출처 및 참고자료

- CNN에서 가져온 완전 연결 레이어에 대한 자세한 설명 기계 학습 숙달 .

- 활성화 기능 및 해당 애플리케이션에 대한 종합 가이드는 다음에서 검색됩니다. 분석 Vidhya .

- 신경망의 드롭아웃 및 최적화 기술에 대한 통찰력은 다음에서 찾을 수 있습니다. DeepAI .

- 신경망의 가중치와 편향 이해 데이터 과학을 향하여 .

- PyTorch에서 ReLU 활성화 함수 사용 PyTorch 문서 .