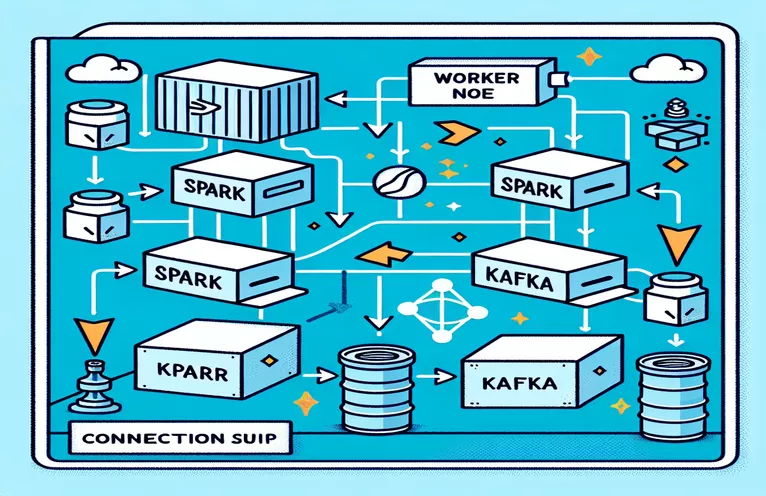

Docker화된 환경에서 Spark와 Kafka를 통합하는 데 따른 과제

통합하는 동안 연결 문제에 직면한 적이 있습니까? 카프카 브로커 으로 스파크 클러스터 Docker 설정 내에서? 당신은 혼자가 아닙니다! 많은 개발자는 이 두 가지 강력한 도구 간의 통신을 설정할 때 장애물에 직면합니다. 🛠️

최근에는 체력 강화에 나섰습니다. 스파크 클러스터 실시간 데이터 처리를 간소화하기 위해 Kafka 브로커를 추가합니다. 그러나 지속적인 연결 시간 초과와 DNS 확인 오류로 인해 문제가 발생하여 프로세스가 문제 해결 마라톤으로 바뀌었습니다. 😅

이러한 문제는 Docker Compose 및 Spark의 Kafka 관련 구성에서 잘못 구성된 설정으로 인해 발생했습니다. 여러 가이드를 따르고 수많은 매개변수를 조정했음에도 불구하고 파악하기 어려운 "브로커를 사용할 수 없을 수 있습니다"라는 메시지가 계속 표시되어 당황스럽고 좌절감을 느꼈습니다.

이 기사에서는 내 경험을 공유하고 Docker 환경에서 Spark 작업자와 Kafka 브로커 간의 연결 문제를 해결하기 위한 실용적인 단계를 제공하겠습니다. 그 과정에서 이러한 함정을 피하고 원활한 통합을 보장하기 위한 팁과 요령을 배우게 됩니다. 뛰어 들어보세요! 🚀

| 명령 | 사용예 |

|---|---|

| from_json() | 이 Spark SQL 함수는 JSON 문자열을 구문 분석하고 구조화된 데이터 개체를 생성합니다. 이 예에서는 Kafka 메시지를 구조화된 데이터로 역직렬화하는 데 사용됩니다. |

| StructType() | 구조화된 데이터 처리를 위한 스키마를 정의합니다. Kafka 메시지의 예상 형식을 정의하는 데 특히 유용합니다. |

| .readStream | Spark에서 스트리밍 DataFrame을 시작하여 Kafka 또는 기타 스트리밍 소스에서 지속적인 데이터 수집을 허용합니다. |

| writeStream | Spark 구조적 스트리밍 쿼리에 대한 출력 모드와 싱크를 정의합니다. 여기서는 추가 모드에서 콘솔에 쓰기를 지정합니다. |

| bootstrap_servers | Kafka 브로커의 주소를 지정하는 Kafka 구성 매개변수입니다. Spark 및 Kafka 통신에 중요합니다. |

| auto_offset_reset | 이전 오프셋이 없을 때 메시지 읽기를 시작할 위치를 결정하는 Kafka 소비자 설정입니다. "가장 빠른" 옵션은 가장 오래된 메시지부터 시작됩니다. |

| KAFKA_ADVERTISED_LISTENERS | Docker Kafka 구성 환경 변수입니다. Kafka 클라이언트에 대해 광고된 주소를 지정하여 Docker 네트워크 내부 및 외부에서 적절한 통신을 보장합니다. |

| KAFKA_LISTENERS | Kafka 브로커가 수신 연결을 수신하는 네트워크 인터페이스를 구성합니다. 여기서는 내부 통신과 외부 통신을 분리하는 데 사용됩니다. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | 다양한 Kafka 수신기에 대한 보안 프로토콜을 정의합니다. 이 경우에는 PLAINTEXT와 같은 해당 프로토콜에 리스너 이름을 매핑합니다. |

| .awaitTermination() | 스트리밍 쿼리가 종료될 때까지 스크립트 실행을 차단하여 스트림이 지속적으로 실행되도록 하는 Spark 구조적 스트리밍 방법입니다. |

Docker의 Spark 및 Kafka 통합 이해

첫 번째 스크립트는 다음과 같은 연결을 설정하는 데 중점을 둡니다. 스파크 워커 그리고 카프카 브로커. Spark의 구조적 스트리밍 API를 사용하여 스크립트는 Kafka 주제에서 실시간 데이터를 읽습니다. Spark 세션을 초기화하고 필요한 Kafka 패키지로 구성하는 것으로 시작됩니다. 이는 Spark가 Kafka와 원활하게 통신하는 데 필요한 종속성을 제공하므로 중요합니다. 이러한 종속성의 예로는 Docker 환경에서 Spark와 Kafka 간의 호환성을 보장하는 `org.apache.spark:spark-sql-kafka` 패키지가 있습니다.

Kafka 메시지를 처리하기 위해 스크립트는 `StructType`을 사용하여 스키마를 정의합니다. 이 스키마는 수신 메시지가 올바르게 구문 분석되고 구조화되도록 보장합니다. 실제 시나리오에는 Kafka의 JSON 데이터 처리가 포함되는 경우가 많습니다. 예를 들어 가격 업데이트가 포함된 메시지가 Kafka로 전송되는 암호화폐 모니터링 시스템을 상상해 보세요. 이러한 메시지를 읽을 수 있는 형식으로 구문 분석하면 추세 예측을 위해 데이터를 더 쉽게 처리하고 분석할 수 있습니다. 🪙

Docker Compose 구성은 연결 문제를 해결하는 데 중추적인 역할을 합니다. `KAFKA_ADVERTISED_LISTENERS` 및 `KAFKA_LISTENERS` 설정은 Docker 네트워크 내에서 내부 및 외부 통신을 구별하도록 조정됩니다. 이렇게 하면 Spark 및 Kafka와 같은 동일한 Docker 네트워크에서 실행되는 서비스가 DNS 확인 문제 없이 상호 작용할 수 있습니다. 예를 들어 'INSIDE://kafka:9093'을 매핑하면 내부 컨테이너가 Kafka에 액세스할 수 있고, 'OUTSIDE://localhost:9093'을 매핑하면 모니터링 도구와 같은 외부 애플리케이션을 연결할 수 있습니다.

두 번째 스크립트는 Kafka 연결을 테스트하기 위해 Python `KafkaConsumer`를 사용하는 방법을 보여줍니다. 이는 Kafka 브로커가 올바르게 작동하는지 확인하는 간단하면서도 효과적인 접근 방식입니다. 지정된 주제의 메시지를 사용하여 데이터 흐름이 중단되지 않는지 확인할 수 있습니다. 사용자가 주식 시장 데이터를 추적하려는 애플리케이션을 생각해 보십시오. 이 소비자 스크립트를 사용하여 연결을 테스트하면 구성 오류로 인해 중요한 업데이트가 누락되지 않는지 확인할 수 있습니다. 이러한 도구를 사용하면 실시간 데이터 처리를 위한 강력한 시스템을 자신 있게 배포할 수 있습니다! 🚀

Spark Worker와 Kafka Broker 간의 연결 문제 처리

해결 방법 1: Python을 사용하여 Docker를 통해 Spark 및 Kafka의 연결 문제 디버깅 및 해결

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Dockerized Kafka에서 DNS 확인 문제 디버깅

해결 방법 2: 적절한 DNS 확인을 위해 Docker Compose 구성 수정

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Kafka 소비자 연결 테스트

솔루션 3: 연결 테스트를 위한 Python Kafka 소비자

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Docker화된 환경에서 Kafka 및 Spark 최적화

원활한 의사소통을 보장하는 중요한 측면 카프카 브로커 그리고 스파크 워커 Docker에서는 네트워크 설정을 효과적으로 구성하고 있습니다. Docker 컨테이너는 격리된 환경에서 작동하므로 서비스가 상호 작용해야 할 때 DNS 확인 문제가 발생하는 경우가 많습니다. 이 문제를 해결하려면 Docker Compose의 네트워크 구성 옵션을 활용할 수 있습니다. 예를 들어 `my_network`와 같은 사용자 정의 네트워크를 정의하고 서비스를 연결하면 컨테이너가 IP가 아닌 이름으로 서로를 인식하므로 설정이 단순화되고 일반적인 함정을 피할 수 있습니다.

또 다른 필수 고려 사항은 Kafka의 수신기 구성을 최적화하는 것입니다. Docker Compose 파일에 'KAFKA_ADVERTISED_LISTENERS' 및 'KAFKA_LISTENERS'를 지정하면 Kafka가 클라이언트에 적절한 주소를 광고할 수 있습니다. 내부 수신기와 외부 수신기 간의 이러한 차별화는 특히 Spark 작업자가 Docker 네트워크 외부에서 연결을 시도할 때 충돌을 해결합니다. 이에 대한 실제 예는 액세스를 위해 별도의 외부 수신기가 필요한 호스트 시스템에서 Kafka 데이터를 쿼리하는 모니터링 대시보드입니다. 🔧

마지막으로 Spark 애플리케이션에서 강력한 오류 처리를 구현하는 것이 중요합니다. 예를 들어 Kafka 구성 내에서 재시도 및 폴백을 활용하면 임시 연결 문제를 원활하게 처리할 수 있습니다. `.option("kafka.consumer.max.poll.records", "500")`을 추가하면 부하가 심한 경우에도 효율적인 데이터 검색이 보장됩니다. 실시간으로 주가를 추적하는 프로덕션급 애플리케이션을 상상해 보십시오. 안전 장치를 마련하면 네트워크 문제가 발생하는 동안에도 데이터 흐름이 중단되지 않습니다. 이러한 기술은 함께 안정적인 데이터 처리 파이프라인의 백본을 형성합니다. 🚀

Docker의 Spark 및 Kafka에 대한 일반적인 질문

- 목적은 무엇입니까? KAFKA_ADVERTISED_LISTENERS?

- Kafka 클라이언트가 연결할 광고 주소를 지정하여 Docker 네트워크 내부 및 외부에서 적절한 통신을 보장합니다.

- Docker Compose에서 사용자 정의 네트워크를 어떻게 정의합니까?

- 아래에서 네트워크를 추가할 수 있습니다. networks 키를 입력하고 `와 같은 서비스에 포함시킵니다.networks: my_network`.

- Docker 컨테이너에서 DNS 확인이 실패하는 이유는 무엇입니까?

- 컨테이너는 DNS를 연결하는 동일한 Docker 네트워크에 속하지 않는 한 이름으로 서로를 인식하지 못할 수 있습니다.

- 역할은 무엇입니까? .option("subscribe", "topic") 스파크 스트리밍에서?

- 실시간 데이터 수집을 위해 Spark 구조적 스트리밍 DataFrame을 지정된 Kafka 주제에 구독합니다.

- 재시도는 Kafka-Spark 통합을 어떻게 향상시킬 수 있나요?

- 다음과 같은 구성에서 재시도 max.poll.records, 일시적인 오류를 처리하고 일관된 데이터 처리를 보장합니다.

Spark 및 Kafka 통합 단순화

Docker에서 Spark 및 Kafka를 설정하는 것은 복잡할 수 있지만 올바른 구성을 사용하면 관리가 가능해집니다. 연결 문제를 방지하려면 수신기 설정 및 네트워크 구성에 집중하세요. 최적의 성능을 위해 Zookeeper 및 Kafka와 같은 모든 구성 요소가 잘 동기화되었는지 확인하세요.

금융 데이터 모니터링이나 IoT 스트림 모니터링과 같은 실제 사용 사례에서는 강력한 구성의 중요성이 강조됩니다. 여기에 공유된 도구와 스크립트는 일반적인 장애물을 극복하고 효율적인 실시간 데이터 파이프라인을 구축하기 위한 지식을 제공합니다. 🛠️

출처 및 참고자료

- 이 글은 해당 관계자로부터 전해졌습니다 Apache Spark Kafka 통합 문서 , 구성 및 사용에 대한 자세한 통찰력을 제공합니다.

- Docker 네트워킹 모범 사례는 다음에서 참조되었습니다. Docker 네트워킹 문서 정확하고 안정적인 컨테이너 통신 설정을 보장합니다.

- 실제 예제와 추가 Kafka 설정이 다음에서 채택되었습니다. Wurstmeister Kafka Docker GitHub 리포지토리 .