„Spark“ ir „Kafka“ integravimo į dokerizuotą aplinką iššūkiai

Ar kada nors susidūrėte su ryšio problema integruodami a Kafka brokeris į a Kibirkšties klasteris „Docker“ sąrankoje? Tu ne vienas! Daugelis kūrėjų susiduria su kliūtimis nustatydami ryšį tarp šių dviejų galingų įrankių. 🛠️

Neseniai pradėjau tobulinti savo Kibirkšties klasteris pridedant Kafka brokerį, kad būtų supaprastintas duomenų apdorojimas realiuoju laiku. Tačiau susidūriau su kliūtimi dėl nuolatinio ryšio skirtojo laiko ir DNS skyros klaidų, o tai pavertė procesą trikčių šalinimo maratonu. 😅

Šios problemos kilo dėl netinkamai sukonfigūruotų „Docker Compose“ ir „Spark“ su Kafka susijusių konfigūracijų nustatymų. Nepaisant kelių vadovų ir daugybės parametrų pakeitimo, sunkiai suprantamas pranešimas „tarpininkas gali būti nepasiekiamas“ išliko, todėl mane glumino ir nusivyliau.

Šiame straipsnyje pasidalinsiu savo patirtimi ir pasiūlysiu praktinių žingsnių, kaip išspręsti „Spark“ darbuotojų ir „Kafka“ brokerių ryšio problemas „Docker“ aplinkoje. Pakeliui sužinosite patarimų ir gudrybių, kaip išvengti šių spąstų ir užtikrinti sklandų integravimą. Pasinerkime! 🚀

| komandą | Naudojimo pavyzdys |

|---|---|

| from_json() | Ši „Spark SQL“ funkcija analizuoja JSON eilutę ir sukuria struktūrinį duomenų objektą. Pavyzdyje jis naudojamas Kafka pranešimų deserializavimui į struktūrinius duomenis. |

| StructType() | Apibrėžia struktūrizuoto duomenų apdorojimo schemą. Tai ypač naudinga nustatant numatomą Kafkos pranešimų formatą. |

| .readStream | Inicijuoja srautinį duomenų rėmelį „Spark“, leidžiantį nuolat gauti duomenis iš „Kafka“ ar kitų srautinio perdavimo šaltinių. |

| writeStream | Apibrėžia „Spark Structured Streaming“ užklausos išvesties režimą ir kriauklę. Čia nurodomas rašymas į konsolę pridėjimo režimu. |

| bootstrap_servers | Kafka konfigūracijos parametras, nurodantis Kafka brokerio adresą. Labai svarbus Spark ir Kafka bendravimui. |

| auto_offset_reset | Kafka vartotojo nustatymas, kuris nustato, kur pradėti skaityti pranešimus, kai nėra išankstinio kompensavimo. „Anksčiausia“ parinktis prasideda nuo seniausio pranešimo. |

| KAFKA_ADVERTISED_LISTENERS | „Docker Kafka“ konfigūracijos aplinkos kintamasis. Jame nurodomi reklamuojami Kafka klientų adresai, užtikrinantys tinkamą ryšį Docker tinkle ir už jo ribų. |

| KAFKA_LISTENERS | Konfigūruoja tinklo sąsajas, kuriose Kafka tarpininkas klauso gaunamų ryšių. Čia naudojamas vidinei ir išorinei komunikacijai atskirti. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Apibrėžia skirtingų Kafka klausytojų saugos protokolus. Jis susieja klausytojų vardus su atitinkamais protokolais, pvz., šiuo atveju PLAINTEXT. |

| .awaitTermination() | Spark Structured Streaming metodas, kuris blokuoja scenarijaus vykdymą, kol bus nutraukta srautinio perdavimo užklausa, užtikrinant, kad srautas veiktų nuolat. |

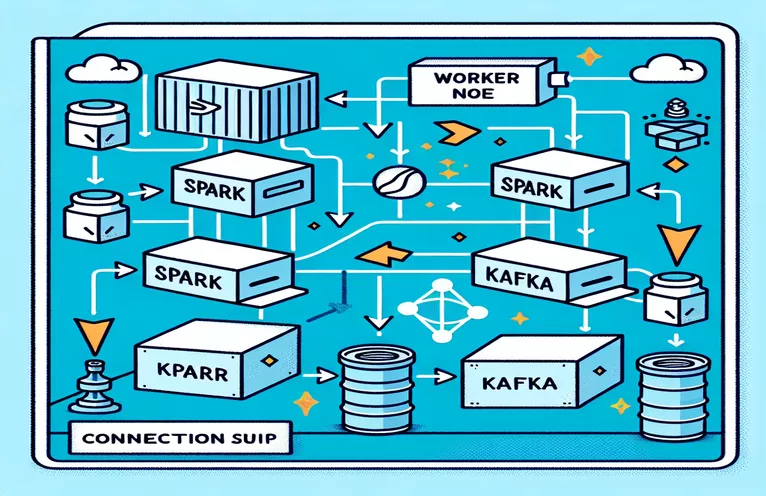

„Spark“ ir „Kafka“ integracijos „Docker“ supratimas

Pirmajame scenarijuje pagrindinis dėmesys skiriamas ryšio tarp a Kibirkšties darbuotojas ir a Kafka brokeris. Naudojant „Spark“ struktūrinio srautinio perdavimo API, scenarijus nuskaito Kafka temos duomenis realiuoju laiku. Tai prasideda inicijuojant Spark seansą ir sukonfigūruojant jį su reikiamu Kafka paketu. Tai labai svarbu, nes suteikia reikiamą priklausomybę, kad „Spark“ galėtų sklandžiai bendrauti su Kafka. Šios priklausomybės pavyzdys yra „org.apache.spark:spark-sql-kafka“ paketas, užtikrinantis „Spark“ ir „Kafka“ suderinamumą „Docker“ aplinkoje.

Kad tvarkytų Kafka pranešimus, scenarijus apibrėžia schemą naudodamas „StructType“. Ši schema užtikrina, kad gaunami pranešimai būtų tinkamai išanalizuoti ir struktūrizuoti. Realaus pasaulio scenarijai dažnai apima JSON duomenų tvarkymą iš Kafka. Pavyzdžiui, įsivaizduokite kriptovaliutų stebėjimo sistemą, kurioje Kafkai siunčiami pranešimai su kainų atnaujinimais. Išnagrinėjus šiuos pranešimus į skaitomą formatą, lengviau apdoroti ir analizuoti duomenis, kad būtų galima numatyti tendencijas. 🪙

„Docker Compose“ konfigūracija atlieka pagrindinį vaidmenį sprendžiant ryšio problemas. „KAFKA_ADVERTISED_LISTENERS“ ir „KAFKA_LISTENERS“ nustatymai sureguliuoti, kad būtų galima atskirti vidinį ir išorinį ryšį Docker tinkle. Tai užtikrina, kad paslaugos, veikiančios tame pačiame „Docker“ tinkle, pvz., „Spark“ ir „Kafka“, gali sąveikauti be DNS sprendimo problemų. Pavyzdžiui, susiejimas „INSIDE://kafka:9093“ leidžia vidiniams konteineriams pasiekti „Kafka“, o „OUTSIDE://localhost:9093“ leidžia prisijungti prie išorinių programų, pvz., stebėjimo įrankių.

Antrasis scenarijus parodo, kaip naudoti Python „KafkaConsumer“ Kafka ryšiui išbandyti. Tai paprastas, bet efektyvus būdas užtikrinti, kad Kafka brokeris veiktų tinkamai. Vartodami pranešimus iš nurodytos temos, galite patikrinti, ar duomenų srautas nenutrūksta. Apsvarstykite programą, kurioje vartotojas nori sekti akcijų rinkos duomenis. Išbandžius ryšį naudojant šį vartotojo scenarijų, užtikrinama, kad dėl konfigūracijos klaidų nebus praleisti jokie svarbūs naujinimai. Naudodami šiuos įrankius galite užtikrintai įdiegti patikimas sistemas duomenų apdorojimui realiuoju laiku! 🚀

Spark Worker ir Kafka Broker ryšio problemų sprendimas

1 sprendimas: „Python“ naudojimas derinimui ir ryšio problemoms spręsti „Spark“ ir „Kafka“ su „Docker“

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

„Dockerized Kafka“ DNS sprendimo problemų derinimas

2 sprendimas: pakeiskite „Docker Compose“ konfigūraciją, kad būtų užtikrinta tinkama DNS skyra

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

„Kafka“ vartotojų ryšio testavimas

3 sprendimas: Python Kafka Consumer ryšiui išbandyti

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Kafka ir Spark optimizavimas dokerinėje aplinkoje

Svarbus sklandaus bendravimo tarp Kafka brokeriai ir Kibirkšties darbuotojai „Docker“ efektyviai konfigūruoja tinklo nustatymus. „Docker“ konteineriai veikia izoliuotose aplinkose, todėl dažnai kyla DNS sprendimo problemų, kai paslaugoms reikia sąveikauti. Norėdami tai išspręsti, galite pasinaudoti „Docker Compose“ tinklo konfigūravimo parinktimis. Pavyzdžiui, apibrėžiant tinkintą tinklą, pvz., „mano_tinklas“ ir susiejant paslaugas, užtikrinama, kad sudėtiniai rodiniai atpažintų vienas kitą pagal pavadinimą, o ne pagal IP, o tai supaprastina sąranką ir išvengia įprastų spąstų.

Kitas svarbus aspektas yra Kafkos klausytojų konfigūracijų optimizavimas. Savo „Docker Compose“ faile nurodydami „KAFKA_ADVERTISED_LISTENERS“ ir „KAFKA_LISTENERS“, leidžiate „Kafka“ reklamuoti tinkamus adresus savo klientams. Šis vidinių ir išorinių klausytojų atskyrimas išsprendžia konfliktus, ypač kai „Spark Workers“ bando prisijungti iš „Docker“ tinklo ribų. Realus to pavyzdys yra stebėjimo prietaisų skydelis, užklausantis Kafka duomenų iš pagrindinio kompiuterio, o norint pasiekti reikia atskiro išorinio klausytojo. 🔧

Galiausiai, labai svarbu įdiegti patikimą klaidų tvarkymą „Spark“ programose. Pavyzdžiui, naudojant „Kafka“ konfigūracijos bandymus ir atsargines galimybes, laikinąsias ryšio problemas galima dailiai išspręsti. Pridėjus `.option("kafka.consumer.max.poll.records", "500")` užtikrinamas efektyvus duomenų gavimas net ir esant didelėms apkrovoms. Įsivaizduokite gamybinio lygio taikomąją programą, stebinčią akcijų kainas realiuoju laiku – įdiegus saugiklius, užtikrinamas nenutrūkstamas duomenų srautas net ir esant tinklo trikdžiams. Šie metodai kartu sudaro patikimo duomenų apdorojimo dujotiekio pagrindą. 🚀

Dažniausiai užduodami klausimai apie „Spark“ ir „Kafka“ programoje „Docker“.

- Koks tikslas KAFKA_ADVERTISED_LISTENERS?

- Jame nurodomi reklamuojami Kafka klientų prisijungimo adresai, užtikrinantys tinkamą ryšį Docker tinkle ir už jo ribų.

- Kaip „Docker Compose“ apibrėžiate tinkintą tinklą?

- Galite pridėti tinklą pagal networks raktą ir įtraukite jį į paslaugas, pvz., „networks: my_network`.

- Kodėl „Docker“ konteineriuose DNS skyra nepavyksta?

- Sudėtiniai rodiniai gali neatpažinti vienas kito pagal pavadinimą, nebent jie yra to paties Docker tinklo, kuris susieja jų DNS, dalis.

- Koks yra vaidmuo .option("subscribe", "topic") „Spark Streaming“?

- Jis prenumeruoja „Spark Structured Streaming DataFrame“ nurodytą „Kafka“ temą, kad būtų galima gauti duomenis realiuoju laiku.

- Kaip pakartotiniai bandymai gali pagerinti Kafka-Spark integraciją?

- Pakartotinai bando konfigūracijose, pvz max.poll.records, padėti tvarkyti trumpalaikes klaidas ir užtikrinti nuoseklų duomenų apdorojimą.

„Spark“ ir „Kafka“ integracijos supaprastinimas

„Spark“ ir „Kafka“ nustatymas programoje „Docker“ gali būti sudėtingas, tačiau su tinkamomis konfigūracijomis tai tampa valdoma. Sutelkite dėmesį į klausytojo nustatymus ir tinklo konfigūracijas, kad išvengtumėte ryšio problemų. Įsitikinkite, kad visi komponentai, pvz., „Zookeeper“ ir „Kafka“, yra gerai sinchronizuojami, kad būtų užtikrintas optimalus veikimas.

Realaus naudojimo atvejai, pvz., finansinių duomenų ar daiktų interneto srautų stebėjimas, pabrėžia patikimų konfigūracijų svarbą. Čia bendrinami įrankiai ir scenarijai suteikia žinių, kaip įveikti įprastas kliūtis ir kurti efektyvius, realaus laiko duomenų srautus. 🛠️

Šaltiniai ir nuorodos

- Šį straipsnį informavo pareigūnas „Apache Spark Kafka“ integravimo dokumentacija , kuriame pateikiamos išsamios įžvalgos apie konfigūraciją ir naudojimą.

- „Docker“ tinklų geriausia praktika buvo nurodyta iš Docker tinklo dokumentacija užtikrinti tikslią ir patikimą konteinerių ryšio sąranką.

- Praktiniai pavyzdžiai ir papildomi Kafka nustatymai buvo pritaikyti iš Wurstmeister Kafka Docker GitHub saugykla .