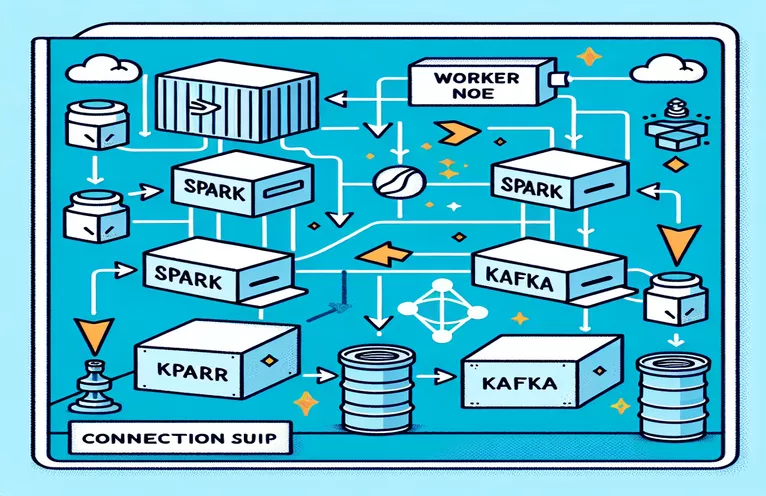

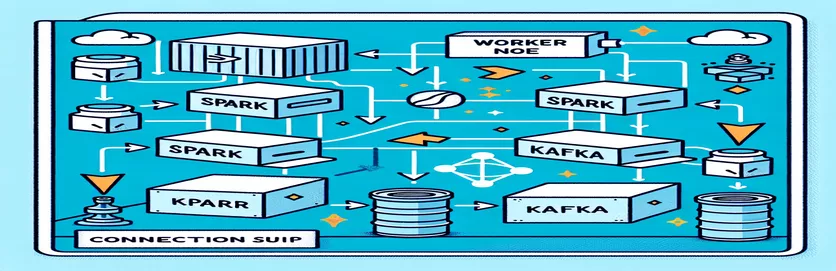

Izaicinājumi Spark un Kafka integrēšanai dokerizētā vidē

Vai esat kādreiz saskāries ar savienojamības problēmu, integrējot a Kafka brokeris uz a Spark Cluster Docker iestatījumos? Tu neesi viens! Daudzi izstrādātāji saskaras ar šķēršļiem, veidojot saziņu starp šiem diviem spēcīgajiem rīkiem. 🛠️

Nesen es sāku uzlabot savu Spark Cluster pievienojot Kafka brokeri, lai racionalizētu reāllaika datu apstrādi. Tomēr es saskāros ar pastāvīgu savienojuma taimautu un DNS izšķirtspējas kļūdām, kas procesu pārvērta par traucējummeklēšanas maratonu. 😅

Šīs problēmas radās nepareizi konfigurētu iestatījumu dēļ Docker Compose un Spark ar Kafka saistītajās konfigurācijās. Neraugoties uz vairāku norādījumu ievērošanu un daudzu parametru pielāgošanu, nenotveramais ziņojums “starpnieks var nebūt pieejams” saglabājās, liekot man neizpratni un neapmierinātību.

Šajā rakstā es dalīšos savā pieredzē un piedāvāšu praktiskas darbības, lai atrisinātu savienojamības problēmas starp Spark darbiniekiem un Kafka brokeriem Docker vidē. Pa ceļam jūs uzzināsit padomus un trikus, lai izvairītos no šīm kļūdām un nodrošinātu nevainojamu integrāciju. Iegremdējamies! 🚀

| Komanda | Lietošanas piemērs |

|---|---|

| from_json() | Šī Spark SQL funkcija parsē JSON virkni un izveido strukturētu datu objektu. Piemērā tas tiek izmantots, lai Kafka ziņojumus deserializētu strukturētos datos. |

| StructType() | Definē shēmu strukturētai datu apstrādei. Tas ir īpaši noderīgi, lai definētu paredzamo Kafkas ziņojumu formātu. |

| .readStream | Sparkā sāk straumēt DataFrame, kas ļauj nepārtraukti saņemt datus no Kafka vai citiem straumēšanas avotiem. |

| writeStream | Definē izvades režīmu un izlietni Spark Structured Streaming vaicājumam. Šeit tas norāda rakstīšanu konsolē pievienošanas režīmā. |

| bootstrap_servers | Kafka konfigurācijas parametrs, kas norāda Kafka brokera adresi. Svarīgi Spark un Kafka komunikācijai. |

| auto_offset_reset | Kafka patērētāja iestatījums, kas nosaka, kur sākt lasīt ziņojumus, ja nav iepriekšējas nobīdes. Opcija "agrākā" sākas no vecākā ziņojuma. |

| KAFKA_ADVERTISED_LISTENERS | Docker Kafka konfigurācijas vides mainīgais. Tas norāda Kafka klientu reklamētās adreses, nodrošinot pareizu saziņu Docker tīklā un ārpus tā. |

| KAFKA_LISTENERS | Konfigurē tīkla saskarnes, kurās Kafka brokeris klausās ienākošos savienojumus. Šeit izmanto iekšējās un ārējās komunikācijas atdalīšanai. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Definē drošības protokolus dažādiem Kafka klausītājiem. Tas piesaista klausītāju nosaukumus to attiecīgajiem protokoliem, piemēram, šajā gadījumā PLAINTEXT. |

| .awaitTermination() | Spark Structured Streaming metode, kas bloķē skripta izpildi, līdz tiek pārtraukts straumēšanas vaicājums, nodrošinot straumes nepārtrauktu darbību. |

Izpratne par Spark un Kafka integrāciju programmā Docker

Pirmais skripts ir vērsts uz savienojuma izveidi starp a Spark Worker un a Kafka brokeris. Izmantojot Spark strukturētās straumēšanas API, skripts nolasa reāllaika datus no Kafka tēmas. Tas sākas ar Spark sesijas inicializāciju un tās konfigurēšanu ar nepieciešamo Kafka pakotni. Tas ir ļoti svarīgi, jo tas nodrošina nepieciešamo atkarību, lai Spark varētu nevainojami sazināties ar Kafku. Šīs atkarības piemērs ir pakotne "org.apache.spark:spark-sql-kafka", kas nodrošina Spark un Kafka saderību Docker vidē.

Lai apstrādātu Kafka ziņojumus, skripts definē shēmu, izmantojot StructType. Šī shēma nodrošina, ka ienākošie ziņojumi ir pareizi parsēti un strukturēti. Reālās pasaules scenāriji bieži ietver JSON datu apstrādi no Kafka. Piemēram, iedomājieties kriptovalūtas uzraudzības sistēmu, kurā Kafkai tiek nosūtīti ziņojumi ar cenu atjauninājumiem. Šo ziņojumu parsēšana lasāmā formātā atvieglo datu apstrādi un analīzi tendenču prognozēšanai. 🪙

Docker Compose konfigurācijai ir galvenā loma savienojamības problēmu risināšanā. Iestatījumi “KAFKA_ADVERTISED_LISTENERS” un “KAFKA_LISTENERS” ir pielāgoti, lai atšķirtu iekšējo un ārējo saziņu Docker tīklā. Tas nodrošina, ka pakalpojumi, kas darbojas vienā Docker tīklā, piemēram, Spark un Kafka, var mijiedarboties bez DNS atrisināšanas problēmām. Piemēram, kartējot “INSIDE://kafka:9093”, iekšējie konteineri var piekļūt Kafka, savukārt “OUTSIDE://localhost:9093” ļauj izveidot savienojumu ārējām lietojumprogrammām, piemēram, uzraudzības rīkiem.

Otrais skripts parāda, kā izmantot Python "KafkaConsumer", lai pārbaudītu Kafka savienojumu. Šī ir vienkārša, taču efektīva pieeja, lai nodrošinātu, ka Kafka brokeris darbojas pareizi. Patērējot ziņas no norādītās tēmas, varat pārbaudīt, vai datu plūsma ir nepārtraukta. Apsveriet lietojumprogrammu, kurā lietotājs vēlas izsekot akciju tirgus datiem. Pārbaudot savienojumu, izmantojot šo patērētāja skriptu, tiek nodrošināts, ka konfigurācijas kļūdu dēļ netiek palaists neviens svarīgs atjauninājums. Izmantojot šos rīkus, varat droši izvietot stabilas sistēmas reāllaika datu apstrādei! 🚀

Savienojamības problēmu risināšana starp Spark Worker un Kafka Broker

1. risinājums: izmantojiet Python atkļūdošanai un savienojuma problēmu risināšanai Spark un Kafka ar Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

DNS risināšanas problēmu atkļūdošana programmā Dockerized Kafka

2. risinājums: mainiet Docker Compose konfigurāciju, lai nodrošinātu pareizu DNS izšķirtspēju

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Kafka patērētāju savienojuma pārbaude

3. risinājums: Python Kafka patērētājs savienojuma pārbaudei

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Kafka un Spark optimizēšana dokerizētā vidē

Kritisks aspekts, lai nodrošinātu vienmērīgu saziņu starp Kafka brokeri un Dzirksteles strādnieki programmā Docker efektīvi konfigurē tīkla iestatījumus. Docker konteineri darbojas izolētā vidē, bieži izraisot DNS atrisināšanas problēmas, kad pakalpojumiem ir jāsadarbojas. Lai to novērstu, varat izmantot Docker Compose tīkla konfigurācijas opcijas. Piemēram, definējot pielāgotu tīklu, piemēram, “mans_tīkls” un savienojot pakalpojumus, tiek nodrošināts, ka konteineri atpazīst viens otru pēc nosaukuma, nevis pēc IP, kas vienkāršo iestatīšanu un novērš bieži sastopamas kļūdas.

Vēl viens būtisks apsvērums ir Kafkas klausītāju konfigurāciju optimizēšana. Norādot KAFKA_ADVERTISED_LISTENERS un KAFKA_LISTENERS savā Docker Compose failā, jūs atļaujat Kafka reklamēt atbilstošas adreses saviem klientiem. Šī atšķirība starp iekšējiem un ārējiem klausītājiem atrisina konfliktus, jo īpaši, ja Spark Workers mēģina izveidot savienojumu ārpus Docker tīkla. Reāls piemērs tam ir pārraudzības informācijas panelis, kas vaicā Kafka datus no resursdatora, un piekļuvei ir nepieciešams īpašs ārējs klausītājs. 🔧

Visbeidzot, ļoti svarīgi ir ieviest spēcīgu kļūdu apstrādi jūsu Spark lietojumprogrammās. Piemēram, izmantojot atkārtotus mēģinājumus un atkāpšanās gadījumus Kafka konfigurācijā, var graciozi risināt pagaidu savienojuma problēmas. Pievienojot `.option("kafka.consumer.max.poll.records", "500")`, tiek nodrošināta efektīva datu izguve pat pie lielas slodzes. Iedomājieties ražošanas līmeņa lietojumprogrammu, kas reāllaikā izseko akciju cenas — ja ir uzstādīti atteices drošinātāji, tiek nodrošināta nepārtraukta datu plūsma pat tīkla traucējumu laikā. Šīs metodes kopā veido uzticama datu apstrādes konveijera mugurkaulu. 🚀

Bieži uzdotie jautājumi par Spark un Kafka programmā Docker

- Kāds ir mērķis KAFKA_ADVERTISED_LISTENERS?

- Tas norāda reklamētās adreses Kafka klientiem, lai izveidotu savienojumu, nodrošinot pareizu saziņu Docker tīklā un ārpus tā.

- Kā programmā Docker Compose tiek definēts pielāgots tīkls?

- Jūs varat pievienot tīklu zem networks atslēgu un iekļaujiet to pakalpojumos, piemēram, `networks: my_network`.

- Kāpēc DNS izšķirtspēja neizdodas Docker konteineros?

- Konteineri var neatpazīt viens otru pēc nosaukuma, ja vien tie nav daļa no tā paša Docker tīkla, kas saista to DNS.

- Kāda ir loma .option("subscribe", "topic") Spark Streaming?

- Tas abonē Spark Structured Streaming DataFrame norādītajā Kafka tēmā datu ievadīšanai reāllaikā.

- Kā atkārtoti mēģinājumi var uzlabot Kafka-Spark integrāciju?

- Atkārtoti mēģinājumi konfigurācijās, piemēram, max.poll.records, palīdz apstrādāt pārejošas kļūdas un nodrošināt konsekventu datu apstrādi.

Spark un Kafka integrācijas vienkāršošana

Spark un Kafka iestatīšana programmā Docker var būt sarežģīta, taču ar pareizām konfigurācijām tas kļūst pārvaldāms. Koncentrējieties uz klausītāja iestatījumiem un tīkla konfigurācijām, lai izvairītos no savienojamības problēmām. Pārliecinieties, vai visi komponenti, piemēram, Zookeeper un Kafka, ir labi sinhronizēti optimālai veiktspējai.

Reālās pasaules lietošanas gadījumi, piemēram, finanšu datu vai IoT straumju uzraudzība, uzsver stabilu konfigurāciju nozīmi. Šeit koplietotie rīki un skripti sniedz jums zināšanas, lai pārvarētu izplatītus šķēršļus un izveidotu efektīvus reāllaika datu cauruļvadus. 🛠️

Avoti un atsauces

- Šo rakstu informēja amatpersona Apache Spark Kafka integrācijas dokumentācija , sniedzot detalizētu ieskatu konfigurācijā un lietošanā.

- Docker tīklu veidošanas paraugprakse tika minēta no Docker tīkla dokumentācija lai nodrošinātu precīzus un uzticamus konteineru sakaru iestatījumus.

- Praktiski piemēri un papildu Kafka iestatījumi tika pielāgoti no Wurstmeister Kafka Docker GitHub repozitorijs .