Daniel Marino

25 November 2024

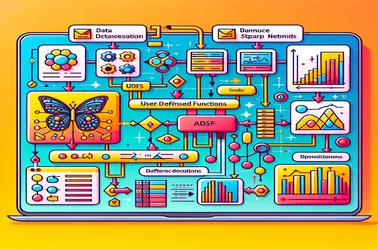

Membetulkan Masalah SparkContext dengan Penggunaan UDF Apache Spark untuk Pengekstrakan Ciri Imej

Apabila menggunakan UDF dalam Apache Spark untuk operasi teragih seperti pemprosesan model pembelajaran mendalam, adalah perkara biasa untuk menghadapi masalah "SparkContext hanya boleh digunakan pada pemacu" Spark. Ini berlaku disebabkan oleh sifat terikat pemandu yang ketat bagi SparkContext, yang mengawal pengagihan kerja. Dengan menghalang konflik bersiri dalam saluran paip pemprosesan imej yang diedarkan dan menjamin akses model tanpa permulaan semula pada setiap nod, penyelesaian seperti pembolehubah siaran membolehkan kami berkongsi model dengan nod pekerja dalam cara yang cekap. Keupayaan Spark untuk mengendalikan tugas pembelajaran mesin yang rumit pada skala besar dipertingkatkan dengan pendekatan penyiaran.