Daniel Marino

25 november 2024

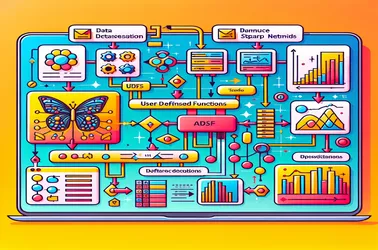

SparkContext-problemen oplossen met het gebruik van UDF's door Apache Spark voor de extractie van afbeeldingskenmerken

Bij het gebruik van UDF's binnen Apache Spark voor gedistribueerde bewerkingen zoals de verwerking van deep learning-modellen, kom je vaak het probleem "SparkContext kan alleen op het stuurprogramma" van Spark tegen. Dit komt door het strikte driver-gebonden karakter van SparkContext, dat de taakverdeling regelt. Door serialisatieconflicten in gedistribueerde pijplijnen voor beeldverwerking te voorkomen en modeltoegang te garanderen zonder herinitialisatie op elk knooppunt, stellen oplossingen zoals broadcast-variabelen ons in staat modellen te delen met werkknooppunten in een efficiënte manier. Het vermogen van Spark om ingewikkelde machine learning-taken op schaal uit te voeren, wordt aanzienlijk verbeterd door broadcast-benaderingen.