Uitdagingen bij het integreren van Spark en Kafka in een gedockeriseerde omgeving

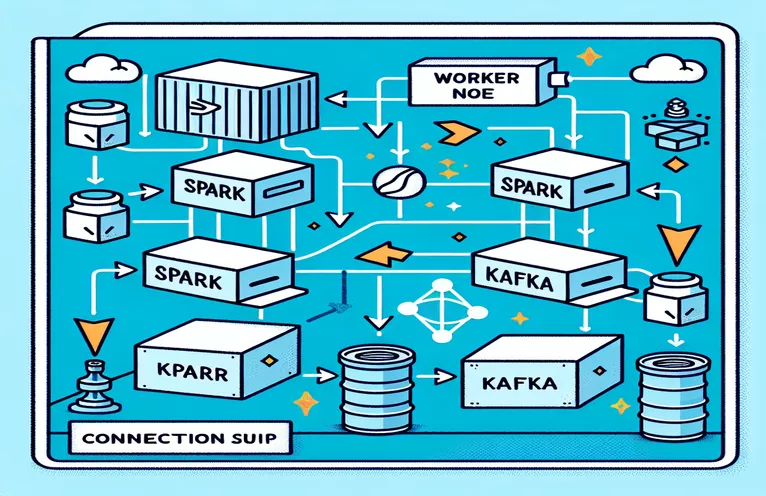

Heeft u ooit te maken gehad met een verbindingsprobleem tijdens het integreren van een Kafka-makelaar in een Spark-cluster binnen een Docker-installatie? Je bent niet de enige! Veel ontwikkelaars stuiten op hindernissen bij het opzetten van de communicatie tussen deze twee krachtige tools. 🛠️

Onlangs ben ik begonnen met het verbeteren van mijn Spark-cluster door een Kafka-makelaar toe te voegen om de realtime gegevensverwerking te stroomlijnen. Ik stuitte echter op een wegversperring met aanhoudende verbindingstime-outs en DNS-resolutiefouten, waardoor het proces een marathon voor het oplossen van problemen werd. 😅

Deze problemen kwamen voort uit verkeerd geconfigureerde instellingen in de Kafka-gerelateerde configuraties van Docker Compose en Spark. Ondanks het volgen van verschillende handleidingen en het aanpassen van talloze parameters, bleef het ongrijpbare bericht "makelaar is mogelijk niet beschikbaar" bestaan, waardoor ik verbaasd en gefrustreerd raakte.

In dit artikel deel ik mijn ervaringen en bied ik praktische stappen aan om connectiviteitsproblemen tussen Spark-werknemers en Kafka-makelaars in een Docker-omgeving op te lossen. Gaandeweg leer je tips en trucs om deze valkuilen te vermijden en een naadloze integratie te garanderen. Laten we erin duiken! 🚀

| Commando | Voorbeeld van gebruik |

|---|---|

| from_json() | Deze Spark SQL-functie parseert een JSON-tekenreeks en maakt een gestructureerd gegevensobject. In het voorbeeld wordt het gebruikt om Kafka-berichten te deserialiseren naar gestructureerde gegevens. |

| StructType() | Definieert een schema voor gestructureerde gegevensverwerking. Het is vooral handig voor het definiëren van het verwachte formaat van Kafka-berichten. |

| .readStream | Initieert een streaming DataFrame in Spark, waardoor continue gegevensopname uit Kafka of andere streamingbronnen mogelijk is. |

| writeStream | Definieert de uitvoermodus en sink voor een Spark Structured Streaming-query. Hier specificeert het schrijven naar de console in de toevoegmodus. |

| bootstrap_servers | Een Kafka-configuratieparameter die het adres van de Kafka-broker specificeert. Cruciaal voor Spark- en Kafka-communicatie. |

| auto_offset_reset | Een Kafka-consumenteninstelling die bepaalt waar berichten moeten worden gelezen als er geen eerdere offset bestaat. De "vroegste" optie begint vanaf het oudste bericht. |

| KAFKA_ADVERTISED_LISTENERS | Een Docker Kafka-configuratieomgevingsvariabele. Het specificeert de geadverteerde adressen voor Kafka-clients en zorgt voor een goede communicatie binnen en buiten het Docker-netwerk. |

| KAFKA_LISTENERS | Configureert de netwerkinterfaces waarop de Kafka-makelaar luistert naar inkomende verbindingen. Hier gebruikt voor het scheiden van interne en externe communicatie. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Definieert de beveiligingsprotocollen voor verschillende Kafka-luisteraars. Het wijst luisteraarnamen toe aan hun respectieve protocollen, zoals PLAINTEXT in dit geval. |

| .awaitTermination() | Een Spark Structured Streaming-methode die de uitvoering van het script blokkeert totdat de streamingquery wordt beëindigd, zodat de stream continu wordt uitgevoerd. |

Inzicht in Spark- en Kafka-integratie in Docker

Het eerste script richt zich op het tot stand brengen van een verbinding tussen a Spark-werknemer en een Kafka-makelaar. Door de Structured Streaming API van Spark te gebruiken, leest het script realtime gegevens uit een Kafka-onderwerp. Het begint met het initialiseren van een Spark-sessie en het configureren ervan met het vereiste Kafka-pakket. Dit is van cruciaal belang omdat het Spark de noodzakelijke afhankelijkheid biedt om naadloos met Kafka te communiceren. Een voorbeeld van deze afhankelijkheid is het pakket `org.apache.spark:spark-sql-kafka`, dat compatibiliteit tussen Spark en Kafka in een Docker-omgeving garandeert.

Om Kafka-berichten af te handelen, definieert het script een schema met behulp van `StructType`. Dit schema zorgt ervoor dat de binnenkomende berichten correct worden geparseerd en gestructureerd. Real-world scenario's omvatten vaak het verwerken van JSON-gegevens van Kafka. Stel je bijvoorbeeld een cryptocurrency-monitoringsysteem voor waarbij berichten met prijsupdates naar Kafka worden verzonden. Door deze berichten in een leesbaar formaat te parseren, wordt het eenvoudiger om gegevens te verwerken en analyseren voor trendvoorspelling. 🪙

De Docker Compose-configuratie speelt een cruciale rol bij het oplossen van verbindingsproblemen. De instellingen `KAFKA_ADVERTISED_LISTENERS` en `KAFKA_LISTENERS` zijn aangepast om onderscheid te maken tussen interne en externe communicatie binnen het Docker-netwerk. Dit zorgt ervoor dat services die op hetzelfde Docker-netwerk draaien, zoals Spark en Kafka, kunnen communiceren zonder DNS-resolutieproblemen. Door bijvoorbeeld `INSIDE://kafka:9093` in kaart te brengen, kunnen interne containers toegang krijgen tot Kafka, terwijl `OUTSIDE://localhost:9093` externe toepassingen zoals monitoringtools in staat stelt verbinding te maken.

Het tweede script laat zien hoe je een Python `KafkaConsumer` gebruikt voor het testen van de Kafka-verbinding. Dit is een eenvoudige maar effectieve aanpak om ervoor te zorgen dat de Kafka-makelaar correct functioneert. Door berichten over het opgegeven onderwerp te gebruiken, kunt u controleren of de gegevensstroom ononderbroken is. Overweeg een toepassing waarbij een gebruiker beursgegevens wil volgen. Het testen van de verbinding met dit consumentenscript zorgt ervoor dat er geen kritische updates worden gemist als gevolg van configuratiefouten. Met deze tools kunt u vol vertrouwen robuuste systemen inzetten voor realtime gegevensverwerking! 🚀

Connectiviteitsproblemen tussen Spark Worker en Kafka Broker afhandelen

Oplossing 1: Python gebruiken voor het debuggen en oplossen van verbindingsproblemen in Spark en Kafka met Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Fouten opsporen in DNS-resolutieproblemen in Dockerized Kafka

Oplossing 2: Docker Compose-configuratie wijzigen voor een juiste DNS-resolutie

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Kafka-consumentenverbinding testen

Oplossing 3: Python Kafka Consumer voor het testen van de verbinding

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Kafka en Spark optimaliseren in een gedockeriseerde omgeving

Een cruciaal aspect voor het garanderen van een soepele communicatie tussen Kafka Makelaars En Spark-arbeiders in Docker configureert netwerkinstellingen effectief. Docker-containers werken in geïsoleerde omgevingen en veroorzaken vaak DNS-resolutieproblemen wanneer services moeten communiceren. Om dit aan te pakken, kunt u gebruik maken van de netwerkconfiguratieopties van Docker Compose. Het definiëren van een aangepast netwerk zoals 'mijn_netwerk' en het koppelen van services zorgt er bijvoorbeeld voor dat containers elkaar herkennen op naam in plaats van op IP, wat de installatie vereenvoudigt en veelvoorkomende valkuilen vermijdt.

Een andere essentiële overweging is het optimaliseren van Kafka's luisteraarconfiguraties. Door `KAFKA_ADVERTISED_LISTENERS` en `KAFKA_LISTENERS` op te geven in uw Docker Compose-bestand, staat u Kafka toe de juiste adressen aan zijn klanten te adverteren. Dit onderscheid tussen interne en externe luisteraars lost conflicten op, vooral wanneer Spark Workers proberen verbinding te maken van buiten het Docker-netwerk. Een praktijkvoorbeeld hiervan is een monitoringdashboard dat Kafka-gegevens opvraagt vanaf een hostmachine, waarvoor een aparte externe luisteraar nodig is voor toegang. 🔧

Ten slotte is het implementeren van robuuste foutafhandeling in uw Spark-applicaties van cruciaal belang. Door bijvoorbeeld gebruik te maken van nieuwe pogingen en fallbacks binnen de Kafka-configuratie kunnen tijdelijke verbindingsproblemen op een elegante manier worden afgehandeld. Het toevoegen van `.option("kafka.consumer.max.poll.records", "500")` zorgt voor efficiënt ophalen van gegevens, zelfs onder zware belasting. Stel je een applicatie van productiekwaliteit voor die de aandelenkoersen in realtime bijhoudt. Met fail-safes is een ononderbroken gegevensstroom gegarandeerd, zelfs tijdens netwerkstoringen. Deze technieken vormen samen de ruggengraat van een betrouwbare dataverwerkingspijplijn. 🚀

Veelgestelde vragen over Spark en Kafka in Docker

- Wat is het doel van KAFKA_ADVERTISED_LISTENERS?

- Het specificeert de geadverteerde adressen waarmee Kafka-clients verbinding kunnen maken, waardoor een goede communicatie binnen en buiten het Docker-netwerk wordt gegarandeerd.

- Hoe definieer je een aangepast netwerk in Docker Compose?

- U kunt een netwerk toevoegen onder de networks sleutel en neem deze op in services, zoals `networks: my_network`.

- Waarom mislukt DNS-resolutie in Docker-containers?

- Containers herkennen elkaar mogelijk niet bij naam, tenzij ze deel uitmaken van hetzelfde Docker-netwerk, dat hun DNS koppelt.

- Wat is de rol van .option("subscribe", "topic") in Spark-streaming?

- Het abonneert het Spark Structured Streaming DataFrame op het opgegeven Kafka-onderwerp voor realtime gegevensopname.

- Hoe kunnen nieuwe pogingen de Kafka-Spark-integratie verbeteren?

- Nieuwe pogingen in configuraties, zoals max.poll.records, helpen bij het omgaan met tijdelijke fouten en zorgen voor een consistente gegevensverwerking.

Vereenvoudiging van Spark- en Kafka-integratie

Het instellen van Spark en Kafka in Docker kan complex zijn, maar met de juiste configuraties wordt het beheersbaar. Concentreer u op luisteraarinstellingen en netwerkconfiguraties om verbindingsproblemen te voorkomen. Zorg ervoor dat alle componenten zoals Zookeeper en Kafka goed gesynchroniseerd zijn voor optimale prestaties.

Gebruiksscenario's uit de praktijk, zoals het monitoren van financiële gegevens of IoT-stromen, benadrukken het belang van robuuste configuraties. De tools en scripts die hier worden gedeeld, voorzien u van de kennis om veelvoorkomende hindernissen te overwinnen en efficiënte, realtime datapijplijnen op te bouwen. 🛠️

Bronnen en referenties

- Dit artikel werd geïnformeerd door de ambtenaar Apache Spark Kafka-integratiedocumentatie , voor gedetailleerd inzicht in configuratie en gebruik.

- Er werd verwezen naar de best practices voor Docker-netwerken uit de Docker-netwerkdocumentatie om nauwkeurige en betrouwbare containercommunicatie-instellingen te garanderen.

- Praktijkvoorbeelden en aanvullende Kafka-instellingen zijn overgenomen uit de Wurstmeister Kafka Docker GitHub-repository .