Daniel Marino

26 november 2024

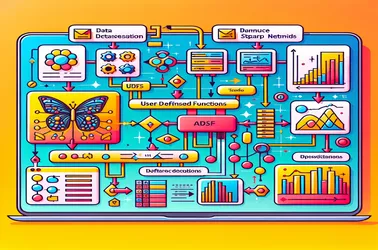

Løse SparkContext-problemer med Apache Sparks bruk av UDF-er for utvinning av bildefunksjoner

Når du bruker UDF-er i Apache Spark for distribuerte operasjoner som prosessering av dyp læringsmodeller, er det vanlig å støte på Sparks "SparkContext kan bare brukes på driveren". Dette skjer på grunn av den strenge sjåførbundne naturen til SparkContext, som kontrollerer jobbfordeling. Ved å forhindre serialiseringskonflikter i distribuerte bildebehandling-rørledninger og garantere modelltilgang uten reinitialisering på hver node, gjør løsninger som kringkastings-variabler oss i stand til å dele modeller med arbeidernoder i en effektiv måte. Sparks kapasitet til å håndtere intrikate maskinlæringsoppgaver i stor skala er betydelig forbedret av kringkastingstilnærminger.