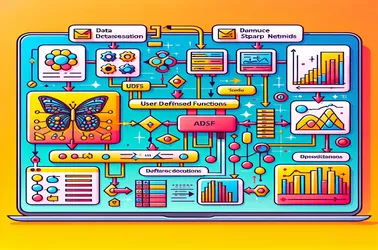

Podczas korzystania z funkcji UDF w Apache Spark do operacji rozproszonych, takich jak przetwarzanie modelu głębokiego uczenia, często spotyka się problem Sparka „SparkContext może być używany tylko w sterowniku”. Dzieje się tak ze względu na rygorystyczny charakter związany ze sterownikiem SparkContext, który kontroluje dystrybucję zadań. Zapobiegając konfliktom serializacji w rozproszonych potokach przetwarzania obrazów i gwarantując dostęp do modelu bez ponownej inicjalizacji w każdym węźle, rozwiązania takie jak zmienne rozgłaszania umożliwiają nam udostępnianie modeli węzłom roboczym w skuteczny sposób. Zdolność platformy Spark do obsługi skomplikowanych zadań uczenia maszynowego na dużą skalę jest znacznie poprawiona dzięki podejściu opartemu na transmisji.

Daniel Marino

26 listopada 2024

Naprawianie problemów SparkContext związanych z używaniem UDF przez Apache Spark do wyodrębniania cech obrazu