Wyzwania związane z integracją platformy Spark i Kafka w środowisku dokowanym

Czy kiedykolwiek napotkałeś problem z łącznością podczas integracji Broker Kafki w Gromada Iskier w konfiguracji Dockera? Nie jesteś sam! Wielu programistów napotyka przeszkody podczas konfigurowania komunikacji między tymi dwoma potężnymi narzędziami. 🛠️

Ostatnio zabrałem się za ulepszanie swojego Gromada Iskier poprzez dodanie brokera Kafka w celu usprawnienia przetwarzania danych w czasie rzeczywistym. Napotkałem jednak przeszkodę w postaci utrzymujących się przekroczeń limitu czasu połączenia i błędów rozpoznawania DNS, co zamieniło proces w maraton rozwiązywania problemów. 😅

Te problemy wynikały z błędnie skonfigurowanych ustawień w konfiguracjach Docker Compose i Kafka związanych z platformą Spark. Pomimo zastosowania się do kilku przewodników i zmiany wielu parametrów, nieuchwytny komunikat „broker może być niedostępny” nadal się pojawiał, co wywołało u mnie zdziwienie i frustrację.

W tym artykule podzielę się swoim doświadczeniem i zaproponuję praktyczne kroki umożliwiające rozwiązanie problemów związanych z łącznością między pracownikami Spark a brokerami Kafka w środowisku Docker. Po drodze nauczysz się wskazówek i wskazówek, jak uniknąć tych pułapek i zapewnić bezproblemową integrację. Zanurzmy się! 🚀

| Rozkaz | Przykład użycia |

|---|---|

| from_json() | Ta funkcja Spark SQL analizuje ciąg JSON i tworzy obiekt danych strukturalnych. W tym przykładzie służy do deserializacji komunikatów Kafki do postaci danych strukturalnych. |

| StructType() | Definiuje schemat przetwarzania danych strukturalnych. Jest to szczególnie przydatne przy definiowaniu oczekiwanego formatu komunikatów Kafki. |

| .readStream | Inicjuje strumieniową ramkę danych w platformie Spark, umożliwiając ciągłe pozyskiwanie danych z platformy Kafka lub innych źródeł przesyłania strumieniowego. |

| writeStream | Definiuje tryb wyjściowy i ujście dla zapytania dotyczącego przesyłania strumieniowego strukturalnego platformy Spark. Tutaj określa zapis do konsoli w trybie dołączania. |

| bootstrap_servers | Parametr konfiguracyjny platformy Kafka, który określa adres brokera platformy Kafka. Krytyczne dla komunikacji Spark i Kafka. |

| auto_offset_reset | Ustawienie konsumenta platformy Kafka, które określa, od czego rozpocząć czytanie komunikatów, jeśli nie istnieje wcześniejsze przesunięcie. Opcja „najwcześniejsza” rozpoczyna się od najstarszej wiadomości. |

| KAFKA_ADVERTISED_LISTENERS | Zmienna środowiskowa konfiguracji platformy Docker Kafka. Określa reklamowane adresy dla klientów Kafki, zapewniając poprawną komunikację wewnątrz i na zewnątrz sieci Docker. |

| KAFKA_LISTENERS | Konfiguruje interfejsy sieciowe, na których broker Kafka nasłuchuje połączeń przychodzących. Stosowane tutaj do oddzielenia komunikacji wewnętrznej i zewnętrznej. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Definiuje protokoły bezpieczeństwa dla różnych odbiorników Kafki. Odwzorowuje nazwy słuchaczy na ich odpowiednie protokoły, takie jak w tym przypadku PLAINTEXT. |

| .awaitTermination() | Metoda Spark Structured Streaming, która blokuje wykonanie skryptu do momentu zakończenia zapytania dotyczącego przesyłania strumieniowego, zapewniając ciągłe działanie strumienia. |

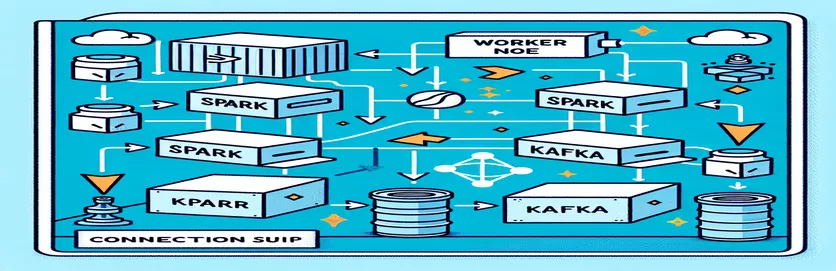

Zrozumienie integracji Sparka i Kafki w Dockerze

Pierwszy skrypt koncentruje się na ustanowieniu połączenia pomiędzy a Pracownik Iskry i a Broker Kafki. Korzystając z interfejsu API Structured Streaming API platformy Spark, skrypt odczytuje dane w czasie rzeczywistym z tematu Kafki. Rozpoczyna się od zainicjowania sesji Spark i skonfigurowania jej z wymaganym pakietem Kafki. Jest to kluczowe, ponieważ zapewnia niezbędną zależność, aby Spark mógł bezproblemowo komunikować się z Kafką. Przykładem tej zależności jest pakiet `org.apache.spark:spark-sql-kafka`, który zapewnia kompatybilność pomiędzy Spark i Kafką w środowisku Docker.

Aby obsłużyć komunikaty Kafki, skrypt definiuje schemat przy użyciu `StructType`. Ten schemat zapewnia, że przychodzące wiadomości są poprawnie analizowane i uporządkowane. Scenariusze ze świata rzeczywistego często obejmują obsługę danych JSON z platformy Kafka. Wyobraźmy sobie na przykład system monitorowania kryptowalut, w którym do Kafki wysyłane są wiadomości zawierające aktualizacje cen. Analizowanie tych komunikatów w czytelnym formacie ułatwia przetwarzanie i analizowanie danych w celu przewidywania trendów. 🪙

Konfiguracja Docker Compose odgrywa kluczową rolę w rozwiązywaniu problemów z łącznością. Ustawienia `KAFKA_ADVERTISED_LISTENERS` i `KAFKA_LISTENERS` zostały dostosowane w celu rozróżnienia komunikacji wewnętrznej i zewnętrznej w sieci Docker. Zapewnia to, że usługi działające w tej samej sieci Docker, takie jak Spark i Kafka, mogą współdziałać bez problemów z rozpoznawaniem DNS. Na przykład mapowanie „INSIDE://kafka:9093” umożliwia wewnętrznym kontenerom dostęp do Kafki, podczas gdy „OUTSIDE://localhost:9093” umożliwia połączenie aplikacji zewnętrznych, takich jak narzędzia monitorujące.

Drugi skrypt demonstruje, jak używać Pythona „KafkaConsumer” do testowania połączenia Kafka. Jest to proste, ale skuteczne podejście zapewniające prawidłowe działanie brokera Kafka. Korzystając z wiadomości z określonego tematu, możesz sprawdzić, czy przepływ danych przebiega nieprzerwanie. Rozważmy aplikację, w której użytkownik chce śledzić dane giełdowe. Testowanie połączenia przy użyciu tego skryptu konsumenckiego gwarantuje, że żadne krytyczne aktualizacje nie zostaną pominięte z powodu błędów konfiguracji. Dzięki tym narzędziom możesz śmiało wdrażać niezawodne systemy do przetwarzania danych w czasie rzeczywistym! 🚀

Rozwiązywanie problemów z łącznością między platformą Spark Worker a brokerem Kafka

Rozwiązanie 1: Używanie Pythona do debugowania i rozwiązywania problemów z połączeniem w Spark i Kafka z Dockerem

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Debugowanie problemów z rozpoznawaniem DNS w dokowanej platformie Kafka

Rozwiązanie 2: Modyfikowanie konfiguracji Docker Compose w celu zapewnienia prawidłowego rozpoznawania DNS

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Testowanie połączenia konsumenckiego Kafki

Rozwiązanie 3: Python Kafka Consumer do testowania połączenia

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Optymalizacja platformy Kafka i Spark w środowisku dokowanym

Kluczowym aspektem zapewnienia płynnej komunikacji pomiędzy Brokerzy Kafki I Pracownicy Iskry w Dockerze skutecznie konfiguruje ustawienia sieciowe. Kontenery Docker działają w odizolowanych środowiskach, często powodując problemy z rozpoznawaniem DNS, gdy usługi muszą współdziałać. Aby rozwiązać ten problem, możesz wykorzystać opcje konfiguracji sieci Docker Compose. Na przykład zdefiniowanie niestandardowej sieci, takiej jak „moja_sieć” i połączenie usług gwarantuje, że kontenery będą rozpoznawać się nawzajem po nazwie, a nie po adresie IP, co upraszcza konfigurację i pozwala uniknąć typowych pułapek.

Kolejną istotną kwestią jest optymalizacja konfiguracji słuchaczy Kafki. Określając `KAFKA_ADVERTISED_LISTENERS` i `KAFKA_LISTENERS` w pliku Docker Compose, pozwalasz Kafce na reklamowanie odpowiednich adresów swoim klientom. To rozróżnienie między odbiornikami wewnętrznymi i zewnętrznymi rozwiązuje konflikty, szczególnie gdy pracownicy platformy Spark próbują połączyć się spoza sieci Docker. Prawdziwym przykładem jest pulpit monitorujący wysyłający zapytania do danych Kafki z komputera hosta, wymagający dostępu do odrębnego zewnętrznego odbiornika. 🔧

Wreszcie, kluczowe znaczenie ma wdrożenie niezawodnej obsługi błędów w aplikacjach Spark. Na przykład wykorzystanie ponownych prób i powrotów w konfiguracji Kafki może skutecznie rozwiązać tymczasowe problemy z łącznością. Dodanie `.option("kafka.consumer.max.poll.records", "500")` zapewnia wydajne pobieranie danych, nawet przy dużym obciążeniu. Wyobraź sobie aplikację klasy produkcyjnej śledzącą ceny akcji w czasie rzeczywistym — posiadanie zabezpieczeń zapewniających nieprzerwany przepływ danych nawet w przypadku zakłóceń w sieci. Techniki te razem tworzą szkielet niezawodnego potoku przetwarzania danych. 🚀

Często zadawane pytania dotyczące platformy Spark i Kafka w platformie Docker

- Jaki jest cel KAFKA_ADVERTISED_LISTENERS?

- Określa reklamowane adresy, z którymi mogą się łączyć klienci Kafki, zapewniając prawidłową komunikację w sieci Docker i poza nią.

- Jak zdefiniować niestandardową sieć w Docker Compose?

- Możesz dodać sieć w obszarze networks key i dołącz go do usług, takich jak `networks: my_network`.

- Dlaczego rozpoznawanie DNS kończy się niepowodzeniem w kontenerach Docker?

- Kontenery mogą nie rozpoznawać się po nazwie, chyba że są częścią tej samej sieci Docker, która łączy ich DNS.

- Jaka jest rola .option("subscribe", "topic") w Spark Streaming?

- Subskrybuje ramkę danych strumieniowego przesyłania strukturalnego Spark do określonego tematu platformy Kafka w celu pozyskiwania danych w czasie rzeczywistym.

- W jaki sposób ponowne próby mogą poprawić integrację Kafka-Spark?

- Ponowne próby w konfiguracjach takich jak max.poll.records, pomagają w obsłudze przejściowych błędów i zapewniają spójne przetwarzanie danych.

Uproszczenie integracji Sparka i Kafki

Konfigurowanie Sparka i Kafki w Dockerze może być skomplikowane, ale przy odpowiednich konfiguracjach staje się łatwe w zarządzaniu. Skoncentruj się na ustawieniach odbiornika i konfiguracjach sieci, aby uniknąć problemów z łącznością. Upewnij się, że wszystkie komponenty, takie jak Zookeeper i Kafka, są dobrze zsynchronizowane, aby zapewnić optymalną wydajność.

Przypadki użycia w świecie rzeczywistym, takie jak monitorowanie danych finansowych lub strumieni IoT, podkreślają znaczenie niezawodnych konfiguracji. Udostępnione tutaj narzędzia i skrypty wyposażają Cię w wiedzę niezbędną do pokonywania typowych przeszkód i tworzenia wydajnych potoków danych w czasie rzeczywistym. 🛠️

Źródła i odniesienia

- O tym artykule poinformował urzędnik Dokumentacja integracji Apache Spark Kafka , zapewniając szczegółowy wgląd w konfigurację i użytkowanie.

- Do najlepszych praktyk sieciowych Dockera odwoływano się z Dokumentacja sieci Docker aby zapewnić dokładne i niezawodne konfiguracje komunikacji kontenerowej.

- Praktyczne przykłady i dodatkowe ustawienia Kafki zostały zaadaptowane z Repozytorium Dockera Wurstmeister Kafka na GitHubie .