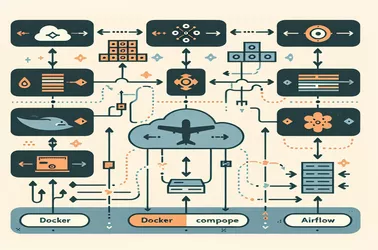

Pode ser difícil gerenciar o sequenciamento dinâmico de tarefas no Apache Airflow , principalmente quando as dependências devem ser criadas em tempo de execução. Um fluxo de trabalho mais flexível é possível utilizando dag_run.conf em vez de associações de tarefas de codificação. Para pipelines de processamento de dados, onde os parâmetros de entrada flutuam com frequência, esse método é especialmente útil. Usando a API Taskflow ou PythonOperators, os fluxos de trabalho podem se adaptar com base em gatilhos externos. Os DAGs dinâmicos fornecem uma opção escalável para operações de dados contemporâneas, estejam lidando com diversos conjuntos de dados, automatizando pipelines ETL ou simplificando a execução da tarefa.

Alice Dupont

13 fevereiro 2025

Gerando sequências de tarefas dinâmicas no fluxo de ar usando a configuração de execução do DAG