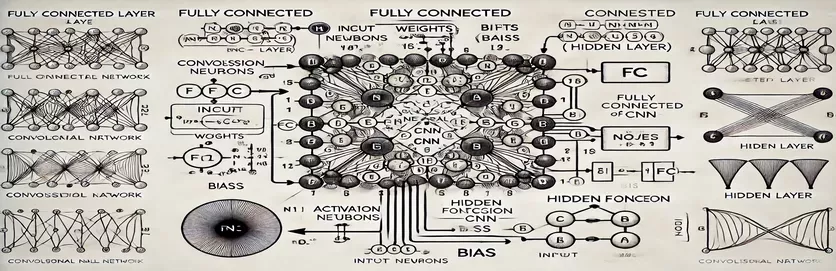

Desmistificando camadas totalmente conectadas em CNNs

Compreender o funcionamento de uma camada totalmente conectada (FC) em uma rede neural convolucional (CNN) pode parecer desvendar um mistério. Para muitos, a complexidade reside no processo de cálculo e na forma como um nó na camada oculta é derivado. Ao contrário das Redes Neurais Artificiais (RNAs) tradicionais, a camada FC nas CNNs tem nuances que muitas vezes ficam inexplicáveis em tutoriais. Se você está confuso sobre isso, você não está sozinho!

Muitos recursos abordam esse tópico, deixando os alunos sem uma orientação clara. Os tutoriais muitas vezes reciclam explicações incompletas, aumentando a frustração daqueles que buscam clareza. Se você está procurando respostas repetidamente, você está no lugar certo. 🧩

Neste guia, focaremos no cálculo de um único nó da camada oculta da camada FC. Depois de compreender o mecanismo de um nó, você estará equipado para lidar com o resto. Ao dividir esse processo em etapas claras e práticas, você ganhará confiança para navegar em qualquer cálculo da camada FC.

Usando exemplos relacionáveis e um diagrama simples, iluminaremos o caminho das entradas às saídas na camada FC. Diga adeus à confusão e olá à compreensão – vamos mergulhar! 🚀

| Comando | Exemplo de uso |

|---|---|

| np.dot() | Executa o produto escalar entre duas matrizes. Usado aqui para calcular a soma ponderada de entradas e pesos para um nó na camada totalmente conectada. |

| np.maximum() | Aplica a função de ativação ReLU selecionando o valor máximo entre a saída calculada e zero. |

| torch.tensor() | Cria um tensor no PyTorch. Tensores são os blocos básicos para representação de dados em estruturas de aprendizagem profunda. |

| torch.matmul() | Executa multiplicação de matrizes no PyTorch. Usado para calcular o produto escalar entre entradas e pesos. |

| torch.nn.functional.relu() | Aplica a função de ativação ReLU no PyTorch, definindo todos os valores negativos no tensor como zero. |

| np.testing.assert_array_almost_equal() | Compara duas matrizes elemento a elemento quanto à igualdade dentro de uma certa tolerância. Útil para testar a exatidão da saída em operações numéricas. |

| unittest.TestCase | Uma classe base no módulo unittest para criar casos de teste. Usado para estruturar e organizar testes unitários em Python. |

| np.array() | Cria um array em NumPy. Matrizes são usadas para representar entradas, pesos e tendências nos cálculos da camada totalmente conectada. |

| torch.matmul() | Função do PyTorch para multiplicação de matrizes, crucial para calcular resultados em redes neurais. |

| unittest.main() | Executa todos os casos de teste definidos no script. Essencial para validar a precisão e fiabilidade das soluções implementadas. |

Dividindo cálculos de camadas totalmente conectadas

Os scripts fornecidos visam desmistificar como um nó em um camada de uma CNN processa dados da camada anterior. Essas camadas conectam todas as entradas a todos os nós usando links e tendências ponderadas, tornando-as essenciais para tarefas como classificação de imagens. O primeiro script calcula a saída para um único nó usando . Multiplicando os valores de entrada pelos seus pesos correspondentes e adicionando o viés, a saída do nó é obtida. Esta saída é então passada por uma função de ativação (por exemplo, ReLU) para introduzir a não linearidade. Por exemplo, imagine os valores de pixel de uma imagem como entradas; os pesos podem representar filtros aprendidos que extraem recursos significativos da imagem. 🖼️

O segundo script generaliza o cálculo para vários nós. Utiliza multiplicação de matrizes, onde os pesos são representados como uma matriz 2D e as entradas como um vetor. Esta abordagem eficiente permite a computação simultânea para todos os nós da camada. Ao adicionar vieses e aplicar a função de ativação ReLU, as saídas finais da camada são produzidas. Este método é altamente escalonável e é uma operação central em estruturas modernas de aprendizado profundo. Por exemplo, num sistema de reconhecimento facial, este processo poderia ajudar a determinar se uma forma detectada se assemelha a um rosto humano. 😊

Para aqueles que trabalham com bibliotecas de aprendizagem profunda como , o terceiro script demonstra como usar tensores e funções integradas para realizar os mesmos cálculos. A flexibilidade e as otimizações integradas do PyTorch o tornam ideal para construir e treinar redes neurais. O script mostra como definir entradas, pesos e tendências como tensores e realizar a multiplicação de matrizes usando o função. Isto é particularmente útil para criar canais de ponta a ponta para treinar CNNs em grandes conjuntos de dados, como a identificação de animais em fotografias da vida selvagem.

Finalmente, o script de testes unitários garante que todas as implementações funcionem corretamente sob diversas condições. Usando o biblioteca, verifica a precisão numérica dos cálculos e confirma se os resultados atendem aos resultados esperados. Esta etapa é crucial para depurar e garantir a confiabilidade, especialmente ao implantar CNNs em aplicações do mundo real, como análise de imagens médicas. Com esses scripts e explicações, agora você tem um caminho claro para compreender e implementar camadas FC em CNNs com segurança. 🚀

Compreendendo o cálculo de um nó na camada totalmente conectada

Solução baseada em Python aproveitando NumPy para cálculos matriciais

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

Generalizando o cálculo de nós em camadas totalmente conectadas

Solução baseada em Python para calcular todos os nós em uma camada oculta

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

Usando PyTorch para cálculo de nó em uma camada totalmente conectada

Implementação com PyTorch para entusiastas de aprendizagem profunda

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

Teste cada solução com testes unitários

Testes de unidade baseados em Python para garantir a correção das implementações

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

Desvendando a importância das camadas totalmente conectadas nas CNNs

Camadas totalmente conectadas (FC) desempenham um papel fundamental na transformação de recursos extraídos de camadas convolucionais em previsões finais. Eles funcionam conectando cada entrada a cada saída, fornecendo um mapeamento denso dos recursos aprendidos. Ao contrário das camadas convolucionais que se concentram em hierarquias espaciais, as camadas FC agregam essas informações para tomar decisões como identificar objetos em uma imagem. Por exemplo, no sistema de reconhecimento de imagem de um carro autônomo, a camada FC pode determinar se um objeto detectado é um pedestre ou uma placa de rua. 🚗

Um aspecto que diferencia as camadas FC é a sua capacidade de generalizar padrões aprendidos durante o treinamento. Esta propriedade é crucial ao lidar com dados invisíveis. Cada nó na camada representa uma combinação única de pesos e tendências, permitindo-lhe especializar-se no reconhecimento de padrões ou classes específicas. É por isso que a estrutura das camadas FC frequentemente determina a precisão geral do modelo. Por exemplo, num modelo de reconhecimento de dígitos manuscritos, a camada FC consolida padrões de pixels em previsões numéricas (0-9). ✍️

Embora as camadas FC sejam computacionalmente caras devido às suas conexões densas, elas permanecem vitais para tarefas que exigem classificação detalhada. Técnicas modernas como dropout são usadas para otimizar seu desempenho, evitando overfitting. Ao reduzir o número de nós ativos durante o treinamento, o dropout garante que a camada FC aprenda recursos robustos, tornando-o indispensável em aplicações como reconhecimento facial e diagnóstico de imagens médicas.

- Qual é a principal função de uma camada totalmente conectada nas CNNs?

- A camada FC conecta todas as entradas às saídas, agregando recursos para previsões finais. É a chave para transformar mapas de recursos em resultados acionáveis.

- Como os pesos e tendências são inicializados nas camadas FC?

- Os pesos geralmente são inicializados aleatoriamente ou usando técnicas como a inicialização de Xavier, enquanto as tendências geralmente começam em zero para simplificar.

- Como a ativação do ReLU melhora o desempenho da camada FC?

- ReLU aplica a não linearidade definindo as saídas negativas como zero. Evita o desaparecimento de gradientes, fazendo com que o modelo convirja mais rapidamente.

- O dropout pode ser aplicado às camadas FC?

- Sim, o dropout desativa aleatoriamente os nós durante o treinamento, melhorando a generalização do modelo e reduzindo o overfitting.

- O que torna as camadas FC diferentes das camadas convolucionais?

- Enquanto as camadas convolucionais extraem características espaciais, as camadas FC agregam essas características em um formato denso para classificação.

A camada totalmente conectada consolida recursos aprendidos em previsões acionáveis, servindo como etapa final de tomada de decisão em redes neurais. Ao compreender como cada nó é calculado, os usuários ganham confiança no projeto e na otimização de arquiteturas CNN para tarefas como detecção e classificação de objetos.

Exemplos práticos, como o reconhecimento de imagens em veículos autônomos ou a identificação facial, mostram a importância das camadas FC. Com a abordagem certa, a incorporação de métodos de otimização garante modelos robustos e precisos que se adaptam bem a dados invisíveis. O domínio deste conceito abre uma exploração mais profunda da inteligência artificial. 😊

- Explicação detalhada sobre camadas totalmente conectadas em CNNs provenientes de Domínio do aprendizado de máquina .

- Guia completo para funções de ativação e seus aplicativos recuperados de Análise Vidhya .

- Insights sobre técnicas de abandono e otimização para redes neurais encontrados em DeepAI .

- Compreendendo pesos e vieses em redes neurais de Rumo à ciência de dados .

- Uso de funções de ativação ReLU em PyTorch provenientes de Documentação PyTorch .