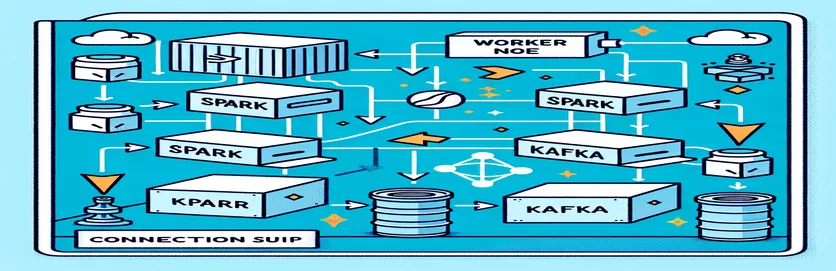

Desafios da integração do Spark e do Kafka em um ambiente Dockerizado

Você já enfrentou um problema de conectividade ao integrar um Corretor Kafka em um Cluster Spark dentro de uma configuração do Docker? Você não está sozinho! Muitos desenvolvedores encontram obstáculos ao configurar a comunicação entre essas duas ferramentas poderosas. 🛠️

Recentemente, comecei a aprimorar meu Cluster Spark adicionando um corretor Kafka para agilizar o processamento de dados em tempo real. No entanto, encontrei um obstáculo com tempos limite de conexão persistentes e erros de resolução de DNS, o que transformou o processo em uma maratona de solução de problemas. 😅

Esses problemas resultaram de configurações incorretas no Docker Compose e nas configurações relacionadas ao Kafka do Spark. Apesar de seguir vários guias e ajustar vários parâmetros, a elusiva mensagem “o corretor pode não estar disponível” persistiu, deixando-me confuso e frustrado.

Neste artigo, compartilharei minha experiência e oferecerei etapas práticas para resolver desafios de conectividade entre trabalhadores Spark e corretores Kafka em um ambiente Docker. Ao longo do caminho, você aprenderá dicas e truques para evitar essas armadilhas e garantir uma integração perfeita. Vamos mergulhar! 🚀

| Comando | Exemplo de uso |

|---|---|

| from_json() | Esta função Spark SQL analisa uma string JSON e cria um objeto de dados estruturados. No exemplo, é usado para desserializar mensagens Kafka em dados estruturados. |

| StructType() | Define um esquema para processamento estruturado de dados. É particularmente útil para definir o formato esperado das mensagens Kafka. |

| .readStream | Inicia um DataFrame de streaming no Spark, permitindo a ingestão contínua de dados do Kafka ou de outras fontes de streaming. |

| writeStream | Define o modo de saída e o coletor para uma consulta de streaming estruturado do Spark. Aqui, especifica a gravação no console no modo de acréscimo. |

| bootstrap_servers | Um parâmetro de configuração do Kafka que especifica o endereço do broker Kafka. Crítico para comunicação Spark e Kafka. |

| auto_offset_reset | Uma configuração do consumidor Kafka que determina onde começar a ler mensagens quando não existe deslocamento anterior. A opção “mais antiga” começa na mensagem mais antiga. |

| KAFKA_ADVERTISED_LISTENERS | Uma variável de ambiente de configuração do Docker Kafka. Especifica os endereços anunciados para clientes Kafka, garantindo a comunicação adequada dentro e fora da rede Docker. |

| KAFKA_LISTENERS | Configura as interfaces de rede nas quais o agente Kafka escuta conexões de entrada. Usado aqui para separar a comunicação interna e externa. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Define os protocolos de segurança para diferentes ouvintes Kafka. Ele mapeia os nomes dos ouvintes para seus respectivos protocolos, como PLAINTEXT neste caso. |

| .awaitTermination() | Um método Spark Structured Streaming que bloqueia a execução do script até que a consulta de streaming seja encerrada, garantindo que o stream seja executado continuamente. |

Compreendendo a integração Spark e Kafka no Docker

O primeiro roteiro se concentra em estabelecer uma conexão entre um Trabalhador de faísca e um Corretor Kafka. Ao usar a API de streaming estruturado do Spark, o script lê dados em tempo real de um tópico Kafka. Ele começa inicializando uma sessão do Spark e configurando-a com o pacote Kafka necessário. Isso é crucial, pois fornece a dependência necessária para que o Spark se comunique perfeitamente com o Kafka. Um exemplo dessa dependência é o pacote `org.apache.spark:spark-sql-kafka`, que garante compatibilidade entre Spark e Kafka em um ambiente Docker.

Para lidar com mensagens Kafka, o script define um esquema usando `StructType`. Este esquema garante que as mensagens recebidas sejam analisadas e estruturadas corretamente. Os cenários do mundo real geralmente envolvem o tratamento de dados JSON do Kafka. Por exemplo, imagine um sistema de monitoramento de criptomoeda onde mensagens contendo atualizações de preços são enviadas para Kafka. A análise dessas mensagens em um formato legível facilita o processamento e a análise de dados para previsão de tendências. 🪙

A configuração do Docker Compose desempenha um papel fundamental na resolução de problemas de conectividade. As configurações `KAFKA_ADVERTISED_LISTENERS` e `KAFKA_LISTENERS` são ajustadas para diferenciar a comunicação interna e externa dentro da rede Docker. Isso garante que os serviços executados na mesma rede Docker, como Spark e Kafka, possam interagir sem problemas de resolução de DNS. Por exemplo, o mapeamento `INSIDE://kafka:9093` permite que contêineres internos acessem o Kafka, enquanto `OUTSIDE://localhost:9093` permite que aplicativos externos, como ferramentas de monitoramento, se conectem.

O segundo script demonstra como usar um `KafkaConsumer` Python para testar a conexão Kafka. Esta é uma abordagem simples, mas eficaz, para garantir que o corretor Kafka esteja funcionando corretamente. Ao consumir mensagens do tópico especificado, você pode verificar se o fluxo de dados é ininterrupto. Considere um aplicativo onde um usuário deseja rastrear dados do mercado de ações. Testar a conexão usando esse script de consumidor garante que nenhuma atualização crítica seja perdida devido a erros de configuração. Com essas ferramentas, você pode implantar sistemas robustos com segurança para processamento de dados em tempo real! 🚀

Lidando com problemas de conectividade entre Spark Worker e Kafka Broker

Solução 1: usando Python para depurar e resolver problemas de conexão no Spark e Kafka com Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Depurando problemas de resolução de DNS no Kafka Dockerizado

Solução 2: Modificando a configuração do Docker Compose para resolução DNS adequada

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Testando a conexão do consumidor Kafka

Solução 3: Consumidor Python Kafka para testar a conexão

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Otimizando Kafka e Spark em um ambiente Dockerizado

Um aspecto crítico para garantir uma comunicação tranquila entre Corretores Kafka e Trabalhadores de faísca no Docker está definindo as configurações de rede de maneira eficaz. Os contêineres Docker operam em ambientes isolados, muitas vezes causando problemas de resolução de DNS quando os serviços precisam interagir. Para resolver isso, você pode aproveitar as opções de configuração de rede do Docker Compose. Por exemplo, definir uma rede personalizada como `my_network` e vincular serviços garante que os contêineres se reconheçam por nome em vez de IP, o que simplifica a configuração e evita armadilhas comuns.

Outra consideração essencial é otimizar as configurações do ouvinte do Kafka. Ao especificar `KAFKA_ADVERTISED_LISTENERS` e `KAFKA_LISTENERS` em seu arquivo Docker Compose, você permite que Kafka anuncie endereços apropriados para seus clientes. Essa diferenciação entre ouvintes internos e externos resolve conflitos, principalmente quando Spark Workers tentam se conectar de fora da rede Docker. Um exemplo real disso é um painel de monitoramento que consulta dados Kafka de uma máquina host, exigindo um ouvinte externo distinto para acesso. 🔧

Por fim, implementar um tratamento robusto de erros em seus aplicativos Spark é crucial. Por exemplo, aproveitar novas tentativas e fallbacks na configuração do Kafka pode lidar com problemas de conectividade temporários normalmente. Adicionar `.option("kafka.consumer.max.poll.records", "500")` garante uma recuperação de dados eficiente, mesmo sob cargas pesadas. Imagine um aplicativo de nível de produção rastreando os preços das ações em tempo real. Ter sistemas de proteção contra falhas garante um fluxo de dados ininterrupto, mesmo durante problemas de rede. Juntas, essas técnicas formam a espinha dorsal de um pipeline confiável de processamento de dados. 🚀

Perguntas comuns sobre Spark e Kafka no Docker

- Qual é o propósito KAFKA_ADVERTISED_LISTENERS?

- Ele especifica os endereços anunciados para os clientes Kafka se conectarem, garantindo a comunicação adequada dentro e fora da rede Docker.

- Como você define uma rede personalizada no Docker Compose?

- Você pode adicionar uma rede sob o networks chave e incluí-la em serviços, como `networks: my_network`.

- Por que a resolução de DNS falha em contêineres Docker?

- Os contêineres podem não se reconhecer pelo nome, a menos que façam parte da mesma rede Docker, que vincula seu DNS.

- Qual é o papel .option("subscribe", "topic") no Spark Streaming?

- Ele inscreve o Spark Structured Streaming DataFrame no tópico Kafka especificado para ingestão de dados em tempo real.

- Como as novas tentativas podem melhorar a integração Kafka-Spark?

- Novas tentativas em configurações, como max.poll.records, ajudam a lidar com erros transitórios e garantem um processamento de dados consistente.

Simplificando a integração Spark e Kafka

Configurar Spark e Kafka no Docker pode ser complexo, mas com as configurações certas, torna-se gerenciável. Concentre-se nas configurações do ouvinte e nas configurações de rede para evitar problemas de conectividade. Certifique-se de que todos os componentes como Zookeeper e Kafka estejam bem sincronizados para um desempenho ideal.

Casos de uso do mundo real, como monitoramento de dados financeiros ou fluxos de IoT, destacam a importância de configurações robustas. As ferramentas e scripts compartilhados aqui fornecem o conhecimento necessário para superar obstáculos comuns e criar pipelines de dados eficientes e em tempo real. 🛠️

Fontes e Referências

- Este artigo foi informado pelo oficial Documentação de integração do Apache Spark Kafka , fornecendo insights detalhados sobre configuração e uso.

- As melhores práticas de rede Docker foram referenciadas no Documentação de rede Docker para garantir configurações de comunicação de contêineres precisas e confiáveis.

- Exemplos práticos e configurações adicionais do Kafka foram adaptados do Repositório Wurstmeister Kafka Docker GitHub .