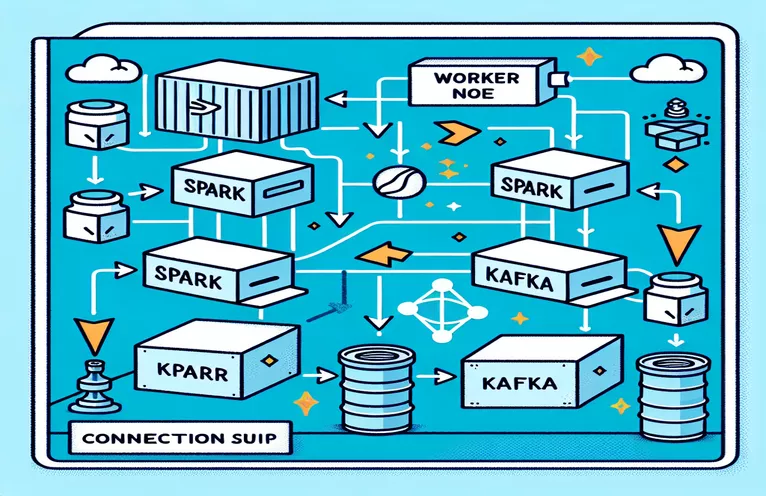

Проблемы интеграции Spark и Kafka в докеризованной среде

Сталкивались ли вы когда-нибудь с проблемой подключения при интеграции Кафка Брокер в Искровой кластер в настройке Docker? Вы не одиноки! Многие разработчики сталкиваются с трудностями при настройке связи между этими двумя мощными инструментами. 🛠️

Недавно я начал совершенствовать свои Искровой кластер добавив брокер Kafka для оптимизации обработки данных в реальном времени. Однако я столкнулся с препятствием из-за постоянных тайм-аутов соединения и ошибок разрешения DNS, что превратило процесс в марафон устранения неполадок. 😅

Эти проблемы возникли из-за неправильно настроенных настроек в Docker Compose и конфигурациях Spark, связанных с Kafka. Несмотря на то, что я следовал нескольким руководствам и настраивал многочисленные параметры, неуловимое сообщение «брокер может быть недоступен», оставив меня озадаченным и разочарованным.

В этой статье я поделюсь своим опытом и предложу практические шаги по решению проблем с подключением между работниками Spark и брокерами Kafka в среде Docker. Попутно вы узнаете советы и рекомендации, которые помогут избежать этих ошибок и обеспечить плавную интеграцию. Давайте погрузимся! 🚀

| Команда | Пример использования |

|---|---|

| from_json() | Эта функция Spark SQL анализирует строку JSON и создает объект структурированных данных. В примере он используется для десериализации сообщений Kafka в структурированные данные. |

| StructType() | Определяет схему для обработки структурированных данных. Это особенно полезно для определения ожидаемого формата сообщений Kafka. |

| .readStream | Инициирует потоковый DataFrame в Spark, обеспечивая непрерывный прием данных из Kafka или других источников потоковой передачи. |

| writeStream | Определяет режим вывода и приемник для запроса структурированной потоковой передачи Spark. Здесь он определяет запись в консоль в режиме добавления. |

| bootstrap_servers | Параметр конфигурации Kafka, указывающий адрес брокера Kafka. Критически важен для взаимодействия Spark и Kafka. |

| auto_offset_reset | Пользовательская настройка Kafka, определяющая, с чего начинать чтение сообщений, если предварительного смещения не существует. «Самый ранний» вариант начинается с самого старого сообщения. |

| KAFKA_ADVERTISED_LISTENERS | Переменная среды конфигурации Docker Kafka. Он указывает объявленные адреса для клиентов Kafka, обеспечивая правильную связь внутри и за пределами сети Docker. |

| KAFKA_LISTENERS | Настраивает сетевые интерфейсы, на которых брокер Kafka прослушивает входящие соединения. Используется здесь для разделения внутренней и внешней связи. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Определяет протоколы безопасности для различных прослушивателей Kafka. Он сопоставляет имена слушателей с соответствующими протоколами, например PLAINTEXT в данном случае. |

| .awaitTermination() | Метод структурированной потоковой передачи Spark, который блокирует выполнение сценария до тех пор, пока запрос потоковой передачи не будет завершен, обеспечивая непрерывную работу потока. |

Понимание интеграции Spark и Kafka в Docker

Первый скрипт ориентирован на установление соединения между Искровой рабочий и Кафка Брокер. Используя API структурированной потоковой передачи Spark, сценарий считывает данные в реальном времени из темы Kafka. Он начинается с инициализации сеанса Spark и его настройки с помощью необходимого пакета Kafka. Это очень важно, поскольку обеспечивает Spark необходимую зависимость для беспрепятственного взаимодействия с Kafka. Примером этой зависимости является пакет org.apache.spark:spark-sql-kafka, который обеспечивает совместимость между Spark и Kafka в среде Docker.

Для обработки сообщений Kafka сценарий определяет схему, используя StructType. Эта схема гарантирует, что входящие сообщения правильно анализируются и структурируются. Реальные сценарии часто включают обработку данных JSON из Kafka. Например, представьте себе систему мониторинга криптовалюты, в которой сообщения, содержащие обновления цен, отправляются в Kafka. Преобразование этих сообщений в читаемый формат упрощает обработку и анализ данных для прогнозирования тенденций. 🪙

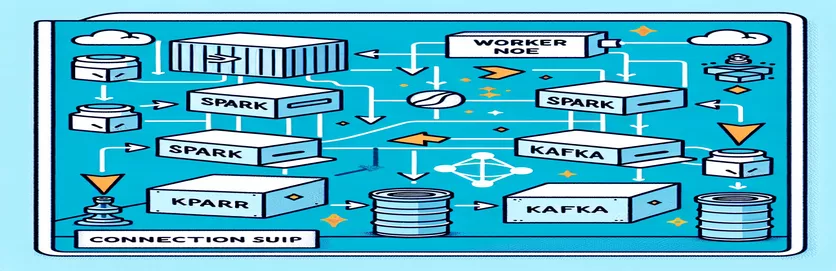

Конфигурация Docker Compose играет ключевую роль в решении проблем с подключением. Настройки KAFKA_ADVERTISED_LISTENERS и KAFKA_LISTENERS настроены так, чтобы различать внутреннюю и внешнюю связь внутри сети Docker. Это гарантирует, что службы, работающие в одной сети Docker, такие как Spark и Kafka, могут взаимодействовать без проблем с разрешением DNS. Например, сопоставление INSIDE://kafka:9093 позволяет внутренним контейнерам получать доступ к Kafka, а OUTSIDE://localhost:9093 позволяет подключаться внешним приложениям, таким как инструменты мониторинга.

Второй скрипт демонстрирует, как использовать Python KafkaConsumer для тестирования соединения Kafka. Это простой, но эффективный подход, позволяющий гарантировать правильную работу брокера Kafka. Получая сообщения из указанной темы, вы можете проверить, бесперебойен ли поток данных. Рассмотрим приложение, в котором пользователь хочет отслеживать данные фондового рынка. Тестирование соединения с помощью этого пользовательского сценария гарантирует, что ни одно важное обновление не будет пропущено из-за ошибок конфигурации. С помощью этих инструментов вы можете уверенно развертывать надежные системы для обработки данных в реальном времени! 🚀

Решение проблем подключения между Spark Worker и Kafka Broker

Решение 1. Использование Python для отладки и решения проблем с подключением в Spark и Kafka с помощью Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Отладка проблем разрешения DNS в Dockerized Kafka

Решение 2. Изменение конфигурации Docker Compose для правильного разрешения DNS

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Тестирование подключения потребителей Kafka

Решение 3. Python Kafka Consumer для тестирования соединения

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Оптимизация Kafka и Spark в докеризованной среде

Важнейший аспект обеспечения бесперебойной связи между Кафка Брокерс и Искровые рабочие в Docker эффективно настраивает параметры сети. Контейнеры Docker работают в изолированных средах, что часто вызывает проблемы с разрешением DNS, когда службам необходимо взаимодействовать. Чтобы решить эту проблему, вы можете использовать параметры конфигурации сети Docker Compose. Например, определение пользовательской сети, такой как my_network, и связывание служб гарантирует, что контейнеры распознают друг друга по имени, а не по IP, что упрощает настройку и позволяет избежать распространенных ошибок.

Еще одним важным моментом является оптимизация конфигураций прослушивателей Kafka. Указав KAFKA_ADVERTISED_LISTENERS и KAFKA_LISTENERS в файле Docker Compose, вы разрешаете Kafka рекламировать соответствующие адреса своим клиентам. Такое различие между внутренними и внешними прослушивателями разрешает конфликты, особенно когда рабочие Spark пытаются подключиться из-за пределов сети Docker. Реальным примером этого является панель мониторинга, запрашивающая данные Kafka с хост-компьютера, требующая отдельного внешнего прослушивателя для доступа. 🔧

Наконец, решающее значение имеет реализация надежной обработки ошибок в ваших приложениях Spark. Например, использование повторных попыток и резервных вариантов в конфигурации Kafka позволяет корректно решать временные проблемы с подключением. Добавление `.option("kafka.consumer.max.poll.records", "500")` обеспечивает эффективный поиск данных даже при больших нагрузках. Представьте себе приложение промышленного уровня, отслеживающее цены на акции в режиме реального времени: наличие отказоустойчивых средств обеспечивает бесперебойный поток данных даже во время сбоев в сети. Эти методы вместе составляют основу надежного конвейера обработки данных. 🚀

Общие вопросы о Spark и Kafka в Docker

- Какова цель KAFKA_ADVERTISED_LISTENERS?

- Он указывает объявленные адреса для подключения клиентов Kafka, обеспечивая правильную связь внутри и за пределами сети Docker.

- Как определить собственную сеть в Docker Compose?

- Вы можете добавить сеть в разделе networks ключ и включить его в службы, например `networks: my_network`.

- Почему не удается разрешить DNS в контейнерах Docker?

- Контейнеры могут не узнавать друг друга по имени, если они не являются частью одной сети Docker, которая связывает их DNS.

- Какова роль .option("subscribe", "topic") в Spark Streaming?

- Он подписывается Spark Structured Streaming DataFrame на указанную тему Kafka для приема данных в реальном времени.

- Как повторные попытки могут улучшить интеграцию Kafka-Spark?

- Повторные попытки в конфигурациях, таких как max.poll.records, помогают обрабатывать временные ошибки и обеспечивают согласованную обработку данных.

Упрощение интеграции Spark и Kafka

Настройка Spark и Kafka в Docker может быть сложной задачей, но при правильных конфигурациях она становится выполнимой. Сосредоточьтесь на настройках прослушивателя и конфигурации сети, чтобы избежать проблем с подключением. Убедитесь, что все компоненты, такие как Zookeeper и Kafka, хорошо синхронизированы для обеспечения оптимальной производительности.

Реальные варианты использования, такие как мониторинг финансовых данных или потоков Интернета вещей, подчеркивают важность надежных конфигураций. Инструменты и сценарии, представленные здесь, дадут вам знания, необходимые для преодоления типичных препятствий и построения эффективных конвейеров данных в режиме реального времени. 🛠️

Источники и ссылки

- Об этой статье сообщил официальный представитель Документация по интеграции Apache Spark Kafka , предоставляя подробную информацию о конфигурации и использовании.

- Лучшие практики работы с сетями Docker были взяты из Сетевая документация Docker для обеспечения точных и надежных настроек контейнерной связи.

- Практические примеры и дополнительные настройки Kafka были адаптированы из Репозиторий Docker на GitHub Wurstmeister Kafka .