Výzvy integrácie Spark a Kafka v dockerizovanom prostredí

Stretli ste sa niekedy s problémom s pripojením pri integrácii a maklér Kafka do a Spark Cluster v rámci nastavenia Docker? Nie ste sami! Mnoho vývojárov naráža na prekážky pri nastavovaní komunikácie medzi týmito dvoma výkonnými nástrojmi. 🛠️

Nedávno som sa pustil do vylepšovania svojho Spark Cluster pridaním sprostredkovateľa Kafka na zefektívnenie spracovania údajov v reálnom čase. Narazil som však na prekážku s pretrvávajúcimi časovými limitmi pripojenia a chybami v rozlíšení DNS, čo zmenilo proces na maratón na riešenie problémov. 😅

Tieto problémy pramenili z nesprávne nakonfigurovaných nastavení v konfiguráciách súvisiacich s Docker Compose a Spark Kafka. Napriek tomu, že ste sa riadili niekoľkými návodmi a upravovali mnohé parametre, nepolapiteľná správa „makléř nemusí být dostupný“ pretrvávala, čo ma nechalo zmätené a frustrované.

V tomto článku sa podelím o svoje skúsenosti a ponúknem praktické kroky na vyriešenie problémov s konektivitou medzi pracovníkmi Spark a maklérmi Kafka v prostredí Docker. Počas toho sa naučíte tipy a triky, ako sa týmto nástrahám vyhnúť a zabezpečiť bezproblémovú integráciu. Poďme sa ponoriť! 🚀

| Príkaz | Príklad použitia |

|---|---|

| from_json() | Táto funkcia Spark SQL analyzuje reťazec JSON a vytvorí štruktúrovaný dátový objekt. V príklade sa používa na deserializáciu Kafkových správ na štruktúrované dáta. |

| StructType() | Definuje schému pre spracovanie štruktúrovaných dát. Je to užitočné najmä na definovanie očakávaného formátu správ Kafka. |

| .readStream | Iniciuje streamovanie dátového rámca v Sparku, čo umožňuje nepretržité prijímanie dát z Kafky alebo iných zdrojov streamovania. |

| writeStream | Definuje výstupný režim a umývadlo pre dotaz Spark Structured Streaming. Tu určuje zápis do konzoly v režime pripojenia. |

| bootstrap_servers | Konfiguračný parameter Kafka, ktorý špecifikuje adresu makléra Kafka. Rozhodujúce pre komunikáciu medzi Sparkom a Kafkom. |

| auto_offset_reset | Spotrebiteľské nastavenie Kafka, ktoré určuje, kde začať čítať správy, keď neexistuje žiadny predchádzajúci posun. Možnosť „najskôr“ začína od najstaršej správy. |

| KAFKA_ADVERTISED_LISTENERS | Premenná konfiguračného prostredia Docker Kafka. Špecifikuje inzerované adresy pre klientov Kafka, čím zabezpečuje správnu komunikáciu v rámci siete Docker aj mimo nej. |

| KAFKA_LISTENERS | Konfiguruje sieťové rozhrania, na ktorých maklér Kafka počúva prichádzajúce spojenia. Používa sa tu na oddelenie internej a externej komunikácie. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Definuje bezpečnostné protokoly pre rôznych Kafkových poslucháčov. Mapuje názvy poslucháčov na ich príslušné protokoly, ako je v tomto prípade PLAINTEXT. |

| .awaitTermination() | Metóda Spark Structured Streaming, ktorá blokuje vykonávanie skriptu, kým sa neukončí dotaz na streamovanie, čím sa zabezpečí, že stream beží nepretržite. |

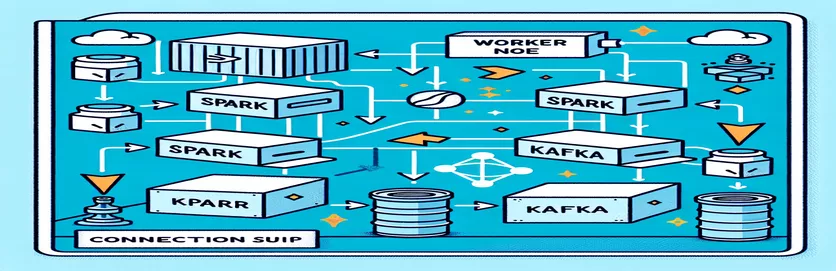

Pochopenie integrácie Spark a Kafka v Dockeri

Prvý scenár sa zameriava na vytvorenie spojenia medzi a Spark Worker a a maklér Kafka. Použitím Spark's Structured Streaming API skript číta dáta z Kafkovej témy v reálnom čase. Začína sa inicializáciou relácie Spark a jej konfiguráciou s požadovaným balíkom Kafka. To je kľúčové, pretože poskytuje potrebnú závislosť pre Spark na bezproblémovú komunikáciu s Kafkom. Príkladom tejto závislosti je balík `org.apache.spark:spark-sql-kafka`, ktorý zabezpečuje kompatibilitu medzi Spark a Kafka v prostredí Docker.

Na spracovanie Kafkových správ skript definuje schému pomocou `StructType`. Táto schéma zabezpečuje, že prichádzajúce správy sú správne analyzované a štruktúrované. Scenáre v reálnom svete často zahŕňajú spracovanie údajov JSON od spoločnosti Kafka. Predstavte si napríklad monitorovací systém kryptomien, kde sa správy obsahujúce aktualizácie cien odosielajú spoločnosti Kafka. Analýza týchto správ do čitateľného formátu uľahčuje spracovanie a analýzu údajov na predpovedanie trendov. 🪙

Konfigurácia Docker Compose zohráva kľúčovú úlohu pri riešení problémov s pripojením. Nastavenia `KAFKA_ADVERTISED_LISTENERS` a `KAFKA_LISTENERS` sú upravené tak, aby odlíšili internú a externú komunikáciu v rámci siete Docker. To zaisťuje, že služby bežiace na rovnakej sieti Docker, ako sú Spark a Kafka, môžu interagovať bez problémov s rozlíšením DNS. Napríklad mapovanie `INSIDE://kafka:9093` umožňuje interným kontajnerom pristupovať ku Kafke, zatiaľ čo `OUTSIDE://localhost:9093` umožňuje pripojenie externých aplikácií, ako sú monitorovacie nástroje.

Druhý skript ukazuje, ako použiť Python `KafkaConsumer` na testovanie Kafkovho spojenia. Ide o jednoduchý, ale účinný prístup, ako zabezpečiť, aby maklér Kafka fungoval správne. Spotrebovaním správ zo zadanej témy môžete overiť, či je dátový tok neprerušený. Predstavte si aplikáciu, v ktorej chce používateľ sledovať údaje o akciovom trhu. Testovanie pripojenia pomocou tohto spotrebiteľského skriptu zaisťuje, že v dôsledku chýb konfigurácie nebudú zmeškané žiadne kritické aktualizácie. Pomocou týchto nástrojov môžete s istotou nasadiť robustné systémy na spracovanie údajov v reálnom čase! 🚀

Riešenie problémov s konektivitou medzi Spark Worker a Kafka Broker

Riešenie 1: Použitie Pythonu na ladenie a riešenie problémov s pripojením v Spark a Kafka s Dockerom

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Ladenie problémov s rozlíšením DNS v Dockerized Kafka

Riešenie 2: Úprava konfigurácie Docker Compose pre správne rozlíšenie DNS

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Testovanie pripojenia Kafka Consumer Connection

Riešenie 3: Python Kafka Consumer na testovanie pripojenia

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Optimalizácia Kafku a Sparku v dockerizovanom prostredí

Kritický aspekt zabezpečenia hladkej komunikácie medzi Kafka Brokers a Spark Workers v Docker efektívne konfiguruje nastavenia siete. Kontajnery Docker fungujú v izolovaných prostrediach, čo často spôsobuje problémy s rozlíšením DNS, keď služby potrebujú interakciu. Ak to chcete vyriešiť, môžete využiť možnosti konfigurácie siete Docker Compose. Napríklad definovanie vlastnej siete ako „moja_sieť“ a prepojenie služieb zaisťuje, že kontajnery sa navzájom rozpoznávajú podľa názvu a nie podľa adresy IP, čo zjednodušuje nastavenie a predchádza bežným nástrahám.

Ďalším dôležitým aspektom je optimalizácia Kafkových konfigurácií poslucháčov. Zadaním `KAFKA_ADVERTISED_LISTENERS` a `KAFKA_LISTENERS` v súbore Docker Compose umožníte spoločnosti Kafka inzerovať vhodné adresy svojim klientom. Toto rozlíšenie medzi internými a externými poslucháčmi rieši konflikty, najmä keď sa Spark Workers pokúšajú pripojiť mimo siete Docker. Príkladom zo skutočného života je monitorovací dashboard, ktorý zisťuje údaje Kafka z hostiteľského počítača a vyžaduje na prístup samostatný externý poslucháč. 🔧

A nakoniec, implementácia robustného spracovania chýb vo vašich aplikáciách Spark je kľúčová. Napríklad využitie opakovaných pokusov a výpadkov v rámci konfigurácie Kafka dokáže elegantne zvládnuť dočasné problémy s pripojením. Pridanie `.option("kafka.consumer.max.poll.records", "500")` zabezpečuje efektívne získavanie údajov aj pri veľkom zaťažení. Predstavte si aplikáciu produkčnej úrovne, ktorá sleduje ceny akcií v reálnom čase – s bezpečnostnými zariadeniami na mieste zaisťuje neprerušovaný tok dát aj počas výpadkov siete. Tieto techniky spolu tvoria chrbticu spoľahlivého potrubia na spracovanie údajov. 🚀

Bežné otázky o Sparkovi a Kafkovi v Dockeri

- Aký je účel KAFKA_ADVERTISED_LISTENERS?

- Špecifikuje inzerované adresy, na ktoré sa môžu klienti Kafka pripojiť, čím sa zabezpečí správna komunikácia v sieti Docker aj mimo nej.

- Ako definujete vlastnú sieť v Docker Compose?

- Môžete pridať sieť pod networks kľúč a zahrnúť ho do služieb, ako napríklad `networks: my_network`.

- Prečo zlyhá rozlíšenie DNS v kontajneroch Docker?

- Kontajnery sa nemusia navzájom rozpoznať podľa názvu, pokiaľ nie sú súčasťou rovnakej siete Docker, ktorá spája ich DNS.

- Aká je úloha .option("subscribe", "topic") v Spark Streaming?

- Prihlási Spark Structured Streaming DataFrame k špecifikovanej Kafkovej téme na príjem údajov v reálnom čase.

- Ako môžu opakované pokusy zlepšiť integráciu Kafka-Spark?

- Opakovania v konfiguráciách, ako napr max.poll.recordspomáhajú zvládnuť prechodné chyby a zabezpečiť konzistentné spracovanie údajov.

Zjednodušenie integrácie Spark a Kafka

Nastavenie Spark a Kafka v Dockeri môže byť zložité, ale so správnymi konfiguráciami sa dá zvládnuť. Zamerajte sa na nastavenia poslucháča a konfigurácie siete, aby ste sa vyhli problémom s pripojením. Zabezpečte, aby boli všetky komponenty ako Zookeeper a Kafka dobre synchronizované pre optimálny výkon.

Skutočné prípady použitia, ako je monitorovanie finančných údajov alebo tokov internetu vecí, zdôrazňujú dôležitosť robustných konfigurácií. Tu zdieľané nástroje a skripty vás vybavia znalosťami na prekonávanie bežných prekážok a budovanie efektívnych dátových kanálov v reálnom čase. 🛠️

Zdroje a odkazy

- O tomto článku informoval úradník Dokumentácia integrácie Apache Spark Kafka , ktorá poskytuje podrobné informácie o konfigurácii a používaní.

- Na osvedčené postupy siete Docker sa odkazovalo z webu Docker Networking Documentation zabezpečiť presné a spoľahlivé nastavenia komunikácie kontajnerov.

- Praktické príklady a ďalšie Kafkove nastavenia boli upravené z Úložisko Wurstmeister Kafka Docker GitHub .