Daniel Marino

26 november 2024

Odpravljanje težav s SparkContext z uporabo UDF-jev Apache Spark za ekstrakcijo funkcij slike

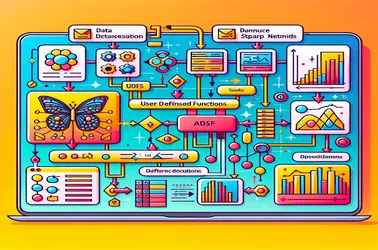

Pri uporabi UDF-jev znotraj Apache Spark za porazdeljene operacije, kot je obdelava modela globokega učenja, je običajno, da naletite na težavo Spark "SparkContext je mogoče uporabiti samo v gonilniku". To se zgodi zaradi stroge gonilne narave SparkContexta, ki nadzoruje distribucijo opravil. S preprečevanjem konfliktov serializacije v porazdeljenih cevovodih za obdelavo slik in zagotavljanjem dostopa do modela brez ponovne inicializacije na vsakem vozlišču nam rešitve, kot so spremenljivke oddajanja, omogočajo skupno rabo modelov z delovnimi vozlišči v učinkovit način. Zmogljivost Spark za obvladovanje zapletenih nalog strojnega učenja v velikem obsegu je močno izboljšana s pristopi oddajanja.