Daniel Marino

26 november 2024

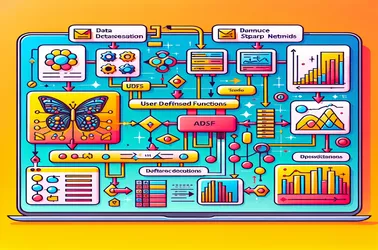

Åtgärda SparkContext-problem med Apache Sparks användning av UDF:er för extraktion av bildfunktioner

När du använder UDF:er inom Apache Spark för distribuerade operationer som bearbetning av djupinlärningsmodeller, är det vanligt att stöta på Sparks problem "SparkContext kan endast användas på föraren". Detta beror på den strikta förarbundna karaktären hos SparkContext, som styr jobbdistributionen. Genom att förhindra serialiseringskonflikter i distribuerade bildbehandlings-pipelines och garantera modellåtkomst utan återinitiering på varje nod, gör lösningar som broadcast-variabler det möjligt för oss att dela modeller med arbetarnoder i en effektivt sätt. Sparks kapacitet att hantera komplicerade maskininlärningsuppgifter i stor skala förbättras avsevärt av broadcast-metoder.