Daniel Marino

26 листопада 2024

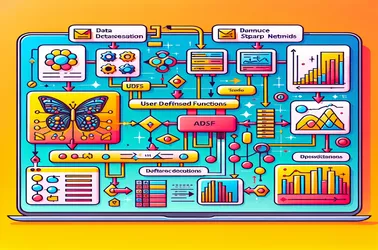

Виправлення проблем SparkContext із використанням Apache Spark UDF для вилучення функцій зображення

Під час використання UDF в Apache Spark для розподілених операцій, таких як обробка моделі глибокого навчання, часто виникає проблема Spark «SparkContext можна використовувати лише в драйвері». Це відбувається через сувору прив’язаність драйвера SparkContext, який контролює розподіл завдань. Запобігаючи конфліктам серіалізації в розподілених конвеєрах обробки зображень і гарантуючи доступ до моделі без повторної ініціалізації на кожному вузлі, такі рішення, як трансляція змінних, дозволяють нам ділитися моделями з робочими вузлами в ефективним способом. Здатність Spark вирішувати складні завдання машинного навчання в масштабі значно покращена завдяки широкомовним підходам.