Проблеми інтеграції Spark і Kafka в докеризоване середовище

Ви коли-небудь стикалися з проблемою підключення під час інтеграції a Кафка Брокер в a Іскровий кластер у налаштуваннях Docker? Ви не самотні! Багато розробників стикаються з перешкодами під час встановлення зв’язку між цими двома потужними інструментами. 🛠️

Нещодавно я взявся за вдосконалення свого Іскровий кластер шляхом додавання брокера Kafka для оптимізації обробки даних у реальному часі. Однак я натрапив на блокпост із постійними тайм-аутами підключення та помилками вирішення DNS, що перетворило процес на марафон усунення несправностей. 😅

Ці проблеми виникли через неправильно налаштовані налаштування в Docker Compose та конфігураціях Spark, пов’язаних із Kafka. Незважаючи на дотримання кількох посібників і налаштування численних параметрів, невловиме повідомлення «брокер може бути недоступний» залишалося, залишаючи мене спантеличеним і розчарованим.

У цій статті я поділюся своїм досвідом і запропоную практичні кроки для вирішення проблем підключення між працівниками Spark і брокерами Kafka в середовищі Docker. Попутно ви дізнаєтесь поради та підказки, щоб уникнути цих пасток і забезпечити бездоганну інтеграцію. Давайте зануримося! 🚀

| Команда | Приклад використання |

|---|---|

| from_json() | Ця функція Spark SQL аналізує рядок JSON і створює об’єкт структурованих даних. У прикладі він використовується для десеріалізації повідомлень Kafka у структуровані дані. |

| StructType() | Визначає схему обробки структурованих даних. Це особливо корисно для визначення очікуваного формату повідомлень Kafka. |

| .readStream | Ініціює потоковий DataFrame у Spark, що дозволяє безперервно приймати дані з Kafka або інших потокових джерел. |

| writeStream | Визначає режим виведення та приймач для запиту Spark Structured Streaming. Тут він визначає запис до консолі в режимі додавання. |

| bootstrap_servers | Параметр конфігурації Kafka, який визначає адресу брокера Kafka. Вирішальне значення для спілкування Spark і Kafka. |

| auto_offset_reset | Налаштування споживача Kafka, яке визначає, з чого починати читати повідомлення, якщо немає попереднього зсуву. Параметр «найраніший» починається з найстарішого повідомлення. |

| KAFKA_ADVERTISED_LISTENERS | Змінна середовища конфігурації Docker Kafka. Він визначає оголошені адреси для клієнтів Kafka, забезпечуючи належний зв’язок у мережі Docker і поза нею. |

| KAFKA_LISTENERS | Налаштовує мережеві інтерфейси, на яких брокер Kafka прослуховує вхідні з’єднання. Використовується тут для розділення внутрішнього та зовнішнього зв’язку. |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | Визначає протоколи безпеки для різних слухачів Kafka. Він відображає імена слухачів на їхні відповідні протоколи, наприклад PLAINTEXT у цьому випадку. |

| .awaitTermination() | Метод Spark Structured Streaming, який блокує виконання сценарію, доки потоковий запит не буде припинено, забезпечуючи безперервну роботу потоку. |

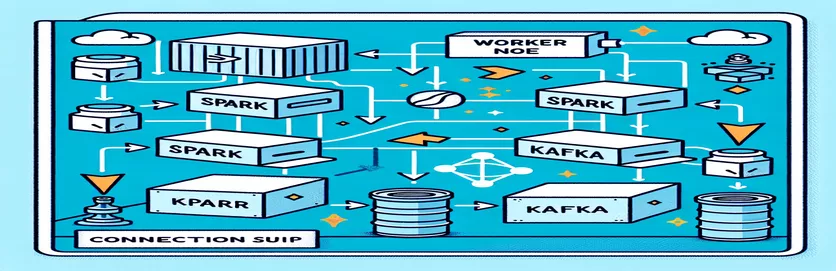

Розуміння інтеграції Spark і Kafka в Docker

Перший сценарій спрямований на встановлення зв’язку між a Spark Worker і а Кафка Брокер. Використовуючи Spark Structured Streaming API, сценарій зчитує дані в реальному часі з теми Kafka. Він починається з ініціалізації сеансу Spark і його налаштування за допомогою необхідного пакета Kafka. Це надзвичайно важливо, оскільки забезпечує необхідну залежність для безперебійного спілкування Spark з Kafka. Прикладом цієї залежності є пакет `org.apache.spark:spark-sql-kafka`, який забезпечує сумісність між Spark і Kafka в середовищі Docker.

Для обробки повідомлень Kafka сценарій визначає схему за допомогою `StructType`. Ця схема забезпечує правильний аналіз і структурування вхідних повідомлень. Сценарії реального світу часто включають обробку даних JSON від Kafka. Наприклад, уявіть систему моніторингу криптовалюти, де Kafka надсилає повідомлення з оновленнями цін. Розбір цих повідомлень у зручний для читання формат полегшує обробку й аналіз даних для прогнозування тенденцій. 🪙

Конфігурація Docker Compose відіграє ключову роль у вирішенні проблем із підключенням. Параметри `KAFKA_ADVERTISED_LISTENERS` і `KAFKA_LISTENERS` налаштовано для розмежування внутрішнього та зовнішнього зв’язку в мережі Docker. Це гарантує, що служби, які працюють в тій самій мережі Docker, наприклад Spark і Kafka, можуть взаємодіяти без проблем із вирішенням DNS. Наприклад, зіставлення `INSIDE://kafka:9093` дозволяє внутрішнім контейнерам отримувати доступ до Kafka, тоді як `OUTSIDE://localhost:9093` дає змогу підключатися зовнішнім програмам, наприклад інструментам моніторингу.

Другий сценарій демонструє, як використовувати Python `KafkaConsumer` для тестування з’єднання Kafka. Це простий, але ефективний підхід для забезпечення правильної роботи брокера Kafka. Використовуючи повідомлення з указаної теми, ви можете перевірити, чи потік даних не переривається. Розглянемо програму, у якій користувач хоче відстежувати дані фондового ринку. Перевірка підключення за допомогою цього сценарію споживача гарантує, що жодне критичне оновлення не буде пропущено через помилки конфігурації. За допомогою цих інструментів ви можете впевнено розгортати надійні системи для обробки даних у реальному часі! 🚀

Вирішення проблем із підключенням між Spark Worker і Kafka Broker

Рішення 1: використання Python для налагодження та вирішення проблем із підключенням у Spark і Kafka з Docker

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

Налагодження проблем вирішення DNS у Dockerized Kafka

Рішення 2: змінення конфігурації Docker Compose для правильного вирішення DNS

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

Тестування Kafka Consumer Connection

Рішення 3: Споживач Python Kafka для тестування з’єднання

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

Оптимізація Kafka та Spark у середовищі Dockerized

Критичний аспект забезпечення безперебійного зв’язку між Брокери Кафки і Spark Workers у Docker ефективно налаштовує параметри мережі. Контейнери Docker працюють в ізольованих середовищах, часто спричиняючи проблеми з вирішенням DNS, коли служби потребують взаємодії. Щоб вирішити цю проблему, ви можете скористатися параметрами конфігурації мережі Docker Compose. Наприклад, визначення спеціальної мережі, як-от `my_network`, і зв’язування служб гарантує, що контейнери розпізнають один одного за іменем, а не за IP-адресою, що спрощує налаштування та уникає поширених пасток.

Іншим важливим фактором є оптимізація конфігурацій слухача Kafka. Вказавши `KAFKA_ADVERTISED_LISTENERS` і `KAFKA_LISTENERS` у вашому файлі Docker Compose, ви дозволяєте Kafka рекламувати відповідні адреси своїм клієнтам. Таке розмежування між внутрішніми та зовнішніми слухачами вирішує конфлікти, особливо коли Spark Workers намагаються підключитися з-за меж мережі Docker. Прикладом цього з реального життя є інформаційна панель моніторингу, яка запитує дані Kafka з хост-комп’ютера, для доступу потрібен окремий зовнішній слухач. 🔧

Нарешті, впровадження надійної обробки помилок у ваших програмах Spark має вирішальне значення. Наприклад, використання повторних спроб і резервних копій у конфігурації Kafka може витончено вирішити тимчасові проблеми з підключенням. Додавання `.option("kafka.consumer.max.poll.records", "500")` забезпечує ефективне отримання даних навіть за великих навантажень. Уявіть собі програму виробничого рівня, яка відстежує ціни акцій у режимі реального часу — наявність відмовостійкості забезпечує безперебійний потік даних навіть під час збоїв у мережі. Ці методи разом утворюють основу надійного конвеєра обробки даних. 🚀

Поширені запитання про Spark і Kafka у Docker

- Яка мета KAFKA_ADVERTISED_LISTENERS?

- Він визначає оголошені адреси для підключення клієнтів Kafka, забезпечуючи належний зв’язок у мережі Docker та поза нею.

- Як визначити спеціальну мережу в Docker Compose?

- Ви можете додати мережу під networks ключ і включити його в служби, наприклад `networks: my_network`.

- Чому не вдається розділити DNS у контейнерах Docker?

- Контейнери можуть не розпізнавати один одного за назвою, якщо вони не є частиною однієї мережі Docker, яка пов’язує їхні DNS.

- Яка роль .option("subscribe", "topic") у Spark Streaming?

- Він підписує Spark Structured Streaming DataFrame на вказану тему Kafka для отримання даних у реальному часі.

- Як повторні спроби можуть покращити інтеграцію Kafka-Spark?

- Повторні спроби в конфігураціях, наприклад max.poll.records, допомагають обробляти тимчасові помилки та забезпечують послідовну обробку даних.

Спрощення інтеграції Spark і Kafka

Налаштування Spark і Kafka в Docker може бути складним, але з правильними конфігураціями це стає керованим. Зосередьтеся на налаштуваннях слухача та мережевих конфігураціях, щоб уникнути проблем із підключенням. Переконайтеся, що всі компоненти, такі як Zookeeper і Kafka, добре синхронізовані для оптимальної продуктивності.

Реальні випадки використання, такі як моніторинг фінансових даних або потоків Інтернету речей, підкреслюють важливість надійних конфігурацій. Інструменти та сценарії, надані тут, допоможуть вам подолати типові перешкоди та побудувати ефективні канали даних у реальному часі. 🛠️

Джерела та література

- Про це повідомив чиновник Документація інтеграції Apache Spark Kafka , надаючи детальну інформацію про конфігурацію та використання.

- Посилання на найкращі методи роботи з мережею Docker наведено в Мережева документація Docker щоб забезпечити точні та надійні налаштування зв’язку контейнера.

- Практичні приклади та додаткові налаштування Kafka були адаптовані з Wurstmeister Kafka Docker GitHub Repository .