Проблеми розміщення віртуальної голови для розробки AR

Робота над проектом доповненої реальності (AR) може бути одночасно захоплюючою та складною. Розробляючи програму для Android за допомогою Unity, я прагнув бездоганно поєднати цифровий і реальний світи, розмістивши віртуальну голову над реальними обличчями. Ця функція значною мірою залежить від точності, щоб створити захоплюючий досвід. 🕶️

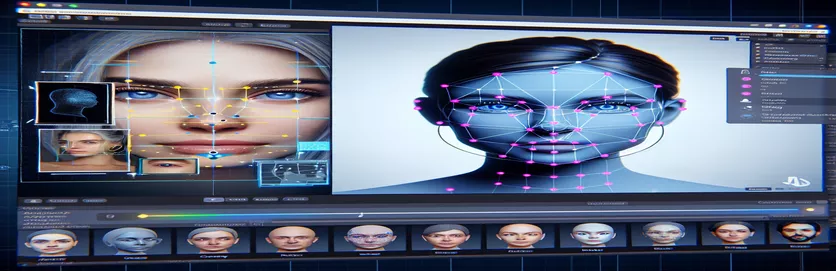

Щоб досягти цього, я використовував MediaPipe від Google для виявлення орієнтирів обличчя, таких як очі, ніс і рот. Потім на основі цих ключових моментів було створено та розміщено віртуальну голову. Було захоплююче побачити, як сучасні інструменти можуть трансформувати можливості AR, але ця подорож була далекою від ідеальної.

Проблема виникла, коли віртуальна голова не збігалася з реальним обличчям, як очікувалося. Незалежно від ракурсу чи пристрою, розміщення завжди було трохи «зміщеним», що призводило до неприродного ефекту. Віртуальне уявлення ніби було відірване від реальності. Це викликало серію експериментів з усунення несправностей.

Від налаштування налаштувань камери Unity до експериментів з алгоритмом MediaPipe кожна спроба приносила поступові покращення, але не приносила остаточного рішення. У цій статті розглядається суть проблеми, отримані уроки та потенційні рішення для розробників, які стикаються з подібними проблемами. 🚀

| Команда | Приклад використання |

|---|---|

| mainCamera.usePhysicalProperties | Ця команда дозволяє використовувати фізичні властивості камери Unity, дозволяючи точніше контролювати фокусну відстань і спотворення об’єктива для вирівнювання віртуальних і реальних об’єктів. |

| faceMesh.GetDetectedFaceTransform() | Отримує дані перетворення (положення та обертання) виявленого обличчя з сітки обличчя MediaPipe, що має вирішальне значення для точного розміщення віртуальних голов над реальними обличчями. |

| UnityObjectToClipPos | Спеціальна функція шейдера, яка перетворює позицію вершини з простору об’єкта в простір відсікання, яка використовується в шейдерах корекції спотворення лінз для забезпечення вирівнювання. |

| tex2D | Команда шейдера, яка використовується для вибірки текстури в заданих УФ-координатах, необхідна для застосування корекції спотворень до каналів камери. |

| length(distUV) | Обчислює евклідову відстань УФ-координат від початку координат, яка використовується для поступового коригування спотворення лінзи. |

| adjuster.virtualHead | Змінна сценарію, яка посилається на віртуальну голову GameObject, що дозволяє динамічно оновлювати її позицію та обертання на основі даних відстеження обличчя. |

| [TestFixture] | Атрибут NUnit, який позначає клас як тестовий фікстур, сигналізуючи про те, що він містить модульні тести. Це корисно для перевірки логіки вирівнювання віртуальної головки. |

| Assert.AreEqual | Метод NUnit, який використовується для порівняння очікуваних і фактичних значень під час модульного тестування, гарантуючи, що розміщення віртуальної голови відповідає бажаним результатам. |

| _DistortionStrength | Властивість шейдера, яка регулює інтенсивність спотворення лінзи, точно налаштовуючи вирівнювання між реальним і віртуальним світами. |

| Quaternion.Euler | Створює поворот на основі кутів Ейлера, який зазвичай використовується для вирівнювання об’єктів, як-от віртуальна голова, у 3D-просторі Unity. |

Підвищення точності AR за допомогою Unity та MediaPipe

Перший сценарій, який ми дослідили, зосереджений на використанні фізичних властивостей камери Unity. Увімкнувши usePhysicalProperties, ми налаштовуємо поведінку камери, щоб вона точніше відповідала реальній оптиці. Це особливо важливо під час роботи з доповненою реальністю, де навіть незначні розбіжності у фокусній відстані чи полі зору можуть призвести до того, що віртуальні об’єкти виглядатимуть зміщеними. Наприклад, установивши фокусну відстань на точне значення, наприклад 35 мм, можна вирівняти віртуальну голову з виявленим обличчям. Це налаштування схоже на тонке налаштування телескопа, щоб привести віддалені об’єкти в ідеальний фокус, забезпечуючи відчуття природності та ефекту доповненої реальності. 📸

Іншим важливим компонентом сценарію є отримання положення та обертання виявленого обличчя за допомогою faceMesh.GetDetectedFaceTransform(). Ця функція забезпечує оновлення в режимі реального часу від сітки обличчя MediaPipe, яка є важливою для синхронізації віртуальної голови з рухами користувача. Уявіть собі, що ви граєте у відеогру, де голова вашого персонажа не рухається синхронно з вашою; досвід був би жахливим. Забезпечуючи точне вирівнювання, цей сценарій перетворює AR з новинки на інструмент, який може підтримувати такі програми, як віртуальні зустрічі або розширені ігри.

Другий сценарій заглиблюється в програмування шейдерів, зокрема вирішуючи спотворення лінзи. Шейдер виправляє спотворення в каналі камери, використовуючи такі властивості, як _DistortionStrength, щоб маніпулювати тим, як УФ-координати відображаються на текстурі. Це особливо корисно при роботі з ширококутними об’єктивами або камерами з унікальними профілями спотворення. Наприклад, якщо віртуальна голова виглядає більшою або меншою за реальне обличчя залежно від кута, налаштування параметрів спотворення гарантує краще вирівнювання. Це схоже на налаштування рами дзеркала, щоб усунути ефект веселого будинку, зробивши відображення більш реалістичними. 🎨

Нарешті, модульні тести з третього сценарію перевіряють рішення. Ці тести порівнюють очікуване положення та обертання віртуальної голови з фактичними результатами, гарантуючи, що коригування витримуються за різних умов. Використання NUnit Assert.AreEqual, розробники можуть симулювати різні сценарії, як-от швидке переміщення голови або нахил її під надзвичайними кутами, щоб підтвердити вирівнювання. Наприклад, під час розробки я помітив, що вирівнювання працювало добре, коли дивився вперед, але дрейфував, коли голова поверталася набік. Ці модульні тести висвітлили проблему та скерували подальші вдосконалення, підкресливши важливість ретельного тестування для створення надійних програм AR. 🚀

Налаштування розміщення віртуальних об’єктів у AR за допомогою Unity та MediaPipe

Рішення 1: використання фізичної камери Unity для налаштування кута огляду та спотворення об’єктива

// Import necessary Unity librariesusing UnityEngine;using Mediapipe.Unity;public class VirtualHeadAdjuster : MonoBehaviour{public Camera mainCamera; // Assign Unity's physical camerapublic GameObject virtualHead; // Assign the virtual head prefabprivate MediapipeFaceMesh faceMesh; // MediaPipe's face mesh componentvoid Start(){// Enable Unity's physical cameramainCamera.usePhysicalProperties = true;mainCamera.focalLength = 35f; // Set a standard focal length}void Update(){if (faceMesh != null && faceMesh.IsTracking){// Update the virtual head's position and rotationTransform detectedHead = faceMesh.GetDetectedFaceTransform();virtualHead.transform.position = detectedHead.position;virtualHead.transform.rotation = detectedHead.rotation;}}}

Вивчення альтернативних коригувань для віртуального вирівнювання голови

Рішення 2. Використання спеціального шейдера для виправлення спотворення лінзи

Shader "Custom/LensDistortionCorrection"{Properties{_DistortionStrength ("Distortion Strength", Float) = 0.5}SubShader{Pass{CGPROGRAM#pragma vertex vert#pragma fragment fragfloat _DistortionStrength;struct appdata{float4 vertex : POSITION;float2 uv : TEXCOORD0;};struct v2f{float4 pos : SV_POSITION;float2 uv : TEXCOORD0;};v2f vert (appdata v){v2f o;o.pos = UnityObjectToClipPos(v.vertex);o.uv = v.uv;return o;}fixed4 frag (v2f i) : SV_Target{float2 distUV = i.uv - 0.5;distUV *= 1.0 + _DistortionStrength * length(distUV);distUV += 0.5;return tex2D(_MainTex, distUV);}ENDCG}}}

Тестування покращеної сумісності в проектах AR Unity

Рішення 3: Реалізація модульних тестів для вирівнювання віртуальної головки

using NUnit.Framework;using UnityEngine;using Mediapipe.Unity;[TestFixture]public class VirtualHeadAlignmentTests{private VirtualHeadAdjuster adjuster;private GameObject testHead;[SetUp]public void Init(){GameObject cameraObject = new GameObject("MainCamera");adjuster = cameraObject.AddComponent<VirtualHeadAdjuster>();testHead = new GameObject("VirtualHead");adjuster.virtualHead = testHead;}[Test]public void TestVirtualHeadAlignment(){Vector3 expectedPosition = new Vector3(0, 1, 2);Quaternion expectedRotation = Quaternion.Euler(0, 45, 0);adjuster.virtualHead.transform.position = expectedPosition;adjuster.virtualHead.transform.rotation = expectedRotation;Assert.AreEqual(expectedPosition, testHead.transform.position);Assert.AreEqual(expectedRotation, testHead.transform.rotation);}}

Покращення розміщення AR за допомогою вдосконалених методів калібрування

Одним із аспектів, який часто забувають про проблеми з вирівнюванням AR, є важливість калібрування камери. У проектах доповненої реальності, як-от розміщення віртуальної голови над реальною, лінзою внутрішні параметри грають життєво важливу роль. Ці параметри включають фокусну відстань, оптичний центр і коефіцієнти спотворення. Якщо ці значення неточні, віртуальна голова може виглядати неправильно або спотворено. Щоб вирішити цю проблему, інструменти калібрування можна використовувати для обчислення цих параметрів для конкретної камери пристрою. Наприклад, таке програмне забезпечення, як OpenCV, пропонує надійні утиліти калібрування для створення точних матриць камер і профілів спотворень. 📐

Інший підхід передбачає використання Unity стек постобробки. Застосовуючи такі ефекти, як глибина різкості або корекція хроматичної аберації, ви можете згладити розбіжності між відтвореною віртуальною головою та реальним середовищем. Постобробка додає шар полірування, який усуває розрив між віртуальними об’єктами та фізичними просторами. Наприклад, легкий ефект розмиття може зменшити різкі краї, які роблять помітними нерівності. Це особливо корисно в захоплюючих програмах, де користувачі зосереджені на сцені.

Нарешті, не варто недооцінювати силу динамічної адаптації під час виконання. Включення моделей машинного навчання у ваш конвеєр AR може дозволити системі навчатися та коригувати розміщення з часом. Наприклад, модель ШІ може аналізувати відгуки користувачів або виявлені невідповідності та динамічно налаштовувати вирівнювання. Це робить систему більш надійною та здатною справлятися з варіаціями освітлення, продуктивності пристрою чи поведінки користувача. Ці вдосконалення забезпечують бездоганний досвід доповненої реальності, завдяки чому віртуальний і реальний світи справді інтегруються. 🚀

Поширені запитання про розміщення MediaPipe і Unity AR

- Чому моя віртуальна голова зміщена з реальним обличчям?

- Проблема часто виникає через неправильне калібрування камери. Використання таких інструментів, як OpenCV, для обчислення camera matrix і distortion coefficients може значно покращити вирівнювання.

- Яка роль фокусної відстані в AR-вирівнюванні?

- The focal length визначає, як камера проектує 3D-точки на 2D-площину. Налаштування його в налаштуваннях фізичної камери Unity може підвищити точність.

- Чи може Unity впоратися з корекцією викривлення об’єктива?

- Так, Unity підтримує шейдери для виправлення спотворень. Реалізуйте шейдер із такими властивостями, як _DistortionStrength щоб налаштувати корекцію на основі профілю вашого об’єктива.

- Як я можу перевірити вирівнювання віртуальних об'єктів?

- Використання модульних тестів у NUnit із такими командами, як Assert.AreEqual дозволяє перевіряти позиціонування та обертання віртуальних об’єктів за різних умов.

- Чи потрібна постобробка для проектів AR?

- Хоча це не є обов’язковим, такі ефекти постобробки depth of field і chromatic aberration може покращити візуальну якість і реалістичність сцен AR.

- Чи може MediaPipe виявляти об’єкти, крім облич?

- Так, MediaPipe пропонує рішення для рук, поз і навіть цілісного відстеження, що робить його універсальним для різних випадків використання AR.

- Яке обладнання найкраще працює для програм Unity AR?

- Ідеально підходять пристрої з високопродуктивними графічними процесорами та точними камерами. Такі інструменти, як ARCore і ARKit додатково покращити сумісність.

- Чому під певними кутами вирівнювання гірше?

- Це може статися через невідповідність поля зору між камерою та віртуальним середовищем. Налаштування камери Unity fieldOfView власність може допомогти.

- Як шейдери покращують вирівнювання AR?

- Шейдери дозволяють коригувати рендеринг у режимі реального часу, наприклад виправляти спотворення або імітувати ефекти лінз, забезпечуючи кращу синхронізацію між віртуальними та реальними об’єктами.

- Чи можуть системи AR саморегулюватися з часом?

- Так, інтеграція моделей машинного навчання дозволяє системам динамічно адаптуватися, навчаючись на основі зворотного зв’язку, щоб з часом покращувати узгодженість і продуктивність.

Підвищення точності AR: останні думки

Досягнення точного узгодження між об’єктами віртуального та реального світу має вирішальне значення для захоплюючого досвіду AR. За допомогою ретельного калібрування та передових технологій можна пом’якшити такі проблеми, як викривлення об’єктива та невідповідність фокусної відстані, забезпечуючи кращу точність і задоволення користувачів.

Інтеграція інструментів Unity, алгоритмів MediaPipe і динамічних налаштувань пропонує надійні рішення для розробників AR. Ці вдосконалення забезпечують плавне поєднання цифрового та фізичного світів, відкриваючи нові можливості для ігор, віртуальних зустрічей тощо. Завдяки наполегливості та інноваціям проблеми з узгодженням AR стають керованими. 🚀

Джерела та література

- Докладні відомості про використання MediaPipe в Unity наведені в офіційній документації MediaPipe. Дослідіть це тут .

- Інструкції щодо калібрування камери та фізичних властивостей Unity можна знайти на сайті документації Unity. Відвідайте Налаштування камери Unity для більш детальної інформації.

- Програмування шейдерів для додатків AR і корекції спотворень лінз було натхнено статтями про розробку шейдерів, наприклад, на Котяче кодування .

- Можливості та обмеження ARCore для розробки Android було розглянуто на сайті розробників ARCore Google. Дізнайтесь більше на Google ARCore .