CNNs میں مکمل طور پر منسلک پرتوں کو ختم کرنا

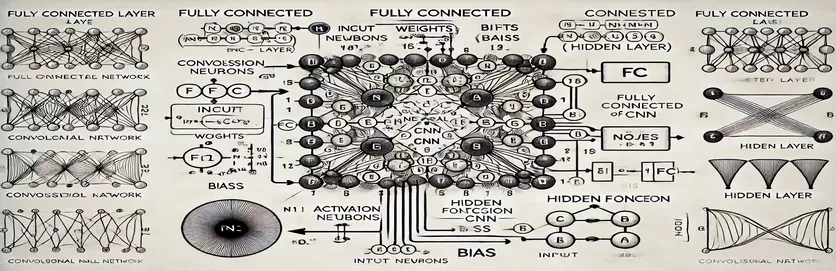

Convolutional Neural Network (CNN) میں مکمل طور پر منسلک (FC) پرت کے کام کو سمجھنا ایک راز کھولنے جیسا محسوس کر سکتا ہے۔ بہت سے لوگوں کے لیے، پیچیدگی حساب کے عمل میں ہے اور یہ کہ پوشیدہ پرت میں سے ایک نوڈ کیسے اخذ کیا جاتا ہے۔ روایتی مصنوعی اعصابی نیٹ ورکس (ANNs) کے برعکس، CNNs میں FC پرت میں باریکیاں ہوتی ہیں جو اکثر ٹیوٹوریلز میں غیر واضح ہوتی ہیں۔ اگر آپ اس کے بارے میں حیران ہیں، تو آپ اکیلے نہیں ہیں!

بہت سے وسائل اس موضوع پر چھیڑ چھاڑ کرتے ہیں، سیکھنے والوں کو واضح رہنمائی کے بغیر چھوڑ دیتے ہیں۔ ٹیوٹوریلز اکثر نامکمل وضاحتوں کو ری سائیکل کرتے ہیں، جو وضاحت کے خواہاں افراد کی مایوسی میں اضافہ کرتے ہیں۔ اگر آپ نے خود کو بار بار جوابات تلاش کرتے ہوئے پایا ہے، تو آپ صحیح جگہ پر ہیں۔ 🧩

اس گائیڈ میں، ہم FC پرت کی پوشیدہ پرت سے ایک نوڈ کا حساب لگانے پر توجہ مرکوز کریں گے۔ ایک بار جب آپ ایک نوڈ کے طریقہ کار کو سمجھ لیں گے، تو آپ باقی سے نمٹنے کے لیے لیس ہو جائیں گے۔ اس عمل کو واضح، قابل عمل اقدامات میں توڑ کر، آپ کسی بھی FC تہہ کے حساب کتاب کو نیویگیٹ کرنے کا اعتماد حاصل کر لیں گے۔

متعلقہ مثالوں اور سیدھے سادے خاکے کا استعمال کرتے ہوئے، ہم FC تہہ میں ان پٹ سے آؤٹ پٹس تک کے راستے کو روشن کریں گے۔ الجھن کو الوداع کہو اور سمجھنے کو ہیلو کہو- آئیے اندر غوطہ لگائیں! 🚀

| حکم | استعمال کی مثال |

|---|---|

| np.dot() | دو صفوں کے درمیان ڈاٹ پروڈکٹ کو انجام دیتا ہے۔ مکمل طور پر منسلک پرت میں نوڈ کے لیے ان پٹ اور وزن کے وزنی مجموعہ کا حساب لگانے کے لیے یہاں استعمال کیا جاتا ہے۔ |

| np.maximum() | حسابی آؤٹ پٹ اور صفر کے درمیان زیادہ سے زیادہ قدر کو منتخب کر کے ReLU ایکٹیویشن فنکشن کا اطلاق کرتا ہے۔ |

| torch.tensor() | PyTorch میں ٹینسر بناتا ہے۔ ٹینسرز گہری سیکھنے کے فریم ورک میں ڈیٹا کی نمائندگی کے لیے بنیادی عمارت ہیں۔ |

| torch.matmul() | PyTorch میں میٹرکس ضرب انجام دیتا ہے۔ ان پٹ اور وزن کے درمیان ڈاٹ پروڈکٹ کا حساب لگانے کے لیے استعمال کیا جاتا ہے۔ |

| torch.nn.functional.relu() | ٹینسر میں تمام منفی قدروں کو صفر پر سیٹ کرتے ہوئے، PyTorch میں ReLU ایکٹیویشن فنکشن کا اطلاق کرتا ہے۔ |

| np.testing.assert_array_almost_equal() | ایک مخصوص رواداری کے اندر برابری کے لیے عنصر کے لحاظ سے دو صفوں کا موازنہ کرتا ہے۔ عددی کارروائیوں میں آؤٹ پٹ درستگی کی جانچ کے لیے مفید ہے۔ |

| unittest.TestCase | ٹیسٹ کیسز بنانے کے لیے یونٹسٹ ماڈیول میں ایک بیس کلاس۔ Python میں یونٹ ٹیسٹ کی ساخت اور ترتیب دینے کے لیے استعمال کیا جاتا ہے۔ |

| np.array() | NumPy میں ایک صف بناتا ہے۔ صفوں کا استعمال مکمل طور پر منسلک پرت کے حسابات میں ان پٹ، وزن، اور تعصبات کی نمائندگی کرنے کے لیے کیا جاتا ہے۔ |

| torch.matmul() | میٹرکس ضرب کے لیے PyTorch کا فنکشن، نیورل نیٹ ورکس میں آؤٹ پٹ کا حساب لگانے کے لیے اہم۔ |

| unittest.main() | اسکرپٹ میں بیان کردہ تمام ٹیسٹ کیسز چلاتا ہے۔ لاگو کردہ حلوں کی درستگی اور وشوسنییتا کی توثیق کے لیے ضروری ہے۔ |

مکمل طور پر منسلک پرت کے حسابات کو توڑنا

فراہم کردہ اسکرپٹس کا مقصد یہ ظاہر کرنا ہے کہ a میں نوڈ کیسے ہوتا ہے۔ مکمل طور پر منسلک (FC) CNN کی پرت پچھلی پرت سے ڈیٹا پر کارروائی کرتی ہے۔ یہ پرتیں وزنی لنکس اور تعصبات کا استعمال کرتے ہوئے ہر ان پٹ کو ہر نوڈ سے جوڑتی ہیں، جو انہیں تصویر کی درجہ بندی جیسے کاموں کے لیے ضروری بناتی ہیں۔ پہلا اسکرپٹ استعمال کرتے ہوئے ایک نوڈ کے آؤٹ پٹ کا حساب لگاتا ہے۔ NumPy. ان پٹ کی قدروں کو ان کے متعلقہ وزن کے ساتھ ضرب دینے اور تعصب کو شامل کرنے سے، نوڈ آؤٹ پٹ حاصل کیا جاتا ہے۔ اس آؤٹ پٹ کو پھر ایکٹیویشن فنکشن (مثال کے طور پر، ReLU) سے گزر کر غیر خطوطی کو متعارف کرایا جاتا ہے۔ مثال کے طور پر، ایک تصویر کی پکسل ویلیو کو ان پٹ کے طور پر تصور کریں۔ وزن سیکھے ہوئے فلٹرز کی نمائندگی کر سکتے ہیں جو تصویر سے معنی خیز خصوصیات نکالتے ہیں۔ 🖼️

دوسرا اسکرپٹ متعدد نوڈس کے حساب کتاب کو عام کرتا ہے۔ یہ میٹرکس ضرب کا استعمال کرتا ہے، جہاں وزن کو 2D میٹرکس اور ان پٹ کو ویکٹر کے طور پر دکھایا جاتا ہے۔ یہ موثر نقطہ نظر تہہ میں موجود تمام نوڈس کے لیے بیک وقت گنتی کی اجازت دیتا ہے۔ تعصبات کو شامل کرنے اور ReLU ایکٹیویشن فنکشن کو لاگو کرنے سے، پرت کے حتمی نتائج پیدا ہوتے ہیں۔ یہ طریقہ انتہائی قابل توسیع ہے اور جدید گہری سیکھنے کے فریم ورک میں ایک بنیادی عمل ہے۔ مثال کے طور پر، چہرے کی شناخت کے نظام میں، اس عمل سے اس بات کا تعین کرنے میں مدد مل سکتی ہے کہ آیا دریافت شدہ شکل انسانی چہرے سے ملتی ہے۔ 😊

جیسے گہری سیکھنے والی لائبریریوں کے ساتھ کام کرنے والوں کے لیے پائی ٹارچ، تیسرا اسکرپٹ یہ ظاہر کرتا ہے کہ ٹینسر اور بلٹ ان فنکشنز کو ایک ہی حساب کو حاصل کرنے کے لیے کیسے استعمال کیا جائے۔ PyTorch کی لچک اور بلٹ ان آپٹیمائزیشن اسے نیورل نیٹ ورکس کی تعمیر اور تربیت کے لیے مثالی بناتی ہے۔ اسکرپٹ سے پتہ چلتا ہے کہ کس طرح ان پٹ، وزن، اور تعصب کو بطور ٹینسر کی وضاحت کرنا ہے اور میٹرکس ضرب کو torch.matmul() فنکشن یہ خاص طور پر بڑے ڈیٹا سیٹس پر CNNs کی تربیت کے لیے آخر سے آخر تک پائپ لائنز بنانے کے لیے مفید ہے، جیسے کہ جنگلی حیات کی تصویروں میں جانوروں کی شناخت کرنا۔

آخر میں، یونٹ ٹیسٹ اسکرپٹ اس بات کو یقینی بناتا ہے کہ تمام نفاذات مختلف حالات میں صحیح طریقے سے کام کرتے ہیں۔ کا استعمال کرتے ہوئے اتحاد لائبریری، یہ حسابات کی عددی درستگی کی تصدیق کرتی ہے اور اس بات کی تصدیق کرتی ہے کہ نتائج متوقع نتائج پر پورا اترتے ہیں۔ یہ قدم ڈیبگنگ اور قابل اعتمادی کو یقینی بنانے کے لیے بہت اہم ہے، خاص طور پر جب CNNs کو حقیقی دنیا کی ایپلی کیشنز جیسے طبی تصویر کے تجزیہ میں تعینات کیا جائے۔ ان اسکرپٹس اور وضاحتوں کے ساتھ، اب آپ کے پاس CNNs میں FC تہوں کو اعتماد کے ساتھ سمجھنے اور لاگو کرنے کا ایک واضح راستہ ہے۔ 🚀

مکمل طور پر منسلک پرت میں نوڈ کے حساب کتاب کو سمجھنا

میٹرکس کیلکولیشنز کے لیے Python پر مبنی حل NumPy کا فائدہ اٹھاتا ہے۔

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layer (e.g., from previous convolutional layers)inputs = np.array([0.5, 0.8, 0.2]) # Example inputs# Define weights for the first node in the hidden layerweights_node1 = np.array([0.4, 0.7, 0.3])# Define bias for the first nodebias_node1 = 0.1# Calculate the output for node 1node1_output = np.dot(inputs, weights_node1) + bias_node1# Apply an activation function (e.g., ReLU)node1_output = max(0, node1_output)# Print the resultprint(f"Output of Node 1: {node1_output}")

مکمل طور پر منسلک تہوں میں نوڈ کیلکولیشن کو عام کرنا

پوشیدہ پرت میں تمام نوڈس کا حساب لگانے کے لیے ازگر پر مبنی حل

# Import necessary libraryimport numpy as np# Define inputs to the fully connected layerinputs = np.array([0.5, 0.8, 0.2])# Define weights matrix (rows: nodes, columns: inputs)weights = np.array([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2# Define bias for each nodebiases = np.array([0.1, 0.2])# Calculate outputs for all nodesoutputs = np.dot(weights, inputs) + biases# Apply activation function (e.g., ReLU)outputs = np.maximum(0, outputs)# Print the resultsprint(f"Outputs of Hidden Layer: {outputs}")

مکمل طور پر منسلک پرت میں نوڈ کیلکولیشن کے لیے PyTorch کا استعمال

گہری سیکھنے کے شوقین افراد کے لیے PyTorch کے ساتھ نفاذ

# Import PyTorchimport torch# Define inputs as a tensorinputs = torch.tensor([0.5, 0.8, 0.2])# Define weights and biasesweights = torch.tensor([[0.4, 0.7, 0.3], # Node 1[0.2, 0.9, 0.5]]) # Node 2biases = torch.tensor([0.1, 0.2])# Calculate outputsoutputs = torch.matmul(weights, inputs) + biases# Apply ReLU activationoutputs = torch.nn.functional.relu(outputs)# Print resultsprint(f"Outputs of Hidden Layer: {outputs}")

یونٹ ٹیسٹ کے ساتھ ہر حل کی جانچ کریں۔

نفاذ کی درستگی کو یقینی بنانے کے لیے ازگر پر مبنی یونٹ ٹیسٹ

# Import unittest libraryimport unittest# Define the test case classclass TestNodeCalculation(unittest.TestCase):def test_single_node(self):inputs = np.array([0.5, 0.8, 0.2])weights_node1 = np.array([0.4, 0.7, 0.3])bias_node1 = 0.1expected_output = max(0, np.dot(inputs, weights_node1) + bias_node1)self.assertEqual(expected_output, 0.86)def test_multiple_nodes(self):inputs = np.array([0.5, 0.8, 0.2])weights = np.array([[0.4, 0.7, 0.3],[0.2, 0.9, 0.5]])biases = np.array([0.1, 0.2])expected_outputs = np.maximum(0, np.dot(weights, inputs) + biases)np.testing.assert_array_almost_equal(expected_outputs, np.array([0.86, 0.98]))# Run the testsif __name__ == "__main__":unittest.main()

CNNs میں مکمل طور پر منسلک تہوں کی اہمیت کو کھولنا

مکمل طور پر جڑی ہوئی (FC) پرتیں convolutional تہوں سے اخذ کردہ خصوصیات کو حتمی پیشین گوئیوں میں تبدیل کرنے میں اہم کردار ادا کرتی ہیں۔ وہ ہر ان پٹ کو ہر آؤٹ پٹ سے جوڑ کر کام کرتے ہیں، سیکھی ہوئی خصوصیات کی گھنی میپنگ فراہم کرتے ہیں۔ ارتعاشی تہوں کے برعکس جو کہ مقامی درجہ بندی پر توجہ مرکوز کرتی ہیں، ایف سی پرتیں تصویر میں اشیاء کی شناخت جیسے فیصلے کرنے کے لیے اس معلومات کو جمع کرتی ہیں۔ مثال کے طور پر، سیلف ڈرائیونگ کار کے امیج ریکگنیشن سسٹم میں، ایف سی پرت اس بات کا تعین کر سکتی ہے کہ آیا کوئی پائی جانے والی چیز پیدل چلنے والوں کی ہے یا سڑک کی علامت۔ 🚗

ایک پہلو جو FC تہوں کو الگ کرتا ہے وہ ہے تربیت کے دوران سیکھے گئے نمونوں کو عام کرنے کی ان کی صلاحیت۔ یہ خاصیت نادیدہ ڈیٹا سے نمٹنے کے وقت اہم ہے۔ پرت میں ہر نوڈ وزن اور تعصبات کے انوکھے امتزاج کی نمائندگی کرتا ہے، جو اسے مخصوص نمونوں یا کلاسوں کو پہچاننے میں مہارت حاصل کرنے کے قابل بناتا ہے۔ یہی وجہ ہے کہ FC تہوں کی ساخت اکثر ماڈل کی مجموعی درستگی کا تعین کرتی ہے۔ مثال کے طور پر، ہاتھ سے لکھے ہندسے کی شناخت کے ماڈل میں، FC پرت پکسل پیٹرن کو عددی پیشین گوئیوں (0-9) میں یکجا کرتی ہے۔ ✍️

اگرچہ FC پرتیں اپنے گھنے کنکشن کی وجہ سے کمپیوٹیشنل طور پر مہنگی ہوتی ہیں، لیکن وہ ان کاموں کے لیے ضروری رہتی ہیں جن میں تفصیلی درجہ بندی کی ضرورت ہوتی ہے۔ ڈراپ آؤٹ جیسی جدید تکنیکوں کو اوور فٹنگ کو روک کر اپنی کارکردگی کو بہتر بنانے کے لیے استعمال کیا جاتا ہے۔ تربیت کے دوران فعال نوڈس کی تعداد کو کم کرکے، ڈراپ آؤٹ اس بات کو یقینی بناتا ہے کہ FC تہہ مضبوط خصوصیات سیکھے، جس سے یہ چہرے کی شناخت اور طبی تصویر کی تشخیص جیسی ایپلی کیشنز میں ناگزیر ہے۔

مکمل طور پر منسلک تہوں کے بارے میں عام سوالات

- CNNs میں مکمل طور پر منسلک پرت کا بنیادی کام کیا ہے؟

- FC تہہ تمام ان پٹ کو آؤٹ پٹ سے جوڑتی ہے، حتمی پیشین گوئیوں کے لیے خصوصیات کو جمع کرتی ہے۔ یہ خصوصیت کے نقشوں کو قابل عمل نتائج میں تبدیل کرنے کی کلید ہے۔

- FC تہوں میں وزن اور تعصب کیسے شروع کیے جاتے ہیں؟

- وزن اکثر تصادفی طور پر شروع کیا جاتا ہے یا زیویئر انیشیلائزیشن جیسی تکنیکوں کا استعمال کرتے ہوئے کیا جاتا ہے، جبکہ تعصب عام طور پر سادگی کے لیے صفر سے شروع ہوتا ہے۔

- ReLU ایکٹیویشن ایف سی لیئر کی کارکردگی کو کیسے بہتر بناتا ہے؟

- ReLU منفی آؤٹ پٹس کو صفر پر سیٹ کر کے غیر لکیری کا اطلاق کرتا ہے۔ یہ غائب ہونے والے گریڈینٹ کو روکتا ہے، جس سے ماڈل تیزی سے کنورج ہوتا ہے۔

- کیا ڈراپ آؤٹ کو ایف سی پرتوں پر لاگو کیا جا سکتا ہے؟

- ہاں، ڈراپ آؤٹ تصادفی طور پر ٹریننگ کے دوران نوڈس کو غیر فعال کر دیتا ہے، ماڈل کو عام کرنے میں اضافہ کرتا ہے اور اوور فٹنگ کو کم کرتا ہے۔

- کیا FC تہوں کو convolutional تہوں سے مختلف بناتا ہے؟

- جب کہ convolutional تہیں مقامی خصوصیات کو نکالتی ہیں، FC تہوں نے ان خصوصیات کو درجہ بندی کے لیے ایک گھنے شکل میں جمع کیا ہے۔

مکمل طور پر منسلک تہوں پر کلیدی ٹیک ویز

مکمل طور پر منسلک پرت سیکھی ہوئی خصوصیات کو قابل عمل پیشین گوئیوں میں یکجا کرتی ہے، جو عصبی نیٹ ورکس میں فیصلہ سازی کے حتمی مرحلے کے طور پر کام کرتی ہے۔ یہ سمجھنے سے کہ ہر نوڈ کا حساب کیسے لگایا جاتا ہے، صارفین کو آبجیکٹ کا پتہ لگانے اور درجہ بندی جیسے کاموں کے لیے CNN فن تعمیر کو ڈیزائن کرنے اور بہتر بنانے میں اعتماد حاصل ہوتا ہے۔

عملی مثالیں، جیسے خود مختار گاڑیوں میں تصویر کی شناخت یا چہرے کی شناخت، FC تہوں کی اہمیت کو ظاہر کرتی ہے۔ صحیح نقطہ نظر کے ساتھ، اصلاح کے طریقوں کو شامل کرنا مضبوط اور درست ماڈلز کو یقینی بناتا ہے جو نادیدہ اعداد و شمار کو اچھی طرح سے ڈھال لیتے ہیں۔ اس تصور کی مہارت مصنوعی ذہانت میں گہری کھوج کو کھول دیتی ہے۔ 😊

ذرائع اور حوالہ جات

- CNNs میں مکمل طور پر منسلک تہوں کے بارے میں تفصیلی وضاحت جس سے حاصل کیا گیا ہے۔ مشین لرننگ میں مہارت .

- ایکٹیویشن فنکشنز اور ان کی ایپلی کیشنز کے لیے جامع گائیڈ جس سے حاصل کیا گیا ہے۔ تجزیات ودھیا .

- عصبی نیٹ ورکس کے لیے ڈراپ آؤٹ اور آپٹیمائزیشن کی تکنیکوں کی بصیرت یہاں پر ملی ڈیپ اے آئی .

- سے عصبی نیٹ ورکس میں وزن اور تعصب کو سمجھنا ڈیٹا سائنس کی طرف .

- PyTorch میں ReLU ایکٹیویشن فنکشنز کا استعمال جس سے حاصل کیا گیا ہے۔ PyTorch دستاویزی .