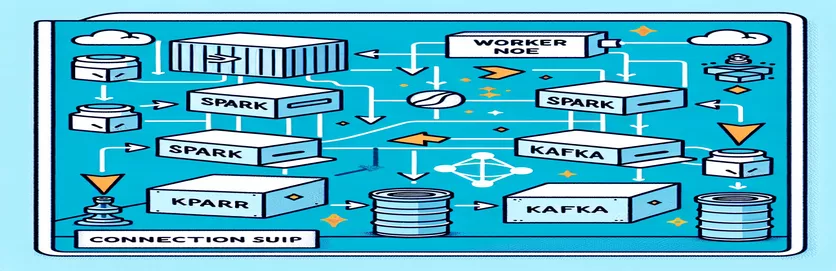

在 Docker 化环境中集成 Spark 和 Kafka 的挑战

您在集成时是否遇到过连接问题 卡夫卡经纪人 进入一个 星火集群 在 Docker 设置中?你并不孤单!许多开发人员在建立这两个强大工具之间的通信时遇到了障碍。 🛠️

最近我开始加强自己的 星火集群 通过添加 Kafka 代理来简化实时数据处理。然而,我遇到了持续连接超时和 DNS 解析错误的障碍,这使该过程变成了一场故障排除马拉松。 😅

这些问题源于 Docker Compose 和 Spark 的 Kafka 相关配置中的设置错误。尽管遵循了一些指南并调整了许多参数,但难以捉摸的“经纪人可能不可用”消息仍然存在,让我感到困惑和沮丧。

在本文中,我将分享我的经验并提供实际步骤来解决 Docker 环境中 Spark 工作线程和 Kafka 代理之间的连接挑战。在此过程中,您将学习避免这些陷阱并确保无缝集成的提示和技巧。让我们深入了解一下! 🚀

| 命令 | 使用示例 |

|---|---|

| from_json() | 此 Spark SQL 函数解析 JSON 字符串并创建结构化数据对象。在示例中,它用于将 Kafka 消息反序列化为结构化数据。 |

| StructType() | 定义结构化数据处理的架构。它对于定义 Kafka 消息的预期格式特别有用。 |

| .readStream | 在 Spark 中启动流式 DataFrame,允许从 Kafka 或其他流式源连续摄取数据。 |

| writeStream | 定义 Spark 结构化流查询的输出模式和接收器。这里,它指定以附加模式写入控制台。 |

| bootstrap_servers | 一个 Kafka 配置参数,指定 Kafka 代理的地址。对于 Spark 和 Kafka 通信至关重要。 |

| auto_offset_reset | Kafka 消费者设置,用于确定在不存在先前偏移量时从何处开始读取消息。 “最早”选项从最旧的消息开始。 |

| KAFKA_ADVERTISED_LISTENERS | Docker Kafka 配置环境变量。它指定 Kafka 客户端的通告地址,确保 Docker 网络内外的正确通信。 |

| KAFKA_LISTENERS | 配置 Kafka 代理侦听传入连接的网络接口。此处用于分隔内部和外部通信。 |

| KAFKA_LISTENER_SECURITY_PROTOCOL_MAP | 定义不同 Kafka 监听器的安全协议。它将侦听器名称映射到各自的协议,例如本例中的 PLAINTEXT。 |

| .awaitTermination() | Spark 结构化流方法,可阻止脚本的执行,直到流查询终止,从而确保流连续运行。 |

了解 Docker 中的 Spark 和 Kafka 集成

第一个脚本重点是在 火花工人 和一个 卡夫卡经纪人。通过使用 Spark 的结构化流 API,该脚本从 Kafka 主题读取实时数据。首先初始化 Spark 会话并使用所需的 Kafka 包对其进行配置。这一点至关重要,因为它为 Spark 与 Kafka 无缝通信提供了必要的依赖。这种依赖关系的一个示例是“org.apache.spark:spark-sql-kafka”包,它确保 Docker 环境中 Spark 和 Kafka 之间的兼容性。

为了处理 Kafka 消息,脚本使用“StructType”定义了一个模式。此架构可确保传入消息得到正确解析和结构化。现实场景通常涉及处理来自 Kafka 的 JSON 数据。例如,想象一个加密货币监控系统,其中包含价格更新的消息被发送到 Kafka。将这些消息解析为可读格式可以更轻松地处理和分析数据以进行趋势预测。 🪙

Docker Compose 配置在解决连接问题方面发挥着关键作用。调整“KAFKA_ADVERTISED_LISTENERS”和“KAFKA_LISTENERS”设置以区分 Docker 网络内的内部和外部通信。这确保了在同一 Docker 网络上运行的服务(例如 Spark 和 Kafka)可以进行交互,而不会出现 DNS 解析问题。例如,映射“INSIDE://kafka:9093”允许内部容器访问 Kafka,而“OUTSIDE://localhost:9093”则允许连接监控工具等外部应用程序。

第二个脚本演示了如何使用 Python `KafkaConsumer` 来测试 Kafka 连接。这是确保 Kafka 代理正常运行的简单而有效的方法。通过消费指定主题的消息,可以验证数据流是否不间断。考虑一个用户想要跟踪股票市场数据的应用程序。使用此使用者脚本测试连接可确保不会因配置错误而错过任何关键更新。借助这些工具,您可以自信地部署强大的系统来进行实时数据处理! 🚀

处理 Spark Worker 和 Kafka Broker 之间的连接问题

解决方案 1:使用 Python 调试并解决 Spark 和 Kafka 与 Docker 中的连接问题

# Import necessary modulesfrom pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StringTypefrom pyspark.sql.functions import from_json, col# Initialize Spark session with Kafka dependencyspark = SparkSession.builder \.appName("KafkaDebugReader") \.config("spark.jars.packages", "org.apache.spark:spark-sql-kafka-0-10_2.12:3.5.0") \.getOrCreate()# Define schema for Kafka messageschema = StructType().add("message", StringType())# Set up Kafka source for streaming datadf = spark.readStream \.format("kafka") \.option("kafka.bootstrap.servers", "localhost:9093") \.option("subscribe", "crypto_topic") \.option("startingOffsets", "earliest") \.load()# Parse Kafka messagemessages = df.select(from_json(col("value").cast("string"), schema).alias("data")) \.select("data.message")# Output data to consolequery = messages.writeStream \.outputMode("append") \.format("console") \.start()query.awaitTermination()

调试 Dockerized Kafka 中的 DNS 解析问题

解决方案 2:修改 Docker Compose 配置以实现正确的 DNS 解析

version: '3.8'services:kafka:image: wurstmeister/kafkacontainer_name: kafkaports:- "9093:9093"environment:KAFKA_ADVERTISED_LISTENERS: INSIDE://kafka:9093,OUTSIDE://localhost:9093KAFKA_LISTENERS: INSIDE://:9093,OUTSIDE://0.0.0.0:9093KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: INSIDE:PLAINTEXT,OUTSIDE:PLAINTEXTnetworks:- my_networkzookeeper:image: zookeepercontainer_name: zookeeperports:- "2181:2181"networks:- my_networknetworks:my_network:driver: bridge

测试 Kafka 消费者连接

解决方案 3:用于测试连接的 Python Kafka Consumer

# Import KafkaConsumer from Kafka libraryfrom kafka import KafkaConsumer# Create a Kafka Consumer instanceconsumer = KafkaConsumer('crypto_topic',bootstrap_servers='kafka:9093',auto_offset_reset='earliest',enable_auto_commit=False,group_id='api_data')# Poll messages from Kafka topicfor message in consumer:print(f"Received message: {message.value.decode('utf-8')}")# Ensure to close the consumerconsumer.close()

在 Docker 化环境中优化 Kafka 和 Spark

确保之间顺畅沟通的一个关键方面 卡夫卡经纪人 和 火花工人 Docker 中正在有效地配置网络设置。 Docker 容器在隔离环境中运行,当服务需要交互时,通常会导致 DNS 解析问题。为了解决这个问题,您可以利用 Docker Compose 的网络配置选项。例如,定义像“my_network”这样的自定义网络和链接服务可确保容器通过名称而不是 IP 相互识别,从而简化设置并避免常见陷阱。

另一个重要的考虑因素是优化 Kafka 的监听器配置。通过在 Docker Compose 文件中指定“KAFKA_ADVERTISED_LISTENERS”和“KAFKA_LISTENERS”,您可以允许 Kafka 向其客户端通告适当的地址。内部和外部侦听器之间的这种区别解决了冲突,特别是当 Spark Workers 尝试从 Docker 网络外部进行连接时。现实生活中的一个示例是监控仪表板从主机查询 Kafka 数据,需要不同的外部侦听器进行访问。 🔧

最后,在 Spark 应用程序中实现强大的错误处理至关重要。例如,利用 Kafka 配置中的重试和回退可以优雅地处理临时连接问题。添加 `.option("kafka.consumer.max.poll.records", "500")` 确保高效的数据检索,即使在重负载下也是如此。想象一下,一个实时跟踪股票价格的生产级应用程序,即使在网络出现故障的情况下,拥有适当的故障保护功能也能确保数据流不间断。这些技术共同构成了可靠数据处理管道的支柱。 🚀

关于 Docker 中的 Spark 和 Kafka 的常见问题

- 目的是什么 KAFKA_ADVERTISED_LISTENERS?

- 它指定 Kafka 客户端连接的通告地址,确保 Docker 网络内外的正确通信。

- 如何在 Docker Compose 中定义自定义网络?

- 您可以在下面添加网络 networks key 并将其包含在服务中,例如`networks: my_network`。

- 为什么 Docker 容器中的 DNS 解析失败?

- 容器可能无法通过名称来识别彼此,除非它们属于链接其 DNS 的同一个 Docker 网络。

- 的作用是什么 .option("subscribe", "topic") 在 Spark 流中?

- 它将 Spark Structured Streaming DataFrame 订阅到指定的 Kafka 主题以进行实时数据摄取。

- 重试如何改进 Kafka-Spark 集成?

- 重试配置,例如 max.poll.records,帮助处理瞬态错误并确保数据处理的一致性。

简化 Spark 和 Kafka 集成

在 Docker 中设置 Spark 和 Kafka 可能很复杂,但通过正确的配置,它变得易于管理。重点关注侦听器设置和网络配置以避免连接问题。确保 Zookeeper 和 Kafka 等所有组件都良好同步,以获得最佳性能。

现实世界的用例,例如监控财务数据或物联网流,凸显了稳健配置的重要性。此处共享的工具和脚本使您具备克服常见障碍并构建高效、实时数据管道的知识。 🛠️

来源和参考文献

- 本文由官方获悉 Apache Spark Kafka 集成文档 ,提供有关配置和使用的详细见解。

- Docker 网络最佳实践引用自 Docker 网络文档 确保准确可靠的集装箱通信设置。

- 实际示例和其他 Kafka 设置改编自 Wurstmeister Kafka Docker GitHub 存储库 。